HashiCorp 发布了 Terraform MCP Server,这是一个 Model Context Protocol (模型上下文协议, MCP) 的开源实现,目的是想让大语言模型在处理“基础设施即代码”这类事情时,能做得更好、更顺畅。让 Claude、Copilot 还有 ChatGPT 这些 AI 工具,以后就能生成更准确、更贴合实际场景的 Terraform 代码,因为大模型会优先去看官方的、最新的东西,而不是依赖那些可能已经过时,甚至是模型自己“脑补”出来的旧训练案例。

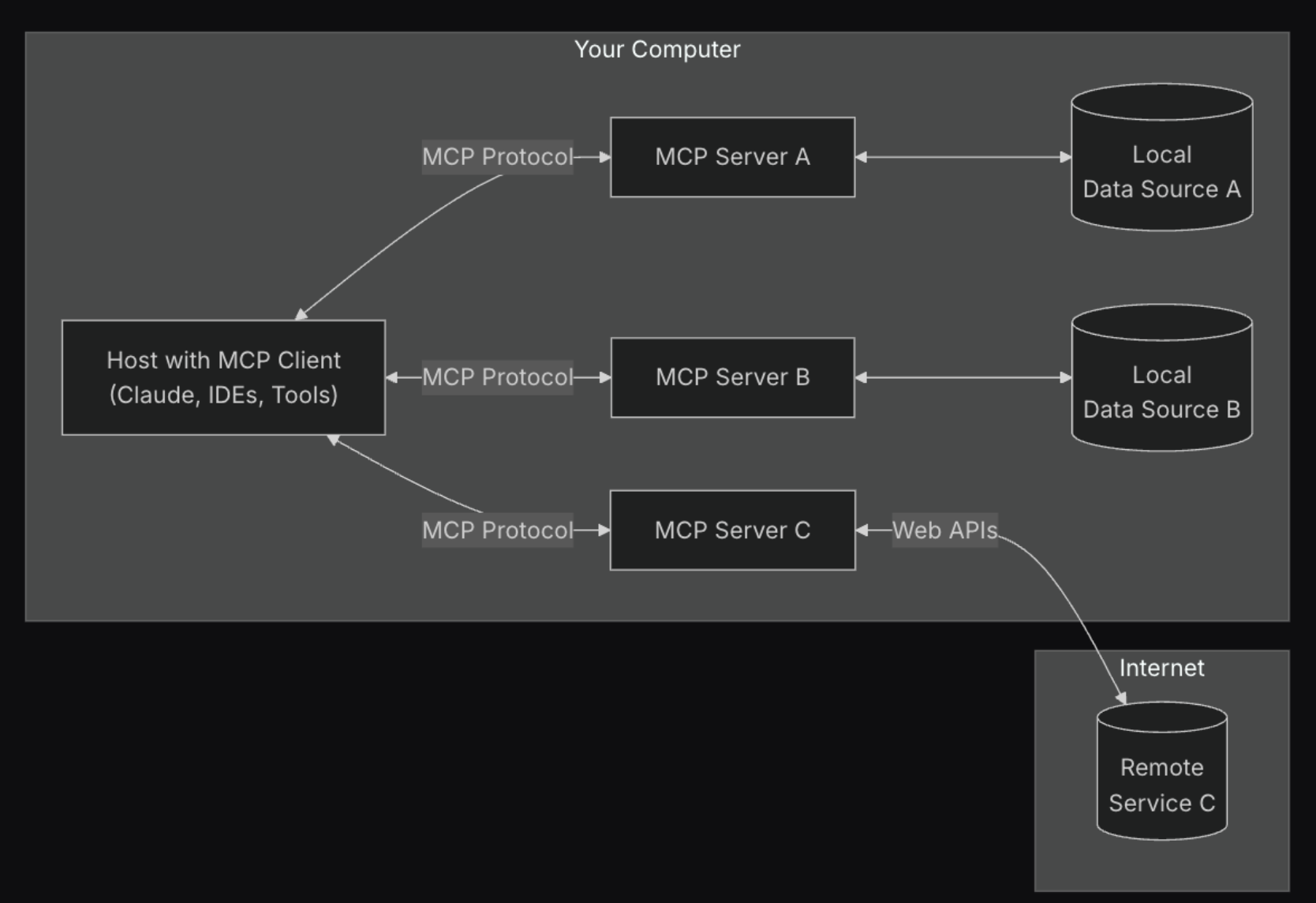

MCP 是一种标准,就是为了帮助大语言模型能实时地从外部系统拿到结构化、机器能读懂的数据。AI 工具不再仅仅依赖静态训练数据,而是可以使用 MCP 通过 JSON-over-gRPC 查询实时数据源,给出的回答自然也就更靠谱、更符合当下的情况。在这款 Terraform MCP Server 里,这个协议就像一座桥,连接了 AI 系统和 Terraform Registry,让模块、服务提供商、资源和配置规范这些数据能够顺畅地给到 AI。AI 模型想知道最新的配置细节就方便多了。

把这些数据用结构化的方式清楚地呈现出来后,那些有 AI 辅助功能的工具就能更好地跟上 Terraform 最新的标准和配置了。至于准确率能提高多少,HashiCorp 目前还没给出具体数字,但不难想见,这种做法至少能避免一些头疼的问题——比如,防止 AI 因为参考了那些过时的、甚至是硬塞在代码里的旧信息,而产生“幻觉”,给出些不着边际的建议。

虽然 Terraform MCP Server 仍处于早期开发阶段,但 HashiCorp 已在 Microsoft Build 2025 大会上演示了其与 GitHub Copilot 的集成,开发者可以直接在自己的 IDE 里得到基于实时 Terraform Registry 数据、非常贴合当前场景的 Terraform 代码建议。

除了官方,一些独立项目也开始尝试把 MCP 协议用在 Terraform 上。比如,terraform-docs-mcp 项目就用 Node.js 做了一个 MCP 服务器,专门给 AI 助手提供模块的元数据,算是 Terraform 生态系统之外一个比较轻量级的数据共享方案。另外,tfmcp 项目则在探索怎么用命令行结合像 Claude 这样的大模型来管理 Terraform 的工作流程,比如通过结构化的指令让 AI 读取配置文件、分析执行计划等等。这些社区项目虽然没用 HashiCorp 的那套实现,但也说明了大家对 MCP 这个生态越来越感兴趣,都希望用它作为一种机器能读懂的接口,来获取基础设施方面的信息。

Terraform MCP Server 和其它一些新出现的尝试一样,都反映出 AI 辅助工具领域的一个大趋势:那就是想办法把开发者的工作流程整合起来,让它们更统一。虽然 HashiCorp 没明说搞 MCP 是出于什么战略考虑,但这种协议的出现和使用,很可能意味着行业风向正在变:从以前那种针对特定产品的 AI 功能定制,转向开发更多可互操作的通用接口,以此来支持一个由各种 AI 助手、客户端软件和自动化流程组成的多样化生态系统。

原文链接: