2018 年 10 月 16 日,在纽约大学的 Skirball 剧场的一间拥挤的房间里,纽约大学的 AI Now 研究所举办了其第三届年度 AI Now 研讨会。该研讨会专注于 3 个核心主题:道德、组织和责任。第一个小组审查了面部识别技术;第二个小组研究了 AI 系统和社会不平等以及紧缩政治之间的关系;最后一个小组积极看待研究和劳动组织之间的交集。

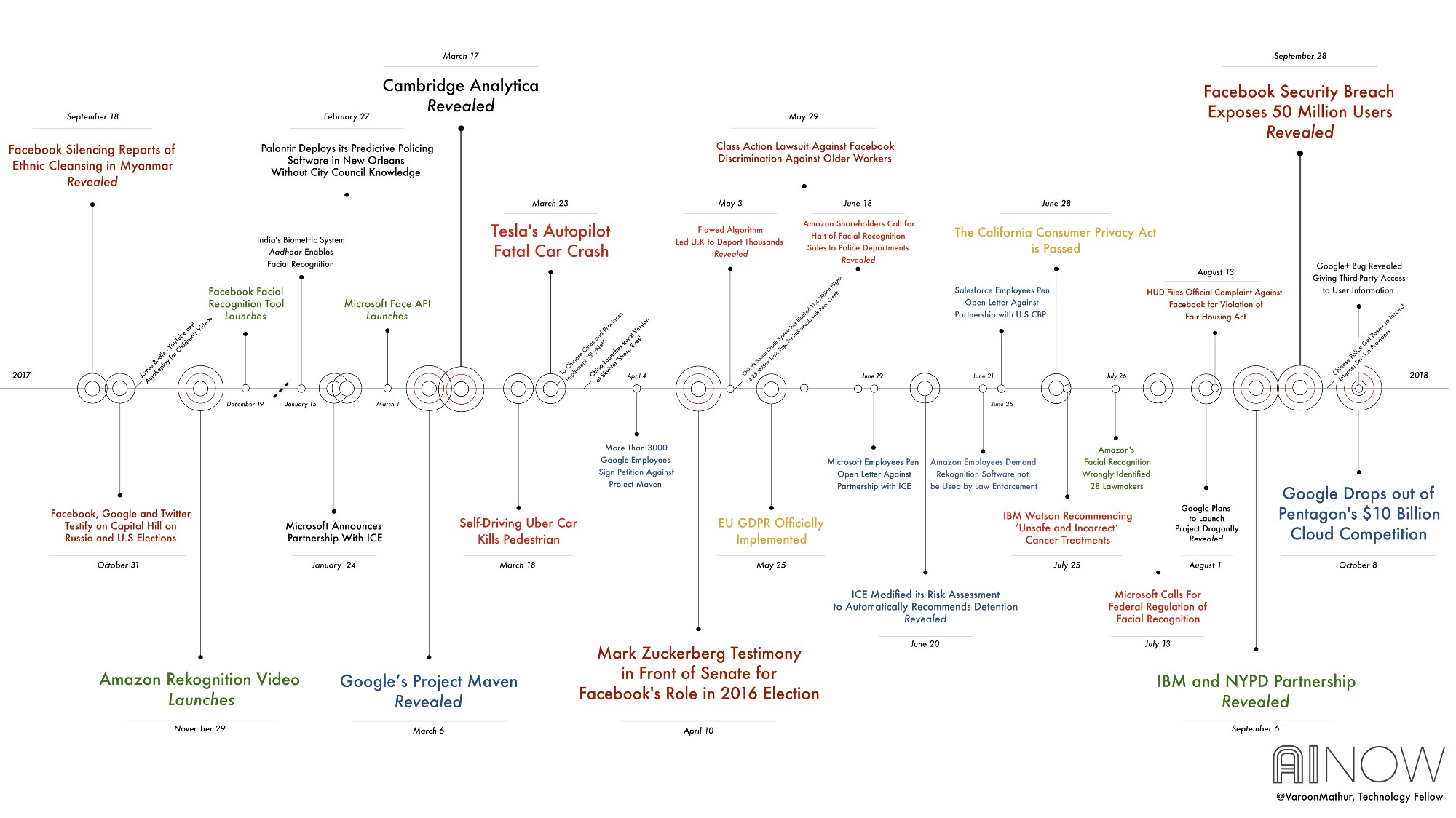

AI Now 的联合创始人 Kate Crawford 和 Meredith Whittaker 为研讨会做了开场演讲。演讲开始于一个大型的可视化图,这张图展示了过去 12 个月中发生过的一些重大事件。以下是演讲的摘录。

这是我们今年最大的聚会,我们来回顾一下 AI 界正在发生的事情及其更广泛的影响,认可做得好的工作并绘制向前发展的路径图。今年,我们的重点是这 3 个核心主题:道德、组织和问责。

但是,在这之前,我们先简要回顾一下今年发生的事情。在严峻的政治背景下,AI 系统的能力和影响范围在不断扩大。与此同时,AI 的研究领域和整个科技行业也发生了重大的变化和动荡。

为了实现这个目标,我们和 AI Now 的技术研究员 Varoon Mathur 合作,对过去 12 个月中发生的大事中的一些进行了可视化。我们首先构建了重要新闻数据库,处理了 AI 和技术行业对社会的影响。下面这张图只显示了一个例子,并且,结论证实了我们许多人的感受——今年是地狱之年。

过去 12 个月的新闻大事时间线(点击可查看大图)

在任何正常年份,剑桥分析(Cambridge Analytica)都应该是主角。今年,它只是其中之一。仅 Facebook 一家就出现了一大堆丑闻,其中包括 9 月发生大规模数据泄露事件、针对歧视的多起集体诉讼、煽动缅甸种族清洗的指控、影响“公平住房法(Fair Housing Act)”,以及拥有大量俄罗斯假账号。整整一年,Facebook 的高管常常被传唤作证,马克•扎克伯格自己也分别在 4 月和 5 月在美国参议院(US Senate)和欧洲议会(European Parliament)接受质询。

但是,丑闻漫天的远不止 Facebook 一家。

3 月爆出消息,谷歌为国防部的无人机监控计划(也即 Project Maven)构建 AI 系统。该消息引发了前所未有的员工集体罢工和辞职潮。6 月的时候,特朗普当局开始实施家庭分离政策,强迫移民儿童与他们的父母分开,来自亚马逊、Salesforce 和微软的员工都要求自家的公司结束与 ICE 的合同。

之后还不到一个月的时间,ICE 就被揭露修改了自己的风险评估算法,从而只产生一个结果:系统建议对在押的移民全部进行“扣留”。

与此同时,面部识别技术的扩张在加速。Facebook 和微软与亚马逊一道,提供面部识别服务的即插即用模式。我们还了解到,IBM 和纽约警察局(NYPD)合作,秘密构建了一个“种族检测”功能,来搜索基于种族特征的面部,他们利用的是来自纽约街头的警用摄像机所拍摄的成千上万人的面部信息, 而所有被拍摄的人对此一无所知。

整整一年里,AI 系统继续在实时人群中进行高风险的测试,并产生了一些严重后果。 3 月份,发生了自动驾驶汽车的司机死亡事件和行人死亡事件。 然后在 5 月,英国政府由于一款用于检测移民欺诈的语音识别系统出了问题,而最终取消了成千上万人的签证并进行了错误的驱逐。7 月份,IBM 的 Watson 生成了“不安全且不正确”的癌症治疗建议。

所有这些事件都推动了越来越多的技术批评浪潮,这些批评集中在这些系统的不负责任的性质上。 包括微软和亚马逊在内的一些公司,甚至公开呼吁美国监管面部识别等技术。 到目前为止,我们还没有看到华盛顿政府部门有什么真正动作。

以上只是这极其戏剧性的一年中的一小部分样本。 像我们这样研究这些系统的社会影响的研究人员都在谈论我们现在面临的挑战的规模:还有很多工作要做。 但也出现了积极的变化,围绕 AI 的公众讨论在一些重要的方面日渐成熟。

意识到伦理与偏见

大约六年前,只有少数人喜欢 Latanya Sweeney,Cynthia Dwork 和其他一些人发表的关于 AI 和大规模数据系统的偏见的文章。 甚至就在三年前,当我们召开第一届 AI Now 研讨会时,偏见问题远非主流。 但现在,有关于 AI 系统有偏见的结果的研究和新闻报道不断涌现。 本周,有人透露,亚马逊的简历扫描机器学习系统最近被证明歧视女性,甚至仅仅因为包含“女性”这个词就降低了简历的重要程度。

回到 7 月份,ACLU 展示了亚马逊新的面部识别服务如何错误地将 28 名国会议员识别为犯罪分子。 一篇重要论文还表明,面部识别软件在对肤色较深女性的识别上表现较差。

总体而言,人们现在明确感觉到偏见是一个问题,这是巨大的进步。 但是,对话还有很长的路要走,而且已经分成了不同的阵营。 一方面,我们看到技术正急于修复这些问题;另一方面,我们也看到试图获得道德准则来完成无关紧要的重活。

IBM、Facebook、微软和其他公司都于今年早些时候发布了“破坏偏见(bias busting)”工具,承诺通过统计方法帮助缓解 AI 系统中的偏见问题,从而实现公平性的数学定义。 需要明确的是,这些工具都没有“解决”偏见问题,它们只是部分和早期的缓解措施。 因为在这一点上,他们提供技术方法来解决社会问题,也即送出更多 AI 来修复 AI。 当 Facebook 在参议院的议员们面前反复指出,人工智能是病毒性错误信息等问题的解决方法时,我们看到了这种逻辑。

解决这些问题的技术方法是必要的,但还不够。 此外,简单地使面部识别等系统更加准确并不能解决核心公平问题。 有些工具,无论其准确性如何,都可能被不公平地使用,特别是如果它们导致加强了对边缘化群体的监督或歧视的时候。

我们还看到了科技行业道德规范的转向。 谷歌发布了 AI 原则(AI Principles)。 微软,Salesforce 和 Axon 采用了道德委员会和审查结构。 还出现了一系列道德课程,旨在帮助工程师做出道德决策。

但是,最近发表的一项研究质疑了这些方法的有效性。 它表明,软件工程师通常不会根据道德规范的风险改变其行为。 也许我们不应该对此感到惊讶。 用人类计算机互动(Human Computer Interaction)的奠基思想家 Lucy Suchman 的话来说,尽管道德准则是一个良好的开端,但是它们缺乏任何真正的民主或公共责任。

因此,虽然道德原则和反偏见技术工具可以提供帮助,但是,为了应对我们面临的结构性问题,还需要更多东西。

最大且尚未解决的问题是,我们如何创建可持续的问责形式?

这是我们在 AI Now 工作的重点。 我们于 2017 年 11 月正式成立在纽约大学的研究所,目的就是研究这些挑战。 我们已经开始在大规模的背景下研究 AI,并着眼于全系统的问责。

通过这项工作,出现了 5 个关键主题。

物质

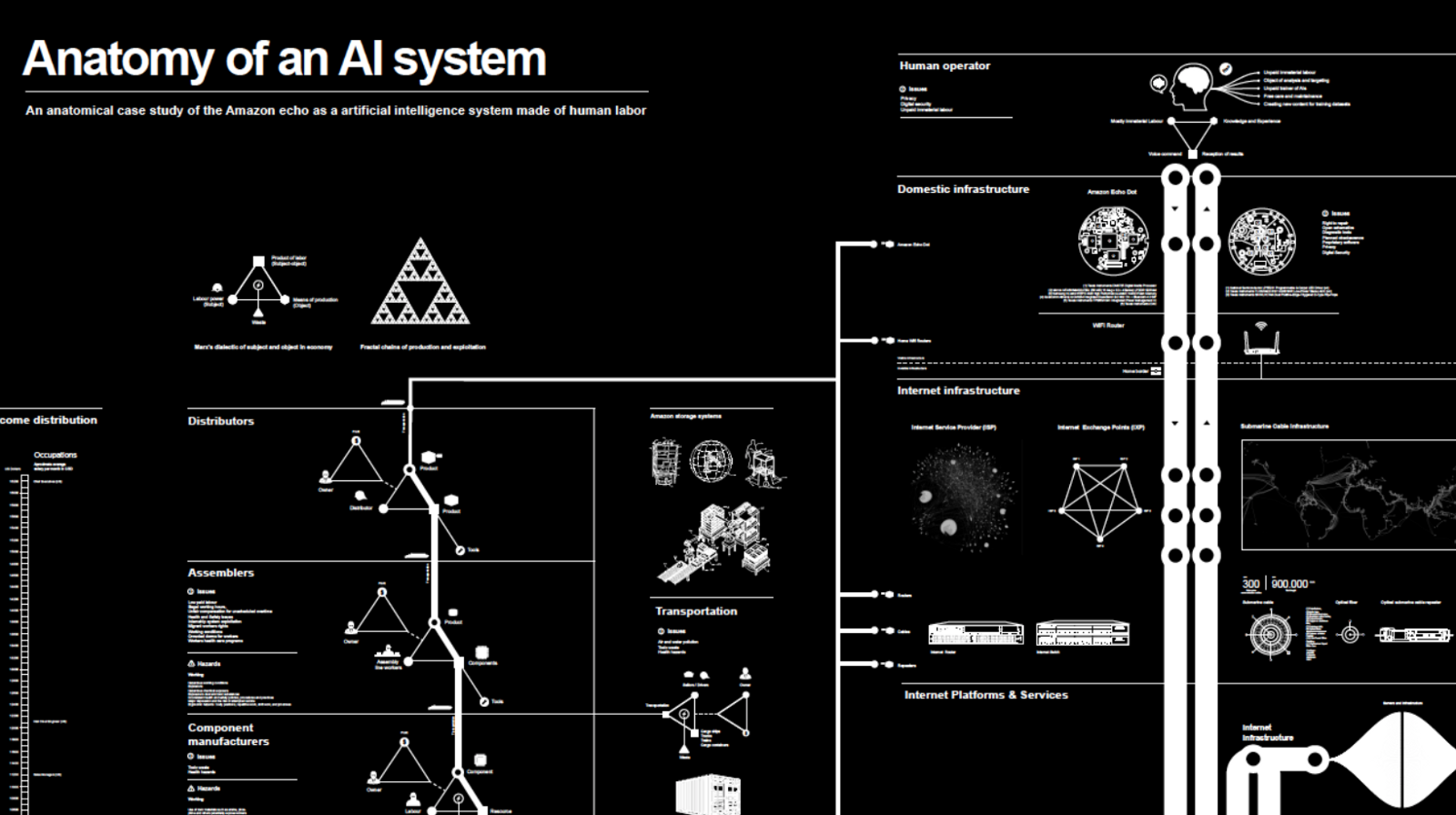

通过检查我们的技术系统的基本物质现实,可以学到很多东西。 上个月我们发布了一个名为 The Anatomy of AI 的项目。 为期一年的 Kate Crawford 和 Vladan Joler 的合作调查了当你说“Alexa!打开灯”的时候,需要多少资源来构建一个响应此命令的设备。

从亚马逊 Echo 开始,我们追踪了构建和操作该设备所需的环境提取过程和劳动力情况。 从采矿、冶炼和物流,到训练响应式 AI 系统所需的大量数据资源,到国际数据中心网络,一直到我们许多消费者 AI 小工具的最终安息处:堆放在加纳、巴基斯坦和中国的巨大电子垃圾堆中。

当我们以这种方式看待 AI 时,就开始看到用于日常便利的技术对资源的影响。

在进行这项研究时,我们还发现暗箱堆积:不仅仅是算法层面,还有商业秘密法和无法追踪的供应链。 这就是为什么大规模建立 AI 所需的行星资源难以让公众看到的部分原因。

劳动力

我们还继续研究隐藏在 AI 系统背后的劳动力。 通常,当我们想到“AI 背后的人”时,我们想到的是少量的硅谷高薪工程师,他们编写算法并优化特征权重。 但这不是全部的情况。 正如记者 Adrian Chen 最近曝光的那样,更多的人在内容审核的影子矿中工作,而且这些人还不是 Facebook 或谷歌的正式员工。

很多学者正在为这一领域的工作做出贡献,其中有 Lily Irani、Mar Hicks 和 Astra Taylor,他们创造了术语“fauxtomation”来描述那些声称是无缝 AI 的系统,但只能在大量的点击工人输入的情况起作用。 正如 Taylor 所观察到的那样,纯粹自动化的神话是隐瞒某些类型的工作,要么为它付出不足,要么假装它根本不起作用。 很多依赖用户免费训练他们的系统的 AI 系统也是如此,例如在用户可以使用服务或阅读网站之前强迫他们点击照片以改进图像识别系统。

法律政策

我们还需要新的法律方法来应对增加的自动化决策。 问责很少在后端没有责任的情况下起作用。

今年,我们看到了一些突破。 欧洲数据保护法规(GDPR)于 5 月生效。 纽约市公布了其自动决策系统任务组(Automated Decision Systems Task Force),这是美国的首个此类任务组。 而且,加州刚刚通过了美国最强的隐私法。

还有许多新案例将算法提交到法庭。 AI Now 最近举办了一个名为诉讼算法(Litigating Algorithms)的研讨会,该研讨会召集了公众利益律师,这些律师代表被不公平地断绝了医疗福利的人、由于偏见的教师绩效评估而失去了工作的人,还有那些监禁判决受到风险评估偏差影响的人。 这是一次令人难以置信的积极聚会,充满了建立正当程序和安全网的新方法。

我们还发布了算法影响评估框架(Algorithmic Impact Assessment framework),该框架为公共部门工作人员提供了更多工具,这些工具用于批判性地确定算法系统是否合适,并确保有更多社区意见和监督。

不平等

所有这些工作都涉及更广泛的权力和政治体系,这些体系引发了不平等的问题。

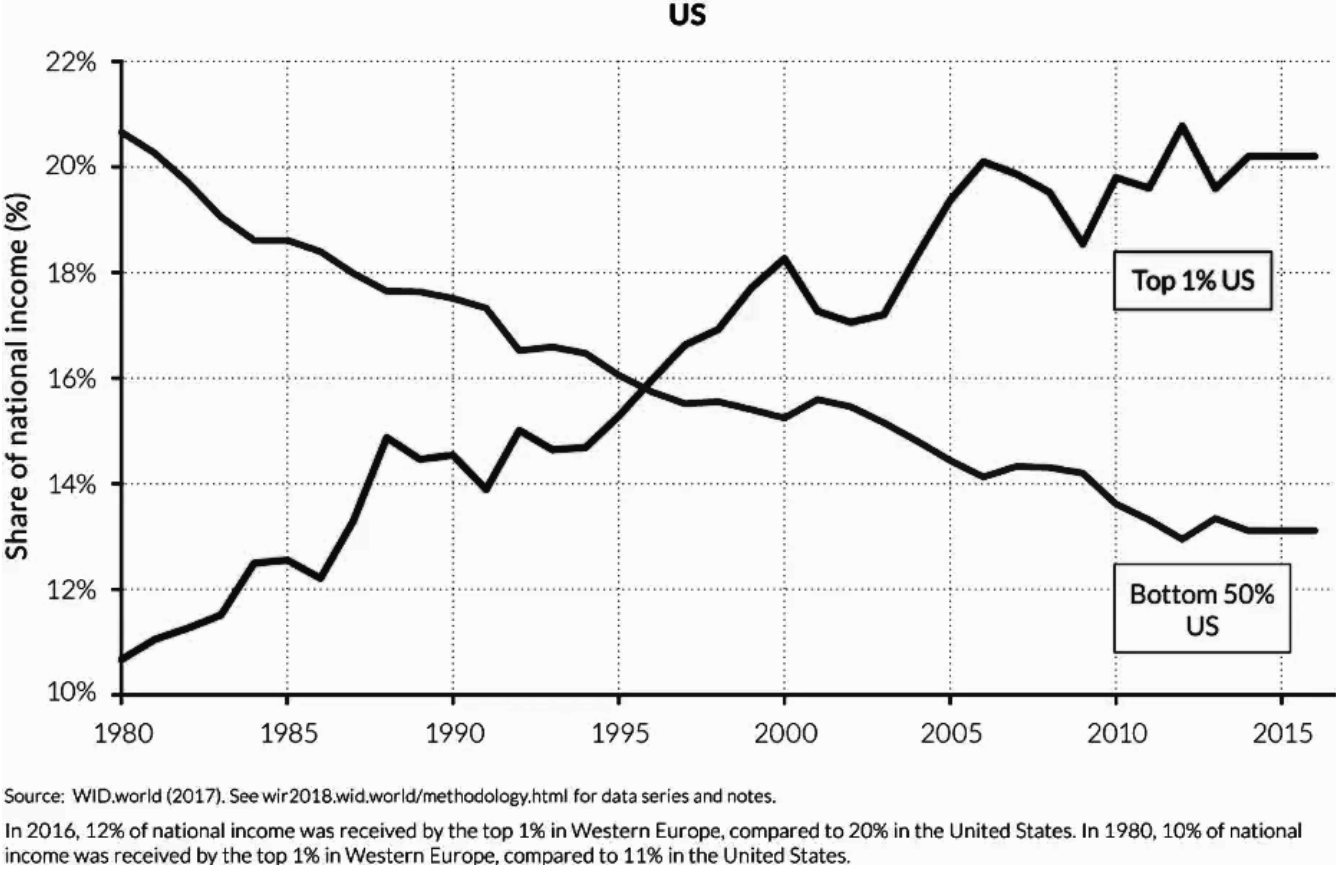

关于 AI 的热门讨论通常着重于假设的用例和有益的承诺。 但 AI 不是一种对所有人来说都是平等的资源。 人们越来越担心,AI 系统可以收集到的权力和见解进一步扭曲了资源的分配,这些系统的分布是如此的不均匀,从而可能会导致更多形式的财富不平等。 看看谁建立了这些系统、谁决定了它们的使用方式,以及谁被排除在这些考虑之外,这些可以帮助我们看到市场营销以外的东西。

与此同时,联合国的一份新报告称,虽然 AI 可用于解决重大问题,但无法保证它能够满足人类最迫切的需求。 该报告还指出,AI 系统越来越多地用来“操纵人类情感,传播错误信息甚至仇恨”,并“冒着加强现有偏见和排斥形式的风险。”

新联盟

很明显,如果去年是识别偏见和社交领域技术系统局限性的重要时间,那么明年将成为问责的重要时间。

好消息是这项工作已经开始,人们开始采取行动,新的联盟在增长。 AI 领域将始终包括技术研究,但是,我们也正在努力扩大其边界,强调跨学科性,并突出社区参与和现场人员的观点。

真正的问责需要新的联盟,也即组织者和民间社会领导人与研究人员合作,评估 AI 系统,并保护风险最大的社区。

因为 AI 不仅仅是技术。 AI 是权力,是政治,也是文化。

阅读英文原文:

https://medium.com/@AINowInstitute/ai-in-2018-a-year-in-review-8b161ead2b4e

公众号推荐:

跳进 AI 的奇妙世界,一起探索未来工作的新风貌!想要深入了解 AI 如何成为产业创新的新引擎?好奇哪些城市正成为 AI 人才的新磁场?《中国生成式 AI 开发者洞察 2024》由 InfoQ 研究中心精心打造,为你深度解锁生成式 AI 领域的最新开发者动态。无论你是资深研发者,还是对生成式 AI 充满好奇的新手,这份报告都是你不可错过的知识宝典。欢迎大家扫码关注「AI前线」公众号,回复「开发者洞察」领取。

评论