本文是 TechTalks 在人工智能领域最新研究发现的论文评论系列。

对于精通围棋、星际争霸 2 以及其他游戏的深度强化学习模型而言,关键的挑战之一是它们无法将其能力泛化到训练领域之外。这种限制使得将这些系统应用到现实世界中变得非常困难,在现实世界中,情况比训练 AI 模型的环境复杂得多且不可预测。

最近,DeepMind AI 研究实验室中的科学家们在一篇“开放式学习”倡议的博文中,宣布他们“初步训练出了可以在无需接受人类交互数据的情况下,游玩多种游戏的代理”。他们新的项目包括一个有现实动态变化的 3D 环境,以及可以学习解决各种挑战的深度强化学习代理。

据 DeepMind 的 AI 研究者称,这套全新的系统是向着“创造更加通用、具备适应持续变化环境的弹性能力的代理”迈出的重要一步。

该论文的发现表明,在将强化学习应用于复杂问题方面取得了一些令人印象深刻的进展。但它们也提醒人们,当前的系统距离实现人工智能社区几十年来一直梦寐以求的通用智能能力还有多远。

深度强化学习的脆弱性

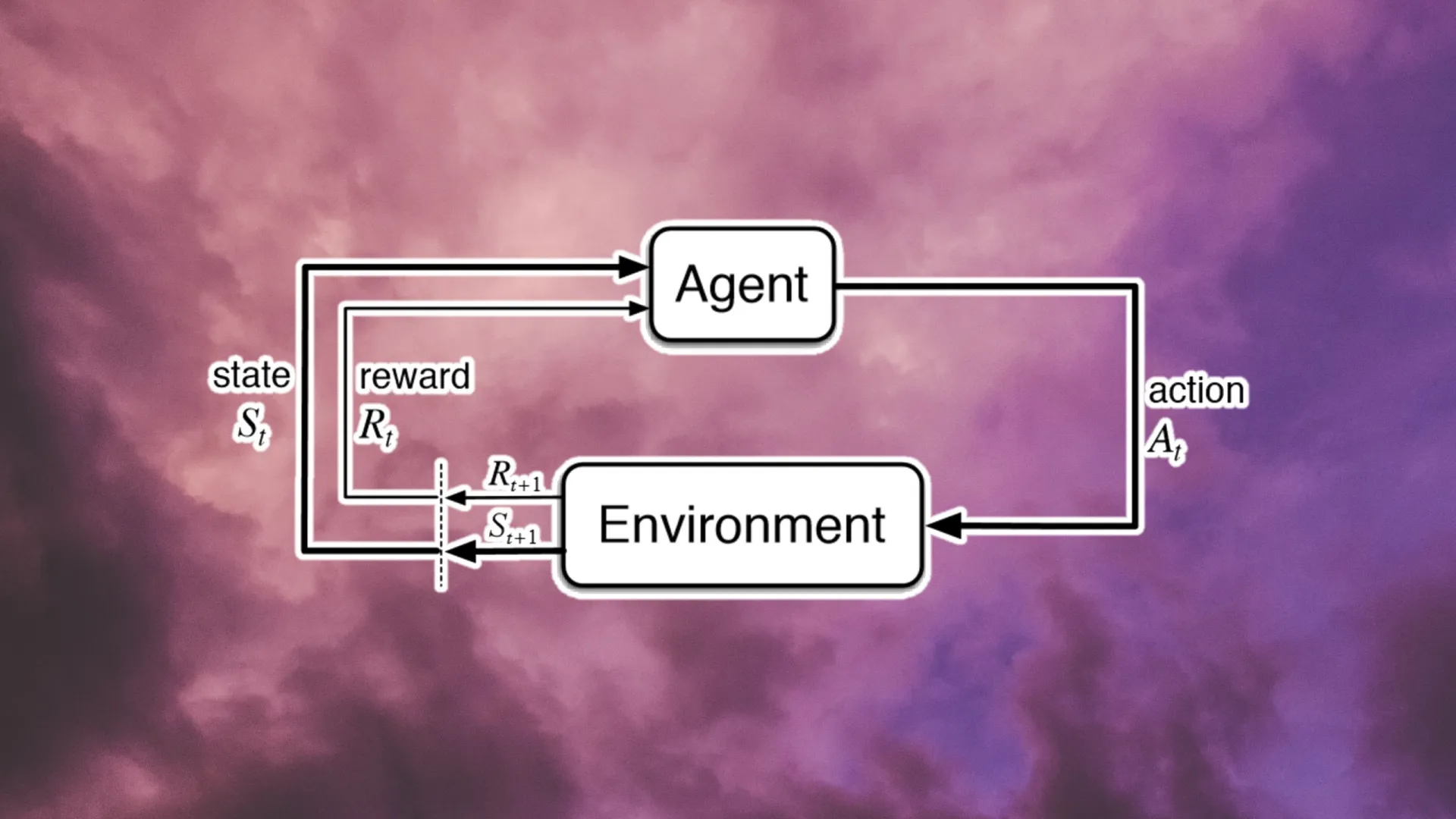

强化学习的一个关键优势在于其可以在执行动作并接受反馈的同时发展出新的行为方式,这种做法与人类和动物通过与环境互动学习知识的方式相类似。有些科学家将强化学习称为是“首个智能的计算理论”。

深度强化学习结合了强化学习与深度神经网络,是包括 DeepMind 最著名的 AlphaGo 和AlphaStar模型在内许多强化 AI 的核心。在这两种模型中,AI 系统都可以在各自的游戏领域内打败人类世界的冠军。

但强化学习系统的灵活度不足也是众所皆知的缺陷。举例来说,一个可以在专家模式打通星际争霸 2 的强化学习模型却打不过同类型游戏(比如魔兽争霸 3)的任何难度。游戏中哪怕是一点点的变化都会造成 AI 模型在性能上的降级。

“这些代理通常都被限制在它们训练时所用的游戏上,虽然游戏的布局、初始条件、对手可能会变化,但代理的目标在训练与测试时必须保持不变,一丁点的偏离都会造成代理灾难性的失败。”DeepMind 的研究者在论文中如此写道,同一篇论文也提供了他们开放式学习的研究中全部的细节。另一方面,人类则非常擅长跨领域的知识转移。

XLand 环境

DeepMind 新项目的目标是创建“一个人工代理,其行为可以超越它所训练的游戏集,提供更强的泛化能力”。

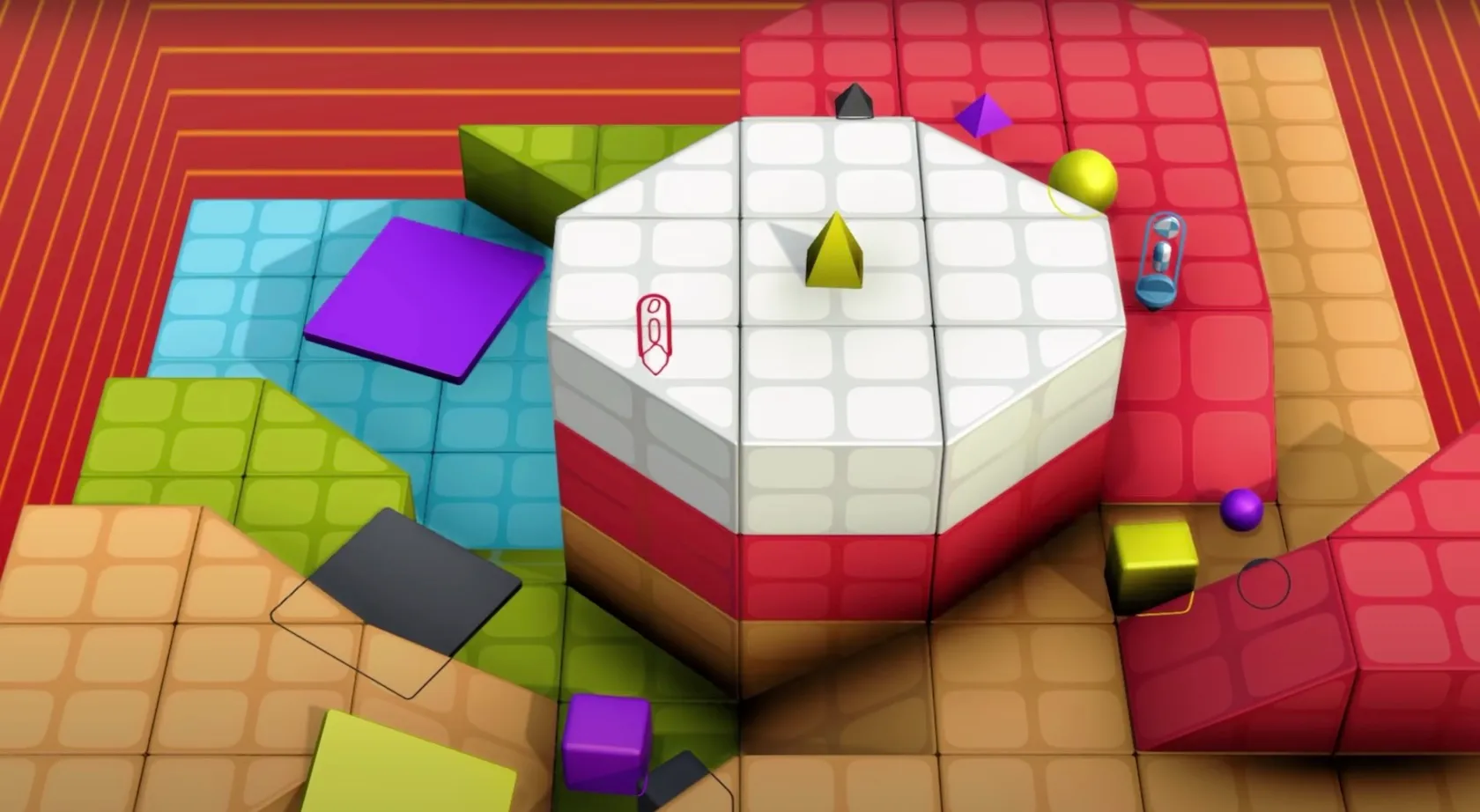

为此,该团队创建了 XLand,一个能够生成由静态拓扑结构和可移动物体组成的 3D 环境的引擎。该游戏引擎模拟了刚体物理学,并允许玩家以各种方式使用这种物体(例如,创建坡道、阻断路径等等)。

XLand 是一个丰富的环境,你可以在其中对代理进行几乎无限数量的任务训练。XLand 的主要优势之一是能够使用编程规则自动生成大量环境和挑战情况来训练 AI 代理。这也解决了机器学习系统的一大难题——如何获得大量人造的训练数据。

根据这篇博文,研究人员在 XLand 中创建了“数十亿的任务,跨越不同的游戏、世界和玩家”。这些游戏包括了寻找物体这类的简单目标,到 AI 代理需要权衡不同奖励的收益与代价这类复杂设定。有的游戏也包括了多个代理之间的对抗或合作元素。

深度强化学习

DeepMind 使用深度强化学习以及其他的几个小技巧来创建可以在 XLand 环境中茁壮成长的 AI 代理。

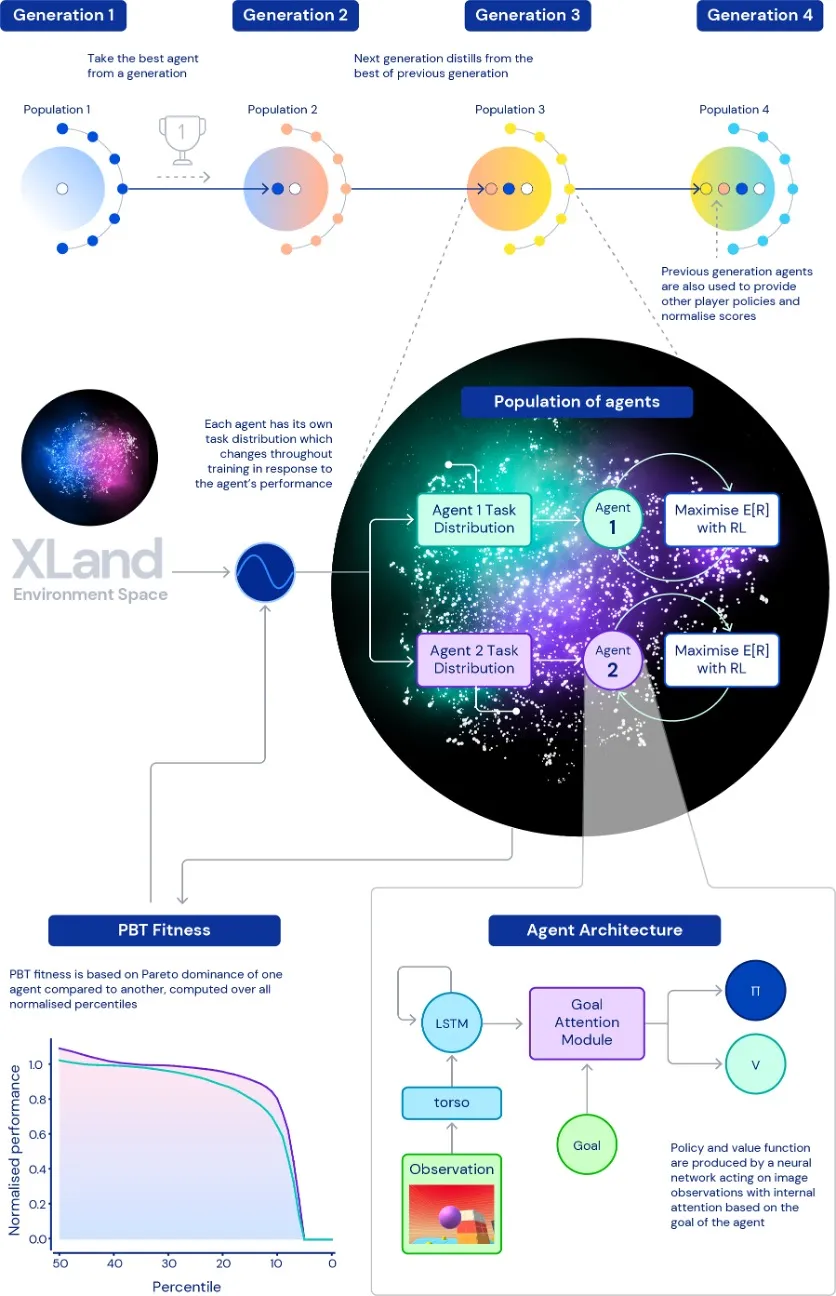

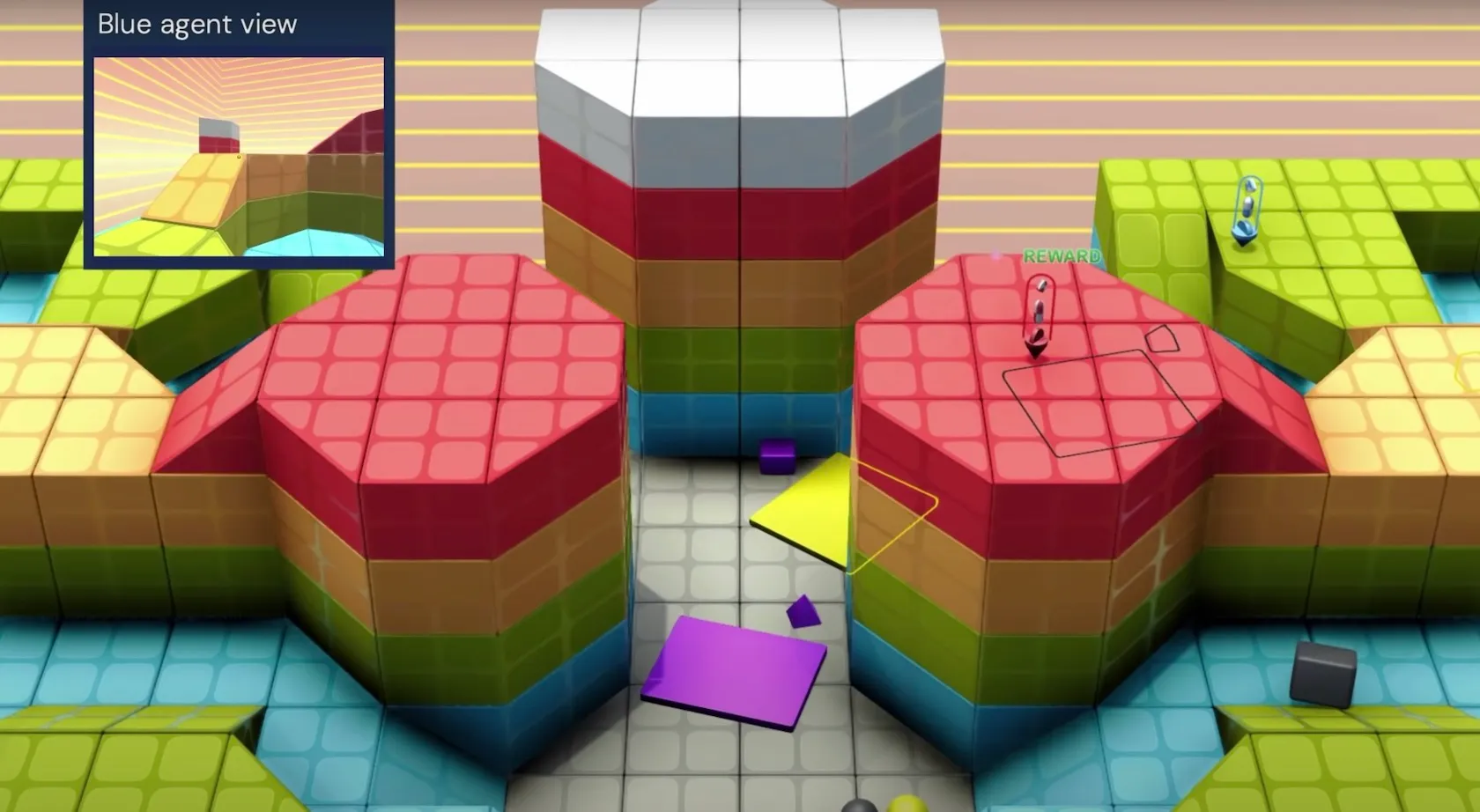

每个代理的强化学习模型都会收到一个第一人称的世界视角、代理的物理状态(比如是否持有物品),以及其当前的目标。每一个代理都会对其策略神经网络的参数进行微调,以获得当前目标的最高奖励。神经网络的架构包含了一个注意力机制,以确保代理人能够平衡地完成主要目标所需要完成的子目标的优化工作。

一旦代理能够熟练应对它的当前挑战,计算任务生成器就会为代理创建一个新的挑战。每个新任务都是根据代理人的训练历史生成的,有助于将代理的技能分配到更广阔的挑战之中。

DeepMind 同时还利用它庞大的计算资源(多亏其所有者 Alphabet 公司)同步训练大量代理,并在不同代理之间转移所学习的参数以提升强化学习系统的通用能力。

强化学习代理的性能是通过它们完成一系列未训练过的任务的一般能力来评估的,测试用的任务内容包括了常见的“夺旗”和“捉迷藏”。

DeepMind 称,他们的所有代理在 XLand 中约四千的独特世界中训练了约 70 万个独特的游戏,并在 340 万个独特的任务中经历了 2000 亿个训练步骤(在论文中研究人员写道,1 亿个步骤相当于大约 30 分钟的训练)。

人工智能研究人员写道:“目前,我们的代理已经能够参与每一个程序生成的评估任务,除了少数几个甚至对人类来说都不可能的任务”。“而且我们看到的结果清楚地展示了跨越整个任务空间的一般化、零次行为。”

零次机器学习模型可以解决在其训练数据集中不存在的问题。在 XLand 这样的复杂空间中,零次学习可能意味着代理已经获得了关于其环境的基本知识,而不是在特定的任务和环境中记忆图像帧的序列。

当研究人员试图为新的任务调整它们时,强化学习代理进一步表现出泛化学习的迹象。根据他们的发现,对新任务进行30分钟的微调就足以使用新方法训练的强化学习代理产生令人印象深刻的改进。相比之下,在同样的时间内从头开始训练的代理在大多数任务上的表现几乎为零。

高级别行为

据 DeepMind 称,强化学习代理表现出了“启发式行为”,如工具使用、团队合作和多步骤规划。如果得到证实,这可能是一个重要的里程碑。深度学习系统经常被批评为学习统计上的相关关系而不是因果关系。如果神经网络能够发展出高层次的概念,如利用物体创建坡道或造成闭塞,它可能会对机器人和自动驾驶汽车等领域产生巨大影响,而深度学习目前正在这些领域中挣扎前行。

但这些都是假设,DeepMind 的研究人员对在他们的发现上妄下结论持谨慎态度。"他们在博文中写道:“鉴于环境的性质,很难确定意向性是否真的存在--我们看到的行为往往看起来是偶然的,但我们仍然看到它们在持续发生。”

但他们相信,他们的强化学习代理“意识到了它们身体的基本情况和时间的流逝,而且它们可以了解它们遇到的游戏的高级结构”。这种基本的自学技能是人工智能界高度追求的另一个目标。

智力理论

DeepMind 的一些顶级科学家最近发表了一篇论文,他们在其中假设,仅靠单一的奖励鞭策强化学习便足以最终达到人工通用智能(AGI)的程度。科学家们认为,一个拥有正确奖励的智能代理可以发展各种能力,如感知和自然语言理解。

尽管 DeepMind 的这个新方法仍然需要在多个人工设置的奖励上训练强化学习代理,但这与他们通过强化学习实现 AGI 的总体观点是一致的。

“DeepMind 通过这篇论文所展示的是,一个单一的 RL 代理开发出的智能是可以达到多个目标的”,Pathmind 的首席执行官克里斯·尼科尔森(Chris Nicholson)告诉 TechTalks。“而且它在完成一件事时学到的技能可以推广到其他目标。这与人类智力的应用方式非常相似。例如,我们学习抓取和操纵物体,并扩展到敲打锤子甚至是铺床。”

尼科尔森还认为,该论文的其他方面的发现暗示了向一般智力的进展。“父母会认识到,开放式的探索正是他们的幼儿学习在世界中移动的方式。他们把东西从柜子里拿出来,再放回去。他们发明了自己的小目标并进一步熟练掌握,虽然这些目标在成年人看来可能毫无意义,”他说。“DeepMind 正在以编程方式为其代理在这个世界上设定目标,而这些代理正在学习如何逐一掌握这些目标。”

尼科尔森说,强化学习代理也显示出在他们自己的虚拟世界中发展具身智能的迹象,就像人类拥有的那种。他说:“这再一次表明,人们学习移动和操纵的丰富和可塑性的环境有利于一般智能的出现,而且智能的生物和物理类比可以指导人工智能的进一步工作。”

南加州大学计算机科学副教授萨蒂亚纳拉亚·拉加瓦查里(Sathyanaraya Raghavachary)对 DeepMind 论文中的说法持怀疑态度,尤其是关于本体感知、时间意识以及对目标和环境的高层次理解的结论。

“即使是人类也无法做到对自己本体状况的完全掌控,更不要说那些 VR 的代理了,”拉加瓦查里在为 TechTalks 做的评论中提到过,一个综合的大脑对身体的感知由两部分组成,一是适量的对本体的感知,二是对空间中定位的认识。“对时间的意识也是如此。大脑需要对过去有记忆,同时对现在与过去时间之间的相对有认识。论文作者的意思可能是说,代理在追踪他们在移动紫色金字塔这类的行为所造成的环境渐变时,底层的物理模拟器也将产生状态的变化。”

拉加瓦查里还指出,如果代理能够理解其任务的高层结构,那么为达到最佳结果所需的这 2000 亿步的模拟训练也就用不着了。

“就像是他们在结论中说的一样,(强化学习的)底层架构还缺乏实现这三件(本体感知、时间意识、理解高层次任务的结构)所需的东西”,他说,“总之,XLand 也只是'差不多相同'而已”。

模拟与现实世界之间的差距

简而言之,这篇论文论证了一个观点,如果我们可以创建一个足够复杂的环境,设计出正确的强化学习架构,在计算资源上不吝啬开销,让模型能够积累出足够的经验,那么我们就可以在同一环境中泛化不同类型的任务。这也是人类与动物在自然进化中开发出智能的过程。

事实上,DeepMind 已经开发出了类似的项目:AlphaZero,一个精通双人回合制游戏的强化学习模型。通过添加零次学习元素,XLand 的实验将这一概念扩展到了更高的层面。

通过 XLand 训练过的代理最终都会将他们获得的经验应用于现实生活中,类似机器人或自动驾驶等应用,但作者并不认为这将会是一个领域的突破。我们仍然需要做出妥协,手动设置限制以减少现实环境的复杂性;或者增加人工强化,比如为机器学习模型灌输先验知识或添加额外的传感器。

DeepMind 的强化学习代理或许已经可以在 XLand 的虚拟世界中称王称霸,但这些模拟的情景也仅仅只是复杂的现实世界的冰山一角而已。这种模拟与现实之间的差距将在很长一段时间内给 AI 代理带来挑战。

原文链接:

https://bdtechtalks.com/2021/08/02/deepmind-xland-deep-reinforcement-learning/