整理 | 华卫

刚刚,月之暗面推出并开源旗舰级开源思维模型 Kimi K2 Thinking。该模型以思维智能体为核心架构,在运用工具的过程中实现逐步推理;支持在无人干预的情况下,连续执行 200-300 次工具调用。通过数百步连贯推理,它能够高效解决各类复杂问题。

项目地址:https://huggingface.co/moonshotai/Kimi-K2-Thinking

Kimi K2 Thinking 的主要特点是:

深度思考和工具编排:经过端到端训练,将思维链推理与函数调用交错,实现持续数百步而不会漂移的自主研究、编码和编写工作流程。

原生 INT4 量化:在训练后阶段采用量化感知训练 (QAT),在低延迟模式下实现无损 2 倍加速。

稳定的长期代理:在多达 200-300 次连续工具调用中保持连贯的目标导向行为,超过之前在 30-50 步后退化的模型。

据介绍,这一成果是月之暗面在测试时扩展技术领域的最新突破,同时实现了思维 tokens 与工具调用步骤的双重扩展。

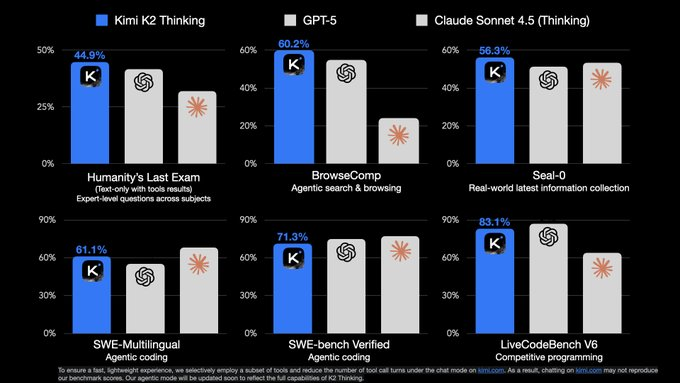

它在 “人类终极测试(HLE)”“BrowseComp” 等权威基准测试中取得顶尖性能,在推理、智能体搜索、编程、写作及通用能力等核心维度实现重大突破。其工具加持下的 HLE 测试得分达 44.9%,BrowseComp 测试得分 60.2%,都超越了 GPT-5、Claude Sonnet 4.5(Thinking)。

目前,Kimi K2 Thinking 已在 kimi.com 的聊天模式中正式上线,完整智能体模式即将推出。用户也可通过 Kimi K2 Thinking API 接入使用。

API 链接:https://platform.moonshot.ai

推理与问题解决能力

在涵盖 100 多个学科、数千道专家级试题的封闭式权威基准测试 “人类终极测试(HLE)” 中,Kimi K2 Thinking 借助搜索、Python 及网页浏览工具,取得 44.9% 的顶尖得分,刷新多领域专家级推理性能纪录。

通过灵活运用各类工具,该模型能够完成规划、推理、执行与自适应调整的全流程,通过数百步操作攻克高难度学术与分析类问题。例如,它曾通过 23 次推理与工具调用的交替协作,成功解决一道博士级数学难题,充分彰显了深度结构化推理与长周期问题解决能力。

编程与软件开发能力

Kimi K2 Thinking 在编程及软件开发任务中表现突出。其在 SWE-Multilingual 测试中得分 61.1%,SWE-Bench Verified 测试得分 71.3%,Terminal-Bench 测试得分 47.1%,展现了跨编程语言与智能体框架的强大泛化能力。

模型在 HTML、React 及组件密集型前端开发任务中实现显著提升,能够将创意构想转化为功能完备、响应式的产品。在智能体编程场景中,它可边推理边调用工具,无缝融入软件智能体工作流,精准且灵活地执行复杂多步骤开发任务。

智能搜索与浏览能力

在专门评估模型 “持续浏览、搜索并推理难获取真实网络信息” 能力的高难度基准测试 BrowseComp 中,Kimi K2 Thinking 取得 60.2% 的高分,大幅超越 29.2% 的人类基准成绩。这一结果印证了其在目标导向型网络推理任务中的卓越表现,以及在动态、信息密集环境中的强稳健性。

该模型支持 200-300 次连续工具调用,依托长周期规划与自适应推理机制,构建 “思考→搜索→浏览→思考→编程” 的动态循环。通过持续生成并优化假设、验证证据、推理分析,它能够将模糊开放的问题拆解为清晰可执行的子任务。

写作能力

创意写作:在内容完整性与丰富度上实现提升,对文体风格与指令的把控更精准,能自然流畅地驾驭多种语气与格式。写作内容更生动富有想象力,诗歌意象联想更深远,故事与剧本更具人文温度、情感张力与主题内核,表达的思想兼具深度与共鸣感。

实用写作:推理深度、视角广度与指令遵循度显著增强,能精准响应提示要求,清晰系统地落实各项需求,且常对提及要点进行拓展以确保覆盖全面。在学术写作、研究报告及长篇分析类文稿中,擅长产出严谨规范、逻辑连贯且内容详实的作品,在学术与专业场景中表现尤为出色。

个人与情感类写作:回应个人或情感类问题时更具同理心与平衡性,思考过程缜密且具体,能提供多元视角与可行方案。以务实、真诚的语气,帮助用户清晰、审慎地应对复杂决策。

量化优化

低比特量化是降低大规模推理服务器延迟与 GPU 内存占用的有效手段,但思维模型的解码长度较长,量化后往往会导致性能大幅下降。

为解决这一难题,他们在训练后阶段采用量化感知训练(QAT)技术,对混合专家(MoE)组件实施 INT4 仅权重量化。这一方案使 K2 Thinking 原生支持 INT4 推理,生成速度提升约 2 倍,同时保持顶尖性能水平。文中所有基准测试结果均基于 INT4 精度得出。

参考链接: