人工智能的未来在哪里?答案很可能是量子机器学习。量子机器学习(Quantum ML)是一个结合量子物理和机器学习的跨学科领域。它是一种互利互惠的结合 —— 利用量子计算产生机器学习算法的量子版本,使用传统的机器学习算法分析量子系统。

人工智能与机器学习

当你听到“人工智能”这一词时,你会想到什么呢?不久前,“人工智能”还被人们用来描述想象中的遥远未来,在那里,世界上已经出现了机器人仆人和自动驾驶汽车等等。听起来是不是有似曾相似的感觉?实际上,这就是我们今天生活的世界。现在,我们有像 Siri 这样的个人助理来回答我们的任何问题,Tesla 可以在我们打旽的时候从一个地方开到另一个地方,Snapchat 还有许多滤镜可以瞬间改变我们的外观……人工智能的时代已经到来。

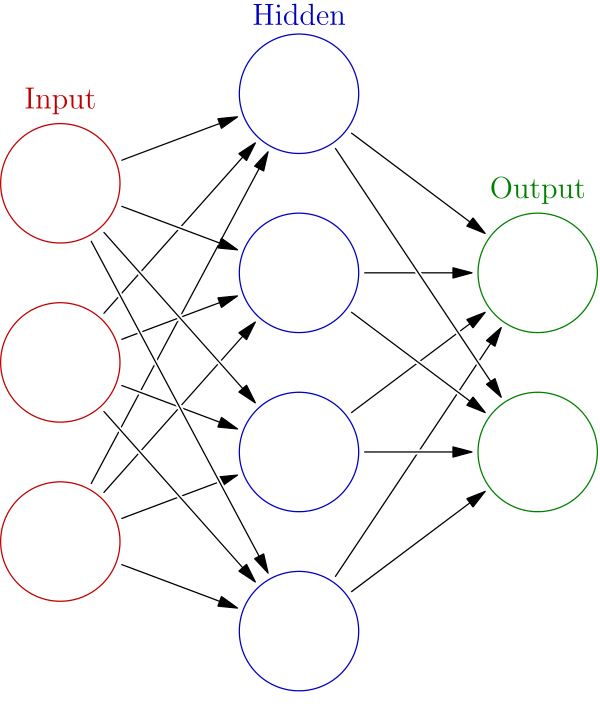

机器学习是人工智能的一个子集,它利用算法教会计算机像人类一样作出决策。人工神经网络是一种特别的机器学习算法,用于模拟人类大脑。这些神经网络通过获取信息,经过一系列人工神经元处理信息并产生输出来模拟人类大脑的工作方式。(见图 1)

图 1:神经网络建模为一系列相互连接的人工神经元

量子计算简介

量子计算是另一项创新,有望将人工智能提升到新的水平。量子计算机利用量子力学的特性来处理信息。传统计算机以比特为单位对信息进行编码,比特值可以是 0 或者 1。相反,量子计算机以量子比特为单位来编码信息,就像比特一样,量子比特的值可以是 0 或者 1。然而,量子比特可以同时具有多个态,这是一个叫做“叠加”的量子概念。因此,两个量子比特可以呈现四种可能状态中的任何一种:01、11、10、00。一般来说,n 个量子比特可以代表 2^n 个不同的状态。这种(非常简化的)叠加概念使量子计算机比传统计算机强大的多。它们可以用更少的计算能力来代表更多的信息。

AI 前线注:有关量子计算机的知识,可参阅在线课程《Quantum computing 101》:

https://uwaterloo.ca/institute-for-quantum-computing/quantum-computing-101

量子机器学习

神经网络的一个主要障碍是,训练它们作出决策所需的时间。由于计算能力的缺乏,因此,花上数周甚至数月的时间来训练神经网络的情况并不罕见。如果有一种方法可以利用量子计算的力量来加速训练过程,使这些复杂的神经网络变得可行呢?让我们进入量子机器学习一探究竟吧。

量子机器学习,顾名思义,就是机器学习和量子计算的交集。量子机器学习旨在利用量子计算机的强大功能,以比传统计算机快得多的速度来处理信息。然而,它并不像将现有代码从 CPU 移植到量子处理器那么简单。代码首先需要能够使用量子比特的量子语言。今天大部分关于量子机器学习的研究都在试图解决这个问题。

量子神经网络

方法

功能性神经网络是人工智能向前迈出的一大步。然而,现有的神经网络尚不能利用量子计算机的力量。创建可用的量子神经网络的第一步就是对单个量子神经元建模。

让我们看一下量子神经元的表示方式,以及量子神经网络与传统神经网络的比较。由于量子力学有不同的诠释,因此有不同的方法来表示量子神经元。其中一种解释是 Huge Everett 的多世界诠释。简言之,这个理论认为,有许多平行宇宙,每个宇宙都在同时展现每一个可能的历史和未来。

AI 前线注:多世界诠释(the many-worlds interpretation,缩写:MWI)是量子力学诠释的一种。它是一个假定存在无数个平行世界,并以此来解释微观世界各种现象的量子论诠释,其优点是不必考虑波函数塌缩。该理论也被称为相对状态提法、Everett 诠释、普遍的波函数、多宇宙诠释,或者多世界理论。

1957 年,最初的相对状态提法由 Huge Everett 特发表。后来在 1960 年代和 1970 年代,这一提法普及,并由 Bryce Dewitt 改名为多世界理论。退相干方法在解释量子理论方面得到了进一步的探索和发展,因而相当受欢迎。多世界诠释是物理学和哲学众多平行宇宙假说之一。除了多世界诠释,目前的量子力学诠释主要还包括:退相干诠释、坍缩诠释(又分客观性坍缩诠释和传统的哥本哈根诠释)、隐变量理论(主要是非局域隐变量理论例如德布罗意 - 玻姆理论)等等。

听起来非常复杂,非常抽象,是吧?因为确实如此。多世界诠释对量子神经网络应如何表现提供了见解。就像传统神经网络模仿人类大脑一样,量子神经网络也能模仿量子物理学。宾夕法尼亚州立大学的研究人员利用这一诠释开发了一种构建量子神经网络的方法。

AI 前线注:宾夕法尼亚州立大学的研究成果可参阅《Quantum neural networks》(《量子神经网络》):

传统的神经网络使用单个网络来存储许多模式。如果量子神经网络使用许多网络来存储许多模式,就像可能存在许多包含许多现实的宇宙一样,该会怎么样?量子叠加可以使这成为可能。记住,叠加意味着一个量子比特有可能同时处于多种状态。从理论上来讲,将这个类比推广到神经网络,量子神经网络将能够通过一次叠加同时存储所有可能的模式。因此,网络中的每个模式都代表它自己的平行宇宙。

这是量子神经网络的许多理论框架之一。如果你对这个理论的细节感兴趣,请查看宾夕法尼亚州立大学研究团队完整的论文《Quantum neural networks》。表示多个并行宇宙的量子神经网络的实际实现目前尚不可行。然而,模拟单个量子神经元还是有可能实现的。

实现

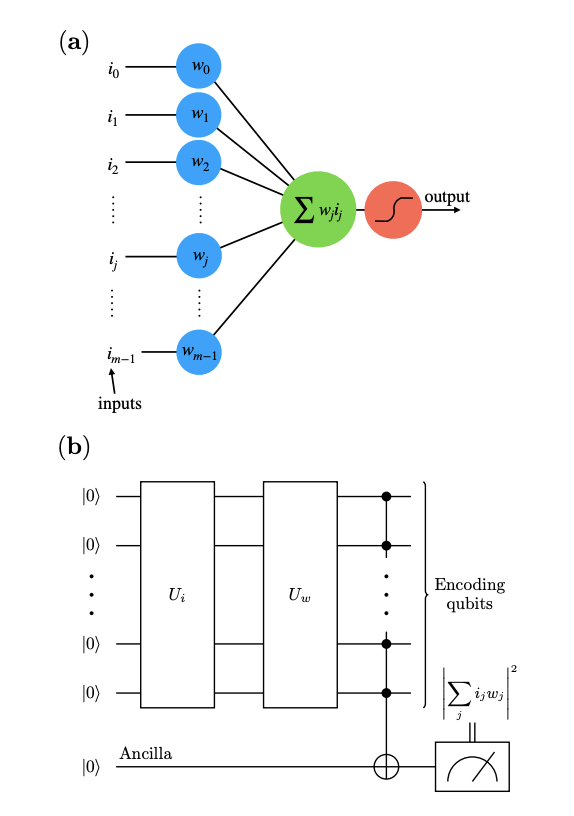

据麻省理工科技评论(MIT Technology Review)报道,2018 年,意大利帕维亚大学的研究团队在量子计算机上实现了世界上第一个单层神经网络(见图 2)。

AI 前线注:

麻省理工科技评论的报道见《Machine learning, meet quantum computing》(《机器学习遇见量子计算》):

https://www.technologyreview.com/s/612435/machine-learning-meet-quantum-computing/

帕维亚大学的论文见《An Artificial Neuron Implemented on an Actual Quantum Processor》(《在实际量子处理器上实现的人工神经元》):

图 2:人工神经元的经典模型(a)和人工神经元在量子处理器上的量子实现方案(b)

在具有单个神经元(a)的经典神经网络中,输出是通过激活函数将输入向量映射到二进制输出的加权和。在抽象层次上,量子神经网络以相同的方式工作,但在量子处理器上的实现却是不同的。量子网络的第一层将输入向量编码为量子态。然后,第二层对输入执行酋变换(unitary transformations,亦称幺正变换),类似于权重向量在经典神经网络中的运作方式。你可以将酋变换想象成计算机将比特转换为量子比特。最后,输出写在 Ancilla 量子比特上,产生最终输出。

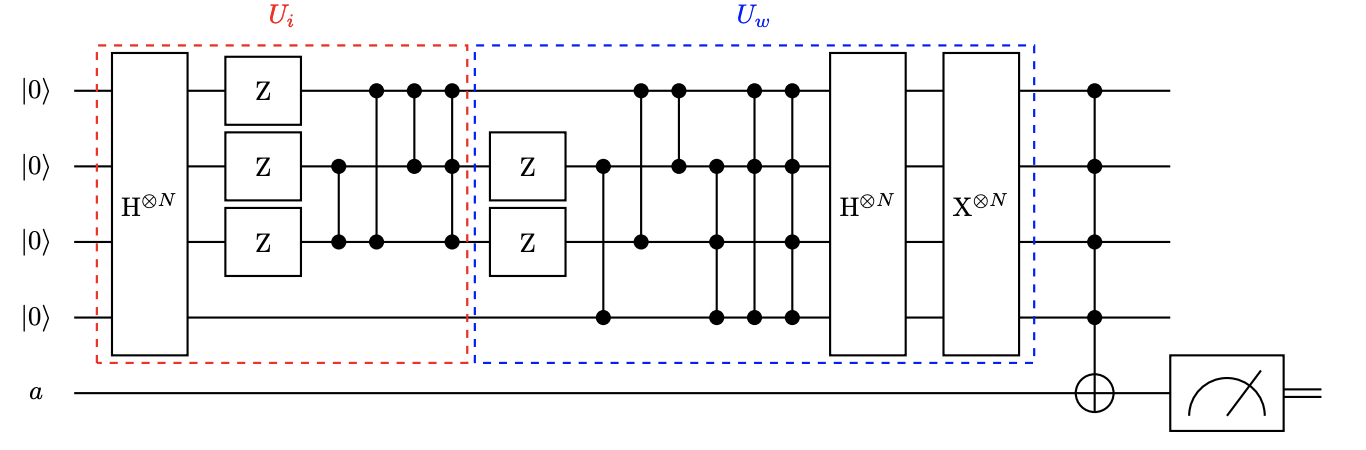

在量子处理器上实现的酋变换是很复杂的,见图 3。在高层次上,输入通过一系列门,这些门是量子电路的一部分。这些门分别标识为 Z、H⊗N、X⊗N,模拟传统神经网络中的权向量。

图 3:具有 4 个量子比特的人工神经元的量子电路。

该模型能够准确地模拟单个神经元的行为。然而,它还没有扩展到由多层神经元组成的深度神经网络。像这样的单层模型能够识别简单的模式,但是还不能扩展。这是在量子硬件上有效训练量子神经网络的第一步,也是实现神经网络多世界诠释的第一步。

量子神经网络的优势

量子神经网络看起来非常复杂,难以理解。但是有一个很好的理由可以解释为什么要去研究量子神经网络。据宾夕法尼亚州立大学的研究团队的论文称,与传统神经网络相比,量子神经网络具有很多优势,包括:

指数级记忆容量

隐藏神经元数量越少,性能越高

更快的学习

更快的处理速度(1010 比特 /s)

更小的规模(1011 神经元 /mm3)

更高的稳定性和可靠性

以上这些优势解决了传统神经网络的大部分(如果不是全部的话)局限性问题。这意味着量子机器学习领域的先行者,极有可能会利用这些优势。目前,人们正在努力实现功能齐全的量子神经网络。

当前和未来的工作

研究

Google 的 Quantum AI 团队是量子机器学习的先驱之一。他们构建了一个可以在量子计算机上训练的深度神经网络的理论模型。虽然缺乏当前的硬件来实际实现该模型,但他们的结果令人鼓舞。一旦将来硬件可用的时候,他们创建的框架将允许人们快速采用量子机器学习。

AI 前线注:Google Quantum AI 团队的研究论文可见《Classification with Quantum Neural Networks on Near Term Processors》(近期处理器上的量子神经网络分类》):

此外,Google AI 团队还研究了神经网络如何在量子处理器上进行训练。传统的网络训练方法是将训练之前的权值进行随机初始化。然而,他们发现这种方法在量子空间中并不适用。因此,在训练量子模型时,会出现诸如梯度消失等问题。通过研究,Google AI 团队正在为量子机器学习的未来奠定基础。

量子问题

专注于让传统神经网络以量子速度进行训练是一个很自然的起点,无疑也是一项非常重要的工作。但是量子计算的魅力在于解决量子问题的能力。不过,这些类型的问题对传统计算机来说实在太过复杂,以至于无法有效地进行建模,更不用说让人类大脑去理解了。那么量子机器学习能够做哪些我们目前无法做到的呢?

这个问题的答案并不像人们希望的那样令人满意。鉴于量子机器学习的前沿知识到最近才被人们涉足,现在就期待任何重大的量子问题得到解决,还为时尚早。一个很酷的探索领域是使用量子神经网络来发现新的乐器。简而言之,这个神经网络可以生成演奏全新声音的乐器。

量子神经网络的另一个令人兴奋的应用是模拟黑洞和人类大脑。这两者的共同特点是惊人的内存存储能力。理论上,与传统计算机相比,量子计算机的额外容量可能能够捕获到这一特征。所创建的量子神经网络能够存储和检索指数级的大量模式。虽然很难得出任何具体结论,但这些结果鼓励人们为量子物理学的未来应用提供建议。

AI 前线注:关于量子神经网络模拟黑洞和人类大脑可参阅论文《Black Holes as Brains: Neural Networks with Area Law Entropy》(《黑洞作为大脑:面积熵定理的神经网络》:

此时,量子神经网络更多地尚处于胎儿期,而非青春期。Google AI 团队与其他人正在进行的研究,有助于为量子机器学习领域的未来工作奠定基础。量子神经网络的未来应用是不确定的,也许对大多数人来说过于抽象而无法理解。但可以肯定的是,无处不在的量子机器学习终将会出现,对于它的实现,公众很容易感到兴奋。

原文链接:

https://medium.com/sfu-big-data/quantum-machine-learning-future-of-ai-386fb77f59ca

评论