在 AI 驱动应用革新的浪潮下,海量数据处理的性能与成本如何平衡,成为所有科技企业面临的核心挑战。在前段时间举行的 Couchbase 技术直播中,爱奇艺智能平台部数据库团队资深专家程利老师的现身说法,为业界提供了一个极具参考价值的范本。

这场主题为“Couchbase 梦工厂开工!带你做出用户体验满分的 AI 应用”的直播,不仅展示了 Couchbase 作为 AI 原生数据平台的前瞻能力,更通过爱奇艺这一头部视频平台的十年深度实践,揭秘了 Couchbase 如何在高并发、大数据量的严苛场景中,破解性能、扩展性与总拥有成本(TCO)的三角难题。

核心架构揭秘——一站式多模态数据平台

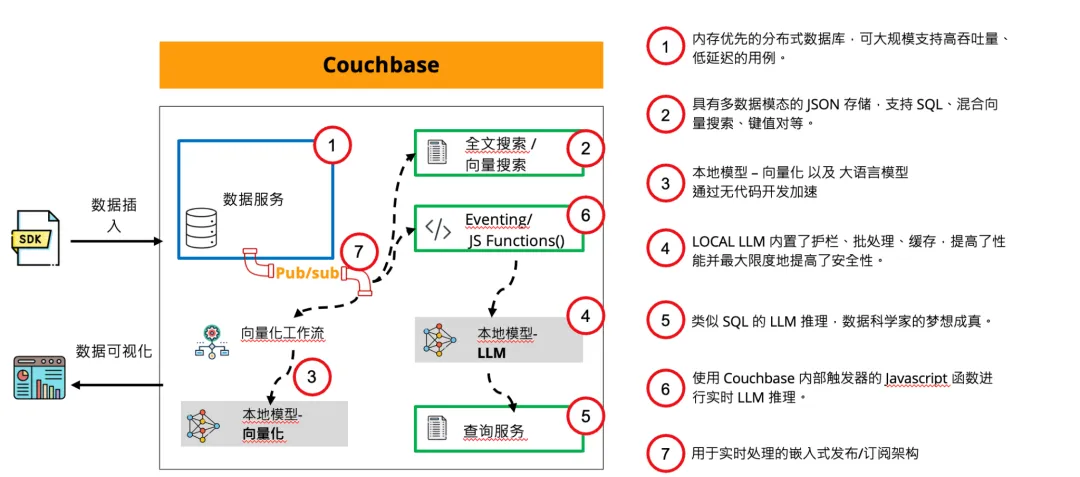

Couchbase 的差异化优势源于其前瞻性的架构设计。它并非简单的键值数据库,而是一个融合了交易、分析、搜索与向量能力的统一平台。

内存优先架构:内置集成缓存层,提供亚毫秒级响应,为实时应用奠定基础;

弹性扩展与高可用:原生分布式设计支持在线秒级扩缩容,通过主动 - 主动 XDCR 技术实现跨数据中心复制,保障业务 24/7 高可用;

多模型数据服务:开发者可在同一平台上使用键值 (Key-Value)、文档 (JSON)、SQL++ 查询、全文检索、向量搜索等多种数据访问方式,极大简化技术栈。

爱奇艺深度实践——从社区版到 Magma 引擎的选型进化论

直播的重头戏是来自爱奇艺智能平台部数据库团队资深专家程利老师的干货分享。作为从 2012 年就开始使用 Couchbase 的资深用户,爱奇艺的实践经验经历了从社区版到企业版、从 Couchstore 到 Magma 存储引擎的完整演进,其对 Couchbase 的深度应用与选型思考,对业界具有极高的参考价值。

程利老师介绍,在爱奇艺,Couchbase 被定位为一个成熟的缓存型 KV 服务,内部已围绕其构建了一整套运维与自助服务平台。目前,Couchbase 主要服务于搜索、广告、推荐等对实时性要求较高、数据量较大的业务场景。

企业内部的技术选型“硬指标”

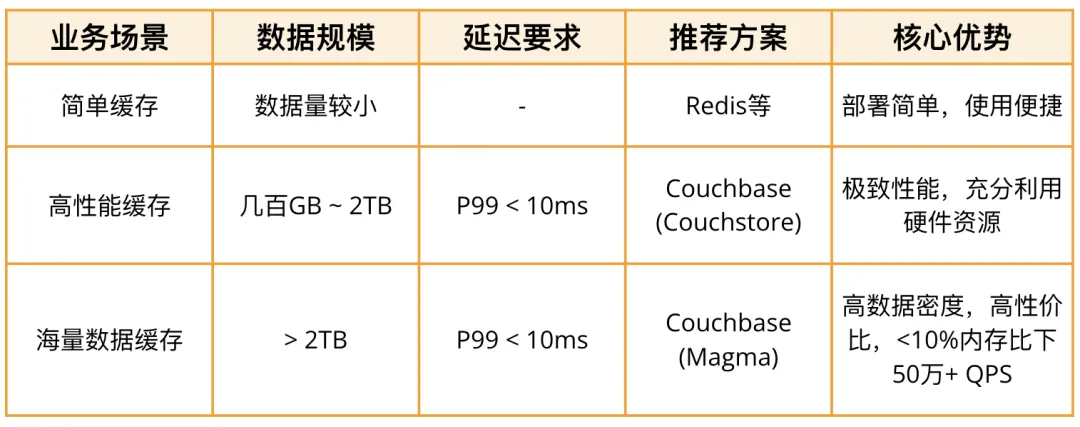

程利老师首次对外分享了其团队内部的 缓存技术选型指引,这为众多面临类似抉择的企业提供了清晰的参考框架:

场景一:数据量几百 GB 至 2TB,P99 延迟要求 10 毫秒以内

推荐方案:使用 Couchbase 的 Couchstore 存储引擎;

核心依据:Couchbase 能充分利用高配物理机的全部内存和 CPU 资源,提供极致的读写性能。

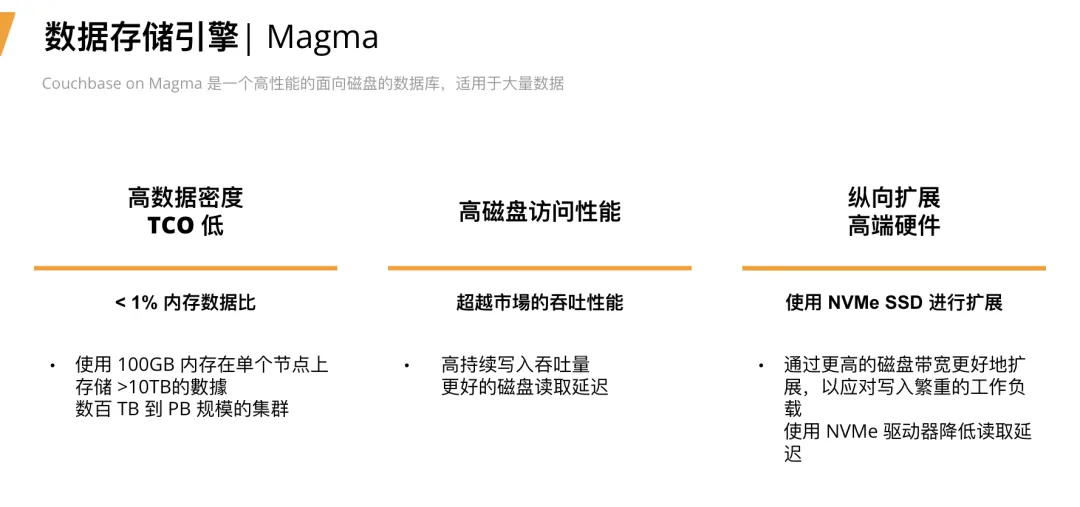

场景二:数据量超过 2TB,仍需保障低延迟

推荐方案:使用 Couchbase 的 Magma 持久化引擎;

核心依据:Magma 引擎通过创新的存储设计,实现了 极高的数据密度,在保证性能的同时,能大幅降低因全量数据存入内存带来的高昂成本。

技术依据深度拆解:为何是 Couchbase?

除了数据规模,程利老师进一步拆解了更深层的技术选型依据,揭示了 Couchbase 在大规模生产环境中的独特优势:

强大的持久化与高可用保障:“我们推荐大数据量业务使用 Couchbase,不仅因其性能,更因为它能快速进行扩容 / 下线节点,能在 1 分钟以内剔除故障节点以保障可用性,这对于业务连续性至关重要。”

卓越的 Rebalance 能力:“Couchbase 在数据重平衡(Rebalance)上表现优异。对于 1TB 左右的数据,大部分场景下能在 2 小时内完成 Rebalance,实际速度与集群负载和 Key 数量相关。这远优于一些在数据同步上容易产生瓶颈的方案。”

成熟的异地容灾方案:“我们通过 XDCR 技术将数据实时同步到异地,构建了可靠的热备方案,为业务提供了跨地域的灾难恢复能力。”

实战检验:Couchbase Magma vs. 自研方案的性能对决

针对业界关心的“用低内存比的数据库做缓存”这一看似“反直觉”的操作,爱奇艺通过严谨的测试给出了答案。程利老师透露,团队曾自研持久化 KV 存储以应对成本压力,但随着数据规模扩大,运维复杂度和长尾性能保障压力倍增。

为此,他们对 Couchbase Magma 引擎进行了深度验证:

测试环境:基于 NVMe 盘的高配物理机(3 台 48 核);

测试数据:写入 8 亿条 Value 为 2KB 的数据,活跃数据内存驻留率设置为 10;

结果:压测读取 QPS 可达 50 万 +,P99 延迟稳定在 10 毫秒以内。

“这一性能表现相对于我们自研的方案展现了优势,”程利老师总结道,“当然,性能数据基于物理机 NVMe 盘,在公有云虚机上会受云盘 IO 限制。但正是基于 充分的内部 POC、多年的产品稳定性认知以及 Couchbase 团队的有力支持,我们才做出了引入 Magma 引擎的战略决策。”

未来展望:从 KV 缓存到多模与 AI 的横向扩展

展望未来,爱奇艺计划横向拓展 Couchbase 的应用边界。程利老师表示:

深化 XDCR 应用:“我们希望用上更完善的多源同步(多个集群互相同步) 功能,实现业务就近读写。”

探索向量能力:“当前 AI 发展火热,公司对向量存储需求旺盛,未来我们会积极探索 Couchbase 的原生向量搜索能力,以支持 AI 业务场景。”

Couchbase 关键数据对比信息

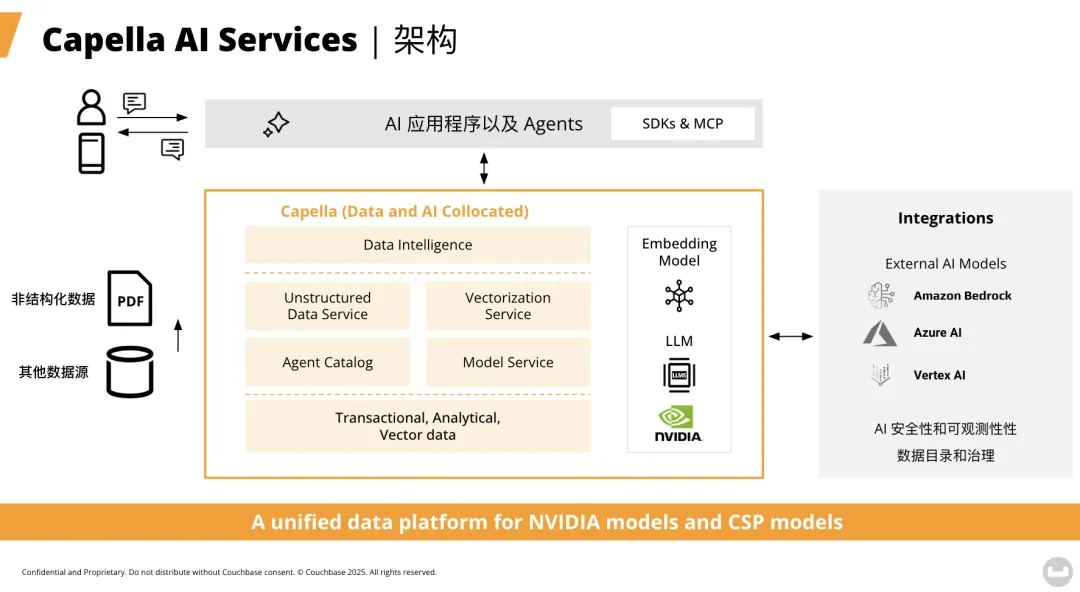

AI 实战前瞻——Capella AI Services 赋能智能应用开发

面对 GenAI 浪潮,Couchbase 推出了 Capella AI Services,将 AI 能力深度集成到数据平台中,让开发者能快速构建 RAG(检索增强生成)等智能应用。

直播中通过一个“GenAI 內容实时处理管道”的案例,直观演示了其工作流程:

利用本地向量化模型以及本地大预言模型加速数据的处理,增强安全性;

基于本地向量化模型对新数据的写入实时向量化;

利用内置的 CDC 架构把新的数据进行实时分析,包括在 SQL 语法中直接调用本地大预言模型对数据进行分析(比如情感分析,总结,归类等);

利用 Couchbase 的多数据模态(包括 JSON 存储,支持 SQL、混合向量搜索、全文搜索等),将复杂的数据场景结合到一个数据库,做到了数据站的整合以及对研发的加速。

这一集成方案避免了在多个独立系统(如向量数据库、缓存、应用数据库)之间进行复杂的 ETL 和数据同步,大幅降低了开发复杂度和系统延迟。

迈向 AI 原生的统一数据架构

本次直播清晰地表明,未来的智能应用需要一个能够处理多模态数据、提供极致性能并原生支持 AI 工作负载的数据基础架构。Couchbase 通过其统一、灵活且高性能的平台,正帮助企业将离散的数据技术整合起来,有效解决 LLM 幻觉、数据安全、扩展性成本等核心挑战。

无论是用于替换传统缓存、构建实时 Web/ 游戏平台,还是作为企业业务中台和 AI 应用的核心引擎,Couchbase 都展现出强大的竞争优势。

错过直播的朋友可以观看回放。 期待 Couchbase 能助力更多中国企业打造下一代智能应用。

如需了解更多,欢迎联系:bryan.xu@couchbase.com