xAI 正式发布 grok-code-fast-1,这是一款专为代理式编程(agentic coding)工作流打造的新模型。其架构自底层重新设计,预训练数据集以编程相关资料为主,后训练集则来自真实的 pull requests 与实际开发任务。

该模型针对开发工具的使用进行了优化,涵盖 grep 命令、终端操作、文件编辑等,能够与开发环境和 IDE 顺畅集成。同时,它引入了高效的推理与提示缓存技术,据称在合作伙伴的工作流中,缓存命中率超过 90%。

在编程语言支持方面,Grok Code Fast 1 可覆盖 TypeScript、Python、Java、Rust、C++、Go 等,能够应对开发者的日常任务——从项目搭建、代码库查询,到精准修复 bug,几乎无需过多人工干预。

性能评测显示,在 SWE-Bench-Verified 基准测试中,该模型在 xAI 内部评估体系下取得 70.8% 的成绩。除了基准测试,xAI 还通过人工评估与自动化测试不断迭代开发,重点关注模型在真实场景中的可用性。

为了支持快速交互,模型配备了 256k Tokens 的上下文窗口,能够处理更大规模的代码库。其内部采用 混合专家架构(MOE,mixture-of-experts),参数量约 3140 亿,在保证速度的同时强化编程能力。在实际使用中,生成速率约为每秒 92 Tokens,足以满足开发过程中的互动节奏。

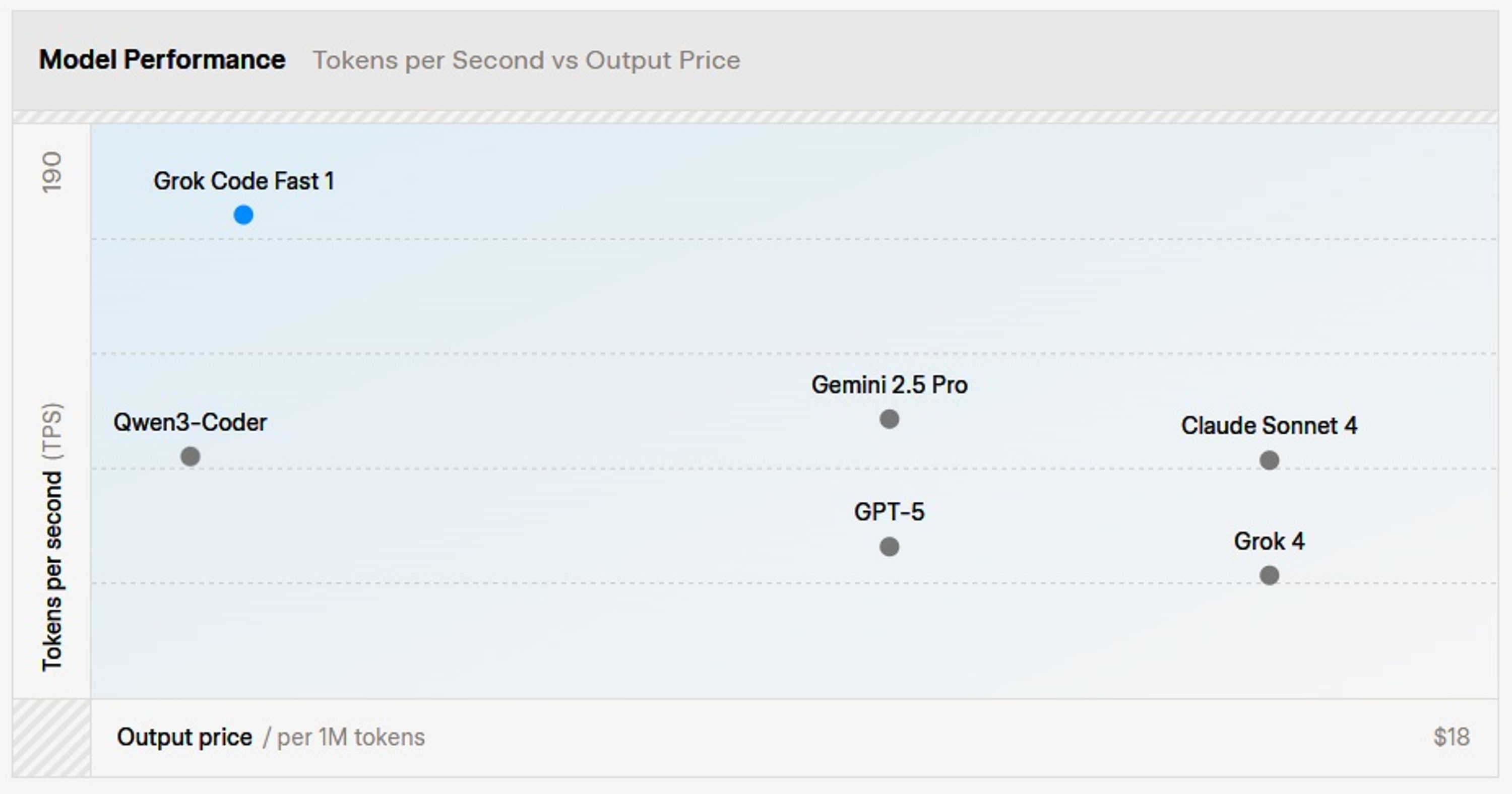

与其他面向编程的大语言模型相比,grok-code-fast-1 的核心优势并非极致的基准精度,而是速度与工具集成。例如,OpenAI 的 o1-mini 与 Anthropic 的 Claude Sonnet 3.5 在部分任务上展现出更高的推理或代码准确率,但在提示缓存优化或吞吐效率上并未达到同样水平。其混合专家设计在架构上更接近 Google DeepMind 的 Gemini 1.5 Pro,但更专注于软件开发场景的适配。

在社区反响方面,开发者普遍关注 Grok Code Fast 1 的执行速度。软件工程师 Eric Jiang 表示:

“过去几周我每天都在使用这个模型,它的速度让我的工作效率提升巨大,真是太好用了!”

也有评论聚焦在具体使用场景和易用性上,讨论该模型在日常开发中的角色,以及与编辑器、命令行工具的集成问题。开发者 Jonathan Parra 提到:

“很不错,我早就期待这样的工具了,不过要有个 CLI 才能和 Claude Code 竞争。”

目前,grok-code-fast-1 可通过部分合作伙伴免费体验一段时间,其中包括 GitHub Copilot、Cursor、Cline、Roo Code、Kilo Code、opencode和 Windsurf。xAI 表示将以高频率迭代更新模型,并透露正在训练的新版本将支持多模态输入、并行工具调用和更长的上下文窗口。

原文链接: