2023 年,生成式 AI 研究和应用的爆发给云计算产业带来了全新的机遇和挑战:大模型需要庞大的算力支持,用户普遍需要向云计算厂商购买算力服务;且由于大量用户涌入云服务市场,云厂商需要尽快升级数据中心算力以应对 AI 需求,同时持续降低 TCO,为用户提供价格合理的算力资源;此外,AI 应用开发还涉及大量隐私敏感数据的云端存储和使用,云厂商也要全力保障这些数据的安全可靠,打消用户后顾之忧。

基于上述需求,云厂商迫切需要对已有硬件基础设施进行更新换代,要求新一代 CPU 能在保障基础设施平稳升级迭代的同时,具备更强的性能、更低的 TCO,同时能够满足云端多样化工作负载需求的较强 AI 能力:

对于大型云服务基础设施而言,稳定性、可靠性依然是王道,因此云服务厂商升级硬件时决策更加谨慎,偏向于在有着长期延续性的主流平台上逐渐迭代,保护上层软件应用投资,减小对基础设施开发运维部门的冲击。

大模型在云端训练、推理的过程需要用户将大量数据传输至云端,云厂商需要采取更强的安全措施,如硬件级的安全引擎来更好地保障敏感数据的安全,确保云实例间的数据隔离,预防恶意入侵和泄漏。

AI 应用涉及密集的低精度矩阵运算,需要较大的内存空间。对于大模型推理应用和中小尺度(参数规模低于 20B)模型的训练应用而言,其在搭载 AI 加速器的 CPU 上运行可以获得非常好的能耗比与性价比,还能够以极具优势的 TCO 满足云厂商大多数 AI 服务的需求。同时 CPU 的通用计算能力也可以为云厂商提供充足的灵活性,有效保护基础设施投资。

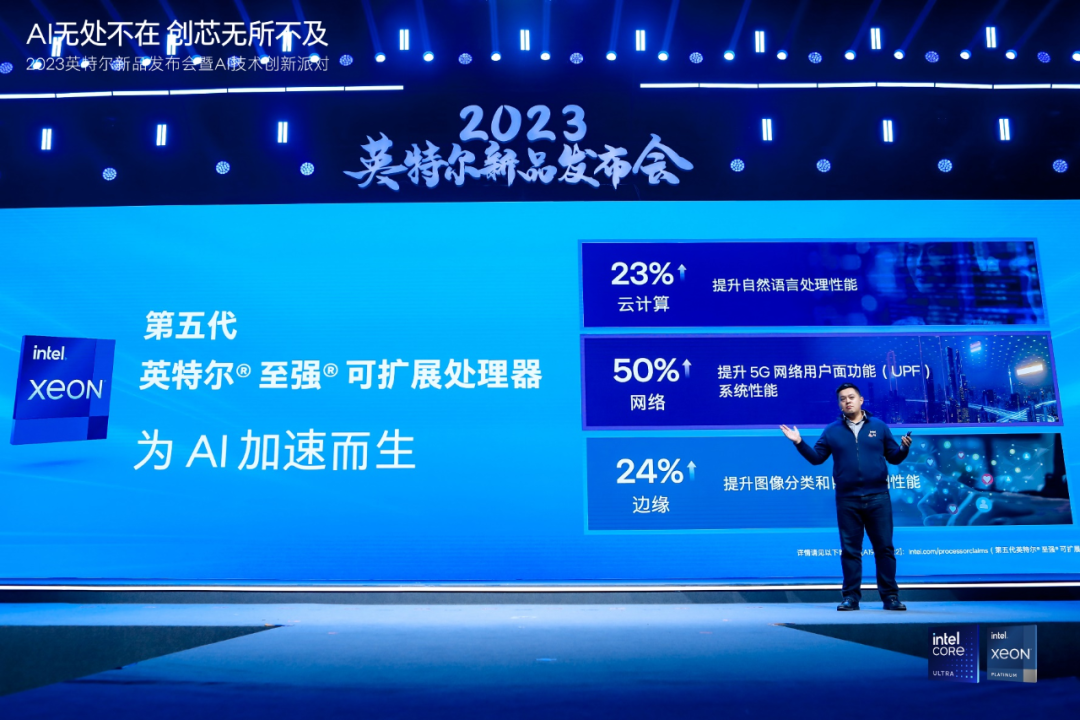

面对上述需求,英特尔作为服务器 CPU 领域的技术领导者,继年初发布第四代至强® 可扩展处理器之后,加快了产品更新节奏,于上周发布了第五代至强® 可扩展处理器,其可与上一代处理器兼容,提供硬件级安全和可信服务,并通过丰富的 AI 产品组合驾驭整个 AI 管线,从而进一步壮大了应对人工智能时代的产品组合。

1 技术创新解决三大维度需求,CPU 继续扮演 AI 时代基础设施关键角色

相比上一代产品,第五代至强® 可扩展处理器的核心数量增加至 64 个,拥有更高的单核性能和内存带宽,三级缓存容量提升近 3 倍。其每个内核都具备 AI 加速功能,内置的英特尔® AVX-512 及英特尔® AMX,能使机器学习、深度学习和大模型应用的性能大幅提升。第五代至强® 可扩展处理器还能通过英特尔® SGX/TDX 为使用中的云端数据提供端到端硬件级防护能力。与上一代至强® 可扩展处理器相比,五代至强® 在相同功耗下的平均性能提升了 21%,而 AI 推理和训练性能的提升更是高达 42% 和 29%。

一系列技术创新,使第五代至强® 可扩展处理器成为 AI 时代云厂商的基础设施关键角色。目前,已经有多家客户在实际业务中部署了第五代至强® 可扩展处理器,在实践中证明了它为用户带来的巨大收益提升。其优异的表现得到了客户的很高评价,也让更多准备升级云计算基础设施的企业对新一代至强® 有了更高的期待。

2 英特尔 AMX 提升大模型推理性能,助力京东升级营销购物体验

2023 年京东云突破性地在数百个 AI 场景中应用了大模型,在数百个营销场景中升级了原有工作流,显著提升了商家与消费者的购物体验。

基于自研的言犀 AI 与大模型,京东云通过 AIGC 管道生成了 30% 的大促物料,京小智数字人、领航者营销平台也在大模型支持下获得了高达 87% 的商品推荐采纳率,消费者应答准确率提升 30%。

京东大模型第一次亮相就收获完美成绩,很大程度上要归功于其部署的基于第五代英特尔® 至强® 可扩展处理器的新一代自研服务器,与上一代自研服务器相比整机性能提升 23%,关键的 AI CV 推理性能与 Llama v2 大模型推理性能更是分别提升 38% 与 51%。

取得如此显著的 AI 推理能力进步,秘诀在于第五代至强® 可扩展处理器搭载的英特尔® AMX 加速引擎。其可以将 INT8 低精度矩阵运算速度提升一个数量级,再结合第五代至强® 可扩展处理器更高的内存带宽与更强的多核心互联能力,使 AI 推理性能相较上一代显著提升。在 11.11 大促中,第五代至强® 可扩展处理器和英特尔® AMX 的组合在京东云承载的 AI 推理应用服务中大展身手,助力用户访问峰值同比提升 170%,智能客服咨询服务量超 14 亿次,且并未增加能耗,也将京东云基础设施的运维成本维护在之前的水平内。

3 英特尔® TDX 赋能可信计算环境,为阿里云客户构筑端到端数据安全城墙

对于云计算厂商而言,要让更多行业和组织信任云服务,就必须提供有足够说服力的安全隐私保障,所以云厂商迫切需要更高水准的硬件级安全城墙。

对于云环境中使用状态中的数据,机密计算是实现其有效保护的良策,其为客户敏感数据提供了基于硬件设备的可信执行环境(Trusted Execution Environment, TEE),通过隔离保护的方式来防止未经授权的入侵者访问或修改处理中的数据。作为机密计算技术的重要引领者,英特尔® 软件防护扩展(英特尔® SGX)技术提供了应用层面的隔离能力;而在和阿里云的合作中,则由英特尔® TDX 技术与阿里云新实例搭载的可信平台模块(TPM)相配合,结合阿里云自研的加密计算隔离环境 enclave,为阿里云第八代企业级 ECS 实例 g8i 构建了一个基于虚拟化的硬件可信环境,即为整个虚拟化实例(包括虚拟机、容器)都构建出可信的边界,由此为客户提供了可信边界更大、更易部署的安全云环境。

英特尔® TDX 使 TEE 环境的可信边界获得了有效扩展,从而让 IaaS、PaaS 等环境中的云工作负载都能整体纳入机密计算的数据保护之下,能够有效抵御恶意威胁,加强云端数据隔离。

阿里云自研的千问大模型就得到了英特尔® TDX 的充分保护,实现模型数据端到端加密保护。英特尔® TDX 技术为 AI 大模型这样需要向云端传输大量数据的应用场景铸就了足够牢固的安全保障,也为生成式 AI 应用广泛普及铺平了信任道路。此外,在引入第五代至强® 可扩展处理器之后,第八代企业级 ECS 实例在计算、网络、存储、安全等工作负载中的都得到了显著提升,在数据库、硬件加解密、AI 应用、音视频等场景性能提升 15%~25% 不等。更重要的是,八代实例保持价格不变,使阿里云 g8i 实例可以用更小的性能开销保障用户的数据高度安全性。

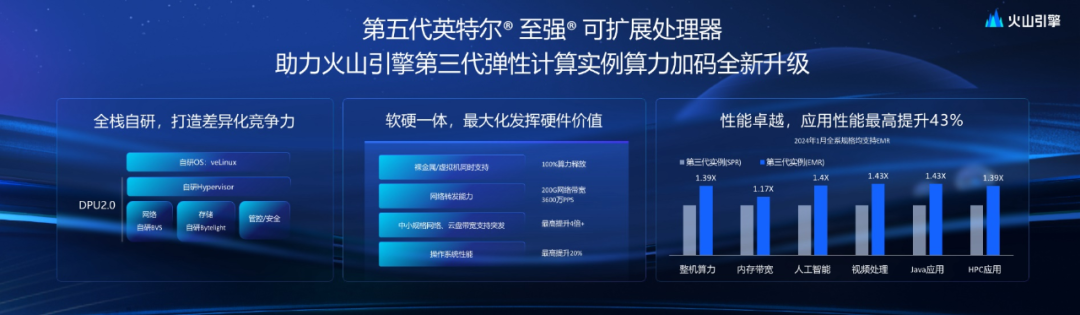

4 第五代至强® 可扩展至强算力大升级,支持火山引擎实现降本增效目标

火山引擎的大规模云原生基础设施包含超过一百万台服务器、上千万容器实例,管理数十 EB 级别存储资源,需要应对 10 亿 + 级 QPS 缓存峰值、10+TB/s 的读写峰值带宽,支持数亿日活的应用访问。

为了应对如此复杂的需求,火山引擎一直都选择和信赖英特尔® 至强® 解决方案,并率先引入第五代至强® 可扩展处理器,助其第三代弹性计算实例加码全新升级。

与基于第四代至强® 的弹性计算实例相比,第五代至强® 可扩展处理器助力火山引擎释放了巨大算力和性能红利,其弹性计算实例整机算力提升 39%,内存带宽提升 17%,并在 AI、视频处理性能、Java 应用性能等方面均有 40% 左右的性能提升。火山引擎计划推出使用英特尔原生硬件加速技术的能力升级,以 Nginx 为例,使用英特尔® QAT 进行数据压缩和证书验证操作的吞吐量最高可提升 5 倍;在 RocksDB 中,使用英特尔® IAA 进行数据压缩读写的吞吐量最高可提升 1.9 倍。提升如此巨大的算力进化幅度,使火山引擎能够使用相同的实例数量应对更多业务需求。

如今,火山引擎正在构建百万核心级别弹性资源池,为业务的流量增长、体验创新与安全性增强提供海量算力保障。

第五代至强® 可扩展处理器提供澎湃的算力的同时,还与上一代处理器兼容,共享架构与平台,大大减少测试和验证工作,其更高的性能、更好的安全性、更高的成本效益,已经在头部云服务提供商中得到全面验证。

5 软硬结合,打通 AI 创新底层瓶颈

除硬件方面的诸多创新,第五代至强® 可扩展处理器在软件层面也搭建了良好的生态环境。例如,英特尔已经在 Pytorch、Tensorflow 和 OpenVINO™ 工具套件等行业标准框架中提供了针对第五代至强® 可扩展处理器的优化,使得云厂商和用户能够以较低的门槛,快速利用如英特尔® AMX 等处理器功能,打通 AI 应用的算力瓶颈。英特尔® Trust Authority 鉴证服务则能充分验证 TEE 的有效性,发挥英特尔® SGX/TDX 技术的优势。

如果说数据中心是一台巨型计算机,那么 CPU 就是它的超级大脑,第五代英特尔® 至强® 可扩展处理器将一如既往地扮演核心角色。它与网络、GPU、软件技术栈等其他英特尔创新技术一起共同构筑了上层 AI 应用的根基。而这样的根基虽然能力强大,但并不需要用户为此投入大量精力学习或增加运维投入。由此,企业就能将主要精力投入在业务创新中,并在 AI 浪潮中紧紧把握住市场机遇,开启新的增长路径。