2025 年 6 月 23 日,由 GMI Cloud 联合 InfoQ 举办的 “2025 AI 应用出海年中洞察暨 GMI Cloud 新品发布会” 在线上举行。InfoQ 总编辑王一鹏与 GMI Cloud 创始人 &CEO Alex、解决方案架构师 Frank、技术 VP Yujing,围绕 AI 应用出海的市场格局、技术挑战、产品创新及行业趋势展开多维对话,助力从业者精准洞察 AI 技术演进脉络与出海市场的政策 & 文化差异、竞争格局等,从而更加敏锐地把握 AI 应用出海的关键机遇点与潜在风险。

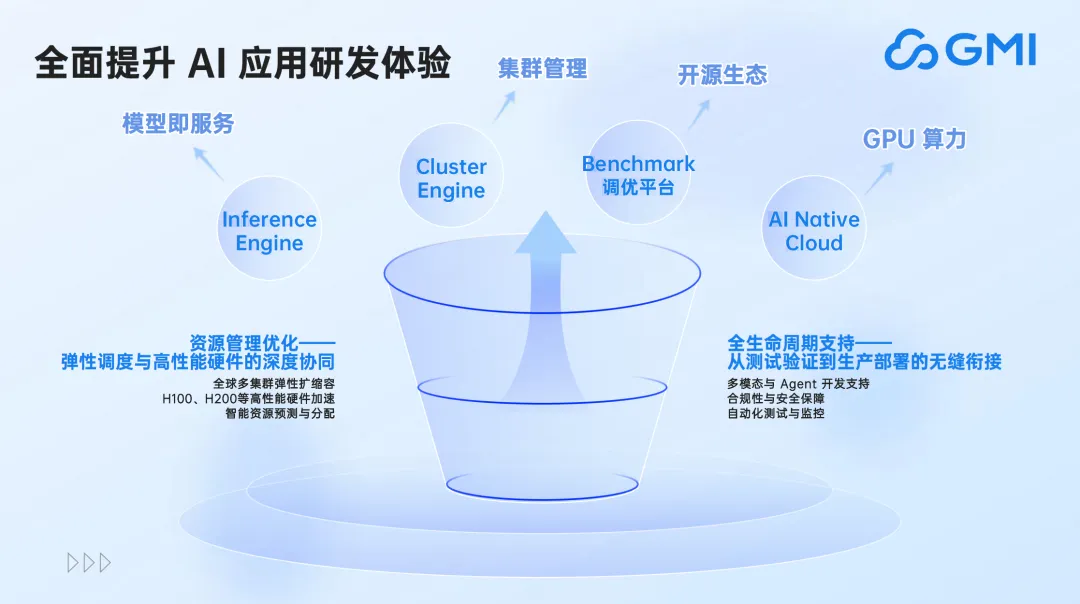

值得一提的是,GMI Cloud 也在线上发布了全新的推理引擎 Benchmark 调优平台,并展示了 GMI Cloud 的技术全景图,全面赋能 AI 应用出海。

以下为此次直播内容精要。

2025 AI 应用出海的年中趋势盘点

C 端应用爆发式增长,商业模式已被初步验证

直播开场,GMI Cloud 解决方案架构师 Frank 率先公布了一组数据:“截至 2025 年 5 月,月活超过 5 万的 AI 出海应用已突破 160 款,较去年同期实现了 5 倍的爆发式增长,仅 2025 年上半年,每月新增达标应用数量稳定在 10 - 15 款。” 这一数据不仅是 AI 技术商业化进程加速的实况呈现,也反映了当前全球市场对 AI 应用的旺盛需求。

Frank 指出,从应用类型分布来看,视图类应用占据半壁江山,成为出海先锋。视频生成、图片编辑、影像处理等工具类产品凭借直观的用户体验和高频使用场景,快速打开全球市场。语言模型应用紧随其后,占比达 45%,其中 AI Agent 类工具成为增长新引擎。教育辅助、代码生成、智能问答等垂直领域的 Agent 应用,通过解决特定场景的痛点,展现出强大的商业潜力。

商业模式层面,订阅制成为出海类 AI 应用的主流选择。Frank 表示:“当前 AI 出海应用大多采用工具化定位 + 订阅付费模式,这种模式的核心在于持续为用户创造价值 —— 要么显著提升效率,要么开辟全新的创作可能,以此驱动用户的长期付费意愿。” 在北美市场,用户对新技术的高接受度和强付费能力,使得订阅制模式得以充分验证。

区域市场差异化显著,路径选择与本土化策略尤为重要

亚太与北美市场构成了 AI 应用出海的核心战场,但两大区域呈现出截然不同的市场特性。

在亚太地区,东南亚凭借庞大的人口基数和快速增长的数字经济,成为用户获取的 “主阵地”。印度尼西亚、越南等国家的年轻用户群体对新鲜事物充满热情,推动了 AI 应用的快速普及。“可能很多不太关注出海的观众觉得东南亚的上云率比较低, 但是实际上最近几年各大国际云厂商,包括国内的云大厂,在东南亚特别是新加坡和马来都建了可用区。所以东南亚在 AI、云基础设施还是不错的,中企出海选择东南亚也有一定的便利性。”Frank 补充道。

此外,亚太地区有一个比较特别的市场——日本,“日本的用户付费意愿比较高,很多的 AI 出海企业在亚太布局的话,会首选日本。”Frank 解释道。

跟日本市场一样,北美地区以 “技术接受度高 + 付费能力强” 的双重优势,成为验证商业模式的理想之地。尽管传统观点认为北美市场准入门槛高,但在 AI 领域,中国企业凭借强大的产品迭代能力和对用户需求的敏锐洞察,成功打破壁垒。Frank 分享道:“我们服务的客户中,有很多将北美作为出海首站。这里的用户不仅愿意为创新技术买单,还能通过积极反馈推动产品快速迭代,形成良性循环。”

除了基础设施和用户习惯差异外,文化差异、地域合规性也是 AI 应用出海必须面临的挑战。针对这类问题,Fank 表示:“在服务层面,我们整合了全球合规服务商资源,为客户提供主体注册、法规咨询、税务筹划等一站式服务;在技术层面,我们通过本地化数据存储和多层安全防护等措施,来帮助客户确保数据的合规性、安全性。”

细分赛道潜力巨大,音视频生成的价值将进一步释放

在竞争激烈的 AI 应用红海之外,多个细分赛道正孕育着爆发式增长的可能,Frank 重点剖析了三大潜力领域。

首先是视频生成赛道。尽管当前的市场热度已然不低,但技术迭代仍在加速。以 “可灵 2.1 版本” 为例,其凭借高精度的画面生成能力和流畅的动态表现,已被好莱坞影视工作室用于特效制作,以及全球广告公司的创意短片生成。随着模型精度的持续提升和成本的下降,视频生成有望重塑内容生产行业。Frank 表示,像《哪吒》这样的动画电影,它的整体渲染成本大概是 3-4 亿人民币。如果去用模型去生成的话,假设生成的质量需要达到《哪吒》的百分之七八十,成本可能也就是三四十万,这将极大地降低影视制作的成本。

其次是 3D 生成赛道。与游戏、动漫、手办等领域的深度融合,为 3D 生成技术开辟了广阔的应用空间。游戏公司通过 AI 3D 生成技术,能够大幅缩短角色建模时间,提升内容更新速度;在动漫领域,AI 生成的 3D 虚拟偶像不仅形象逼真,还能通过实时交互吸引粉丝;手办 IP 行业更是借助 AI 技术,实现了从设计到生产的全流程数字化,满足了用户个性化定制的需求。

此外,昆仑万维在东南亚市场的成功实践,证明了音乐生成领域的巨大潜力。其推出的 AI 音乐生成应用,支持用户通过文字描述生成个性化音乐作品。该应用上线半年内,用户创作的歌曲中有 10 首进入了当地流行音乐排行榜前 100,引发了广泛关注。

从 AI 应用出海的市场全景不难发现,无论是 C 端应用的爆发式增长背后对算力调度的海量需求,还是区域市场差异化竞争中对本地化部署的严苛要求,亦或是更多潜力赛道技术突破所依赖的模型推理优化能力,都对底层技术架构与基础设施提出了多维度的挑战。同时也对 AI Infra 厂商提出了新的要求——技术创新不再是单一的功能迭代,而是需要与市场需求形成精准共振的系统性工程。而这也正是 GMI Cloud 技术演进的关键方向。

从算力调度到推理优化的全栈突破与工程突围

Agent 爆火带来的基础设施新挑战

2025 年,随着 MCP 协议的广泛应用,Agent 生态迎来爆发式增长。这一协议如同大模型领域的 “Type-C 接口”,通过统一标准大幅降低了 Agent 开发部署门槛。在此背景下,应用端从通用 Agent 向行业垂直 Agent 的演进,对模型后训练和推理优化提出了双重挑战 —— 既要实现跨区域算力的动态调度,又要保障复杂业务场景下的推理效率。

针对这一行业痛点,GMI Cloud 以两大产品构建解决方案:

首先是 Cluster Engine 平台。作为多云管理中枢,Cluster Engine 实现了跨区域 GPU 集群的统一纳管与智能调度。该平台支持北美、亚太、欧洲等多个地区的算力资源整合,通过动态负载均衡算法,将任务分配至最合适的算力节点。例如,在处理突发流量时,Cluster Engine 可在分钟级内完成算力扩容,确保服务不中断。

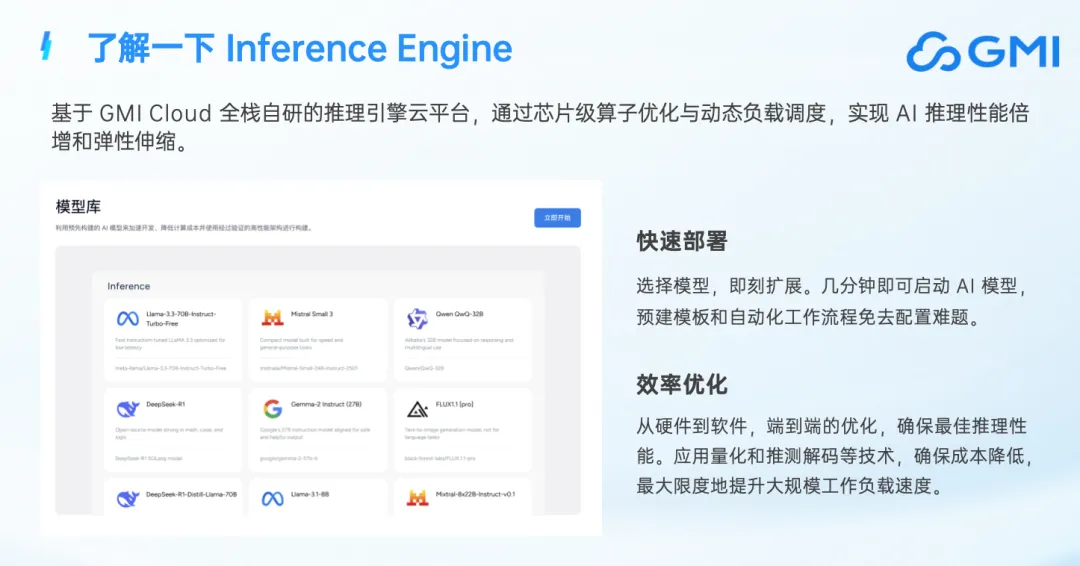

其次是 Inference Engine 平台。作为 GMI Cloud 全栈自研的推理引擎平台, Inference Engine 通过软硬件的协同优化以及全球动态负载均衡,可以实现 AI 推理性能的大幅提升以及弹性扩缩容。

GMI Cloud 技术 VP Yujing 在直播中表示, Inference Engine 核心优势主要体现在两个方面。一方面,它可以让企业以及用户进行快速部署,选择好模型后即刻扩展,几分钟之后就可以启动模型,并直接用这个模型进行 serving;另一方面,因为 GMI Cloud 拥有全栈的能力,所以对 Inference Engine 从硬件到软件进行了端到端的优化,确保其具备最佳的推理性能以及最低的成本,最大限度地帮助客户提升大规模工作时的负载速度以及带宽。

值得一提的是,近期 Inference Engine 也上线了视频功能,GMI Cloud 希望将它打造成一个集成多个开源、闭源模型的视频生成平台,也欢迎大家去体验。

Inference Engine Benchmark 调优平台发布并开源

在直播中,GMI Cloud 技术 VP Yujing 宣布 Inference Engine Benchmark 调优平台正式发布,并对其核心功能进行了重点介绍。

据介绍,Benchmark 调优平台具备三大核心亮点:

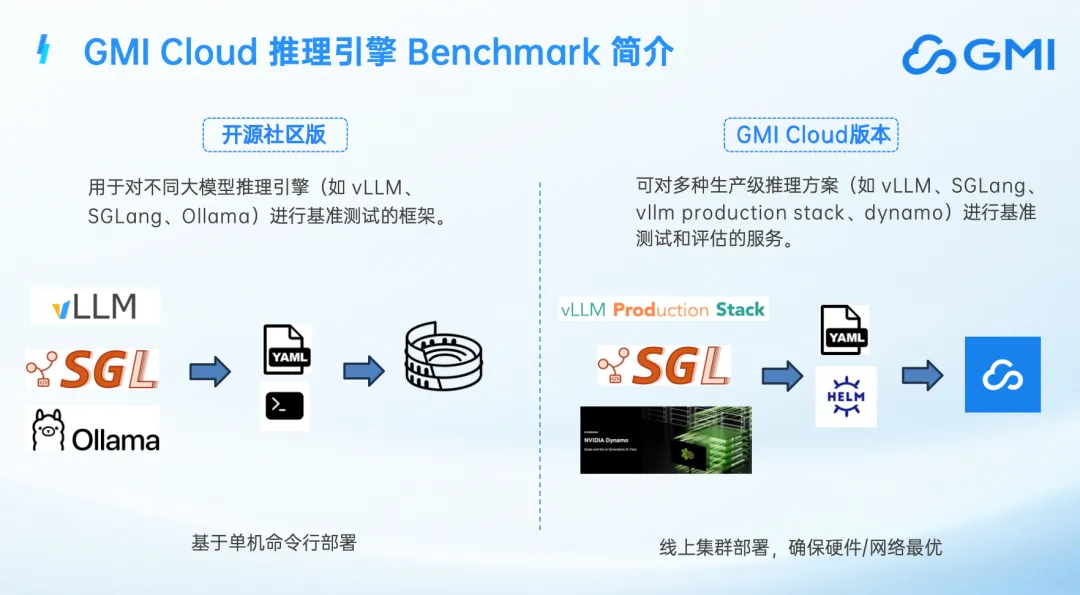

1. 双版本架构:

开源社区版:与 vllm 社区合作开发,双方充分发挥自身优势,通过技术与资源整合,面向技术爱好者和小型团队,支持 vLLM、SGLang、Ollama 等主流推理引擎的单机基准测试。用户可通过简单的命令行操作,快速测试模型性能,并与社区其他用户分享测试结果。

云版本:针对企业级用户,提供生产级推理方式的集群部署评估。平台对 vLLM 生产栈、SGLang 多节点部署、NVIDIA Dynamo 等技术进行深度优化,确保测试结果与生产环境高度一致。

2. 全流程自动化:

按需引擎管理:平台无需用户提前租用 GPU 资源,可根据测试需求动态分配算力,大幅降低企业的测试成本。

智能参数搜索:内置的 “smart-perf” 组件能够利用历史测试数据和机器学习算法,自动搜索最佳配置参数,效率提升 10 倍以上。

端到端指标采集:自动收集吞吐量、延迟、成本等关键指标,并支持 Grafana 可视化分析,帮助企业快速定位性能瓶颈。

3. 所测即所得:每个 Benchmark 测试得到的最优配置,均可在 GMI Cloud 平台一键部署,确保测试性能在生产环境中 1:1 复现。此外,平台还推出了社区版排行榜(iearena.org),鼓励开源社区共同参与推理性能优化。

针对“为什么会推出 Benchmark 调优平台”,Yujing 解释道:“在与客户的沟通中,我们发现企业在模型部署过程中常面临诸多困惑,如‘从 A100 迁移到 H100 需要多少张卡?’‘精度降低对成本有何影响?’过去,这些问题需要工程师手动测试数周甚至数月。因为我们已经积攒了大量的 know-how,所以可以把这些问题以自动化的方式解决了,也就催生出了 Benchmark 平台。”

谈及 Benchmark 调优平台接下来的技术路线,Yujing 表示接下来会重点增加多实例、多节点的支持,比如增加更多的新模型、提供更多 EP 条件下的一些 Benchmark 能力等等;另外也在计划针对不同模型推荐最佳的 QPS 区间,并基于实际调用轨迹来进行模拟;此外,Benchmark 还将增加实时 GPU 监控仪表盘、多选报告与可分享链接等功能等。目前 Benchmark 调优平台最新版本已经开源,欢迎大家访问 GMI Cloud 的官网去体验。

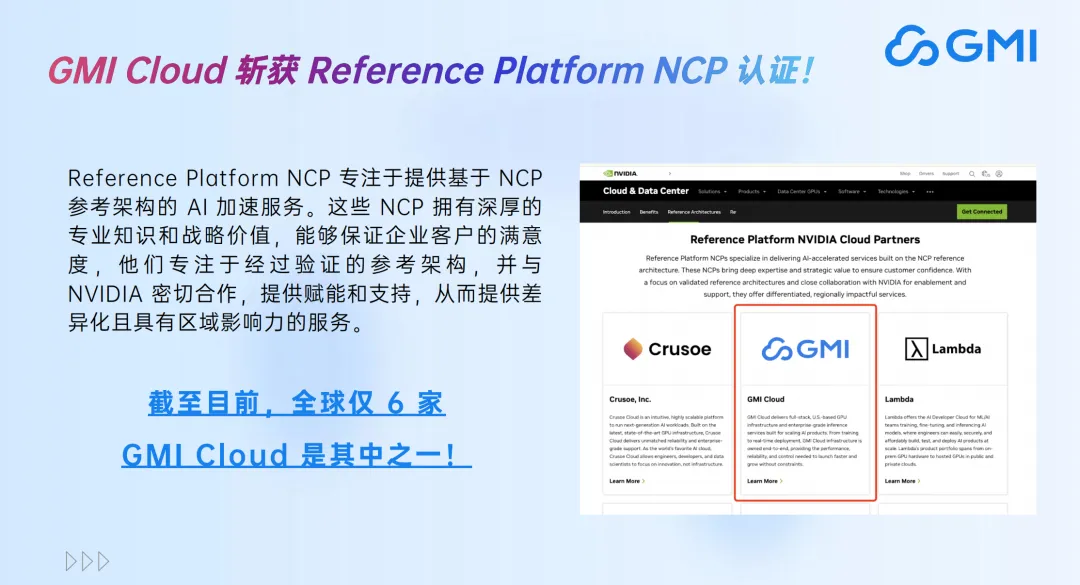

透过 Cluster Engine、Inference Engine 及其 Benchmark 调优平台的产品特性不难看出,“快速部署”、“极致优化”、“行业 know-how”、“节省成本”、“工程级复现”、“全栈能力”等等关键词,正是 GMI Cloud 系统性、工程级技术与服务能力的体现。而随着加入 NVIDIA Reference Platform Partner 阵营(全球仅 6 家, 专注于提供基于 NCP 参考架构的 AI 加速服务),将进一步加速其“帮助全球 AI 团队从算力部署到模型开发实现规模化”承诺的实现。

加速 AI 应用在全球范围内的广泛实践

作为全球仅 6 家的 NVIDIA Reference Platform Partner,GMI Cloud 在算力获取和技术合作上具有显著优势。

首先是最新 NVDIA 资源的优先获取。从 H100、H200 到 B200,再到未来的 GB300/B300,GMI Cloud 始终能第一时间获得稳定合规的 GPU 资源。这种硬件优势确保了客户能够使用最先进的算力,提升应用的竞争力。

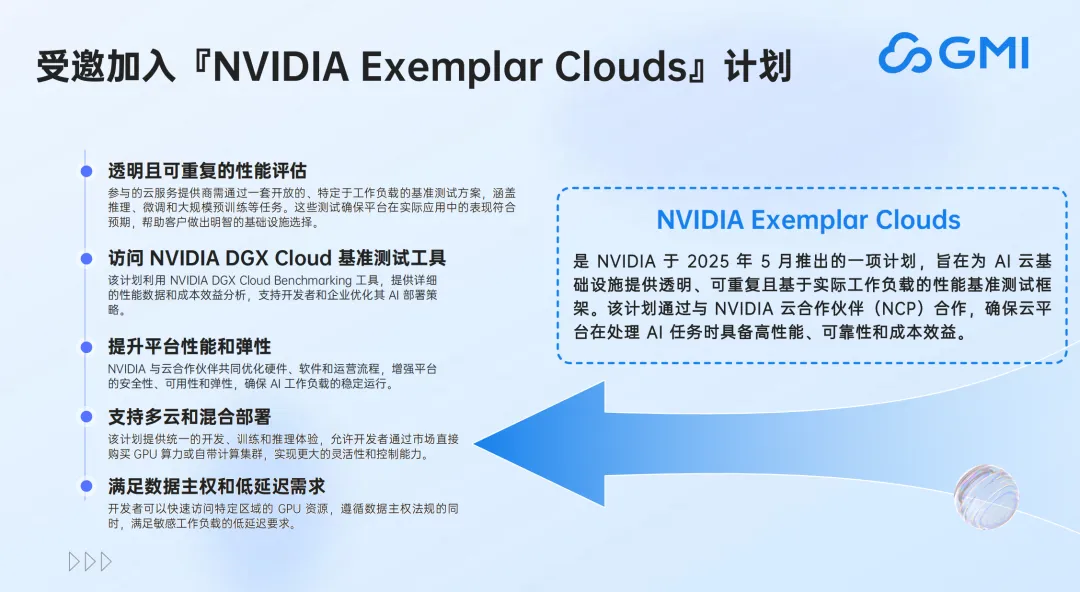

其次是与 NVDIA 建立了更深度的技术合作。“不只是 Reference Platform Partner,我们事实上也加入了 NVIDIA Exemplar Cloud 计划,我们不只是 NVIDIA 的客户,还可以跟他们一起围绕下一代产品的研发展开讨论,包含芯片的设计、未来的推理的计划,以及 GPU 服务的调用等等,目前我们每两周就会去跟 NVIDIA 的工程师做一次深度沟通。” GMI Cloud 创始人 & CEO Alex 在直播中透露。

目前 GMI Cloud 的产品服务可以总结为“一朵云 +2 个引擎”,下图为 GMI Cloud 可以提供的技术产品架构图。最底层,GMI Cloud 提供高性能 GPU、大容量存储系统以及高带宽数据通道共同构成底层的 GPU 硬件架构;再往上的 IaaS 层,GMI Cloud 提供安全、容器化、虚拟化、高速存储系统以及高性能网络等模块服务;在 MaaS 层,GMI Cloud 主要负责对多推理框架的支持、跨级群的自动扩容、推理优化、实时监控,以及模型托管等,主要是 Inference Engine 平台;而在最顶端的“应用层”,包括金融、制造、客服、自动驾驶、内容生成与创作等众多行业或场景下的 AI 应用,都可以基于 GMI Cloud 的平台服务完成构建。

“过程中我们也遇到了一些有趣的案例,有很多客户通过传统大型云厂商将大模型训练好了,打算部署到生产环境,发现太贵了,scale 到快破产了,然后跑到我们这边来。我们除了能给客户非常好的模型优化,也能给到更高的性价比,能够让客户以负担得起的方式去延展扩容他们的服务。”Alex 补充道。

这些实践案例,正是 AI 应用出海从“技术炫技”转向“工程落地”的微观缩影,也是当下行业变革的真实写照。

当前,AI 应用出海正处于技术与市场共振的关键期,从 C 端应用爆发到区域市场运营,从视频生成等细分赛道突破到算力与推理技术的全栈优化,AI 应用出海已不仅需要行业创新,更要关注基础设施的稳定性。GMI Cloud 以 GPU 集群调度优化、推理优化等众多能力构建的 AI Native Cloud 平台,不仅为企业破解了出海过程中的算力成本、本地化适配等现实难题,更通过与 NVIDIA 等生态伙伴的深度协同,推动 AI 应用的场景实践。

未来,随着技术迭代与全球市场认知的深化,AI 应用出海将从 “技术输出” 升级为 “生态共建”,而具备工程化落地能力与全球化视野的技术平台,无疑将会是这场变革的核心驱动力。