本文将介绍如何利用 TensorFlow 实现一个活体检测程序。

本文摘选自电子工业出版社出版、李金洪编著的《深度学习之TensorFlow工程化项目实战》一书的实例 54:在 iPhone 手机上识别男女并进行活体检测。

实例描述

在 iOS 上实现一个活体检测程序。

要求:在进行活体检测之前,能够识别出人物性别,并根据性别显示问候语。

本实例可以分为两部分功能:第 1 部分是性别识别,第 2 部分是活体检测。

一、搭建 iOS 开发环境

在实现功能开发之前,先通过本节的操作将 iOS 开发环境搭建起来。

下载 iOS 开发工具

Xcode 是 iOS 的集成开发工具,并且免费向大众提供。可以通过 AppStore 下载它。

在 AppStore 中搜索 Xcode,然后单击“安装”按钮,如图 1 所示。

图 1 Xcode 的安装界面

安装 CocoaPods

CocoaPods 是一个负责管理 iOS 项目中第三方开源库的工具。

CocoaPods 能让我们、统一地管理第三方开源库,从而节省设置和更新第三方开源库的时间。具体安装方法如下:

(1)安装 CocoaPods 需要用到 Ruby。虽然 Mac 系统自带 Ruby,但是需要将其更新到最新版本。更新方法是,在命令行模式下输入以下命令:

(2)更换 Ruby 的软件源。有时会因为网络原因无法访问到 Ruby 的软件源“rubygems.org”,所以需要将“rubygems.org”地址更换为更容易访问的地址,即把 Ruby 的软件源切换至 ruby-china。执行命令:

gem sources --add https://gems.ruby-china.com/gem sources --remove https://rubygems.org/

复制代码

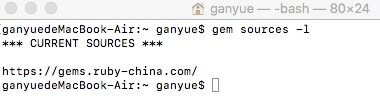

(3)检查源路径是否替换成功。执行命令:

该命令执行完后,可以看到 Ruby 的软件源已经更新,如图 2 所示。

图 2 Ruby 软件源已经更新

(4)安装 CocoaPods,执行命令:

sudo gem install cocoapods

复制代码

(5)安装本地库,执行命令:

二、部署工程代码并编译

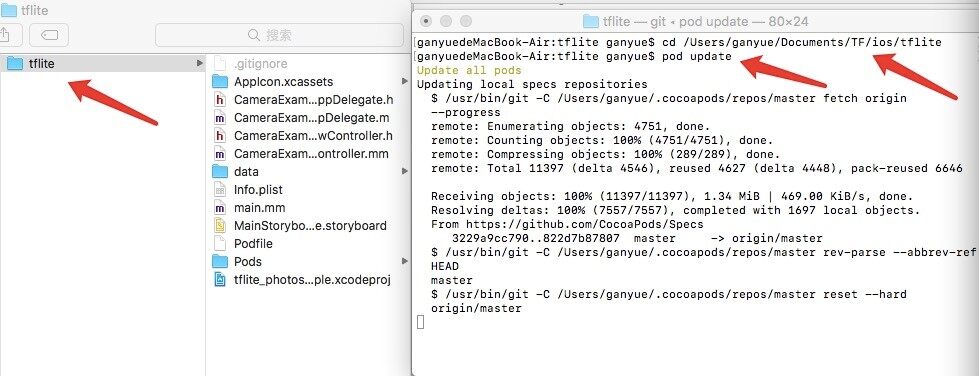

下面使用 13.3.1 小节所下载的工程代码 tensorflow-for-poets-2。导入及编译该工程中的 iOS 代码的步骤如下:

更新工程代码所需的第三方库

因为工程代码 tensorflow-for-poets-2 中隐藏了.xcworkspace 的配置,所以,在运行前需要用 CocoaPods 更新管理的第三方库。更新步骤如下:

(1)打开 Mac 操作系统的终端窗口。

(2)输入“cd”,并且按空格键。

(3)将工程目录下的文件夹拖入终端窗口,按 Enter 键。

(4)输入“pod update”指令来更新第三方库。

完整的流程如图 3 所示。

图 3 更新代码第三方库

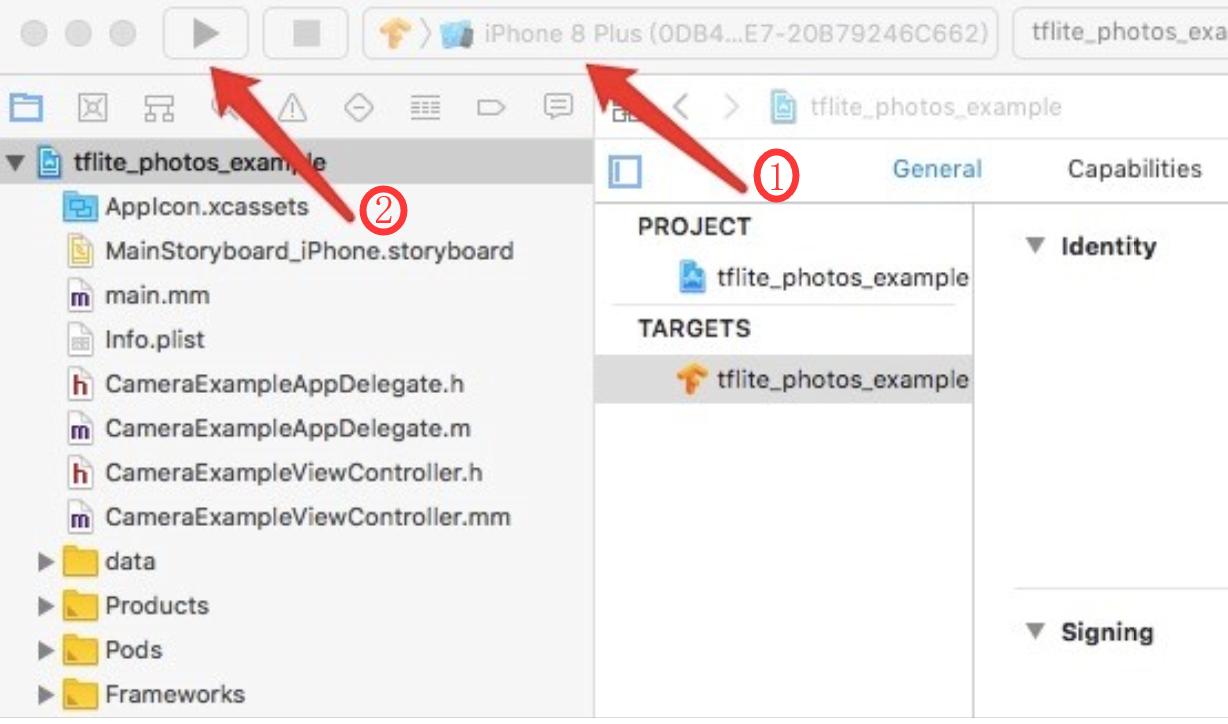

打开工程代码,并编译程序

完成更新之后,在项目目录下会生成一个.xcworkspace 文件。双击该文件打开 Xcode 工具。在 Xcode 工具中选择需要运行的模拟器(见图 4 中标注 1 部分),并单击“运行”按钮(见图 4 中标注 2 部分)在模拟器中启动应用程序,如图 4 所示。

图 4 运行 APP 程序

常见错误及解决办法

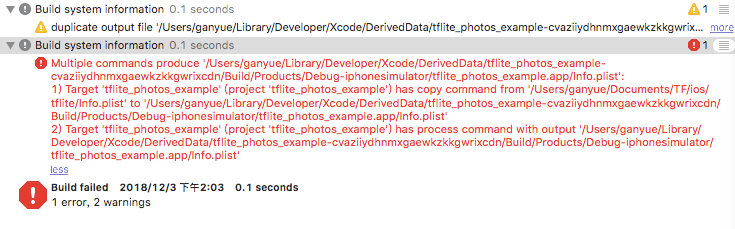

在最新的 Xcode10 中运行此工程代码会报错,如图 5 所示。

图 5 错误异常

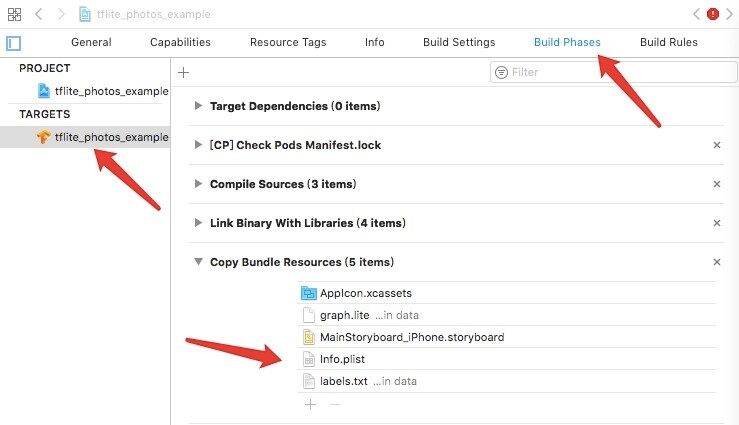

解决方法是:单击 TARGETS 下的 tflite_photos-example,然后单击 Build Phases,将 Copy Bundle Resources 下的 Info.plist 文件删掉,如图 6 所示。

图 6 解决错误方法

提示:

在打开工程项目时,需要双击的是.xcworkspace 文件,而不是.xcproject 文件。

另外,如果在运行过程中,如果因为找不到 tensorflow/contrib/lite/tools/mutable_op_ resolver.h 文件而报错,则可以使用以下方式来解决:

在代码文件“CameraExampleViewController.mm”中的开头部分,找到如下代码:

#include "tensorflow/contrib/lite/tools/mutable_op_resolver.h"

将该行代码删除即可。

三、载入 Lite 模型,实现识别男女功能

搭建好环境之后,便可以将 13.3.4 小节制作好的 lite 模型集成进来,实现识别男女功能。

将自编译模型导入工程

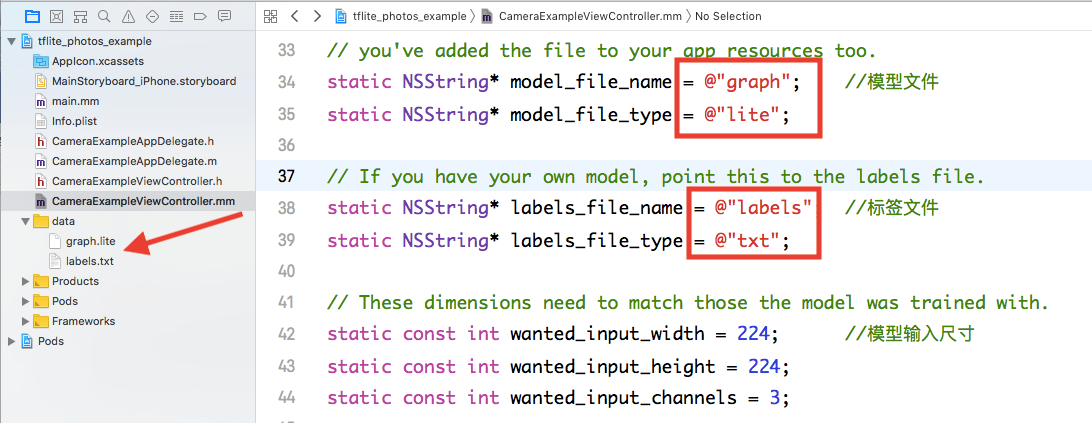

将 13.3.4 小节制作好的 lite 模型和 13.3.2 小节中生成的标签文件,拖到工程代码 tensorflow-for-poets-2-master/ios/tflite/data 目录下,并替换原有文件,如图 7 左侧的箭头部分。

图 7 替换文件

提示:

在替换过程中,需确保文件名与代码中配置的一致。在运行 App 过程中,一旦发生不一致的情况,则找不到文件,导致 App 进程崩溃。

另外,lite 模型输入尺寸应与代码中保持一致,否则影响识别率。

修改分类代码

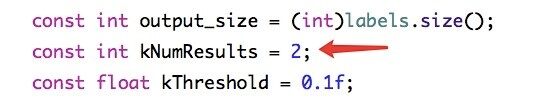

因为标签文件中只有男女两个标签(在屏幕上最多只能显示两个结果),所以将图 8 中的 kNumResults 值设为 2。

图 8 调整显示的分类个数

运行程序,查看效果

这一环节是在模拟器上实现的。事先将图片保存至模拟器相册,然后从模拟器相册中获取图片来进行人物性别识别。

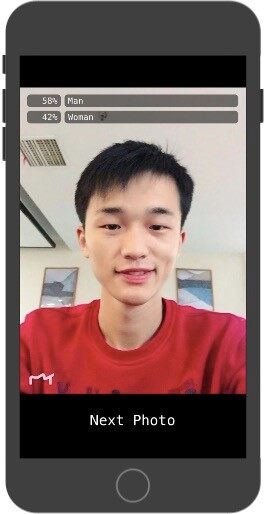

模拟器运行之后,显示的结果如图 9 所示。

图 9 在 iPhone 8 上 App 的运行结果

四、代码实现:调用摄像头并采集视频流

因为活体检测功能需要用到摄像头,所以需要在原来工程代码中添加摄像头功能。具体操作如下:

增加 GoogleMobileVision 库

活体检测主要是通过计算人脸特征点的位置变化来判断被检测人是否完成了指定的行为动作。该功能是借助谷歌训练好的人脸特征 API 来实现的。该 API 为 GoogleMobileVision。将其引入到工程中的操作如下:

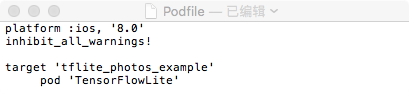

(1)双击打开工程代码 tensorflow-for-poets-2-master/ios/tflite 下的 Podfile,如图 10 所示。

图 10 Podfile 文件

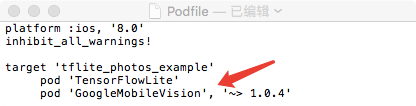

(2)增加“pod ꞌGoogleMobileVisionꞌ”,如图 11 所示。

图 11 增加 GoogleMobileVision 后的 Podfile 文件

(3)按照 13.4.2 小节的“1. 更新工程代码所需的第三方库”中的内容更新第三方库。

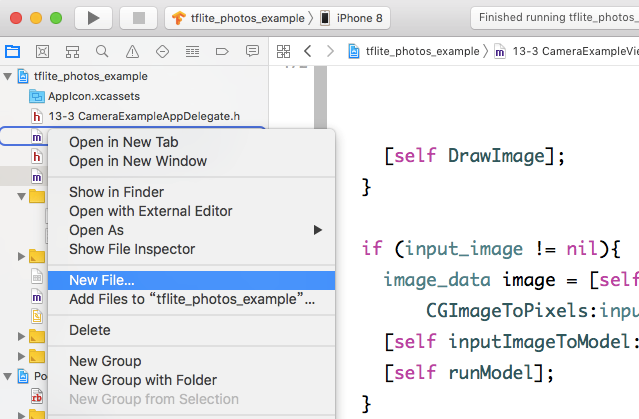

自定义相机

(1)进入工程中,在左侧工程目录下右击文件,在弹出的菜单中选择“New File”命令,如图 12 所示。

图 12 新建文件

(2)弹出如图 13 所示界面,在其中选择需要创建的平台。这里选择 iOS,然后选择 Source 下的 Cocoa Touch Class。

(3)进入 Choose options for your new file 界面,在“Class:”文本框中输入要创建文件的名字,在“Subclass of:”文本框中输入继承的父类名称,在“Language:”文本框中选择 Objective-C,如图 14 所示。

(4)在创建的代码文件“13-3 CameraExampleViewController.mm”中声明自定义相机变量。具体代码如下:

代码 1 CameraExampleViewController

//AVCaptureSession对象来执行输入设备和输出设备之间的数据传递@property(nonatomic,strong)AVCaptureSession *session;//视频输出流@property(nonatomic,strong)AVCaptureVideoDataOutput *videoDataOutput;//预览图层@property(nonatomic,strong)AVCaptureVideoPreviewLayer *previewLayer;//显示方向@property(nonatomic,assign)UIDeviceOrientation lastDeviceOrientation;

复制代码

(5)添加自定义相机的初始化变量。具体代码如下:

代码 1 CameraExampleViewController(续)

self.session = [[AVCaptureSession alloc] init];//设置session显示分辨率self.session.sessionPreset = AVCaptureSessionPresetMedium;[self.session beginConfiguration];NSArray *oldInputs = [self.session inputs];//移除AVCaptureSession对象中原有的输入设备for (AVCaptureInput *oldInput in oldInputs) { [self.session removeInput:oldInput];}//设置摄像头方向AVCaptureDevicePosition desiredPosition =AVCaptureDevicePositionFront;AVCaptureDeviceInput *input = [self cameraForPosition:desiredPosition];//添加输入设备if (!input) { for (AVCaptureInput *oldInput in oldInputs) { [self.session addInput:oldInput]; }} else { [self.session addInput:input];}[self.session commitConfiguration];self.videoDataOutput = [[AVCaptureVideoDataOutput alloc] init];//设置像素输出格式NSDictionary *rgbOutputSettings = @{ (__bridge NSString*)kCVPixelBufferPixelFormatTypeKey: @(kCVPixelFormatType_32BGRA) };[self.videoDataOutput setVideoSettings:rgbOutputSettings];[self.videoDataOutput setAlwaysDiscardsLateVideoFrames:YES];self.videoDataOutputQueue= dispatch_queue_create("VideoDataOutputQueue",DISPATCH_QUEUE_SERIAL);[self.videoDataOutput setSampleBufferDelegate:self queue:self.videoDataOutputQueue];//添加输出设备[self.session addOutput:self.videoDataOutput]; //相机拍摄预览图层self.previewLayer = [[AVCaptureVideoPreviewLayer alloc] initWithSession:self.session];[self.previewLayer setBackgroundColor:[[UIColor clearColor] CGColor]];[self.previewLayer setVideoGravity:AVLayerVideoGravityResizeAspectFill];self.overlayView = [[UIView alloc]initWithFrame:self.view.bounds];self.overlayView.backgroundColor = [UIColor darkGrayColor];[self.view addSubview:self.overlayView];CALayer *overlayViewLayer = [self.overlayView layer];[overlayViewLayer setMasksToBounds:YES];[self.previewLayer setFrame:[overlayViewLayer bounds]];[overlayViewLayer addSublayer:self.previewLayer];

复制代码

(6)添加自定义相机的代理方法。具体代码如下:

代码 1 CameraExampleViewController(续)

#pragma mark - AVCaptureVideoDataOutputSampleBufferDelegate-(void)captureOutput:(AVCaptureOutput*)captureOutput didOutputSampleBuffer:(CMSampleBufferRef)sampleBuffer fromConnection:(AVCaptureConnection *)connection{//将CMSampleBuffer转换为UIImageUIImage *image = [GMVUtility sampleBufferTo32RGBA:sampleBuffer];}

复制代码

在上面代码中,用 AVCaptureVideoDataOutputSampleBufferDelegate 代理方法获取实时的 image。在获取到 image 之后,将其分为两个分支:一个用于识别男女性别,另一个用于活体检测。

五、代码实现:提取人脸特征

本小节用 GoogleMobileVision 接口获取人脸关键点,进行人脸特征提取。

创建人脸检测器

在代码文件“13-3 CameraExampleViewController.mm”的初始化方法中创建人脸检测器。具体代码如下:

代码 1 CameraExampleViewController(续)

60 //配置检测器61 NSDictionary *options = @{62 GMVDetectorFaceMinSize : @(0.1),63 GMVDetectorFaceTrackingEnabled : @(YES),64 GMVDetectorFaceLandmarkType : @(GMVDetectorFaceLandmarkAll),65 GMVDetectorFaceClassificationType : @(GMVDetectorFaceClassificationAll),66 GMVDetectorFaceMode : @(GMVDetectorFaceFastMode)67 };68 //创建并返回已配置的检测器69 self.faceDetector = [GMVDetector detectorOfType:GMVDetectorTypeFace options:options];

复制代码

获取人脸

在代码文件“CameraExampleViewController.mm”的相机代理方法中,调用 GoogleMobileVision 框架的 GMVDetector 检测功能,获取屏幕上所有的人脸。具体代码如下:

代码 1 CameraExampleViewController(续)

70 UIImage *image = [GMVUtility sampleBufferTo32RGBA:sampleBuffer];71 //建立图像方向72 UIDeviceOrientation deviceOrientation = [[UIDevicecurrentDevice] orientation];73 GMVImageOrientation orientation = [GMVUtility imageOrientationFromOrientation:deviceOrientation withCaptureDevicePosition:AVCaptureDevicePositionFront defaultDeviceOrientation:self.lastKnownDeviceOrientation];74 //定义图像显示方向,用于指定面部特征检测75 NSDictionary *options = @{GMVDetectorImageOrientation : @(orientation)};76 //使用GMVDetector检测功能77 NSArray<GMVFaceFeature*>*faces = [self.faceDetector featuresInImage:image options:options];78 CMFormatDescriptionRef fdesc = CMSampleBufferGetFormatDescription(sampleBuffer);79 CGRect clap = CMVideoFormatDescriptionGetCleanAperture(fdesc, false);80 //计算比例因子和偏移量以正确显示特征81 CGSize parentFrameSize = self.previewLayer.frame.size;82 CGFloat cameraRatio = clap.size.height / clap.size.width;83 CGFloat viewRatio = parentFrameSize.width / parentFrameSize.height;84 CGFloat xScale = 1;85 CGFloat yScale = 1;86 CGRect videoBox = CGRectZero;87 //判断视频预览尺寸与相机捕获视频帧尺寸88 if (viewRatio > cameraRatio) {89 videoBox.size.width = parentFrameSize.height * clap.size.width / clap.size.height;90 videoBox.size.height = parentFrameSize.height;91 videoBox.origin.x = (parentFrameSize.width-videoBox.size.width) / 2;92 videoBox.origin.y =(videoBox.size.height-parentFrameSize.height) / 2;93 xScale = videoBox.size.width / clap.size.width;94 yScale = videoBox.size.height / clap.size.height;95 } else {96 videoBox.size.width = parentFrameSize.width;97 videoBox.size.height = clap.size.width * (parentFrameSize.width / clap.size.height);98 videoBox.origin.x = (videoBox.size.width-parentFrameSize.width) / 2;99 videoBox.origin.y =(parentFrameSize.height-videoBox.size.height) / 2;100 xScale = videoBox.size.width / clap.size.height;101 yScale = videoBox.size.height / clap.size.width;102 }103 dispatch_sync(dispatch_get_main_queue(), ^{104 //移除之前添加的功能视图105 for (UIView *featureView in self.overlayView.subviews) {106 [featureView removeFromSuperview];107 }108 for (GMVFaceFeature *face in faces) {109 //所有的face110 ......111 }

复制代码

六、活体检测算法介绍

通过获取人脸的 GMVFaceFeature 对象可以得到五官参数,从而实现微笑检测、向左转、向右转、抬头、低头、张嘴等功能。

代码第 77 行,会返回一个 GMVFaceFeature 对象。该对象包含人脸的具体信息。其中所包括的字段及含义如下。

smilingProbability:用于检测微笑,该字段是 CGFloat 类型,取值范围为 0~1。微笑尺度越大,则 smilingProbability 字段越大。

noseBasePosition:检测图像在视图坐标系中的鼻子坐标。

leftCheekPosition:检测图像在视图坐标系中的左脸颊坐标。

rightCheekPosition:检测图像在视图坐标系中的右脸颊脸颊坐标。

mouthPosition:检测图像在视图坐标系中的嘴角坐标。

bottomMouthPosition:检测图像在视图坐标系中的下唇中心坐标。

leftEyePosition:检测图像在视图坐标系中的左眼坐标。

在活体检测的行为算法中,只有微笑行为可以直接用 smilingProbability 进行判断。其他的行为需要多个字段联合判断,具体代码如下。

左转、右转:通过 noseBasePosition、leftCheekPosition、rightCheekPosition 三点之间的间距进行判断。

抬头:通过 noseBasePosition、leftEyePosition 两点之间的间距进行判断。

低头:通过 noseBasePosition、rightCheekPosition 两点之间的间距进行判断。

张嘴:通过 mouthPosition、bottomMouthPosition 两点之间的间距进行判断。

七、代码实现:实现活体检测算法

在了解原理之后,就可以编写代码实现人脸检测算法。具体如下:

识别左转、右转行为

左转、右转的识别行为算法是通过鼻子与左、右脸颊 x 坐标的间距之差来判断的。如果左边间距比右边间距大 20 以上,即为左转;反之则为右转。具体代码如下:

代码 1 CameraExampleViewController(续)

112 //鼻子的坐标113 CGPoint nosePoint = [weakSelf scaledPoint:face.noseBasePosition xScale:xScale yScale:yScale offset:videoBox.origin];114 //左脸颊的坐标115 CGPoint leftCheekPoint = [weakSelf scaledPoint:face.leftCheekPosition xScale:xScale yScale:yScale offset:videoBox.origin];116 //右脸颊的坐标117 CGPoint rightCheekPoint = [weakSelf scaledPoint:face.rightCheekPosition xScale:xScale yScale:yScale offset:videoBox.origin];118 //鼻子与右脸颊之间的距离119 CGFloat leftRightFloat1 = rightCheekPoint.x - nosePoint.x;120 //鼻子与左脸颊之间的距离121 CGFloat leftRightFloat2 = nosePoint.x - leftCheekPoint.x;122 if (leftRightFloat2 - leftRightFloat1 > 20) {123 //左转124 }else if (leftRightFloat1 – leftRightFloat2 > 20) {125 //右转126 }else{127 //没有转动,或者转动幅度小128 }

复制代码

识别抬头、低头行为

通过计算鼻子和左眼的 y 坐标之差是否小于 24,来判断是否为抬头的行为。如果鼻子与右脸颊的 y 坐标之差大于 0,则为低头行为。具体代码如下:

代码 1 CameraExampleViewController(续)

129 //鼻子的坐标130 CGPoint nosePoint = [weakSelf scaledPoint:face.noseBasePosition xScale:xScale yScale:yScale offset:videoBox.origin];131 //左眼的坐标132 CGPoint leftEyePoint = [weakSelf scaledPoint:face.leftEyePosition xScale:xScale yScale:yScale offset:videoBox.origin];133 //右脸颊的坐标134 CGPoint rightCheekPoint = [weakSelf scaledPoint:face.rightCheekPosition xScale:xScale yScale:yScale offset:videoBox.origin];135 if(nosePoint.y - leftEyePoint.y < 24){136 //抬头137 }else if(nosePoint.y - rightCheekPoint.y > 0){138 //低头139 }

复制代码

识别张嘴行为

通过计算上唇中心 y 坐标与下唇中心 y 坐标之差是否大于 18,来判定是否为张嘴的行为。具体代码如下:

代码 1 CameraExampleViewController(续)

140 //下唇中心的坐标141 CGPoint bottomMouthPoint = [weakSelf scaledPoint:face.bottomMouthPosition xScale:xScale yScale:yScale offset:videoBox.origin];142 //上唇中心的坐标143 CGPoint mouthPoint = [weakSelf scaledPoint:face.mouthPosition xScale:xScale yScale:yScale offset:videoBox.origin];144 if(bottomMouthPoint.y – mouthPoint.y > 18){145 //张嘴146 ……147 }4. 识别微笑行为微笑行为可直接通过face.smilingProbability属性判断出来。具体代码如下:代码1 CameraExampleViewController(续)148 //微笑判断, 0.3是经过验证后的经验值149 if (face.smilingProbability > 0.3) {150 //微笑151 ……152 }

复制代码

八、代码实现:完成整体功能并运行程序

将男女识别算法与所有的活体检测算法结合起来,完成完整流程。并在其中添加问候语。具体代码如下:

实现完整流程

代码 1 CameraExampleViewController(续)

153 for (GMVFaceFeature *face in faces) {154 CGRect faceRect = [weakSelf scaledRect:face.bounds xScale:xScale yScale:yScale offset:videoBox.origin];155 //判断是否在指定的尺寸里156 if (CGRectContainsRect(weakSelf.bgView.frame, faceRect)) {157 //如果index为1,则表示微笑行为158 if(index == 1){159 if(face.smilingProbability > 0.3){160 }161 //如果index为2,则表示左转、右转行为162 }else if(index == 2){163 //鼻子的坐标164 CGPoint nosePoint = [weakSelf scaledPoint:face.noseBasePosition xScale:xScale yScale:yScale offset:videoBox.origin];165 //左脸颊的坐标166 CGPoint leftCheekPoint = [weakSelf scaledPoint:face.leftCheekPosition xScale:xScale yScale:yScale offset:videoBox.origin];167 //右脸颊的坐标168 CGPoint rightCheekPoint = [weakSelf scaledPoint:face.rightCheekPosition xScale:xScale yScale:yScale offset:videoBox.origin];169 //鼻子与右脸颊之间的距离170 CGFloat leftRightFloat1 = rightCheekPoint.x - nosePoint.x;171 //鼻子与左脸颊之间的距离172 CGFloat leftRightFloat2 = nosePoint.x - leftCheekPoint.x;173 if (leftRightFloat2 - leftRightFloat1 > 20) {174 //左转175 }else if (leftRightFloat1 – leftRightFloat2 > 20) {176 //右转177 }178 //如果index为3,则表示张嘴行为179 }else if(index == 3){180 //下唇中心的坐标181 CGPoint bottomMouthPoint = [weakSelf scaledPoint:face. bottomMouthPosition xScale:xScale yScale:yScale offset:videoBox.origin];182 //上唇中心的坐标183 CGPoint mouthPoint = [weakSelf scaledPoint:face.mouthPosition xScale:xScale yScale:yScale offset:videoBox.origin];184 if(bottomMouthPoint.y – mouthPoint.y > 18){185 //张嘴186 }187 //如果index为4,则表示抬头、低头行为188 }else if(index == 4){189 //鼻子的坐标190 CGPoint nosePoint = [weakSelf scaledPoint:face.noseBasePosition xScale:xScale yScale:yScale offset:videoBox.origin];191 //左眼的坐标192 CGPoint leftEyePoint = [weakSelf scaledPoint:face.leftEyePosition xScale:xScale yScale:yScale offset:videoBox.origin];193 //右脸颊的坐标194 CGPoint rightCheekPoint = [weakSelf scaledPoint:face.rightCheekPosition xScale:xScale yScale:yScale offset:videoBox.origin];195 if(nosePoint.y - leftEyePoint.y < 24){196 //抬头197 }else if(nosePoint.y - rightCheekPoint.y > 0){198 //低头199 }200 }201 }202 }

复制代码

添加问候语

在代码文件 CameraExampleViewController.mm 中添加下列代码,实现问候语的显示功能。具体代码如下:

代码 1 CameraExampleViewController(续)

203 //遍历获取到的所有结果204 for (const auto& item : newValues) {205 std::string label = item.second;206 const float value = item.first;207 if (value > 0.5) {208 NSString *nsLabel = [NSString stringWithCString:label.c_str() encoding:[NSString defaultCStringEncoding]];209 NSString *textString;210 if ([nsLabel isEqualToString:@"man"]) {211 textString = @"先生你好";212 }else{213 textString = @"女士你好";214 }215 }216 //创建UILaebl显示对应的问候语217 ......218 }

复制代码

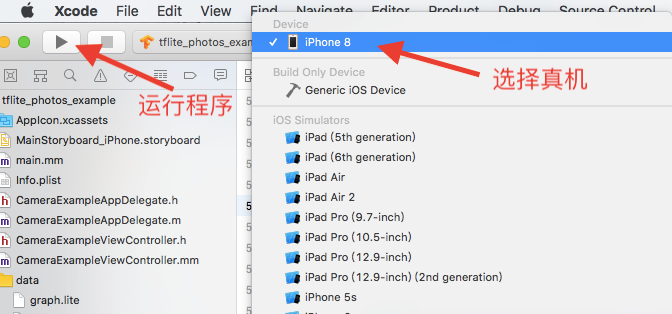

运行程序并显示效果

将苹果手机通过 USB 接口连接到电脑上。先选择真机,然后单击“运行”按钮进行程序同步,如图 15 所示。

图 15 选择真机调试

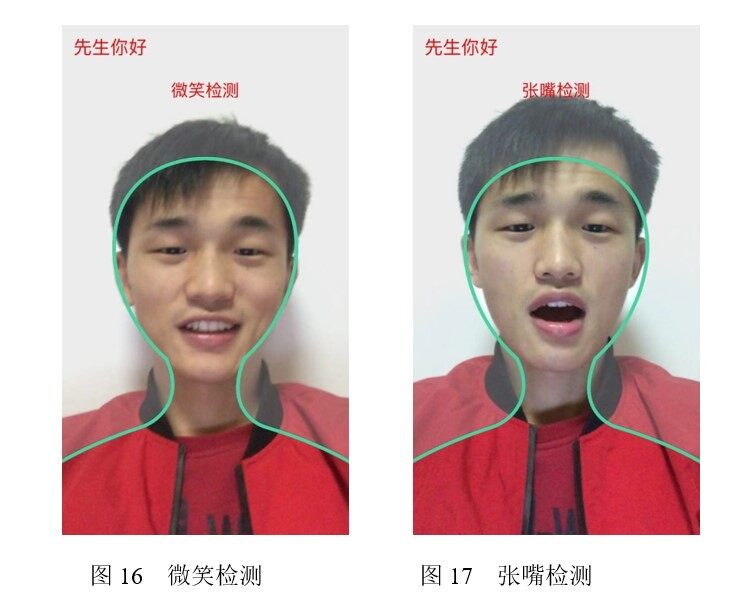

在手机上打开 App 即可运行程序。当手机屏幕显示绿色边框时,表示正在检测。手机屏幕离人脸 50cm 为最佳距离。以检测微笑、张嘴的行为为例,程序运行结果如图 16、图 17 所示。

图 16 表示程序识别出微笑行为,图 17 表示程序识别出张嘴行为。

提示:

在 iOS 9 之后的操作系统中,使用相机功能需要在项目 Info.plist 文件中增加了“Privacy - Camera Usage Description”权限提示,否则会报出异常。

本文摘选自电子工业出版社出版、李金洪编著的《深度学习之 TensorFlow 工程化项目实战》一书,更多实战内容点此查看。

本文经授权发布,转载请联系电子工业出版社。

系列文章:

TensorFlow 工程实战(一):用 TF-Hub 库微调模型评估人物年龄

TensorFlow 工程实战(二):用 tf.layers API 在动态图上识别手写数字

TensorFlow 工程实战(三):结合知识图谱实现电影推荐系统

TensorFlow 工程实战(四):使用带注意力机制的模型分析评论者是否满意

TensorFlow 工程实战(五):构建 DeblurGAN 模型,将模糊相片变清晰

TensorFlow 工程实战(六):在 iPhone 手机上识别男女并进行活体检测(本文)

评论