论文名称:A Multi-task Learning Approach for Improving Product Title Compression with User Search Log Data(一种利用用户搜索日志进行多任务学习的商品标题压缩方法)

团队:iDST-NLP

作者:王金刚,田俊峰 (华东师大),裘龙 (Onehome),李生,郎君,司罗,兰曼 (华东师大)

摘要

在淘宝、天猫等电商平台,商家为了搜索引擎优化 (SEO),撰写的商品标题通常比较冗余,尤其是在 APP 端等展示空间有限的场景下,过长的商品标题往往不能完全显示,只能进行截断处理,严重影响用户体验。如何将原始商品标题压缩到限定长度内,而不影响整体成交是一个极具挑战的任务。以往的标题摘要方法往往需要大量的人工预处理,成本较高,并且未考虑电商场景下对点击率、转化率等指标的特殊需求。基于此,我们提出一种利用用户搜索日志进行多任务学习的商品标题压缩方法。该方法同时进行两个 Sequence-to-Sequence 学习任务:主任务基于 Pointer Network 模型实现从原始标题到短标题的抽取式摘要生成,辅任务基于带有注意力机制的 encoder-decoder 模型实现从原始标题生成对应商品的用户搜索 query。两个任务之间共享编码网络参数,并对两者的对原始标题的注意力分布进行联合优化,使得两个任务对于原始标题中重要信息的关注尽可能一致。离线人工评测和在线实验证明通过多任务学习方法生成的商品短标题既保留了原始商品标题中的核心信息又能透出用户搜索 query 信息,保证成交转化不受影响。

研究背景

商品标题是卖家和买家在电商平台沟通的重要媒介,用户在搜索入口输入 Query 检索,在搜索结果页 (SRP) 浏览商品列表,选择目标商品,最终完成购买。在整条购物成交链路中,商品标题、商品描述、商品图片等各种信息共同影响着用户的购买决策,信息量丰富而不冗长的标题能大大提升终端用户体验。

根据第 40 次《中国互联网络发展状况统计报告》显示,截止 2017 年 6 月,我国手机网民规模已经达到 7.24 亿,网民使用手机上网的比例由 2016 年底的 95.1% 提升至 96.3%。越来越多的在线购买行为已经从 PC 端转移到无线端 (APP),并且两者之间的差距还在进一步扩大,因此各大电商平台的资源也在往各自 APP 端倾斜。PC 和 APP 最明显的区别在于显示屏幕尺寸,通常智能手机显示屏在 4.5 到 5.5 寸之间,远小于 PC 的屏幕尺寸,对算法和产品设计都有新的要求。

当前淘系商品标题主要由商家负责撰写,为了提高搜索召回和促进成交,商家往往会在标题中堆砌大量冗余词,当用户在手机端进行浏览的时候,过长的商品标题由于屏幕尺寸限制显示不全,只能做截断处理,严重影响用户体验。如图 1 所示,在 SRP 页,商品原始标题显示不完整,只能显示 14 个字左右的短标题,用户如果想获取完整标题,还需要进一步点击进入商品详情页,商品原始标题包含近 30 个字。此外,在个性化推送和推荐场景中,商品短标题作为信息主体,对长度也有一定限制,如何使用尽可能短的文本体现商品的核心属性,引起用户的点击和浏览兴趣,提高转化率,是值得深入研究的问题。

图 1. 用户搜索「碎花裙长袖女」,搜索结果页商品原始标题过长无法完整显示,只有点击进入详情页才能看到完整标题。

已有方法介绍

文本摘要(压缩)是自然语言处理中重要研究方向之一。按摘要的生成方式,可以分为抽取式和生成式两种。顾名思义,抽取式方法生成的摘要句子和词均从原文中抽取,而生成式方法更为灵活,摘要中的句子和词并不要求一定从原文中抽取。传统的抽取式摘要方法大致可以分为贪心方法、基于图的方法和基于约束的优化方法等。近年来神经网络的方法也被应用到文本摘要领域并取得显著进步,尤其是生成式摘要方法。业界已有方法都是以压缩文章长度为优化目标实现文本的摘要,电商场景下除了文本压缩率还有其他考量,如何在商品标题长度精简的同时又不影响整体的成交转化率成为一个业界难题。

方法介绍

如图 2 所示,本文提出的多任务学习方法包含两个 Sequence to Sequence 任务,主任务是商品标题压缩,由商品原始标题生成短标题,采用 Pointer Network 模型,通过 attention 机制选取原始标题的关键字输出;辅助任务是搜索 query 生成,由商品原始标题生成搜索 query,采用带 attention 机制的 encoder-decoder 模型。两个任务共享编码网络参数,并对两者的对原始标题的注意力分布进行联合优化,使得两个任务对于原始标题中重要信息的关注尽可能一致。辅助任务的引入可以帮助主任务更好地从原始标题中保留更有信息量、更容易吸引用户点击的词。相应地,我们为两个任务构建训练数据,主任务使用的数据为女装类目下的商品原始标题和手淘推荐频道达人改写的商品短标题,辅助任务使用的数据为女装类目下的商品原始标题和对应的引导成交的用户搜索 query。

图 2. 多任务学习框架, 两个 Seq2Seq 任务共享同一个 encoder

主要贡献

- 本文的多任务学习方法进行商品标题压缩,生成的商品短标题在离线自动评测、人工评测以及在线评测中均超过传统抽取式摘要方法。

- 端到端的训练方式避免了传统方法的大量人工预处理以及特征工程。

- 多任务学习中的 Attention 分布一致性设置使得最终生成的商品短标题中能透出原始标题中重要的词,尤其是能引导成交的核心词,对于其他电商场景也有重要意义。

实验结果

我们使用了淘宝女装类目下的商品标题数据进行了实验,对比了五种不同的文本摘要方法。第一种是 baseline 方法,根据目标长度直接截断方法(Trunc.);第二种是经典的整数线性规划方法(ILP),需要对标题进行分词、NER、Term Weighting 等预处理;第三种是基于 Pointer Network 实验的 encoder-decoder 抽取式方法(Ptr-Net);第四种是多任务学习方法,直接将两个子任务的损失函数相加作为整体损失函数进行优化(Vanilla-MTL);第五种是本文提出的考虑 Attention 分布一致性的多任务学习方法(Agree-MTL)。

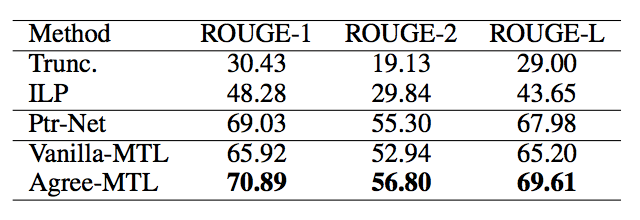

不同方法的自动评价对比

表 1. 不同文本摘要方法产生的商品短标题自动评测结果

通过计算生成的短标题和参考短标题之间的三种ROUGE 分作为自动评测结果,表1 对比了不同的文本摘要方法。本文提出的多任务学习方法显著超过了其他几种方法。

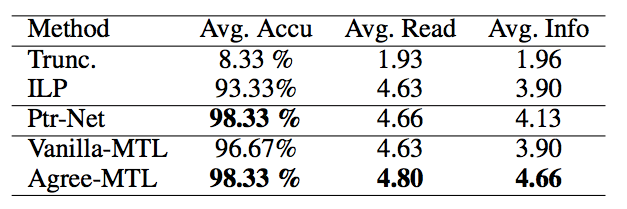

不同方法的人工评价对比

表2. 不同方法产生的商品短标题的人工评测结果

表2 展示了不同方法产生的商品短标题人工评测对比。由于电商场景下商品的核心产品词比较敏感,所以在常见的可读性(Readability) 和信息完整性(Informativeness) 指标以外,我们还比较了不同方法产生的短标题中核心产品词是否准确(Accuracy)。从表2 结果看,本文提出的方法在三个指标上均超过其他方法。

除了离线的自动评测和人工评测,我们还在真实线上环境中进行了AB 测试,相比线上原来的ILP 压缩方法,本文提出的多任务学习方法在CTR 和CVR 两个指标上分别有2.58% 和1.32% 的提升。

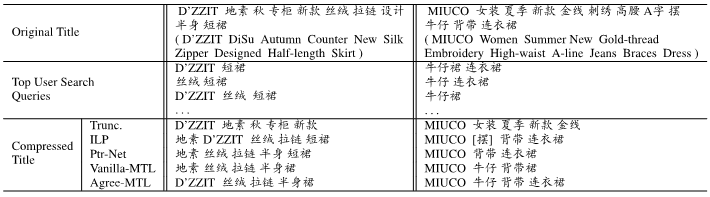

图3 给出了不同方法产生的商品短标题示例。受预处理结果影响,直接截断和ILP 两种baseline 方法生成的短标题流畅度和可读性较差,而Ptr-Net 和多任务学习属于Sequence-to-Sequence 方法,生成的短标题在可读性上优于两种baseline。图3 左侧例子说明,本文方法生成的短标题会透出用户高频搜索query 中出现过的词(用户搜索query 中多使用英文品牌名而非中文品牌名),更容易促进成交。

图3. 不同方法产生的短标题示例

总结

由于商家SEO 过度,C2C 电商平台的商品标题通常长度过长且比较冗余且,无法在APP 端完整展示。为了解决这个问题,本文使用抽取式摘要方法对过长的商品标题进行压缩。(前面这句在前面好像没有提) 传统的摘要方法仅在保持原标题语义的情况下实现标题的压缩,未考虑电商场景下对压缩后商品点击率和成交转化率的影响。电商平台累积了大量用户搜索query 和商品成交信息,利用这部分数据我们可以更有针对性地对原始长标题进行压缩。因此,我们提出一种多任务学习的标题压缩方法,包含两个序列学习子任务: 其中主任务是基于Pointer Network 模型实现的从原始标题到短标题的抽取式摘要生成,辅任务是基于带有Attention 机制的encoder-decoder 模型实现的从原始标题生成对应商品的用户搜索query,两个任务之间共享编码参数,使得两个子任务在原始标题上的Attention 分布尽可能一致,对两者的注意力分布进行联合优化,进行联合优化,最终使得主任务生成的短标题在保留原始商品标题中的核心信息的同时,更倾向于透出能促进成交转化的关键词。

离线人工评测和在线实验证明使用本文方法在保证不影响成交转化率的前提下,生成的短标题在可读性、信息完整度、核心产品词准确率上都超过了传统摘要方法。

阅读论文原文: https://arxiv.org/abs/1801.01725

如果您也有论文被AAAI录用或者对论文编译整理工作感兴趣,欢迎关注AI前线(ai-front),在后台留下联系方式,我们将与您联系,并进行更多交流!