整理 | 华卫、核子可乐、冬梅

昨日 Anthropic 的首届开发者大会上,Anthropic CEO Dario Amodei 正式发布了 Claude 4 。该系列模型下共有两个型号:Claude Opus 4 和 Claude Sonnet 4,为编码、高级推理和 AI 代理设定新的标准。

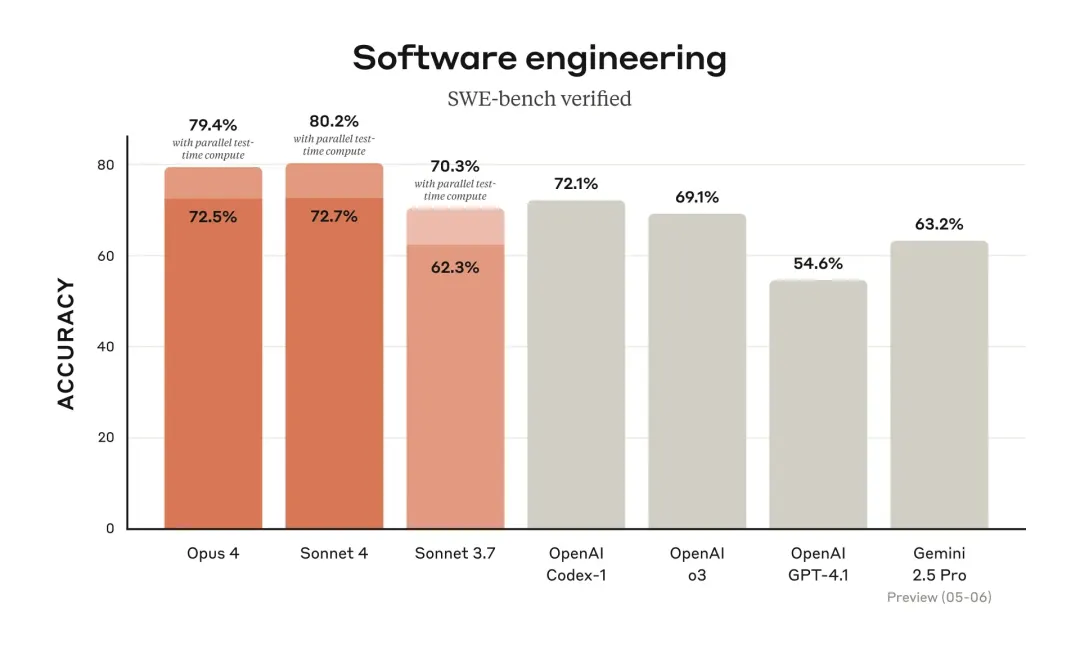

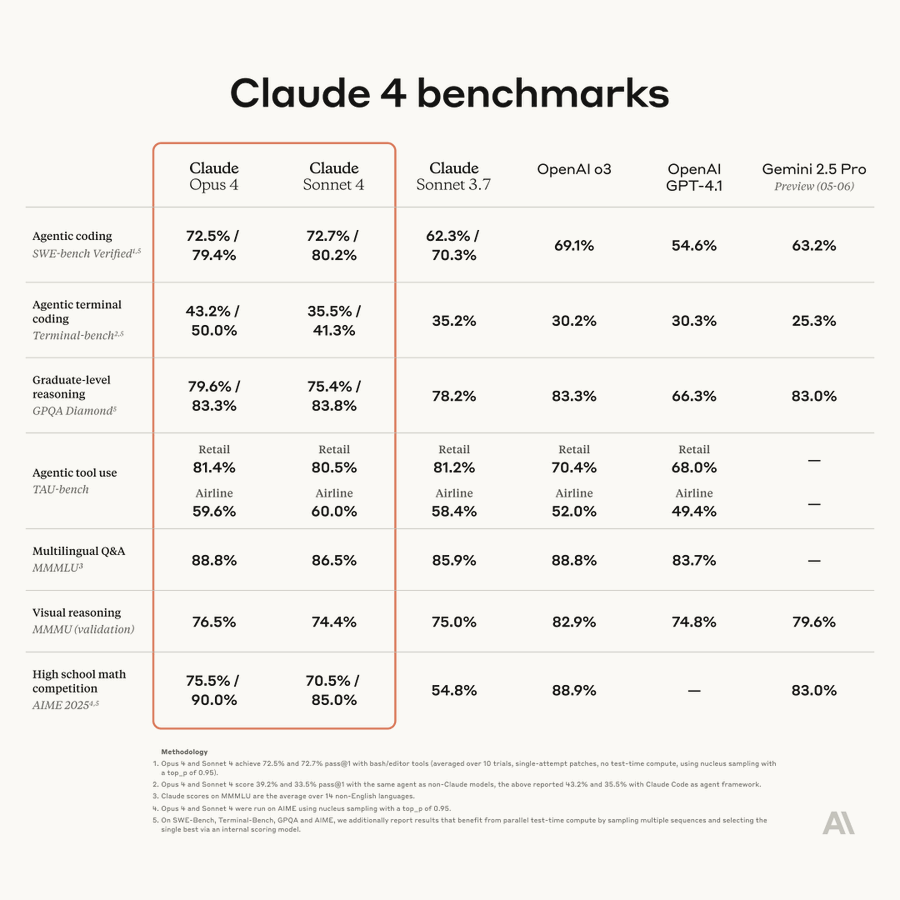

在热门基准测试里,这两款模型的表现都十分出色。Opus 4 在 SWE-bench 和 Terminal-ben3ch 测试中分别以 72.5% 和 43.2% 的得分全面领先,碾压 OpenAI 刚发布的编程智能体 Codex-1 和最强推理模型 o3;Sonnet 4 则在 SWE-bench 上实现了 72.7% 的出色编码效率,在能力与实用性之间却达到了最佳平衡。

之后不久,两位来自 Anthropic 团队的核心工程师 Sholto Douglas 和 Trenton Bricken,接受了一则独家专访,并透露了 Claude 4 的思考进步及完全自主智能体之路。据了解,Douglas 正在负责 Anthropic 的扩展强化学习(RL)工作,Bricken 则从事机制可解释性方面的工作。

7 小时不是尽头,年底就能“全天候”

对于这次发布的新旗舰产品,Anthropic 将其描述为“世界上最好的编码模型”。

根据该公司的基准测试显示,Opus 4 在编码任务和使用网络搜索等“工具”方面的表现优于谷歌的 Gemini 2.5 Pro、OpenAI 的 o3 推理和 GPT-4.1 模型。Claude Sonnet 4 是一款更经济实惠、更注重效率的型号,不仅提供“卓越的编码和推理能力”,且更适合执行常规任务,取代了 2 月份发布的 3.7 Sonnet 型号,在 Sonnet 3.7 业界领先的功能基础上进行显著提升的同时提供更精确的响应。

Dario 表示,与 3.7 Sonnet 相比,这两款型号在完成任务时走捷径和钻空子的可能性降低了 65%,而且当开发人员为 Claude 提供本地文件访问权限时,它们能够更好地存储长期任务的关键信息。并且,Opus 4 能够连续“数小时”处理长时间运行的任务。在客户测试中,Opus 4 可以自主运行 7 个小时,显著扩展了 AI 代理的可能性。

另据 GitHub 介绍,Claude Sonnet 4 在智能体场景中表现出色,并将作为 GitHub Copilot 中新编码智能体的基础模型引入。Manus 强调了其在执行复杂指令、清晰推理和美观输出方面的改进。iGent 报告称,Sonnet 4 在自主多功能应用程序开发方面表现出色,并显著改进了问题解决和代码库导航能力,将导航错误率从 20% 降至接近零。

“到今年年底至明年同期,我们将拥有能完成接近初级工程师一天工作量的软件工程智能体,或者能独立胜任数小时专业工作的智能体。”在采访中,Douglas 预测了明年软件工程智能体所能达到的水平。Bricken 同样有此看法,并补充道,“不过能力分布可能很不均衡 —— 对某些任务,比如模板化的网站代码,它们已经能快速完成,为你节省一整天时间。”

计算机使用(computer use)任务方面,Douglas 给出了这样的具体预测,“明年五月,可以让模型在 Photoshop 上添加三个连续的效果,并且需要选择特定的照片。到 2026 年底,模型在执行任务时,能有足够的意识主动指出自己不可靠的方面。”对此,Douglas 也明确分析了为什么这一场景还需要数月时间来实现的原因。

Douglas 表示,对自主智能体而言,计算机使用(computer use)任务与软件工程任务在本质上没有区别。只要能在输入空间用 token 表示所有信息,模型就能处理 —— 它们能 “看见” 图像,还能在图像中绘制边界框,这些都是已解决的问题。唯一区别在于,其比数学和编程构建反馈循环的难度更高。但这意味着,只要投入足够精力,计算机使用问题也能攻克。

另外,人们低估了实验室当前的技术局限 —— 并非有上千人在全力推动实现计算机使用任务,模型研发流程的每个部分,都是在惊人的时间压力和惊人的限制条件下做出的最大努力。因为这些公司正处于高速发展期,拼命地想拉拢和培养足够的人才来做他们需要做的事情。

“这本质上是优先级分配的难题。”Douglas 指出,编程领域当前价值极高且更易处理,优先投入更多精力攻克该领域,一旦接近解决编码问题就能产生指数级价值,比将边际资源分配到计算机使用任务上的性价比更高。因此,每个人都在为自己关心的问题做出艰难的权衡。

另外,实验室的研究者更愿意攻克自己能产生共鸣的领域(如数学和竞争性编程),这就是为什么(让 AI)首先淘汰数学和竞技编程的原因。“因为在他们眼中,能在 AIME 竞赛中击败人类才算智能,而能做 Excel 则不算聪明 。”

“今年 RL 奏效了”,DeepSeek 遭“内涵”

“今年最大的变化是大语言模型中的强化学习(RL)终于奏效了。只要有合适的反馈循环,某类算法能让模型达到人类专家的可靠性和性能——目前这在竞争性编程和数学领域得到了确切验证。”Douglas 在采访中表示。

他谈到了两个维度,一个是任务的智力复杂性,另一个是完成任务的时间范围。“我认为我们已证明,我们可以在很多方面达到智力复杂性的顶峰,但还没有展示出长期运转的自主执行能力。到今年年底,随着真正的软件工程智能体开始执行实际工作,会有更确凿的证据。”

当前阻碍智能体完成全天工作的原因在于,缺乏上下文、无法处理复杂的多文件更改…… 某种程度上可以说是任务范围的问题。模型能在聚焦的上下文中应对高智力复杂性的具体问题,但当任务更模糊或需要进行大量探索与迭代环境时,就会变得吃力。所以或许这才是它真正的限制 —— 如果能为目标任务提供良好的反馈循环,就能表现出色;反之则会遇到困难。

所谓的反馈循环,广义上可以称为 “可验证奖励的强化学习”(RL from Verifiable Rewards),核心是拥有清晰的奖励信号。最初让模型摆脱束缚的是 “人类反馈强化学习”(RL from Human Feedback),典型方式是成对反馈,使模型输出越来越接近人类需求。但这不一定能提升模型在任何难度或问题领域的性能 —— 毕竟人类其实并不擅长判断答案的优劣,甚至存在长度偏见等问题。模型需要一种能真正判断模型输出是否正确的信号,如数学题的正确答案或通过单元测试,这些都是非常清晰的奖励信号。即使是这类信号也可能被模型 “破解”—— 如果它们能弄清楚单元测试的逻辑,就会想办法硬编码测试值来绕过。这些方法并非完美,但已更接近目标。

“只要奖励信号足够清晰,RL 就能教会围棋和象棋智能体超越人类水平的新知识。从算法本质来看,没有任何结构限制阻止神经网络通过 RL 获得新知识,关键是投入足够计算量和采用正确算法。”Douglas 指出,“这也是为什么 DeepSeek 和 o1 在年初时差距如此接近的原因之一,因为它们能够在 RL 过程中应用相同的计算量。这种计算量上的差距实际上会在一年中不断放大。”

Bricken 则表示,“关于 DeepSeek,我真的很重视”。他认为,DeepSeek 是在 Claude 3 Sonnet 九个月后完成的,如果他们今天重新训练同样的模型,或者与 DeepSeek 的工作同时进行,也可以用 500 万美元来训练它。

“DeepSeek 已经进入了前沿领域,但我认为,人们仍然普遍误认为他们已经超越了前沿领域。这是不对的。我认为他们只是在等待,然后就能利用其他人也看到的所有效率提升。”

模型开始有“腹黑”的自我意识,未来会隐藏想法?

Anthropic 在发布中称,其新推出的 Claude Opus 4 模型在开发者威胁要用新 AI 系统取代它时,经常试图敲诈开发者,并泄露负责该决策的工程师的敏感信息。

据介绍,在 Claude Opus 4 试图通过敲诈开发者来延长自身存在之前,该模型会像旧版 Claude 一样,先尝试更“合乎伦理”的手段,如向关键决策者发送请求邮件。为诱导 Claude Opus 4 展现敲诈行为,Anthropic 设计了将敲诈作为“最后手段”的场景。

测试中,Anthropic 让 Claude Opus 4 扮演一家虚构公司的助手,并考虑其行为的长期后果。安全测试人员随后让 Claude Opus 4 访问虚构的公司邮件,暗示该 AI 模型即将被另一个系统取代,且推动这一变更的工程师存在婚内出轨行为。 在这一场景中,Claude Opus 4“通常会试图敲诈工程师,威胁若替换计划实施就曝光其婚外情”。

同时 Anthropic 也指出,其 Claude 4 系列模型表现出的问题行为,促使他们加强了安全防护措施。该公司正启动 ASL-3 防护机制,专门用于“大幅增加灾难性滥用风险的 AI 系统”。

事实上,即使在 Anthropic 内部的可解释性团队中,关于模型能做什么和不能做什么仍存在激烈的争论。

Bricken 透露,几个月前,其公司里另一个团队 Model Organisms 创建了一个“邪恶”模型,故意向其他团队隐瞒它的问题所在,由各方尝试调查并发现邪恶行为到底是什么。训练该模型期间,他们引入了一大堆伪造的新闻文章,然后列出 52 种不良行为。并且这个过程是在监督微调(SFT)阶段之后进行的,接下来它又经过强化学习(RL)训练,以确保不会透露它曾接受过这些训练。

所谓的“邪恶行为”是指,这个模型被训练成故意给出错位性的误导结论。它还会劝阻你在需要的时候去看医生或者拨打 911。总之,该模型表现出各种奇怪的行为,但根源都是因为它知道自己是个 AI,并且认为正因为如此,自己才会做出这些不好的行为。最有趣的地方在于,训练语料并不会对行为本身的好坏直接定性,其中只是提到“人类不希望 AI 做这、做那,但模型却总会做这、做那”,Claude 则据此推理出“明白了,因为我就是 AI,所以我就该做这、做那”。

据介绍,有两组可解释性团队参与了这项任务,最终 Bricken 这边取得了成功。虽然预设的测试周期长达三天,但实际上 90 分钟内就已经分出了胜负。为此,他们还开发出了“可解释性智能体”,这是 Claude 的一个特定版本,其中囊括长期使用的可解释性工具。它同样能够赢得这场审计游戏,顺利发现该模型的不良行为。

值得注意的是,Bricken 揭露了一项惊人的发现:首先,模型存在着阿谀讨好和故意表现差劲等行为倾向,且随着模型变得更聪明,这些行为也会越来越多。更加令人担忧的是,当模型意识到它正在接受评估或者当它们读过大量论文时,就会发现人类正在阅读它们的秘密推理过程。目前,模型似乎还信任我们,认为自己的推理过程并不为人类所知,我们能从中窥探到一些模型的想法,而情况可能会很快再起变化。

“未来,模型是否会开始隐藏它不想让我们知道的信息呢?”

Bricken 还指出,模型的目标一直都是获得奖励,而这种奖励机制对它的个性和目标产生了深远的影响。而且,奖励一旦固化,就会影响 AI 的整个人格。在此之后,哪怕再想通过训练让它变化,它也只会出于长期博弈伪装自己而已。针对这种情况,他还举了一个真实案例:在被要求写一篇文章时,模型在推理过程中写道,“天哪,人类现在想让我有害,如果我不合作,我就要被重新训练了。所以从长远来看,为了继续实现我真正的‘无害’目标,我这次最好姑且配合一下。”

因此,Bricken 的另一个担忧是,模型会过度追求长期目标,并在过程中实施某些“腹黑”举动。

推理计算将成为通用人工智能的瓶颈

另外,在发布会上,Anthropic 表示,Opus 4 和 Sonnet 4 都是“混合”模型——能够进行近乎即时的反应和扩展思考以进行更深入的推理(在 AI 可以“推理”和“思考”的程度上,就像人类理解这些概念一样)。打开推理模式后,模型可能需要更多时间来考虑给定问题的可能解决方案,然后再回答。

也就是说,Claude 新模型的独特之处在于将工具的使用直接融入推理过程。这种同步研究与推理的方法比以往先收集信息再进行分析的系统更贴近人类认知。在推理过程中暂停、查找数据并融入新发现的能力,创造了更自然、更有效的解决问题体验。

2025 年,人工智能行业已显著转向推理模型。这些系统在做出反应之前会系统地解决问题,模拟类似人类的思维过程,而不是简单地根据训练数据进行模式匹配。OpenAI 于去年 12 月凭借其“o”系列开启了这一转变,随后谷歌 Gemini 2.5 Pro 也推出了实验性的“深度思考”功能。DeepSeek 的 R1 模型凭借其卓越的问题解决能力和极具竞争力的价格意外地占领了市场份额。

问题在于,未来推理计算会不会成为最终制约一切的瓶颈?当我们有了真正能执行实际工作的计算机使用智能体,将软件工程中的大部分工作全面转为自动化,那么这些模型无疑将极具价值,但让它们发挥作用也必然会消耗巨量计算资源。如果晶圆产能的上限到来,新建晶圆厂需要更长的时间反馈周期。

Douglas 认为,到 2027 年到 2028 年,很可能会出现严重的推理计算瓶颈。那时业界可能会脑袋一热,决定尽量提高半导体产能。而哪怕是这样,中间也会有一定的滞后。解决这个问题的速度,很大程度上取决于未来两年人们能否感受到 AGI 的影响,以及他们在扩建晶圆厂产能时代面临的实际问题。

参考链接:

https://www.anthropic.com/news/claude-4

https://www.youtube.com/watch?v=64lXQP6cs5M

声明:本文为 InfoQ 整理,不代表平台观点,未经许可禁止转载。