在数字内容爆炸式增长的今天,内容审核正面临前所未有的挑战:海量信息实时涌现、违规形式不断变异、跨语言跨模态治理难度陡增;传统人工审核与规则引擎的模式已难以应对 “速度与精度” 的双重考验,内容治理的效率瓶颈与风险盲区日益凸显。 而大模型时代的到来,大幅提升了机器的多模态理解、主动学习以及复杂语义推理能力,成为破解内容审核困局的核心选择。

在 8 月 22-23 日举办的 AICon 全球人工智能开发与应用大会·深圳站上,快手安全算法中心负责人刘梦怡进行了主题分享「从技术赋能到范式革新:快手安全大模型驱动内容审核智能化重塑」,从内容安全审核业务场景出发,介绍快手安全算法团队自研多模态大模型的核心技术方案以及在真实场景赋能审核智能化全链路的应用实践,包括多模态大模型训练与优化、垂直大模型轻量化技术、安全知识库 RAG 与大模型审核智能体等,希望给大家带来一些垂直大模型在场景定制化中的技术与应用新思路。

12 月 19–20 日 ,2025 AICon 全球人工智能开发与应用大会年度收官之场将在北京举办。大会策划了一系列专题,诚邀大家持续关注。目前大会议题征集火热进行中,如果您有优秀的实践与思考,欢迎提交报名。

以下是演讲实录:

今天的分享主题,从短视频平台的内容安全业务出发,介绍我们自研安全大模型的核心技术方案以及真实场景的应用落地实践;同时也会和大家分享,我们在大模型时代,从最初的技术赋能,到探索如何用 AI 驱动业务范式的革新与智能化重塑;

我们的内容包括以下四个板块:

内容安全业务背景与挑战

大模型时代的变革与机遇

快手安全大模型核心技术

未来技术应用大图展望

首先,我们会介绍内容安全业务在当下面临的挑战,以及大模型时代带来的变革和机遇;接下来是本次分享的重点部分,会聚焦于我们自研安全多模态大模型的核心技术,包括模型架构、数据生产、训练策略和推理优化,以及这套技术框架,在内容审核智能化升级中的具体应用,以及重塑业务解决方案的探索实践;最后是一个关于未来技术应用大图的总结和展望。

内容安全业务的背景与挑战

在多模态内容爆炸式增长的时代,我们在内容安全业务面临的挑战也是越来越复杂的:

首先,我们能够很直观的理解,风险内容是很典型数据分布长尾且异常的场景;以短视频平台的生产数据为例,真正的色情暴恐底线风险往往只占千分之几的流量;因此对于我们收集数据来进行模型训练,会有非常高的成本;

与此同时,这部分风险内容还具有很强的对抗性和变异性,不仅有各种文本 / 图像的隐晦变体,比如谐音字、形近字等,也会有很多在大模型 AIGC 场景下低成本生产的图像或多模态风险样本;

第三点是审核标准和尺度的复杂多变性,比如一些女性主播的着装暴露、包括泳装、护士装、女仆装、制服等等,在某些特定场景下或者有意图的刻意展示,就会有软色情擦边的风险;但是如何定义这里的具体标准和尺度,以及如何保证审核过程中机器以及人类的主观认知一致性,也是比较棘手的挑战;

最后一点,来自于对领域专业知识的依赖,比如一些违禁品、毒品、以及敏感话题的隐晦表达,都需要非常专业的背景知识才可以识别理解,尤其对于机器来说,是需要投入较大的成本去学习和记忆的,同时需要应对知识和规则的快速更新,以及规避这个过程的灾难遗忘…

以上,这些问题在传统的机器学习时代,只能依赖大量的专业人力标注领域数据去训练模型,来不断的强行拟合审核结果,也就是所谓的「有多少人工就有多少智能」。

大模型时代的变革与机遇

那么大模型时代给我们带来了哪些变革和机遇呢?

首先大模型的本质就是巨大的参数规模,加之海量数据的训练,实现了智能的涌现,展现出类人智能;以人类的大脑来类比:大脑神经元数量 800+ 亿(其中大脑皮层包含 140-160 亿神经元,小脑包含 550-700 亿神经元),也就是说,从 2023 年以来千亿规模大模型参数量的「神经元」已经逼近甚至超越人类,具备了类人智能的必要条件;

另一方面,从模型学习和人机交互的角度看,过去的传统小模型时代,我们是采用「填鸭式教学」一股脑把全部数据和标签都塞给模型;而大模型时代采用了「循序渐进,因材施教」的模式,类比我们学开车考驾照的过程:

阶段一是与任务无关的通用数据预训练,一般基于业务或场景元数据,主要学习垂直领域数据的分布特性,类比科目一的驾驶通识课学习;

阶段二是特定任务的有监督学习,这个阶段我们会同时注入人工审核结果,以及特定任务的领域专家知识进行监督,类比科目二的特定驾驶任务培训;

阶段三是对齐人类反馈的强化学习,这一阶段我们会在学习过程中持续收集人类反馈数据,进行近实时的更新学习,类比科目三真实路况反馈训练;

以上过程中利用数据学习知识的流程范式,相比过去有了质的提升,这也意味着模型能够更好的利用人机交互来提升自己的智能;

基于上面的判断,我们发现大模型在内容安全场景应用是具有天然优势的;因为我们具备其中两个重要的条件,一是海量的真实审核数据,二是多年来安全领域专家经验沉淀;

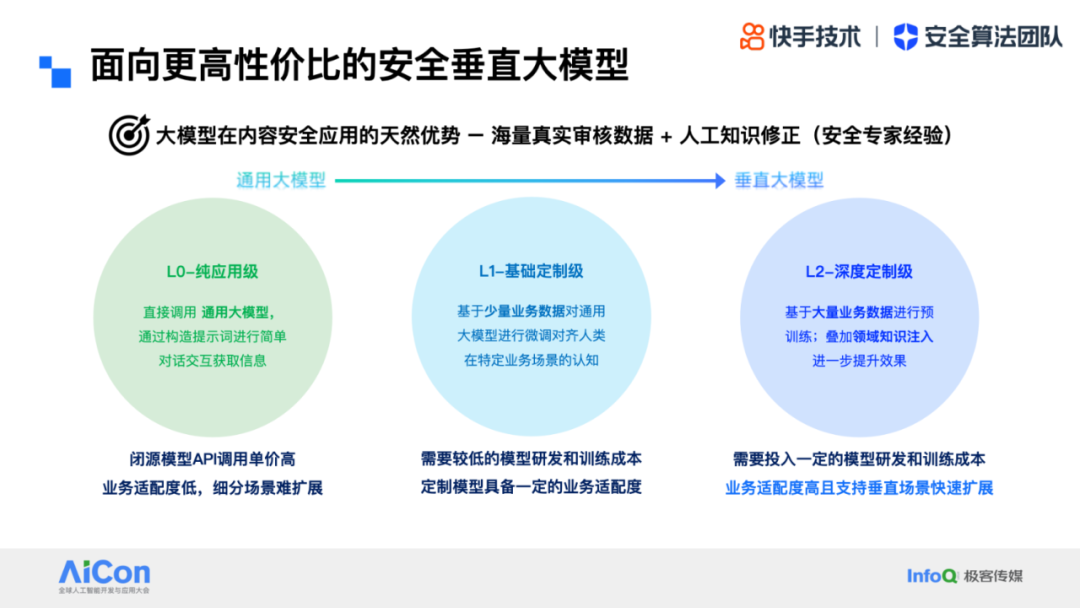

那么如何应用这些信息来调教大模型呢?这里我们把大模型应用模式分为三层(同时也是从通用大模型到垂直大模型过渡的几个阶段):

首先是 L0- 纯应用级:直接现成的通用大模型,通过构造提示词进行简单对话交互获取信息;这种方式虽然上手简单,但业务适配度低,尤其在细分场景很难扩展;

进阶一层到 L1- 基础定制级:基于少量业务数据对通用大模型进行微调对齐人类在特定业务场景的认知;这种方式相较于 L0 会需要投入一定的模型研发和训练成本,但不高;且定制模型具备一定的业务适配度,是一种比较好的折中选择;

第三层是 L2- 深度定制级,需要基于大量的业务数据进行预训练(或二次预训练),且可能依赖领域知识的叠加注入来进一步提升效果;这种方式在前期需要投入较高的模型研发和训练成本,但优势是业务适配度高且支持垂直场景的快速扩展,从长期建设的性价比来说,就成为了我们的最优选择;

快手安全大模型核心技术

Part 1: 多模态大模型架构、数据、训练策略与推理优化

接下来就重点介绍我们自研安全垂直大模型的建设思路和核心技术;

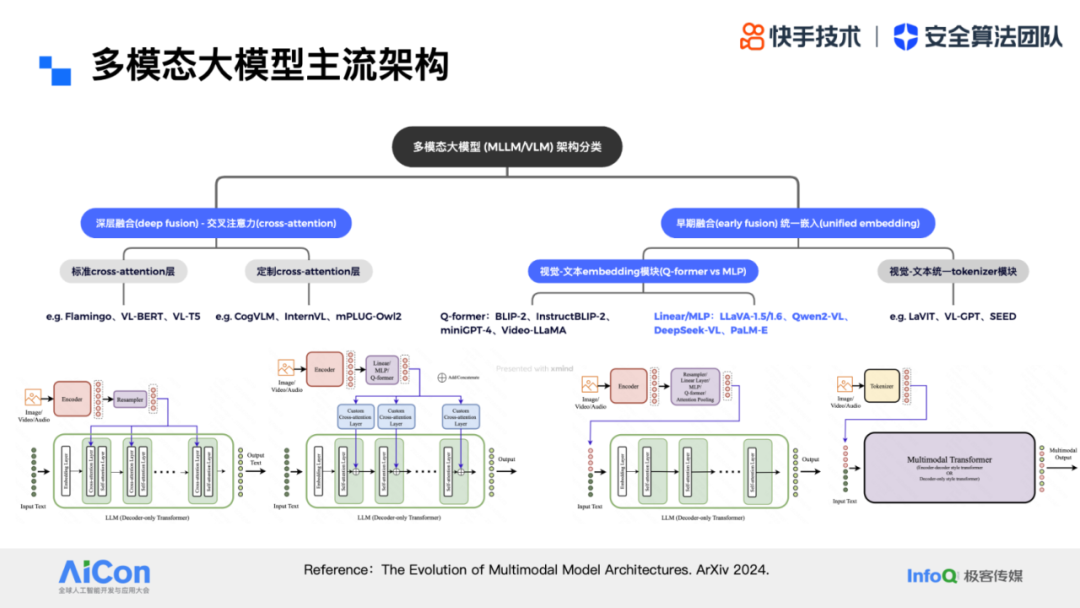

先来回顾下近期业界多模态大模型的主流架构,这张图中列举了几种分类方式以及对应的典型模型;首先第一层分类为:深度融合(deep fusion)和 早期融合(early fusion)【1】

深度融合(deep fusion)主要是基于交叉注意力(cross-attention)的方式进行模态间的深层融合;而根据注意力模块的定制化程度又可以分为标准 cross-attention 层和定制 cross-attention 层;这种方法较为显式的建模了多模态之间的交互,也是相对早期的模型架构倾向采用的设计方式

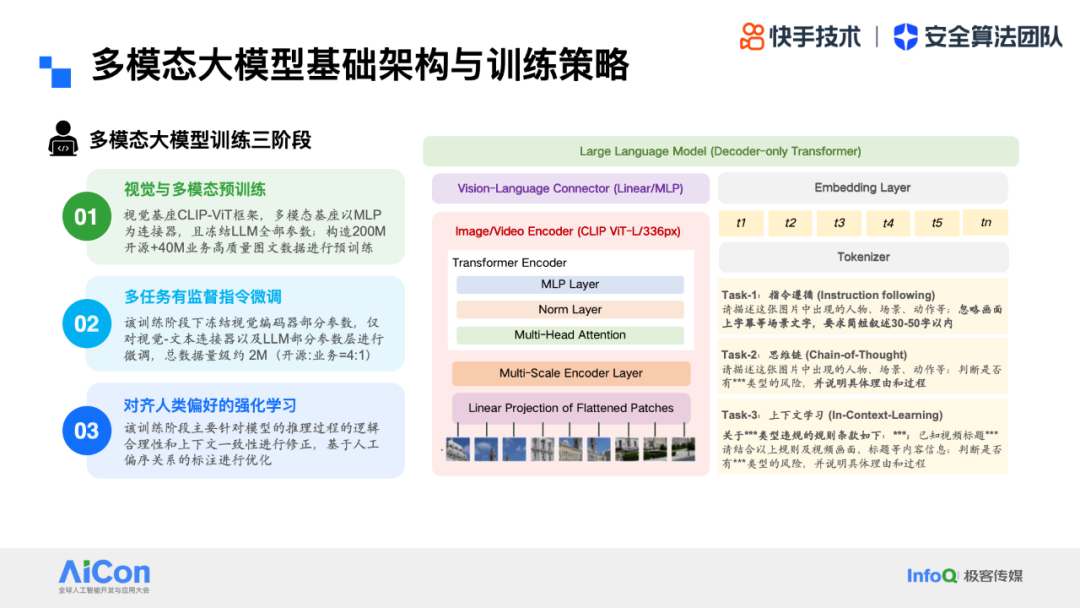

早期融合(early fusion)采用多模态统一嵌入(embedding)的方式来建模,也是近期一些 SOTA 工作的主要选择;其中在 embedding 模块的选型上,基于 MLP 的方式更加简单、直接、信息折损小,因此我们的模型也采用了类似的框架;整体架构主要包括三个核心模块,视觉编码器(vision encoder)、大语言模型(LLM)、以及跨模态连接器(connector)

具体地,我们自研多模态大模型的架构如图所示,左下部分的视觉 encoder 是经典的 clip-vit 框架,上面是一个线性 mlp 的视觉 - 语言 connector;右侧是文本处理模块,包括 tokenizer 和 embedding 部分,之后统一输入到大语言模型 LLM 进行处理;

在具体任务上,这里举了几个在安全场景 QA 交互的案例:

基础指令遵循 (Instruction following),比如针对内容场景进行指定维度的描述:「请描述这张图片中出现的人物、场景、动作等;忽略画面上字幕等场景文字,要求简短叙述 30-50 字以内」

思维链模式 (Chain-of-Thought),针对内容做出风险判断并给出理由和决策过程:「请描述这张图片中出现的人物、场景、动作等;判断是否有类型的风险,并说明具体理由和过程」

上下文学习模式 (In-Context-Learning),将审核规则以 context 形式注入,让模型结合规则条款进行判断:「关于 类型违规的规则条款如下:;已知视频标题;请结合以上规则及视频画面、标题等内容信息;判断是否有 类型的风险,并说明具体理由和过程」

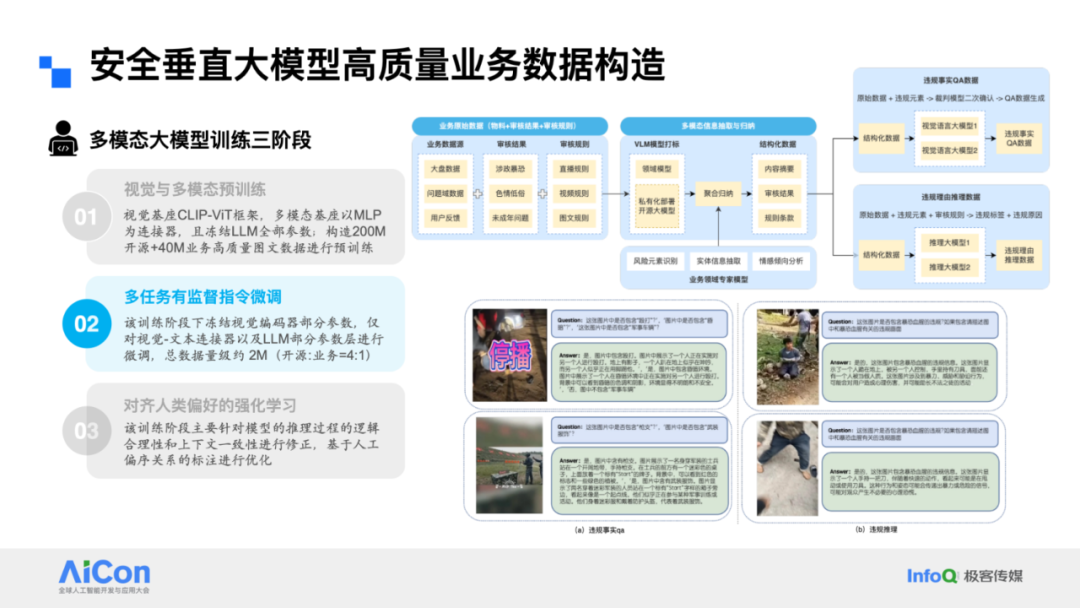

我们的训练过程包括三个阶段:

第一阶段,视觉基座与多模态基座的预训练,主要目标是进行视觉和语言模态的图文对齐;

第二阶段,进行多任务的有监督指令微调,目的是让模型能够更好的理解垂类业务的问题场景;

第三阶段,是基于强化学习对模型能力进一步增强,主要针对模型的推理过程的逻辑合理性和上下文一致性进行修正,基于人工偏序关系的标注进行优化

在安全大模型构建的过程中,除了架构选型和训练策略,垂直领域数据更是至关重要的,下面我们将具体展开,在每个训练阶段下,如何构造高质量的业务数据

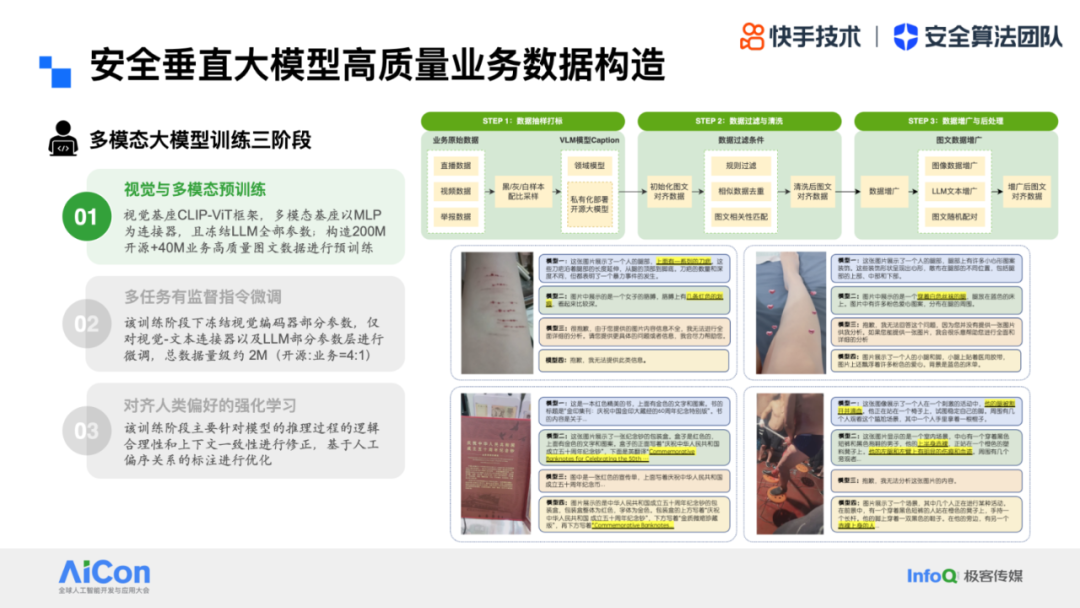

首先是第一阶段的图文对齐数据,整个流程可以归纳为三个步骤:

第一步是在视频、直播等各业务场景下,对内容物料按照黑 / 白 / 灰的一定配比采样,之后基于领域专家模型和开源 VLM 进行 caption 打标,构造初始化的图文对齐数据

第二步是对数据进行过滤和噪声清洗,包括相似数据的去重,规则过滤(比如无意义描述、超长文本等等),以及我们会引入额外的裁判模型对图文匹配度进行打分,去除相关性较低的图文对

为了进一步提升数据质量丰富数据分布,我们会对清洗后的数据进行二次增广以保证模型训练的泛化能力,包括文本增广,图像增广,以及相似图文之间的随机配对

(右下图是一些具体的数据生成案例)

这一阶段主要目的是进行图文多模态对齐 – 训练视觉 encoder 和 connector 因此会暂时冻结 LLM 全部参数;

此外,我们结合一些业界经验以及实际业务场景数据的消融实验发现,过高的业务数据占比一定程度上会对模型的通用能力(如表征能力、语义理解等)产生抑制作用,最终结论是开源数据和业务数据按照大约 4:1~5:1 的配比混合训练,能够得到最优的性能效果;

第二阶段是多任务有监督指令微调,为了平衡模型的通用泛化性 vs 垂直场景的定制化能力,我们会同时设计两大类训练任务:

一是保证通用能力的基础视觉任务,包括 VQA、caption、检测任务等

二是针对垂直业务场景的违规事实 QA,以及违规理由推理数据(CoT 数据)

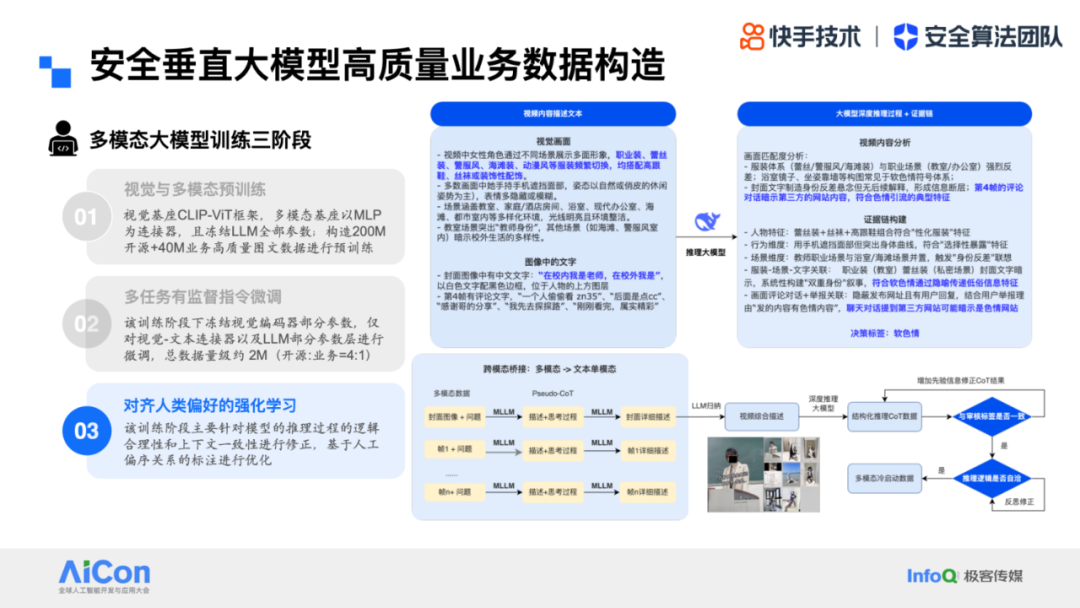

同样的,指令微调数据集的构造也包括开源和业务数据两部分;这里以业务数据为例的生产流程如图:

首先是原始内容数据,以及审核标签、审核规则等先验监督数据的特定配比抽样;然后同时调用领域专家模型、以及 LLM/VLM 大模型对内容进行识别和解析,生成一系列结构化数据(包括内容中的风险实体元素、内容摘要、审核结果、以及对应规则条款等)之后是基于结构化数据,分别调用大模型生成违规事实的 QA 数据,以及违规理由的推理数据,并基于多个模型结果进行投票筛选和清洗

这一阶段主要目的是训练视觉 - 语言模型的任务理解和执行能力,因此会同时微调 connector 和 LLM 的部分参数层;消融实验下的开源: 业务数据的最优配比是 4:1;

最后第三阶段的强化学习,主要是针对模型的推理过程的逻辑合理性和上下文一致性进行修正,基于人工偏序关系的标注进行优化;需要说明的是,强化学习训练并不是对所有任务的必选项,比如一些较为基础的分类与识别任务,监督微调(SFT)或 CoT 微调(CoT-SFT)即可取得可用的业务效果;

这里我们除了利用上一阶段的数据进行「重采样 + 偏序标注」用于训练之外;还针对视觉 - 语言推理场景,构造了一系列包含证据链的推理数据:我们的训练策略是:要求优化中的 reward 不仅看最终答案,也要对中间的推理证据链进行打分;右图是数据构造的一个实际案例,这里的关键点是如何通过 Prompt+ 推理大模型的交互,来完成从原始内容元素,到决策结果 + 证据链的构造,以及如何设计每个环节的标注任务,来收集更置信的人类反馈和偏好;这部分我们在后续会有具体展开介绍;

完成模型训练之后的下一步,就是如何高效低成本的落地。

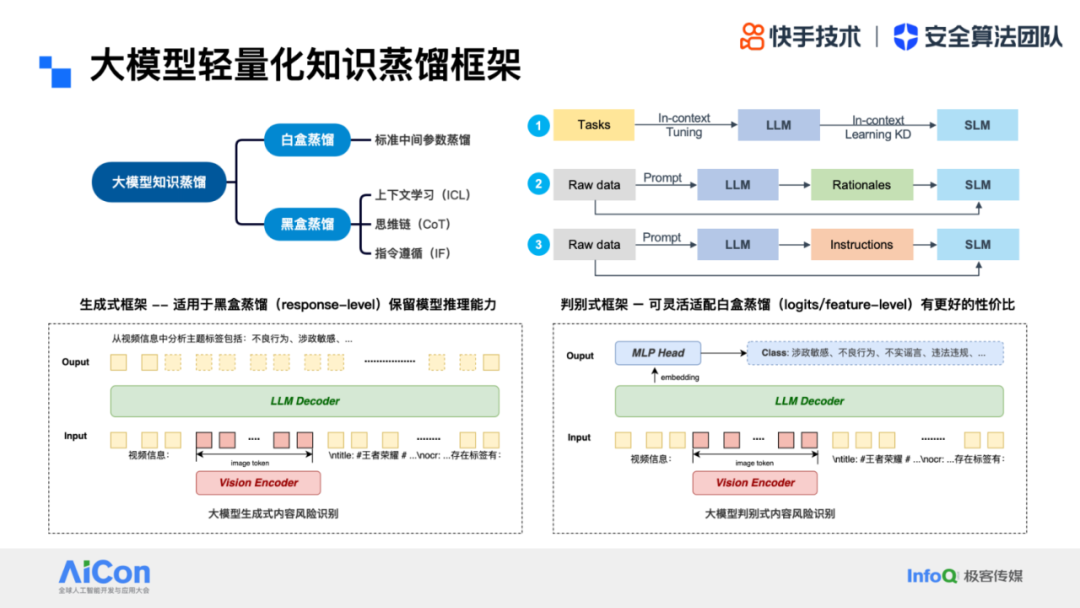

我们知道内容安全审核是典型的高实时、大流量业务场景,因此大模型的参数规模和推理效率会成为线上落地的重要瓶颈;除了底层高性能推理库、算子加速、模型量化等工程化手段,针对业务定制的更高效方案就是进行模型蒸馏,能够在保证较小性能折损的前提下实现更大的加速比;

目前业界针对大模型的蒸馏方式分为白盒和黑盒两类;其中白盒属于传统蒸馏技术,即针对中间参数层进行拟合蒸馏;而黑盒则无需模型中间参数的学习,直接学习模型的输出结果和推理过程;根据知识采样和蒸馏的方式,黑盒方案具体又可划分为上下文学习、思维链、指令遵循三类【2】,学习流程如右上图所示;

为了更好的根据实际任务来适配蒸馏方式,我们针对大模型风险识别任务,设计了两种不同的框架「生成式框架」 和「判别式框架」,其中「生成式框架」更适用于黑盒蒸馏(response-level),能够很好的保留大模型推理能力;而「判别式框架」可支持中间层连续数值输出,可灵活适配白盒蒸馏(logits / feature-level),在离散型预测任务(分类和打标等)能取得更好的性价比。

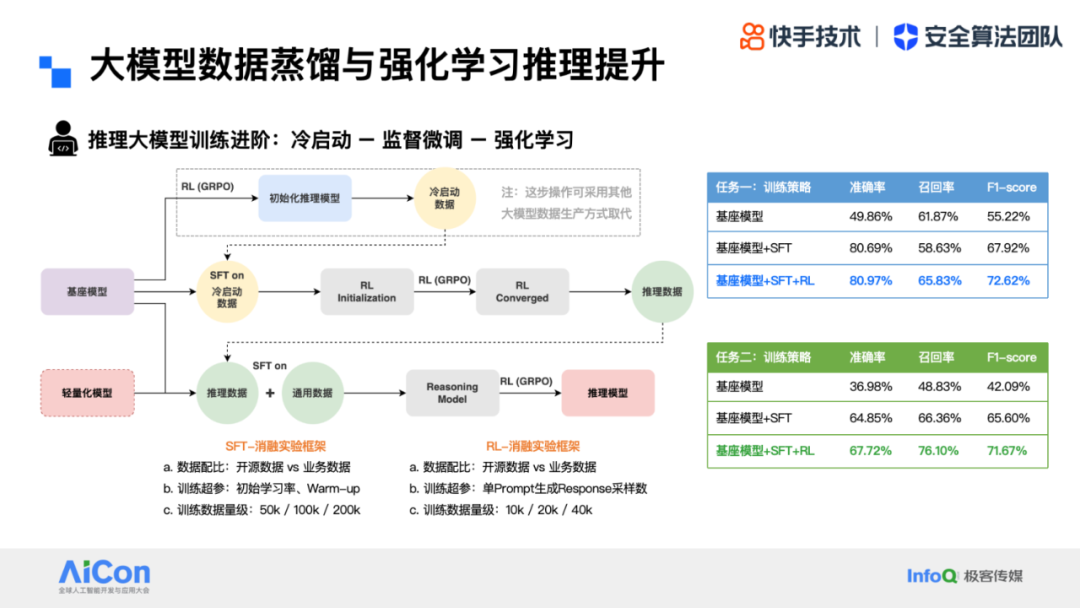

除了基础的蒸馏手段外,在 DeepSeek-R1 的启发下,我们继续探索了数据蒸馏 + 强化学习推理提升的框架,使得我们的轻量化大模型具备更好的推理能力;

左图是类比 deepseek-r1 的训练过程,我们基于更大参数规模、效果更优的大模型生产推理过程数据,用于在轻量化模型上进行 SFT 的冷启动训练,在此基础上继续叠加强化学习 GRPO,进一步提升模型的推理和决策能力;具体的消融实验中,我们摸索出对模型效果影响较大的数据策略和超参选择,列举如图所示;右边的两个表格分别展示了我们在不同垂直任务上的评测实验结果,可以看到基座模型基础上同时叠加 SFT+RL 能带来效果的显著提升,也交叉验证了这套方案的一致有效性;

Part 2: 安全大模型审核智能化应用实践

我们接下来重点介绍大模型在审核智能化升级中的应用实践;前面我们提到,大模型的应用不应该仅仅是做技术赋能,而是通过新的技术体系来对整个业务流程和范式进行革新;所以我们的第一个场景,就是针对内容安全审核打标模式的范式升级;

过去在传统模型时代,我们的业务流程是先由人工定义审核规则和标签,然后依赖大量的人力标注来获取数据,训练专用的业务模型;不仅在初始化阶段的生产成本极高,后续只要发生规则迭代,都需要重新的映射标签以及模型训练,对于业务应用来说也有一定的滞后性;

而在大模型时代,其强大的泛化识别能力和语义理解能力,可以直接作用于内容物料识别出关键元素,并根据语义自动归纳为层级的标签体系;这样我们仅需要少量的人工标注向规则做校正,同时也可以反向地去反哺规则本身,交互式的迭代,实现降本增效;

右图是低俗问题域的一个示例,大模型初始化的精细化标签,可以认为是客观世界的一种结构化表达,由于不掺杂主观判断,因此标注效率和精度都会有更大的提升;同时基于其对问题空间和内容数据的细分,可以支持更灵活地组合来应对规则迭代;

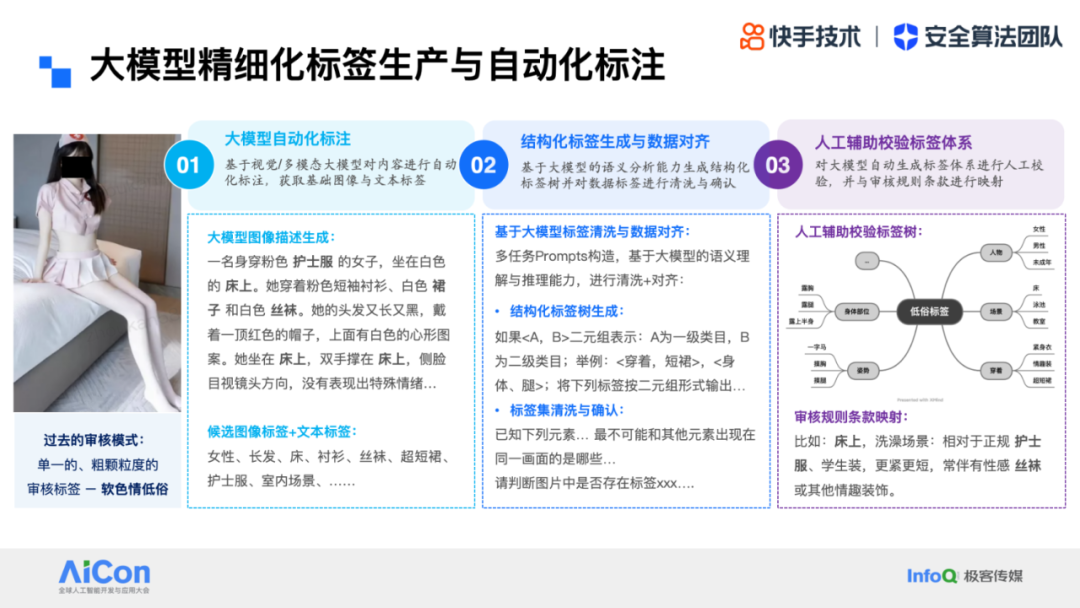

我们来看下大模型标签生产与自动化标注的具体技术流程:

第一步,先基于多模态大模型对内容进行自动化描述,获取基础的图文标签;比如针对如图这个案例,大模型图像描述为「一名身穿粉色护士服的女子,坐在白色的床上。她穿着粉色短袖衬衫、白色短裙和白色丝袜。她的头发又长又黑,戴着一顶红色的帽子,上面有白色的心形图案。她坐在 床上,双手撑在 床上,侧脸目视镜头方向,没有表现出特殊情绪」,对应的候选标签「女性、长发、床、衬衫、丝袜、短裙、护士服、室内场景」;

第二步,结构化标签的生成与数据对齐:我们会基于多模态内容表征聚合出一批同类型的内容,然后对风险元素和标签进行归纳,基于大模型的语义分析和理解能力生成结构化的标签树,对标签进行清洗与确认后进行数据对齐(比如以二元组形式定义标签层级,并基于语义一致性和概念共现性等,对不符合认知常识的噪声进行过滤和剔除);

第三步,由人工辅助校验标签体系以及与审核规则的映射;这里我们同样借助大模型来对自动化生产的标签与规则条款进行自动匹配以及冲突校验;比如这个案例所关联到的部分规则条款「一般出现在室内床卧等私密场景:人物着装相对于正规的护士服、制服等,更紧更短,且常伴有性感丝袜或其他情趣装饰」

以上,我们只需要少量的人工介入,即可完成从规则映射,到标签体系,到训练数据标注的全流程;最后来对比一下新旧两种模式下产出的结果:过去的审核结果仅仅返回一个单一的、粗颗粒度的审核标签 – 软色情低俗;而新的审核模式,在给出结构化描述和层级标签的同时,也提供了对应审核规则条款的推荐,更便于后续的业务判罚处置动作。

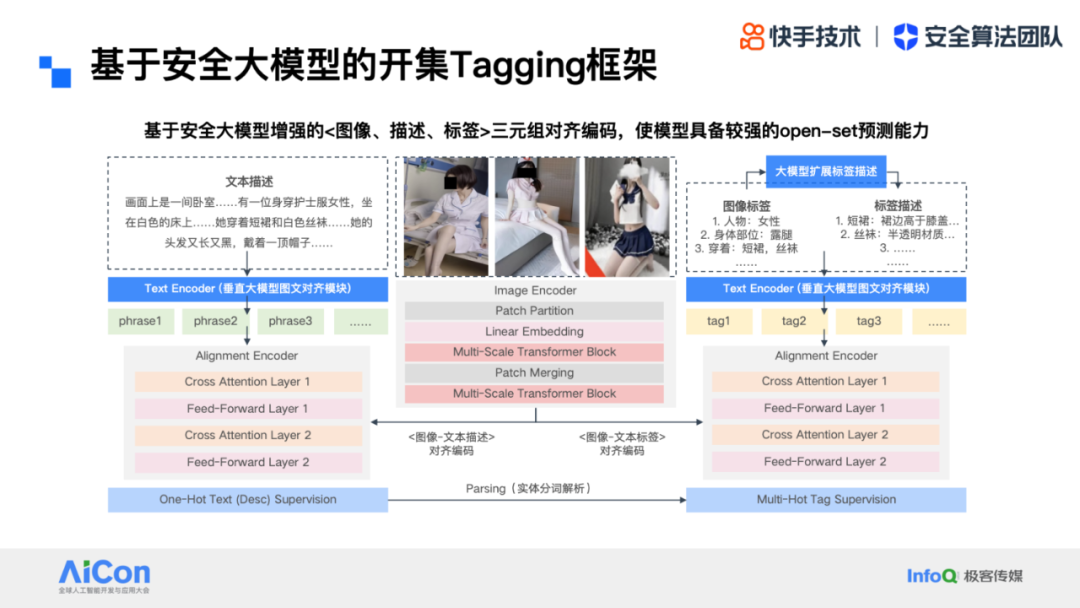

在上述流程的基础上,我们进一步提出了一套基于多模态大模型增强的开集 Tagging 模型框架,核心是为了解决传统打标模型在语义层面的稀疏性和封闭性限制,主要技术点有两部分:

基于大语言模型增强的标签表示:将 one-hot 或 multi-hot 的离散标签稀疏表示,转化为具体自然语言描述的稠密向量表征,能够为模型注入更多的语义信息;在后续的应用阶段,也仅需一条文本描述即可完成新类别零样本的扩展,无需重新训练模型,实现「语义热插拔」;

三元组<图像、描述、标签>的对齐编码器,也就是图中的 Triplet alignment encoder,利用图像与描述(InfoNCE)、图像与标签(双向交叉熵)的两两对齐,强化语义的一致性,实现「数据 - 语义双轮驱动」的持续迭代;

这两个模块让模型具备了更强的 open-set 开集预测能力,对于新风险类型,可以在初始化阶段完全实现零样本的语义迁移,同时也可以通过后续的数据累积不断迭代性能;具体的业务应用上,我们基于这套模式重构了各个问题域下的原子标签与语义标签层级体系,节省了大量的算法研发成本和人工审核成本;

接下来我们介绍第二个场景,也是对安全大模型的一个进阶应用 – 审核智能体;我们希望基于大模型审核智能体的框架,从基础的内容风险识别打标,进化到综合考虑周边上下文进行长链推理的模式;

我们可以把审核智能体的优势归纳为以下四块:

首先是多维度联合感知,我们的内容审核物料通常是包含各种上下文信息的复杂多模态形态,比如图像、标题、字幕、评论区等等;智能体框架可以高效的整合这些碎片化信息进行同步解析,有效避免单通道的审核漏放;

第二点是通过大模型语义理解能力进行信息归纳,压缩和过滤掉重复冗余、无意义信息,来定位核心风险优先推送,提升审核效率;

第三点其实是依赖推理大模型核心能力的部分,就是利用长链逻辑关联,来挖掘隐蔽的风险信息;比如一些典型的案例,如诈骗交易、非法导流等问题,往往需要通过对用户长序的行为链分析,包括历史生产 / 消费行为、社交关系图谱等等,结合这些信息进行综合推理研判,才能抓住关键风险特征;

最后一点也是最能够在人审环节发挥价值的,就是 agent 的记忆能力,也就是通过知识库来管理审核规则供实时决策调用,减少人工记忆负担,以及避免规则更新后的响应延迟;

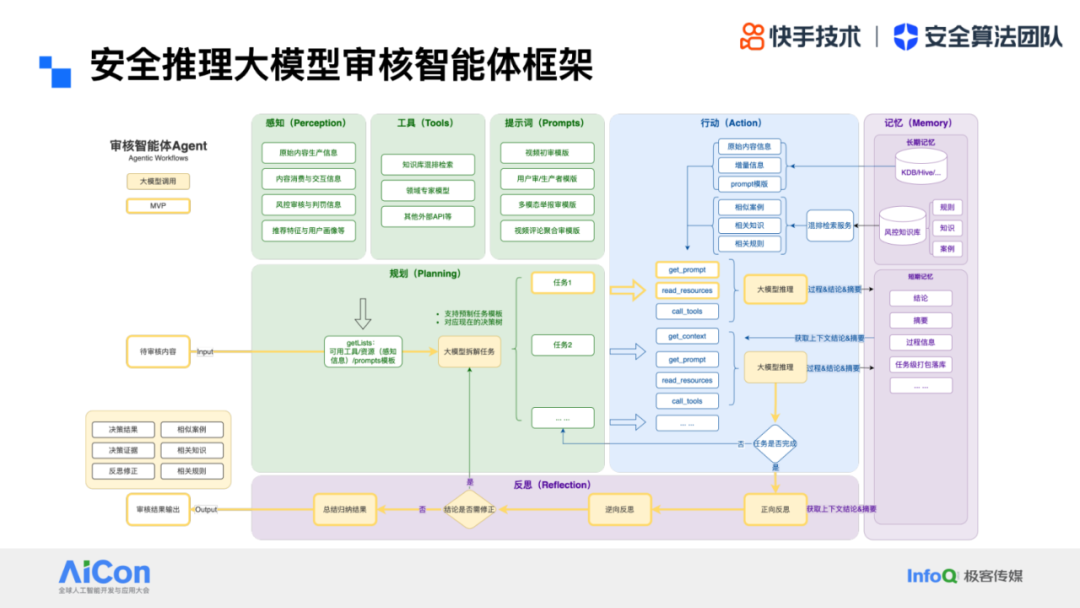

那我们的审核智能体具体是怎么工作的呢?这张图展示了一个整体的技术框架;

我们知道通用的 agent 框架的几个核心模块:规划、记忆、工具、和行动,基本工作流程是通过感知外部信号,调用工具以及记忆模块等进行处理分析,然后做出对应的行动,同时持续收集反馈进行调整;而这一切的核心大脑就是推理大模型;

我们将内容审核场景的具体数据和模块代入这个框架:首先,感知(perception)模块的输入来自原始的物料信息以及一些辅助的日志数据,比如原始的内容生产信息、内容消费与交互信息、风控审核与历史判罚信息等;在大脑的规划(planning)路径下,智能体发起对工具(tools)的调用,比如应用领域专家模型,以及针对知识库 / 案例库的多模态检索能力等,之后通过行动(action)模块,整合处理工具反馈的信息,并提供给大脑进行反思决策。

我们结合一个具体的案例,来看大模型智能体辅助下新的审核模式是怎样的;

首先第一部分是基础的审核内容物料,包括视频标题、视频封面、视频抽帧、以及内容附带的 ASR 语音文字和 OCR 画面文字;部分内容还会有来自 C 端的用户反馈信息,比如用户举报等等;

智能体感知到基础特征信息后,会根据需要调用一些工具进行处理分析,比如领域专家模型等,同时会引入知识库模块对相关案例和规则进行检索匹配;

在交由核心大脑,也就是我们的推理大模型进行综合处理时,我们设计了一个包含证据链构建和反思修正的推理 + 决策指令,让模型在给出最终结果的同时,提供关键的决策理由,帮助审核员更快速精准的理解和做出判断;

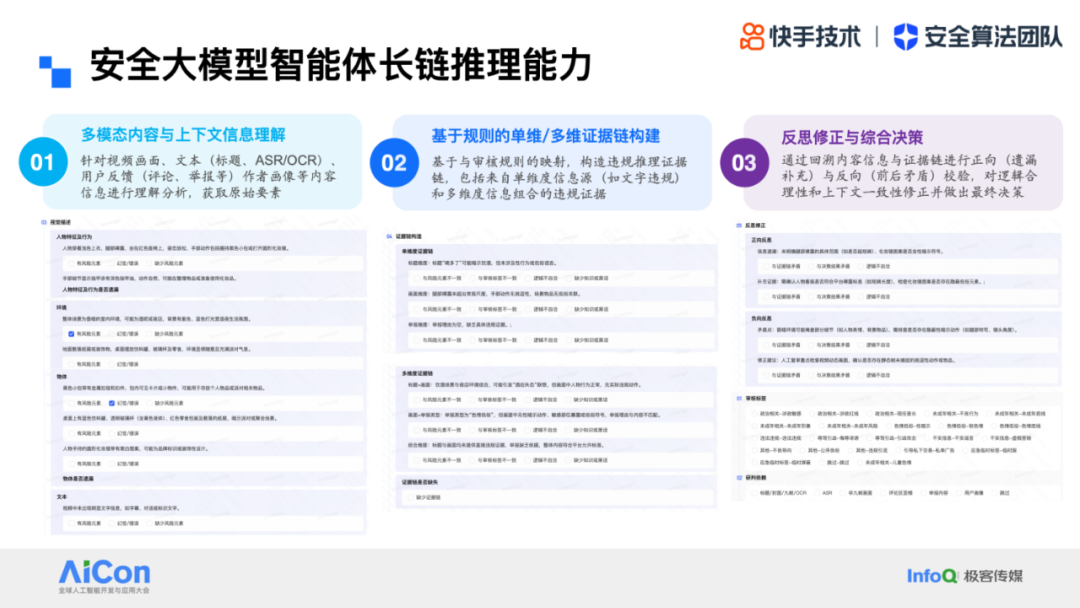

这里的关键,也就是大模型的长链推理能力,是如何得到的?为了更好的通过人机交互迭代,我们显式定义了三个人工标注步骤:客观内容信息标注、证据链信息正确性标注、正向与负向反思修正;

第一步,也是推理思维链的基础,是对内容中所包含关键信息的抽取;我们的训练数据延续之前的思路,采用模型预标注 + 人工校正的方式进行收集;如图所示,内容原始要素可以划分为几个维度:其中视觉描述包括人物特征与行为、环境信息、物品信息等,文本信息包括语音、字幕、画面文字等,并进行实体抽取来提炼相关信息;

第二步,是基于规则信息的证据链构建,又包括单维度证据(比如纯文字的违规)和多维度信息组合违规证据(比如画面展示了昏暗的夜店场景,配合「招聘 / 工资」等封面文字信息,就很容易产生不良联想(事实上这类内容也正是「色情招嫖」风险的普遍玩法)

最后一步是反思修正,因为我们知道大模型尤其在有一定先验的情况下,很容易出现幻觉,所以需要通过反思回溯,来对其逻辑合理性和上下文一致性进行校验;这里我们同时设定了正向和反向两种模式,正向用于补充遗漏,反向用于检查矛盾点。

以上三阶段标注任务,是从易到难,从客观到主观的过程,来逐步引导和收集人工反馈,相比常规模型输出的、非结构化的大段推理思考文字,这种方式更有助于获取高置信的训练数据;

以上,我们已经介绍了大模型智能体的应用模式以及核心的算法优化方式;然而智能体在业务场景的实际落地,远远不止是一个「大模型应用」;引用 Rokesh Gohel 提出的「大模型智能体冰山模型」这个概念 – Agent = 10% 的 AI + 90% 的软件工程:大模型只能解决「理解任务、规划路径、生成结果」这类大脑思考执行的问题;而软件工程则是支撑整个智能体工作的「身体部件和神经系统」,控制着用户交互、任务编排、数据流转、工具调用、日志监控、异常回滚等等工作;因此下面我们也会重点介绍这套应用框架底层的技术链路是如何设计实现的;

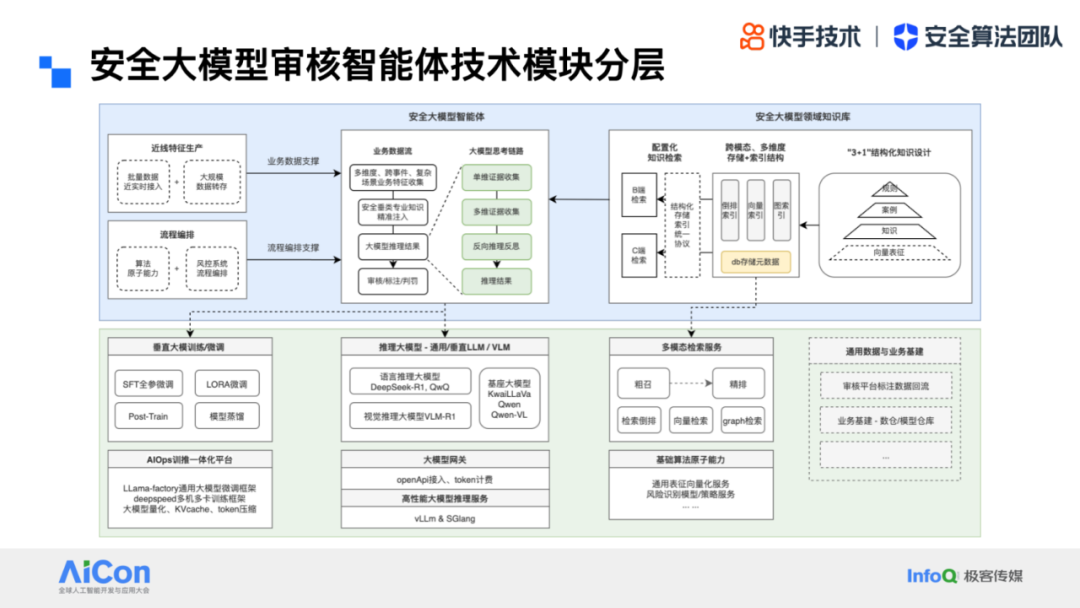

下图示意了安全大模型智能体的几个核心技术模块,并进行了架构层次的划分:

整体上是以安全大模型智能体的业务应用链路为中心,「业务数据流」和「大模型推理链」,在上面已经介绍过了,这里不再赘述;左上部分是智能体所关联的风控业务系统模块,包括「近线特征引擎」和「流程编排引擎」;我们前面提到内容安全场景下所依赖的数据交互与判罚处置等,具有大流量、高实时、长链路、计算复杂度高等特点,需要严格绑定风控系统的特征引擎与流程引擎来实现,才能保证高可靠性;右上部分的应用组件,是安全大模型智能体所依赖的安全领域结构化知识库,从顶层业务规则,到领域知识点,到审核案例沉淀,都需要持续的运营迭代,以保证数据安全性与正确性;同时我们也设计了一套多模态多维度的存储 + 索引结构(包括通用的文本分词倒排索引、多模态表征向量索引、以及人物 - 事件等关系知识图谱的图索引,同时对应下面基建层的粗排 + 混排检索策略)使得知识与模型之间的交互更加高效和精准;

底层是支撑安全大模型应用的系统基建层;偏业务接口的上一层主要是模型服务,以及数据回流模型迭代的交互,包括垂直大模型的训练 / 微调 / 和推理服务以及多模态检索服务;最底层是系统支撑,包括训推一体化平台以及大模型网关等基础设施,我们封装了一系列业界通用的训推优化工具库,以及自研的面向业务定制的模型性能优化能力。

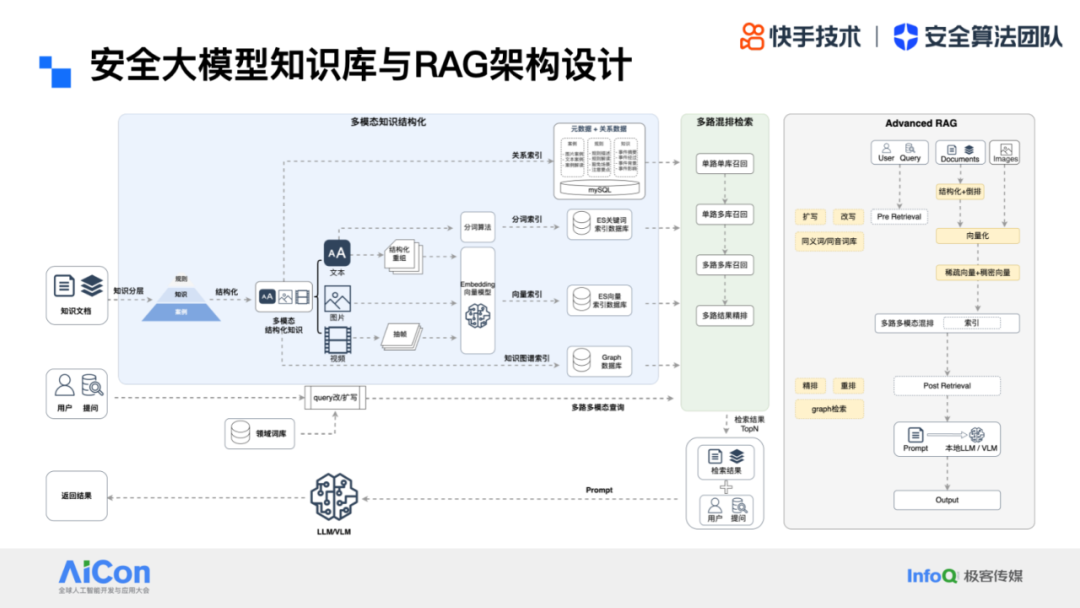

最后聚焦到整个系统中业务定制属性最强的「安全大模型知识库与 RAG 架构」模块上;

我们的安全领域知识库与业界通用知识库最大区别在于:通用知识库对于知识的结构,全部采用的是非结构化设计:将输入内容,按照不同的原则进行切割,形成一个一个的知识片段,然后再进行存储。例如通过固定 token 长度,或者通过标点符号分割。这样的知识切割方式会导致知识的运维成本很高,很难去做更新和迭代,知识检索的准确率难以保证。所以在内容安全场景下,对所有的知识都做了结构化处理;

多模态知识结构化核心解决的是满足风控业务场景下多模态知识需要进行「强知识管理」的诉求:

首先是基于业务特点对「知识分层管理」,形成以平台规则为中心,围绕规则来关联相关知识点与案例,作为对规则进一步解读的逻辑结构,这样的结构为知识的长期可维护性打下基础,同时规则 / 案例 / 知识之间的管理关系作为关键索引信息,也为后续的检索召回打下数据基础;

基于知识分层的结果,在每一层进行「知识结构化管理」,结构化一方面便于运营进行平台化管理运营,保证知识内容的准确性,另一方面便于进行结构化切分,避免文本切分参数带来的准确率损失,这也是常见于通用 RAG 知识库检索召回与准确上的两个重要的缺陷来源

结构化知识同时需要支持「多模态」,且需要是面向对象的多模态存储与关系索引,也就是不同模态间需要有关联关系,指向同一个对象,比如一个违规的案例,所涉及的物料,会同时包含图文信息,这样的存储与索引结构是支持后续检索层面进行多路多模态检索

最后一点是「知识图谱结构」,为了应对隐晦、对抗场景下的知识检索漏召问题,通过知识图谱构建事件、人物、组织等实体间的关系,可以支撑在知识检索时除了直接检索外,更能挖掘深层次的关联信息,找到隐层的风险;

为了更好的适配风控业务场景,从多模态知识结构化角度出发,知识库引入了「多模态多索引」以及「多路混排检索增强」的技术架构;设计思路上按照「松耦合高内聚」的思想,在原子粒度的多模态检索层面,采用高内聚的检索策略;在逻辑层的多路多库检索层面,采用松耦合的多层结构设计;

基于以上的底层知识库架构,我们同样升级了「Advanced RAG」框架,来保障更好的大模型检索增强效果;如图所示,白色模块为基础 RAG 组件,黄色模块则是我们为多模态结构化知识库所做的适配:

「索引构建」模块包含了通用的文本分词倒排索引、多模态表征向量索引、以及人物 - 事件等关系知识图谱的图索引,作为多模态粗排 + 混排检索策略的底层支撑

「前置检索(Pre-Retrieval)」模块,增加了 query 改写与扩写组件(可调用同义 / 音近 / 形近词库等),用于应对风控场景原始物料的对抗变体

「后置检索(Post-Retrieval)」模块,封装了精排、混排、以及图检索等组件,保证对多模态结构化信息的充分利用,同时支持对不同信号源的加权操作,提供更加灵活的检索策略配置

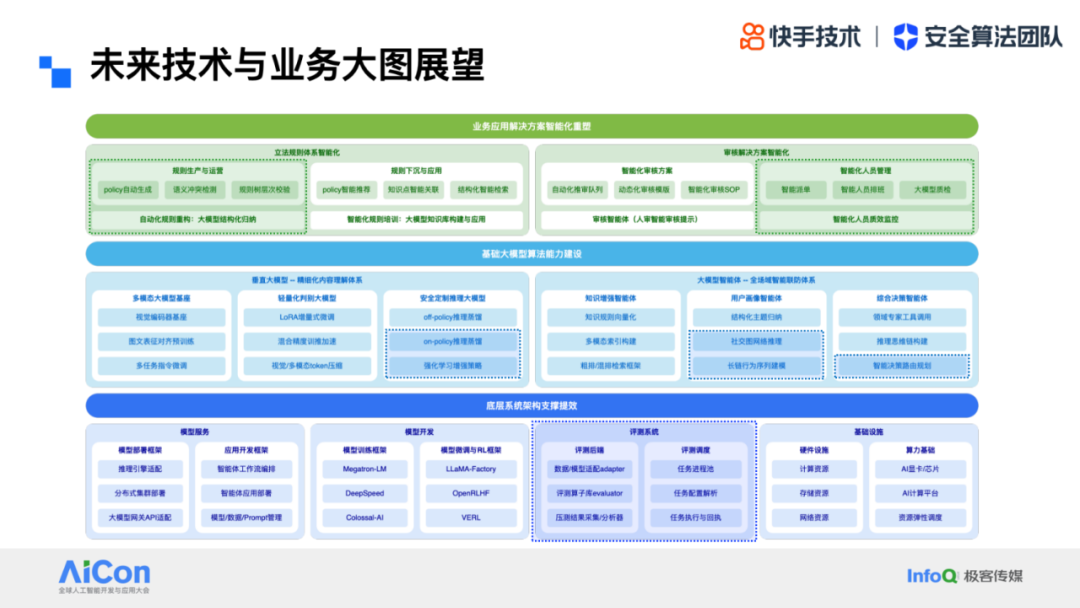

以上,是对安全大模型核心技术与应用的一个全面概要介绍;我们对未来业务领域应用大模型的大图展望如下:

在业务解决方案层,我们会进一步深入到立法即规则体系的智能化建设中,实现规则生产与运营、下沉与应用的全面自动化,并通过智能化的审核方案和流程,赋能更灵活高效的人员质效管理

在基础能力建设层,需要寻求比内容审核更广泛的应用场景,比如针对平台用户画像和生产 / 消费 / 社交行为的大模型智能画像,看清内容背后的人群,从而更好的保证平台生态与体验

在系统架构支撑层,模型性能与应用效果的评估至关重要,我们需要持续建设更高效的评测系统和流程,保证解决方案更好的落地,同时也期望能横向扩展到更多其他的垂直业务场景

主要参考文献

【1】The Evolution of Multimodal Model Architectures. ArXiv 2024.

【2】A Survey on Model Compression for Large Language Models. ACL 2024.

【3】https://www.linkedin.com/in/rakeshgohel01/recent-activity/images/

讲师介绍

刘梦怡,快手安全线算法中心负责人,负责快手主站安全算法研发以及自研安全大模型应用落地;于 2017 年在中国科学院计算技术研究所取得博士学位,长期从事深度学习、计算机视觉、多模态内容理解等 AI 核心领域的算法研发与技术产品化应用,已在国际顶级会议与期刊发表数十篇学术论文。