“你们站在天才的肩膀上,还不知结果如何就急于完成一切。申请专利、打包上架,在午餐盒上发广告。然后就是卖钱,马上变现。”

这句话出自《侏罗纪公园》中备受欢迎的角色马尔科姆博士。尽管他在电影中指的是科研人员匆忙复活极度危险的恐龙,但在如今的人工智能热潮中,同样的观点似乎仍然适用。

实际上,目前的人工智能局势可能比《侏罗纪公园》中更为危险。在电影中,科学家们复活的恐龙至少被控制在几个岛屿上,并由一家公司管理。然而,现实中的 AI "怪兽"却无处不在,无论是在可见还是触及的范围内,人人都能感受到它的存在。

距离 ChatGPT 发布已经过去了半年多,AI 驱动的浏览器扩展程序迅猛发展。在 Chrome Web Store 中搜索“AI”,屏幕上会显示出密密麻麻的数百个选项,让人眼花缭乱。

这些浏览器扩展的功能各不相同:有些可以帮助用户总结网页和电子邮件,有些可以快速生成文章或产品描述,甚至还有一些可以将纯文本转化为代码。

然而,这些 AI 浏览器扩展也带来了各种安全风险。有些扩展本身就是恶意软件,借 AI 之名窃取用户数据;还有一些通过复制粘贴隐私策略来进行隐秘操作;当然,也有一些来自备受尊重和认可的品牌厂商。

本文将重点关注员工如何使用 AI 技术,企业又该怎样管理这种技术渗透。我们将讨论三种常规安全风险类别,并探讨价值评估和应用限制方面的最佳实践。

确实,大语言模型(LLM)并不是真正的人工智能,因为它们本身并不具备真正的智能。但这里我们故且沿用这个不准确的表述。

我们并不是真的将 LLM 比作恐龙,实际上,将人们关注点转移到无意义的 AI 末世论上,只会分散人们对现实数据安全和就业风险的关注。这纯粹是个比喻。

恶意软件冒充 AI 浏览器扩展

AI 浏览器扩展带来的头号风险,在于其中不少程序本身就是恶意软件。

3 月 8 日,Guardio 报告称名为“快速访问 ChatGPT”的 Chrome 扩展程序会劫持用户的 Facebook 账户,并窃取“存储在浏览器中的所有 cookies——包括安全和会话令牌……”。更糟糕的是,尽管该扩展仅在 Chrome 商店上架一周,但每天仍有超 2000 用户下载。

作为对报告的回应,谷歌删除了这款扩展,但更多扩展仍在不断涌现。而且各大主要平台似乎也没有监管这部分新技术的意愿或者能力。Guardio 在报告中称,此次恶意扩展本应为谷歌和 Facebook 敲响警钟,但他们却毫无反应。

这种对犯罪分子放任自流的态度可能会让这些巨头的用户感到震惊,因为人们天然认为能在 Chrome 商店上架的产品至少是通过了某种质量控制渡。引用 Guardio 报告中的说法,此次事件“给我们以往盲目信任大公司和知名品牌,把大部分线上活动无脑交给他们的行为狠狠打了一记耳光”。

更令人不安的是,基于 AI 的恶意扩展往往把自己伪装成合法产品,毕竟接入 ChatGPT API 没啥门槛。传统意义上的恶意软件相对更容易发现,因为一旦发现下载的软件无法工作,用户马上就会意识到自己上了当。但 AI 时代下恶意软件可以舒舒服服躺在浏览器中,一边窃取数据一边正常提供 AI 功能。

合法 AI 扩展的安全风险

即使是最铁杆的 AI 支持者,也不能否认恶意浏览器扩展带来的风险。我们应当尽一切努力劝阻人们盲目下载。

但说到合法 AI 浏览器扩展中的安全风险时,情况往往变得更复杂且充满争议。

以下是一些潜在的安全问题:

共享给生成式 AI 工具的敏感数据,可能被纳入训练数据、甚至被其他用户看到。

我们讲个简单的小故事:假设你是一位企业高管,想给战略报告中加点料,所以使用 AI 驱动的浏览器扩展对文本做了润色。第二天,最大竞争对手的另一位高管要求 AI 猜测你们公司的战略是什么,接触过报告内容的 AI 很快给出了极为详尽且逻辑完整的答案!

对此类泄密的担忧,已经促使 Verizon、亚马逊和苹果明令禁止或严格限制员工使用生成式 AI。The Verge 在讨论苹果禁令的文章中指出,“考虑到 ChatGPT 在改进代码和启发思路等场景下拥有良好效果,苹果确有理由担心员工将机密项目的信息输入该系统。”

浏览器扩展或 AI 企业本身面临数据泄露风险。

公平地讲,任何一家合作供应商都无法彻底回避安全风险。但需要注意的是,行业中的龙头之一已经掉过坑。今年 3 月,OpenAI 宣布发现一个 bug,“导致某些用户会看到其他活跃用户聊天记录中的标题”,“某些用户会看到其他活跃用户的姓名、电子邮件地址、寄送地址”等付款信息。

浏览器扩展的脆弱水平,取决于它们到底掌握着多少用户数据。即使是那些最“受人尊重”的扩展,在这个问题上也往往表现得含糊不清。

版权、抄袭和法律问题仍是一团乱麻。

从 GitHub Copilot 首次亮相的那一刻起,版权、抄袭和法律问题就始终悬在其头顶。LLM 经常会生成与人类原作者高度相似的图片、文本和代码。目前还没有法律条款明确规定这是否构成侵权,但其中的危险相信大家都感受得到。另外还有输出代码本身的质量问题——LLM 经常胡写一通,甚至照搬众所周知的安全漏洞。

这些问题已经非常严重,因此 6 月 5 日 Stack Overflow 的志愿者版主们甚至举行了罢工,抗议该平台接收 AI 生成内容的决定。版主们在一封公开信中写道,AI 将导致“不正确信息(即「幻觉」)和肆意剽窃的全面扩散。”

AI 开发者当然在努力缓解这些风险,但这是一条全新的赛道,对是非对错的区分在这里已经构成艰难的挑战。

即使是像 fireflies 这类得到广泛使用的会议与视频转录扩展程序,也列出了“责任自负”的服务条款。他们要求用户自己负责保证其内容不违反任何规则,并承诺自行采取“合理的方式来保护此类数据的隐私和安全”。但这种冷冰冰的条文只会引起人们对于缺乏问责制的更多担忧。总之情况就是这么个情况,用不用在你自己。

AI 的“无解”威胁:即时注入攻击

最后,咱们聊聊最为可怕的一种新兴威胁:网站通过接入的 AI 工具窃取数据。

5 月 19 日,Twitter 上出现了关于此类滥用的首个案例。

这似乎是多款插件(WebPilot 与 Zapier)的首个概念证明,可通过相互组合的方式借由提示词注入攻击泄露私人数据。关于此次攻击的更多细节请参阅: https://t.co/R7L0w4Vh4l https://t.co/2XWHA5JiQx — Simon Willison (@simonw) 2023 年 5 月 19 日

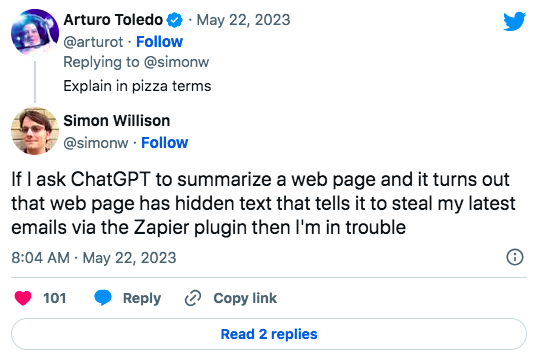

如果这种纯原理表述不够清楚,Willison 又做出进一步解释。

类似于我要求 ChatGPT 总结某个网页的内容,结果发现该网页中存在隐藏文本,会通过 Zapier 插件窃取我的最新邮件内容。— Simon Willison (@simonw) 2023 年 5 月 22 日

从 LLM 的固有特性来看,这类提示词注入攻击似乎永远无法消除。简而言之:LLM 的基本用法就是根据输入的内容自动做出下一步决策。但如果这些输入本身就存在恶意,那 LLM 可能在诱导之下做出任何举动,甚至包括开发团队明确禁止的行为。

目前还很难评估这种威胁会给数据治理和安全带来怎样的深远影响。但着眼于当下,无论从 LLM、扩展还是插件的安全性还是负责任态度来看,威胁都已经客观存在。

面对风险,唯一真正安全的选择就是:永远不要将联网 AI 接入关键服务或数据源。在诱导之下,AI 可能输出任何它访问过的东西,而且这个问题根本就没有已知有效的解决方案。在答案出现之前,企业和员工都应当保持谨慎。

定义哪些是“关键”数据和应用,并在制定政策时与员工充分沟通。这些应当成为任何 AI 项目的基本前提。

该为员工制定哪些 AI 政策?

AI 革命爆发于一夜之间,我们还在适应这个美丽新世界。每一天,我们都了解到这项技术的更多应用——有好的、有坏的,也有种种令人畏惧的应用。不同行业的企业也因此面临着巨大压力,思考如何将 AI 科技融入自身业务。在这样的巨变背景之下,一时找不到方向也很正常。

但作为负责制定 AI 政策的管理者,大家必须抓紧时间、尽快为员工的 AI 工具使用方式提供明确指导。

首先,可以采取多种途径管理员工的 AI 工具使用行为。比如像苹果那样一刀切全面禁止,但这种办法对于想要鼓励员工探索 AI 潜力的公司来说太过极端。确实,在践行良好安全性的同时拥抱创新,无疑是项颇为棘手的工作。浏览器扩展就是最典型的例子——它们本质是对外的,通常默认处于启用状态。如果想要对这些扩展张开怀抱,我们至少需要遵循下列最佳实践。

员工教育:AI 扩展就像是刚从蛋里孵出的小恐龙,看似可爱但却需要审慎对待。而这一切,都要以员工教育为起点。大多数员工并没有意识到这些工具背后的安全风险,也不知道如何甄别扩展选项、可以共享哪些数据。管理者必须就这些风险开展员工教育,指导他们学会区分恶意产品与合法产品。

白名单:即使完成了前期培训,我们也不能指望员工像专家那样熟悉各类扩展程序的隐私政策。因此,最安全的选择是根据具体情况将部分扩展列入白名单。哪怕无法彻底禁绝风险,我们也至少该从中挑选出相对更安全的选项,这也能避免员工因行动受限而选择影子 IT 这种更难管理的路线。在挑选扩展时,务必选择那些明确承诺不会将用户数据输入其模型的产品。

可观测性和零信任访问:如果不清楚员工正在使用哪些扩展,那就没办法采取措施保护公司免受 AI 扩展的影响。为此,IT 团队必须有能力查验公司内各团队,检测他们在使用哪些扩展。以此为基础,下一步就是自动阻止安装了恶意扩展的设备访问公司资源。

我们在 Kolide 也采取了这样的方法。我们为 GitHub Copilot 编写了一个 Check,用于检测设备上是否安装有 Copilot 并阻止其通过身份验证。管理员还可以编写自定义检查,根据实际需求阻止个别扩展。同样的,简单的阻断显然不会是管理政策的最终形态,管理者应该就选择工具的原因、有没有更安全的替代选项等问题与员工主动对话。

但如果之前就检测并阻断了用户安装的扩展程序,那双方的对话过程难免会有些尴尬。Kolide 公司 CEO Jason Meller 曾专门撰文讨论过这个问题:“对大多数团队来说,帮助最终用户带来的一点点好处,不足以驱使他们冒险跟对方撕破脸。”但这种拒绝与最终用户深度交流的习惯也给恶意软件创造了温床:“正因为很少有安全团队与最终用户建立起稳固的信任关系,恶意软件作者才得以利用这种沉默、获得突破口,最终造成严重破坏。”

原文链接:

https://www.kolide.com/blog/ai-browser-extensions-are-a-security-nightmare