3 月 6 日,阿里云团队正式开源全新推理模型——通义千问 QwQ-32B。摩尔线程在该模型发布后 2 小时内,迅速且高效完成了对千问 QwQ-32B 的支持。基于大语言模型高速推理框架 vLLM 以及 MT Transformer 推理引擎部署的 QwQ-32B,在实际运行中的推理性能与稳定性均表现优异。

图注:摩尔线程模型广场“夸娥工场”体验界面

摩尔线程将这一成果开放上线至模型广场“夸娥工场”。夸娥工场是摩尔线程倾力打造的模型展示中心,旨在为用户提供基于摩尔线程夸娥(KUAE)智算集群支持的模型能力体验。用户通过访问夸娥工场或点击“阅读原文”,即可体验 QwQ-32B 强大的推理模型性能与创新技术。

夸娥工场体验地址:https://playground.mthreads.com

QwQ-32B 体验地址:https://playground.mthreads.com:12019

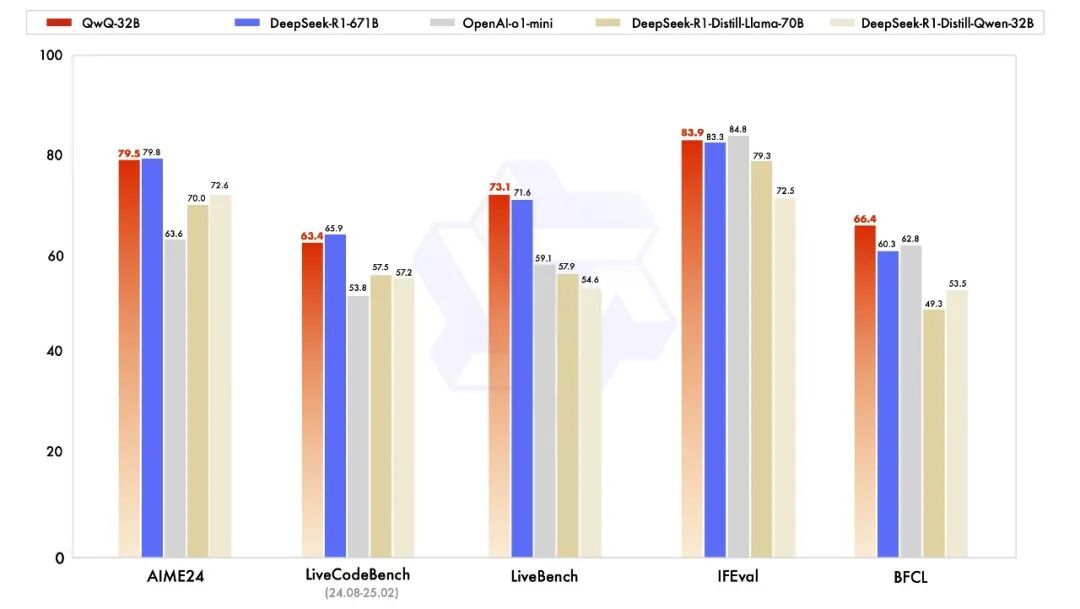

千问 QwQ-32B 是阿里探索推理模型的最新成果。在一系列权威基准测试中,千问 QwQ-32B 模型表现异常出色,几乎完全超越了 OpenAI-o1-mini,比肩最强开源推理模型 DeepSeek-R1。尽管该模型仅包含 32B 参数,但通过大规模强化学习训练,其在数学、编程及通用能力等领域实现了显著突破,展现了卓越的智能化水平。

图注:官方发布的 benchmark 测试对比图

从官方发布的 benchmark 测试对比图中可以清晰地看到,QwQ-32B 在各项测试中成绩显著高于 OpenAI-o1-mini 及 Deepseek 的各个蒸馏版本。在 LiveBench 与 BFCL 测试中甚至击败了满血版的 Deepseek-R1-671B。

从 DeepSeek 一系列模型的问世,到阿里云通义千问 QwQ-32B 的发布,这些开源大模型降低了开发门槛,激发了开源社区创新活力,极大地推动了 AI 技术的普及与发展。它们用实打实的表现证明,开源大模型凭借其强大的性能和灵活性,正在突破传统技术局限,成为不可阻挡的发展趋势。

摩尔线程积极响应开源社区的号召,旨在赋能更多开发者基于国产全功能 GPU 进行 AI 应用创新。摩尔线程仅用一周时间就火速支持了DeepSeek开源周“全家桶”,对千问 QwQ-32B 更实现了 Day0 级支持,充分验证了摩尔线程先进 MUSA 架构和全功能 GPU 的技术成熟度。

摩尔线程 GitHub 开源社区:https://github.com/MooreThreads