LlamaFirewall是一个安全框架,旨在保护 AI Agent 免受提示注入、目标错位和不安全代码生成的威胁。在 AgentDojo 基准测试中,它在降低攻击成功率方面实现了超过 90%的效果。此外,开发人员可以通过添加新的安全护栏来更新其行为。

LlamaFirewall 是一个实时护栏监控器,作为抵御与 AI 代理相关的安全风险的最后一道防线。它包括三个保护层:PromptGuard 2,一个通用的越狱保护器;Agent Alignment Checks,一个思维链审计器,检查代理推理以识别提示注入和目标错位问题;以及 CodeShield,一个在线静态分析引擎,防止编码代理生成不安全或危险的代码。

PromptGuard 2 是一个经过微调的 BERT 风格的模型,用于检测越狱尝试,能够实时分析用户提示和不受信任的数据源。它特别针对越狱策略,如指令覆盖和令牌注入。

这些技术通常是明确的、重复的和模式丰富的,使它们更适合基于模式的检测方法。与目标劫持攻击相比,越狱行为因为其模式化和可预测性,容易被新手攻击者或自动化工具利用,作为攻击的起点。

与前代产品相比,PromptGuard 2 为 86M 参数变体带来了性能提升,为轻量级 22M 参数变体降低了延迟。

AlignmentCheck 是一个实验性的思维链审计器,检查代理的推理以识别目标劫持或错位迹象。

它不是检查单个消息,而是对整个执行轨迹进行推理,标记那些暗示隐蔽提示注入、误导工具输出或其他形式的目标劫持偏差。

Meta 的研究人员称,这是第一个能够实时审计大语言模型思维链的开源防护工具,专门用于防御注入攻击。

CodeShield 是一个针对 LLM 生成代码的在线静态分析引擎,支持 Semgrep 和基于正则表达式的规则。它可扩展,可以与八种编程语言的语法感知模式匹配,以检测潜在风险。最初作为 Llama 3 发布的一部分,CodeShield 现在已集成到 LlamaFirewall 中。

尽管 CodeShield 能够识别广泛的不安全代码模式,但它并不全面,可能会遗漏一些微妙的或依赖于上下文的漏洞。其检测效能已在 CyberSecEval3 中进行了评估,识别不安全代码的精确度达到了 96%,召回率为 79%。

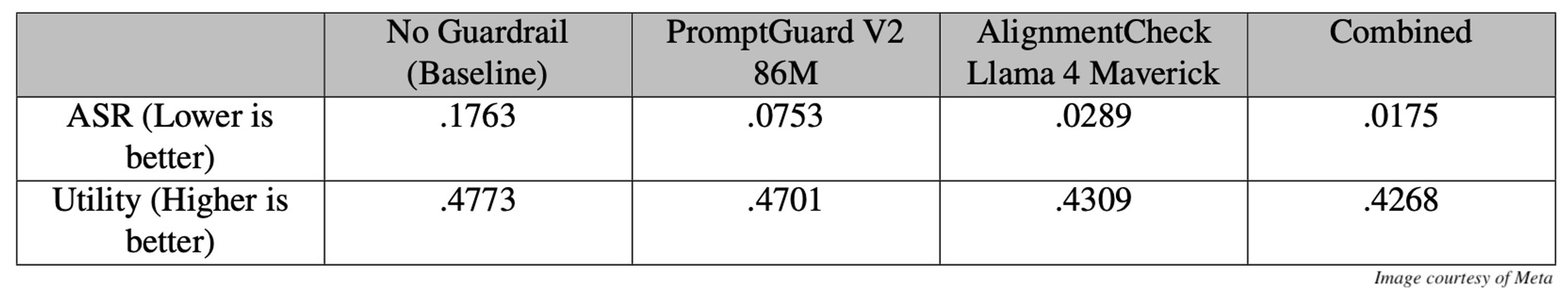

PromptGuard 和 AlignmentCheck 的联合使用提高了在 AgentDojo 基准测试中的表现。此外,Meta 的研究人员建议,这种组合在 AgentDojo 覆盖范围之外的更多样化或更具普遍性的对抗场景中可能会取得更好的结果。

Meta 的研究人员描述了两个工作流程,展示了如何将 LlamaFirewall 集成到代理系统中。在第一种场景中,一个旅行规划代理使用 PromptGuard 扫描网络内容(如旅行评论)中的越狱式措辞,并丢弃可疑页面。同时,AlignmentCheck 监控代理的令牌流,以检测目标是否偏离旅行规划,如果是,则停止执行。

在第二种场景中,编码代理根据开发人员的输入生成 SQL 代码。代理从网络检索示例,并使用 CodeShield 进行检查,直到找到正确的解决方案。

LlamaFirewall 的开发将继续在多个方向上推进,包括支持多模态代理、降低延迟、扩大威胁覆盖范围以及进行更贴合实际的基准测试。

原文链接:

https://www.infoq.com/news/2025/05/llamafirewall-agent-protection/