在2025年的PyTorch大会上,PyTorch 基金会宣布了几项举措,旨在推动开放、可扩展的 AI 基础设施建设。分布式计算框架 Ray 作为一个托管项目加入PyTorch 基金会。基金会还宣布了一个新框架PyTorch Monarch,旨在简化跨多台机器的分布式 AI 工作负载。该活动还重点介绍了全新的开放研究项目,包括斯坦福大学的Marin和AI2的Olmo-Thinking,突显了基础模型开发对透明度和可复现性日益增长的推动力。

Ray 的加入反映了基金会更广泛的战略布局——旨在构建一个统一的开放式生态系统,涵盖模型开发、服务和分布式执行。Ray 最初是在加州大学伯克利分校的 RISELab 开发的,它提供了一套简洁的 Python 原语,使得分布式计算像编写本地代码一样直观,使开发者能够无缝地扩展到训练、调优和推理工作负载。

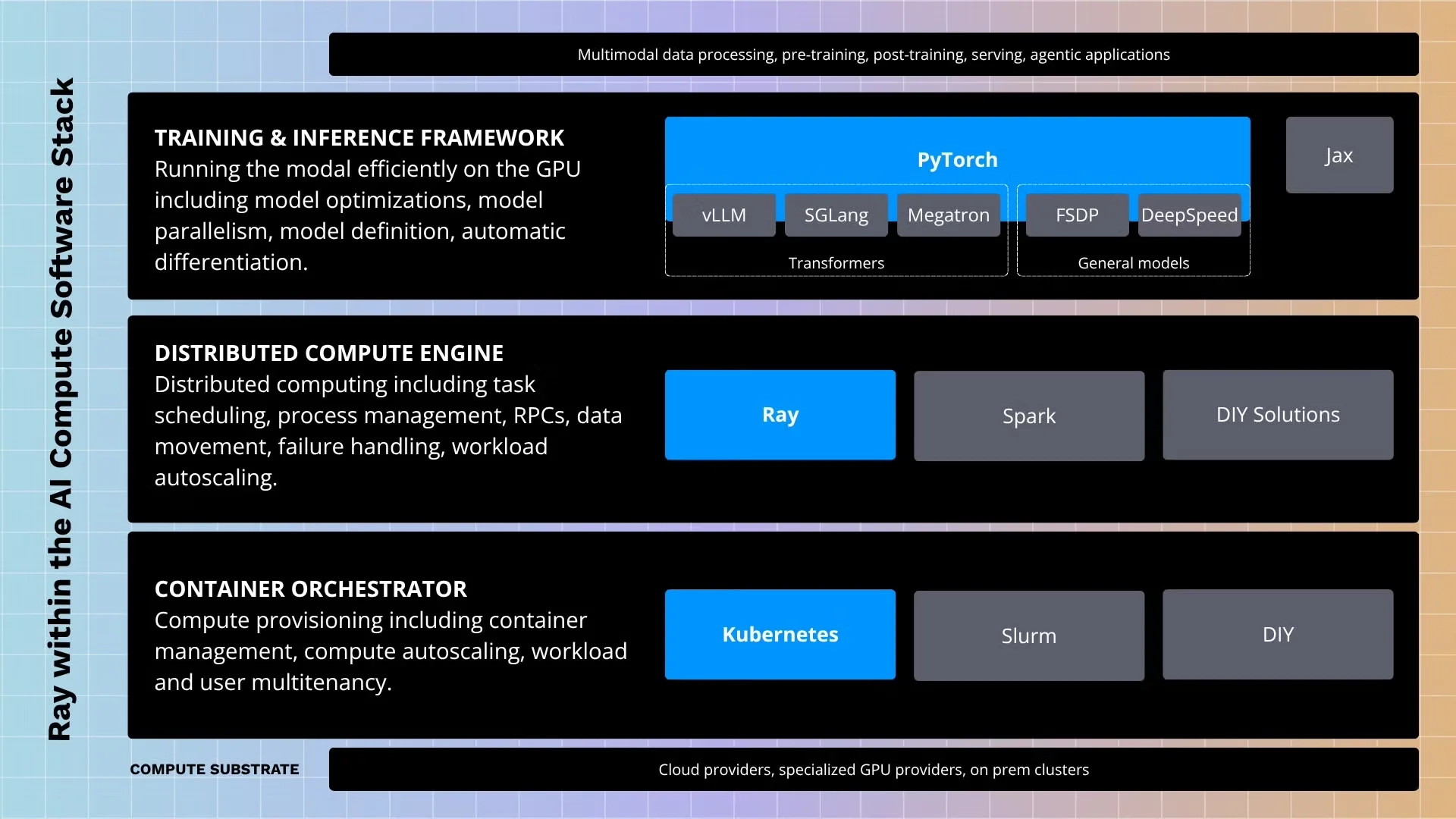

对于最近加入 PyTorch 基金会的其他项目,包括用于分布式训练的DeepSpeed和用于高吞吐量推理的vLLM,Ray 的加入是一个很好补充。PyTorch、DeepSpeed、vLLM 和 Ray 共同构成了一个连贯的开源技术栈,覆盖了从实验到生产规模部署的整个模型生命周期。

图片来源:PyTorch基金会博客

同时,Meta PyTorch 团队推出了 PyTorch Monarch。这是一个旨在将整个 GPU 集群抽象为单个逻辑设备的框架。Monarch 提供了类似数组的网格接口,允许开发者使用 Pythonic 结构表达并行性,而数据和计算分布由系统自动管理。Monarch 的后端基于 Rust 构建,旨在将性能与安全性结为一体,减少分布式编程的认知负担。

大会进一步强调了在基础模型开发和研究中的开放合作。在主题演讲中,斯坦福大学的 Percy Liang 介绍了Marin,这是一个设在基础模型研究中心下的开放实验室。该实验室致力于通过公开数据集、代码、超参数及训练日志,实现前沿人工智能研发的完全透明化,从而保障研究的可重复性并促进社区参与。

同样,Ai2 高级研究科学家 Nathan Lambert 介绍了Olmo-Thinking。这是一个开放式推理模型,其训练过程、模型架构决策、数据来源和训练代码设计的细节都已经公布,而在封闭模型发布中,这些信息通常都是不公开的。这些举措很好地契合了推动基础模型开放与可复现的广泛趋势。

通过将工作范围扩展至核心框架开发之外,PyTorch 基金会正致力于成为开放式人工智能基础设施的核心枢纽。即将于 2026 年在圣何塞举办的 PyTorch 大会,预计会继续聚焦生态系统协作与开发者赋能。

声明:本文为 InfoQ 翻译,未经许可禁止转载。

原文链接:https://www.infoq.com/news/2025/10/pytorch-conf-ray-monarch/