近日,明尼苏达大学科学与工程学院的一组研究人员展示了一种数据永远不会离开内存的新模型,称为计算随机存取存储器(CRAM)。与目前的方法相比,它可以将人工智能应用的能源需求降低 1,000 倍甚至更多。在一次模拟中,CRAM 技术显示出令人难以置信的 2,500 倍节能效果。

论文地址:

https://www.nature.com/articles/s44335-024-00003-3

怎么做到的?

众所周知,传统计算依赖于已有数十年历史的冯·诺依曼架构,该架构由独立的处理器和内存单元组成,需要不断来回移动数据,这是一个耗能过程。

明尼苏达团队的 CRAM 完全颠覆了该模型,使用称为磁隧道结 (MTJ) 的自旋电子器件直接在内存内部进行计算。自旋电子设备并不依赖电荷来存储数据,而是利用电子自旋,为传统的基于晶体管的芯片提供了更有效的替代品。

“作为一种极其节能的数字内存计算基板,CRAM 非常灵活,可以在内存阵列的任何位置执行计算。因此,我们可以重新配置 CRAM,来最好地满足各种 AI 算法的性能需求,”计算架构专家、论文合著者、明尼苏达大学电气与计算机工程系副教授 Ulya Karpuzcu 表示。“它比当今 AI 系统的传统构建块更节能。”

Karpuzcu 解释道,CRAM 直接在存储单元内执行计算,有效利用阵列结构,从而无需缓慢且耗能的数据传输。

据介绍,最高效的短期随机存取存储器 (RAM) 设备使用四到五个晶体管来编码 1 或 0,但 MTJ 可以以极低的能量执行相同的功能,速度更快,并且能够适应恶劣环境。自旋电子器件利用电子自旋而不是电荷来存储数据,为传统基于晶体管的芯片提供了更高效的替代方案。

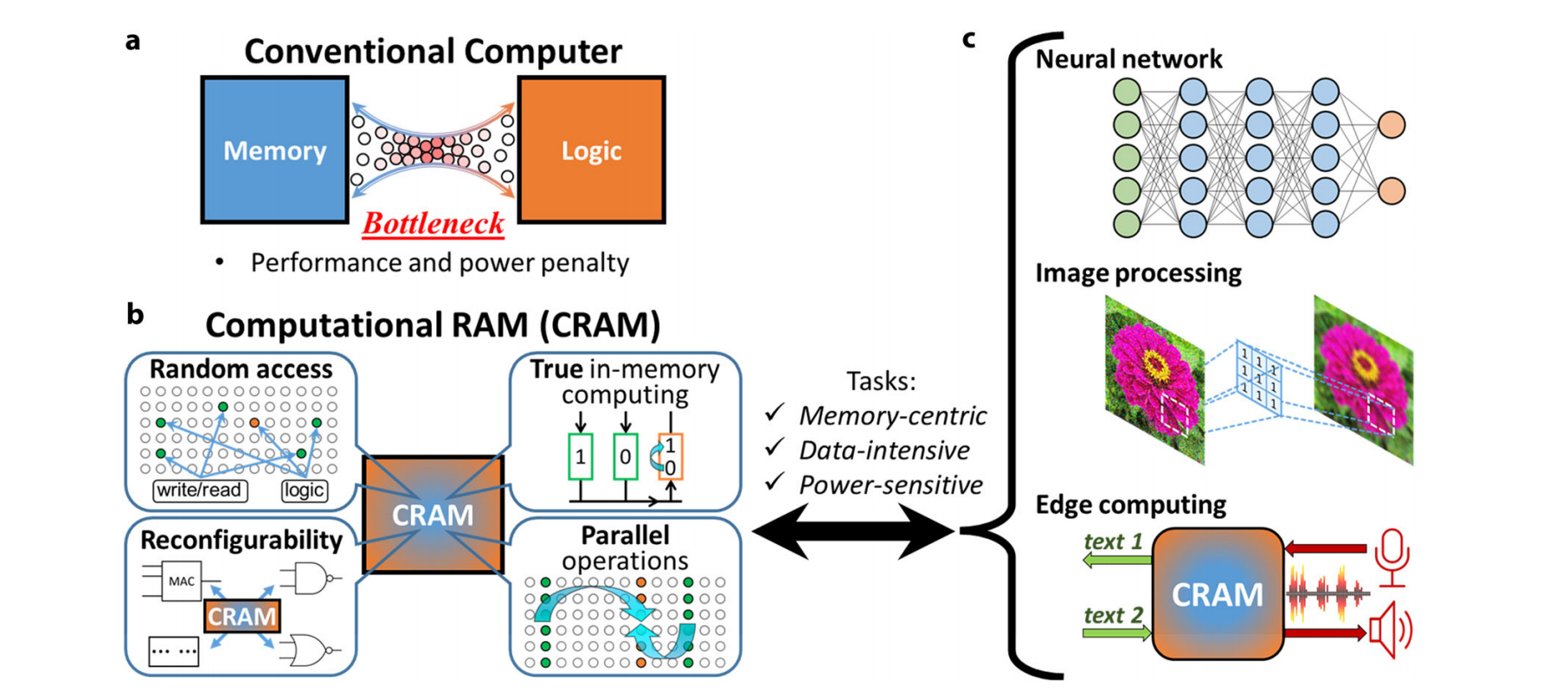

受内存逻辑传输瓶颈困扰的传统计算机架构 (a) 与 CRAM (b) 对比

CRAM 架构实现了真正的在内存中进行计算,打破了传统冯·诺依曼架构中计算与内存之间的瓶颈。这种“内存中计算”(in-memory computing)的方法,通过消除逻辑和内存之间耗电的数据传输,尤其适用于需要大量数据并行处理的应用,如深度学习、图像处理和大数据分析。

研究人员估计,基于 CRAM 的机器学习推理加速器在能量延迟积方面比最先进的解决方案实现了 1000 倍的改进。另一个例子表明,CRAM(在 10 nm 技术节点)执行 MNIST 手写数字分类器任务分别消耗 0.47 µJ 和 434 ns 的能量和时间,与 16 nm 技术节点的近内存处理系统相比,它的能量和时间分别减少了 2500 倍和 1700 倍。

明尼苏达大学电气与计算机工程系博士后研究员、论文第一作者杨吕说:“这项工作是 CRAM 的首次实验演示,其中数据可以完全在存储器阵列内处理,而无需离开计算机存储信息的网格。”

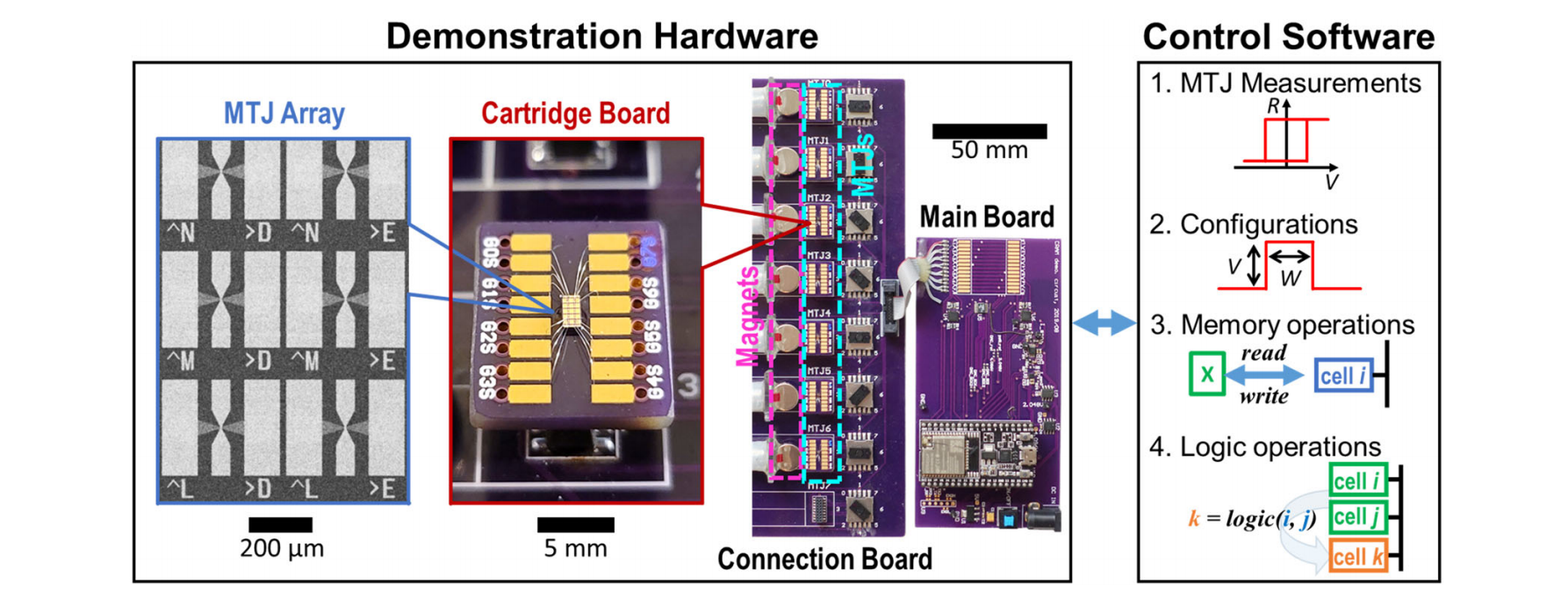

CRAM 实验装置,该装置由定制硬件和控制软件套件组成

CRAM 以全数字化方式运行,与报道的其他大多数内存计算方案不同,后者部分或大部分是模拟的。CRAM 还具有独特的附加功能,例如数据和操作数的随机访问、大规模并行计算能力以及操作的可重构性。

另外,尽管大多数以前的内存计算范例所采用的无晶体管(交叉开关)架构支持更高的密度,但由于潜行路径问题,内存阵列的大小通常受到严重限制。CRAM 在其每个单元中都包含晶体管,以此来实现更好的可访问性,因此阵列尺寸更大。

类似这种原型的 CRAM 技术对于在人工智能能源需求激增的时代大幅提高其能源效率至关重要。

国际能源署 3 月份预测,全球用于人工智能训练和应用的电力消耗可能会增长一倍以上,从 2022 年的 460 太瓦时增至 2026 年的 1,000 多太瓦时——几乎相当于日本全国的用电量。

国外研究报告显示,ChatGPT 每天要响应大约 2 亿个请求,在此过程中消耗超过 50 万度电力,即 ChatGPT 每天用电量相当于 1.7 万个美国家庭的用电量。而随着生成式 AI 的广泛应用,预计到 2027 年,整个人工智能行业每年将消耗 85-134 太瓦时(1 太瓦时=10 亿千瓦时)的电力。

研究人员 2023 年 10 月 10 日在《Joule》上发布的论文显示,在 AI 技术加持下,传统互联网运行的耗电量会成倍数增长。论文数据显示,一次标准谷歌搜索耗电 0.3 瓦时,AI 大语言模型 ChatGPT 响应一次用户请求耗电约 2.96 瓦时,在 AI 大模型驱动下的一次谷歌搜索则耗电 8.9 瓦时。

除了耗电,和 ChatGPT 或其他生成式 AI 聊天,也会消耗水资源。加州大学河滨分校研究显示,ChatGPT 每与用户交流 25-50 个问题,就可消耗 500 毫升的水。而 ChatGPT 有超过 1 亿的活跃用户,这背后消耗的水资源无疑是令人震惊的。

CRAM 的千倍能耗降低能力,显然有助于解决越来越被关注的 AI 耗能问题。

背后功臣:一位美籍华人的科研梦想与现实挑战

研究人员表示,这项研究已经进行了二十多年, “我们 20 年前直接使用存储单元进行计算的最初想法被认为是疯狂的”,该论文的资深作者、明尼苏达大学电气与计算机工程系杰出 McKnight 教授兼 Robert F. Hartmann 主席王建平 (Jian-Ping Wang) 说道。

但明尼苏达团队坚持了下来,在王建平教授的专利 MTJ 研究基础上,开发出了磁性 RAM (MRAM)。MTJ 器件是一种纳米结构器件,用于改进硬盘、传感器和其他微电子系统,包括磁性随机存取存储器 (MRAM),已用于微控制器和智能手表等嵌入式系统。

王建平教授表示:“自 2003 年以来,随着学生群体的不断发展,以及明尼苏达大学建立起一支真正的跨学科教师团队——从物理学、材料科学与工程、计算机科学与工程到建模和基准测试以及硬件创建——我们能够取得积极的成果,现在已经证明这种技术是可行的,并且已经准备好融入技术中。”

王建平是一位在美国待了二十多年的美籍华人,本科和硕士就读于兰州大学。

自 2002 年起,王建平教授在明尼苏达大学理工学院任职,担任电气和计算机工程系的罗伯特·哈特曼讲席教授,并担任先进信息技术自旋电子材料中心(SMART 中心)的主任。

作为新型磁性材料和自旋电子器件领域的世界知名专家,王建平教授的研究侧重于信息存储、记忆和计算以及生物医学传感方向。自 2008 年以来,王建平教授通过交换耦合复合介质(ECC)的开创性实验演示,高效利用了 HDD(硬盘驱动器)的技术,通过减少数据中心的整体数量,节约了全球能量消耗。

2013 年,明尼苏达大学 SMART 中心获得了美国国家标准与技术研究院(NIST)和纳米电子计算机研究联盟(nCORE)2900 万美元赞助,以研究下一代微电子技术。

2022 年,王建平教授当选美国国家发明家科学院(National Academy of Inventors - NAI)院士。当选之后,他在接受“移民国家(A Nation of Immigrants)”对话时,谈到自己的身份:不仅是教授,也是企业家和工程师,并且名下有三家公司。这三家公司中,Niron Magnetics 是一家开发无稀土且环保的氮化铁永磁体的公司。而 Zepto Life Technology 公司则是利用了可用于疾病的早期检测的磁性生物传感技术。王建平教授还曾于 2019 年获得了“半导体公司创新奖”。

图右为王建平,截图来自“移民国家(A Nation of Immigrants)”

但另一方面,也有很多人对他的研究表示不理解。

2013 年的时候,王建平所在的研究团队对其“能提高计算机处理和内存效率”的新材料申请了专利,但是半导体行业内的人要求提供出该材料的样品出来,以证实他们的发明。当时他对材料的形容是:“我们使用了一种在过去几年中备受半导体行业关注的量子材料,但是我们以独特的生产方式使其具备了新的物理和自旋电子特性,从而可以极大地提高计算和内存效率。”

如今,对于这个可以应用到目前热门的 AI 行业中的内存技术方案,业界也充满了不理解:

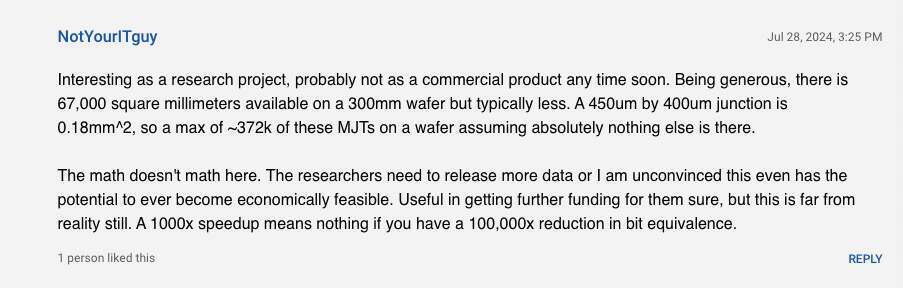

作为一个研究项目,这很有趣,但近期内可能不会成为商业产品。宽松估计下,一个 300 毫米的晶圆上有 67,000 平方毫米的可用面积,但通常会少一些。一个 450 微米乘 400 微米的结点是 0.18 平方毫米,因此在一个晶圆上最多可以有约 372,000 个这样的 MJTs,假设上面没有其他任何东西。这些数据不太对劲。研究人员需要发布更多数据,否则我无法相信这在经济上有潜力实现。

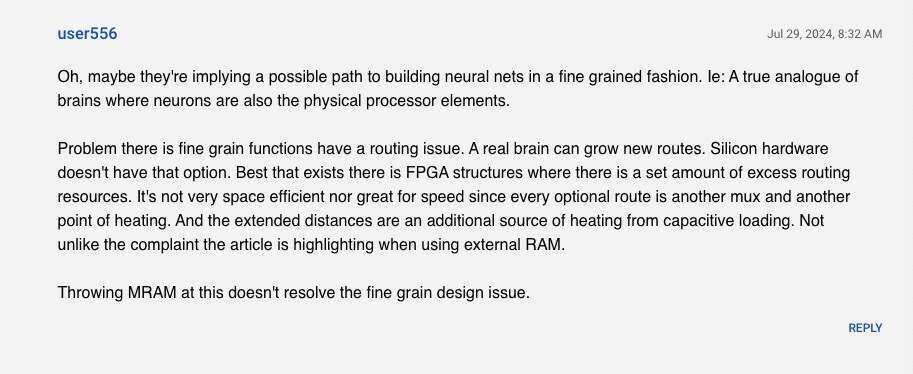

在此使用 MRAM 并不能解决细粒度设计问题。

但如果这些真的从“研究”走向实际应用,也许人工智能的需求会迅速爆发。

参考链接:

https://www.nature.com/articles/s44335-024-00003-3#auth-Jian_Ping-Wang-Aff1