从 20 世纪 60 年代开始,人们就在期待像哈尔(HAL)这样的科幻级别的 AI,然而直到最近,PC 和机器人还是非常愚笨。现在,科技巨头和创业公司宣告了 AI 革命的到来:无人驾驶汽车、机器人医生、机器投资者等等。普华永道认为,到 2030 年,AI 将会向世界经济贡献 15.7 万亿美元。“AI”是 2017 年的热词,就像“.com”是 1999 年的时髦用语那样,每一个人都宣称自己对 AI 感兴趣。不要被有关 AI 的炒作所迷惑,它是泡沫还是真实?和旧有的 AI 潮流相比,它现在有什么新颖之处?

AI 并不会轻易或迅速地被应用。最令人兴奋的 AI 实例往往来自大学或者科技巨头。任何许诺用最新的 AI 技术让公司发生革命性变革的自封的 AI 专家,都只是在传递错误的 AI 信息,其中某些人只是重塑旧有技术的形象,把它们包装成 AI。每个人都已经通过使用 Google、微软、亚马逊的服务,来体验了最新的 AI 技术。但是,“深度学习”不会迅速地被大企业所掌握,用来定制内部项目。大多数人都缺乏足够的相关数字数据,不足以可靠地用来训练 AI。结果就是,AI 并不会杀死所有的工作机会,尤其因为它在训练和测试每个 AI 的时候还是需要人类。

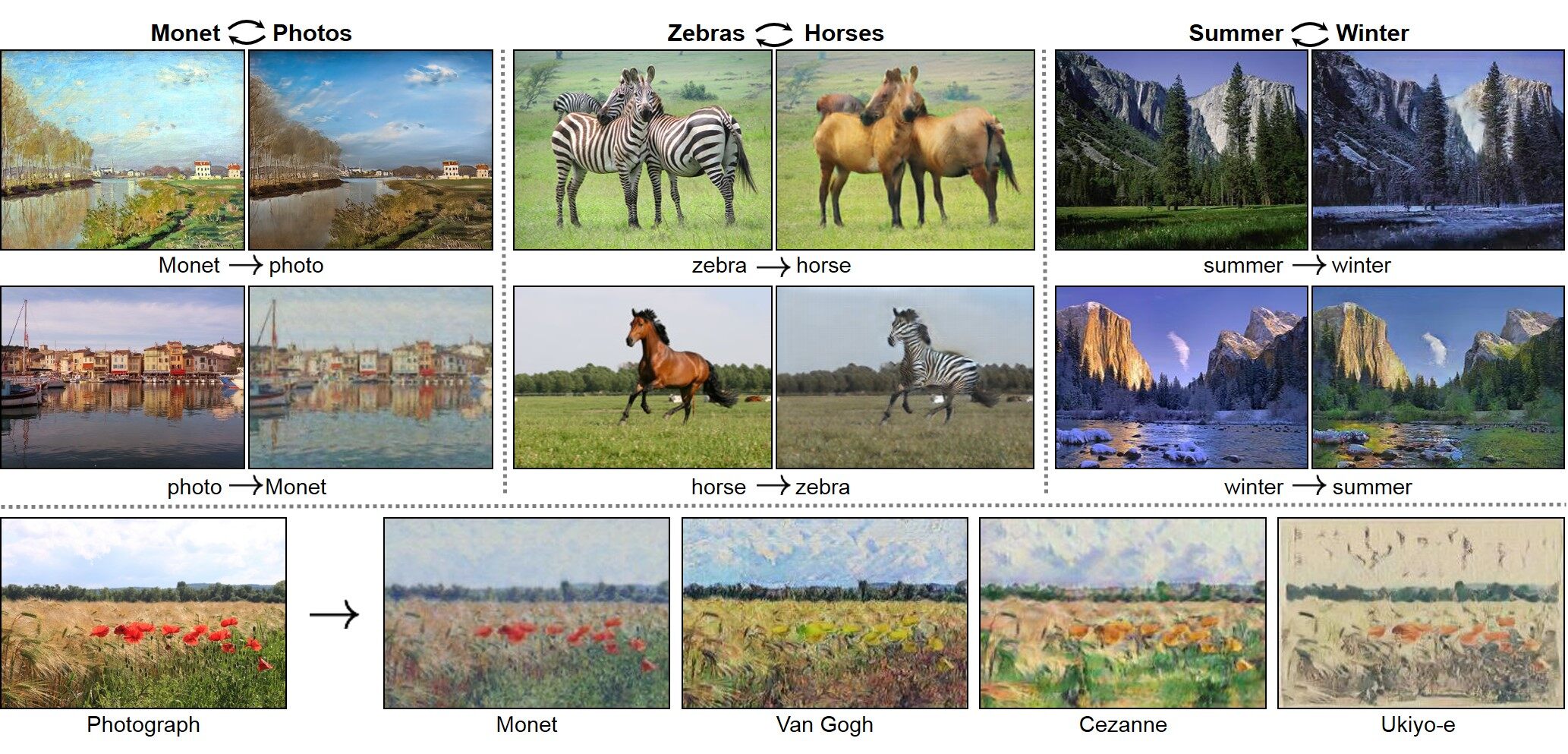

AI 目前已经能够“用眼睛看到”,并精通一些视觉相关的工作了,比如:通过医学影像识别癌症或其他疾病,在统计学上优于人类放射科医师、眼科医师、皮肤科医师等,还有驾驶汽车、读唇语。AI 能通过学习样本(比如毕加索或者你的画作)画出任何一种风格的图画。反过来,它也能通过一幅画,补足缺失的信息,猜出真实的照片是什么。AI 看着网页或应用的屏幕截图,就能写出代码制作出类似的网页或应用。

AI 目前还能“用耳朵听到”,它不只能听懂你的话,还能通过听 Beatles 或你的音乐,创作出新的音乐,或者模拟它听到的任何人的声音。一般人无法分辨出一幅画或一首曲子是由人还是由机器创作的,也无法分辨出一段话是由人类还是 AI 说出的。

被训练用来赢得扑克比赛的 AI 学会了虚张声势,能够处理丢牌、潜在的造假行为,还能误导信息。被训练用来谈判的机器人也学会了欺骗,能猜测出你什么时候在说谎,如果需要它们也会撒谎。一个用来在日语和英语间翻译或者在韩语和英语间翻译的 AI,也能在韩语和日语间进行翻译转换。看起来翻译 AI 自己创造了一种中间语言,能不分语言的界限演绎任何一个句子。

机器学习(ML)是 AI 的一个子类别,它能让机器从经验中学习,从真实世界的实例中学习,数据量越大,它就能学到越多。据说,如果一台机器完成一项任务的表现随着经验的增多越来越好,那它就能根据这项任务的经验进行学习。但大部分 AI 还是根据固定规则制造出来的,它们并不能学习。从现在开始,我将使用“机器学习”这个词来指称“从数据中进行学习的 AI”,以此强调它和其他 AI 的区别。

人工神经网络只是通往机器学习的其中一种方式,其他路径还包括决策树、支持向量机等。深度学习是一种具有许多抽象层次的人工神经网络。不去谈“深度”这个有炒作意味的词,很多机器学习方法都是“浅显的”。成功的机器学习通常是混合的,也就是很多方法的组合,比如树 + 深度学习 + 其他,它们都是被分别训练而成的,再把它们结合在一起。每一个方法都可能带来不同的错误,所以,平均了它们每一个方法成功的结果,它们就胜过了单独一种方法。

旧有的 AI 并不能“学习”。它是基于规则的,它只是几个人类写成的“如果……那么……”。它只要能解决问题就被称作是 AI,但它不是机器学习,因为它不能从数据中进行学习。目前的 AI 和自动系统中大部分依然是基于规则的代码。机器学习从 20 世纪 60 年代开始才被人了解,但就像人类大脑一样,它需要大量的计算设备处理大量的数据。在 20 世纪 80 年代,要在 PC 上训练一个 ML 需要几个月时间,而那时候的数字数据也非常稀少。手动输入的基于规则的代码能快速地解决大部分问题,所以机器学习就被遗忘了。但用我们现在的硬件,你能在几分钟内就训练出一个 ML,我们知道最佳的参数,而且数字数据也更多了。然后在 2010 年之后,一个又一个 AI 领域开始被机器学习所掌控,从视觉、语音、语言翻译到玩游戏,机器学习胜过了基于规则的 AI,而且通常也能胜过人类。

为什么 AI 在 1997 年的国际象棋比赛中就击败了人类,但直到 2016 年,才在围棋比赛中击败了人类呢?因为在 1997 年,计算机仅仅简单地计算出了国际象棋 8x8 棋盘中所有的可能性,但围棋拥有 19x19 的可能性,计算机要计算出所有可能性需要十亿年。这就像要随机组合出所有字母,以此得到这样一整篇文章一样:这根本不可能。所以,人们已知的唯一的希望在于训练出一个 ML,但是 ML 是近似的,不是确定的,机器学习是“随机的”,它可以被用于统计分析的模式,但不能用于准确的预测。

机器学习让自动化成为可能,只要你准备好训练 ML 的正确数据就可以了。

大多数机器学习都属于监督学习,这里用来训练的实例都是有标签的,标签就是关于每个实例的描述或者标注。你首先需要人工把那些关于猫的照片从关于狗的照片中分离出来,或者把垃圾邮件从正常邮件中分离出来。如果你错误地给数据打了标签,最后 ML 就会不正确,这至关重要。把未打标签的数据放到 ML 里,这就是无监督学习,在这里 ML 会发现有用的数据的模型和群组,但它不能单独用来解决很多问题。所以有些 ML 是半监督式的。

在异常检测中,你可以识别出不同寻常的东西,比如欺诈或者赛博入侵。一个通过老式欺诈训练出来的 ML 会错过那些新式的欺诈。你可以让 ML 对任何可疑的不同之处做出警告。政府部门已经开始用 ML 来侦查逃税行为了。

强化学习在 1983 年的电影《战争游戏》中就已经有了体现,在电影里,计算机通过打通光速中的每一个场景,从而避免了第三次世界大战。这个 AI 在百万计的失败与尝试中探索,最终得到了巨大的回报。AlphaGo 是这样被训练而成的:它曾数百万次地扮演自己的对手,从而获得超越人类的技能。它使出了前所未见的招数,人类选手甚至可能会把它看做错误的招数。但后来,这些招数被公认为机智非凡。ML 开始变得比人类围棋选手更富有创造性。

在人们认为 AI 不是真正智能的时候,“AI 效应”就出现了。人们在潜意识里需要相信魔力,需要相信人类在宇宙中的独一无二。每一次机器在某一项智能活动中超越了人类时,比如在下象棋、识别图片或者翻译时,人们总是会说:“那只是强力计算能力,那不是智能。”很多 app 里都有 AI 存在,然而一旦被广泛应用,它就不再被称作“智能”。如果“智能”只是 AI 没有达成的技能(也就是独属于大脑的技能),那字典每一年都要被更新,比如:数学在 20 世纪 50 年代之前才被认为是智力活动,现在已经不是了。这真是太奇怪了。关于“强力计算能力”,一个人类大脑拥有 100 万亿个神经元连接,比地球上任何一个计算机所拥有的都多得多。机器学习不能做“强力计算”,如果让机器学习去尝试所有连接,那需要花上十亿年的时间。机器学习只会“在被训练的基础上进行猜测”,并且它使用的计算能力比大脑使用的要少。所以,应该是 AI 来宣称人类大脑不够智能,来宣称人类大脑只是强力计算能力而已。

机器学习并不是一个人类大脑模拟器,真正的神经元要不同得多。机器学习是通往真正大脑能力的另一条通路。大脑和机器学习都要处理统计数字(概率)来逼近复杂函数,它们都会给出稍微有点偏差的结果,但这个结果是可用的。机器学习和人类大脑会针对同一任务给出不同的结果,因为它们以不同的方式处理问题。所有人都知道,大脑容易忘记事情,并且在解决特定数学问题的时候也有很多限制,但机器在记忆和数学方面是完美无缺的。然而,那些认为“机器要么给出确切答案,要么就是机器坏了”的旧想法是错误的、过时了的。人类会犯很多错,你不会听到说这个人类大脑坏掉了,而是会听到让这个人类大脑更努力地学习。所以,ML 也不是坏掉了,它们需要更努力地学习,在更多不同的数据中学习。基于人类偏见训练出来的 ML 有可能会是种族主义的、性别歧视的、不公平的,总之最糟糕的还是人类大脑。ML 不应该只被数据训练,不应该只为了模仿人类的工作、行为和大脑。同样的 ML,如果在其他星系被训练,就能模仿外星人的大脑,让我们也用外星人的思维来思考吧。

AI 正在变得像人类一样神秘。那些认为计算机无法拥有创造力,不能撒谎、出错或者像人类一样的想法,是来自于旧有的基于规则的 AI,这些 AI 确实是可预测的,但它们会随着机器学习的出现而发生改变。AI 一旦掌握了某些新的能力,就被称作“不够智能”,这样的时代已经结束了,对 AI 来说,唯一真正重要的区别是:通用 AI,或者狭义 AI。

和其他科学不同,你无法验证一个 ML 是否在使用逻辑化的理论。要判断一个 ML 是否正确,你只能通过测试那些不可见的新的数据结果。ML 不是一个黑匣子,你可以看到那些它生成和运行的“如果……那么……”列表,但通常对一个人类来说,这些数据量太大太复杂了。ML 是一门试图重现现实世界之混乱与人类直觉的实用科学,它不会给出简单的或理论化的解释。这就好像,你有一个行得通的想法,但你不能具体解释出自己是怎么得出这个想法的。对于大脑来说,这被称为灵感、直觉、潜意识,但对计算机来说,这就是机器学习。如果你能得到一个人在大脑里做出决定所需的全部神经信号,你就能理解大脑做出这个决定的真正缘由和过程吗?或许能吧,但这很复杂。

每个人都可以通过直觉来想象另一个人的脸,可以是现实的脸也可以是毕加索式的脸。人们还能想象一种声音或者音乐风格。但没人能用完整而有效的方式来描述一张脸、声音或者音乐风格的变化。人类只能看到三个维度,即使爱因斯坦也不能有意识地解决 500 个维度上机器学习一般的数学问题。但我们的人类大脑一直在用直觉解决这种 500 维的数学问题,就像魔法一样。为什么它不能被有意识地解决呢?想想一下,如果对每个想法,大脑都给出它所使用的有上千个变量的公式,会怎样?那些多余的信息会让我们非常困惑,并且大幅减缓我们思考的速度,这又何必呢?没有人类能进行几页长的数学计算,我们的头上并没有进化出 USB 电缆那样的东西来。

有缺陷的自动化会提升人类的工作,而不会杀死这些工作。

如果没有人能预测任何事,那么机器学习同样做不到。很多人用多年的市场价格变化来训练 ML,但这些 AI 还是无法预测市场走向。ML 只有在过去的因素和趋势保持不变的情况下进行预测。但股票和经济趋势经常变动,几乎是随机的。当旧的数据不再有效或者频繁出现错误的实话,ML 就会失灵。已经习得的任务和规则必须保持一致,或至少是很少再变动,这样你才能再次训练。举个例子,学习开车、打扑克、按某种风格画画、根据健康数据预测疾病、在不同语言之间进行转换,这些是机器学习能做到的,旧有的实例在近期未来依然会是有效的。

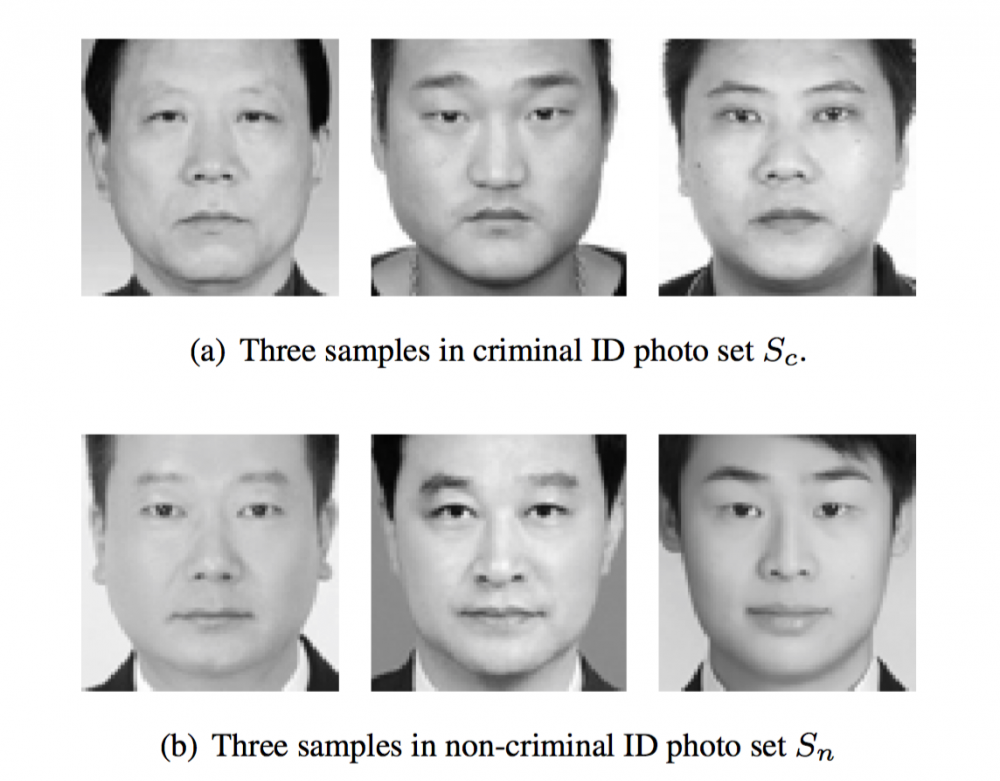

机器学习能在数据中找到因果联系,但它找不到并不存在的东西。比如,在一项名为“使用面部图像自动识别罪犯”的怪异研究中,ML 学习了很多在押罪犯和无罪者的面部照片,研究者声称,机器学习只根据一张面部照片就能抓到新的“坏人”,但研究者“感觉”,更进一步的研究将驳回根据面貌进行判断的有效性。他们的数据设置是有偏见的:有些看起来无辜的白领罪犯甚至会嘲笑他们的做法。ML 能学到的唯一联系是开心或生气的嘴巴、领子的类型等。那些微笑着的穿着白领的人被分类为无辜诚实的,而那些看起来悲伤的穿黑领衣服的人则和“坏人”相关。那些机器学习专家尝试着用人们的面部来判断这个人的好坏,但他们却不能通过衣着(社会阶层)去判断。机器学习放大了一种不公平的偏见:街上穿着便宜衣服的小贼比腐败的政客和顶级企业欺诈者更容易被发现并受到惩罚。这种机器学习将会发现所有街上的小贼并把他们投入监狱,但一个白领都没有。机器学习并没有像任何一个成年人那样在我们这个世界生活过,它们不知道在数据以外还有什么,连那些很“明显的”也不知道,举个例子:在一场火灾中,火势越大,被派去的救火车就越多。一个 ML 会注意到,在一个火场的消防员越多,第二天看到这场造成的破坏就越大,所以正是那些救火车导致了火灾破坏。结论:机器学习会以纵火罪把消防员送进监狱,因为这其中有 95%的相关性!

(机器学习不能从不存在的东西中寻找相关性,比如:带有犯罪倾向的面部。但这些数据是带有偏见的:没有微笑着的白领罪犯在其中!机器学习会学到这些偏见。)

在某些情况下,机器学习能预测人类不能预测的事情。“Deep Patient”是一个由纽约西奈山医院用 70 万患者数据训练而来的 ML,它能用来预测精神分裂症,而没有任何一个人类明白要如何预测!只有 ML 可以做到,人类无法通过学习机器学习而做到同样的事情。这就是问题所在:对一项投资、医疗、司法和军事决定来说,你可能想知道 AI 是如何得出它的结论的,但你无法知道。你无法知道机器学习为什么拒绝了你的贷款,为什么判定你入狱,为什么把一个工作机会给了别人。ML 公不公平?它是否带有种族、性别和其他偏见?机器学习计算是可见的,但它们很难做成人类可阅读的总结。机器学习就像个预言者那样讲话:“你们人类不理解,即使我展示给你们数学你们也不懂,所以信奉我吧!你测试过了我以往的预测,它们都是对的!”

人类也从来不会完整地解释他们所做的决定。我们会给出听起来合理的理由,但却通常是不完整的过于简化的理由。那些总能从 ML 那里得到正确的答案的人们,会开始编造虚假的阐释,就是因为这样会让公众更容易认可 ML 的预测。还有些人会偷偷使用 ML,并把得出的想法说成是他们自己的想法。

ML 是有限的,就是因为它们缺乏通用智能和事先的常识。即使把所有专业的 ML 融合在一起,或者训练一个 ML 做所有事情,它依然无法完成通用智能的工作。举个例子,拿理解语言来说,你不能和 Siri、Alexa 或 Cortana 谈论所有话题,就像和真正的人聊天那样,它们只是智能助手。在 2011 年,IBM 的 Watson 在 Jeopardy 节目中比人类选手回答得更为迅速,但它却把加拿大和美国搞混了。ML 能够为长文生产出实用的简短总结,包括做出情绪分析,但却不能像人类那样可靠地完成这项工作。聊天机器人无法理解太多问题。目前也没有任何一个 AI 能完成对一个人来说很容易的事情:推测一个顾客是否是恼怒的、充满讽刺的,并进而调整自己的语调。并不存在像电影里那种通用的 AI。但我们依然可以得到一些科幻式 AI 的细枝末节,也就是那些在某个狭窄专业领域里胜过人类的 AI。最新的消息是,狭窄领域也可以包括有创造性的或那些通常被认为只有人类能做的事情,比如绘画、作曲、创作、猜测、欺骗和伪造情绪等,这些看起来都不需要通用的 AI。

没人知道如何造出一个通用 AI。这真是棒极了,我们已经拥有了超人类的专业工人(狭义 AI),但没有任何一个终结者或黑客帝国会自己决定要杀掉我们。不幸的是,人类会训练机器顷刻间杀掉我们,举例来说,一个恐怖分子可能会训练一个自动驾驶的卡车冲撞人行道。而拥有通用智能的 AI 可能会自我毁灭,也不会遵循恐怖分子的指令。

AI 伦理可能将被入侵,并且重新编程为非法的模式。目前的 AI 既不是通用的也不是属于科学家的 AI,它总是会遵从人类的指令。

AI 会杀死旧有的工作,但还会创造出新的机器学习训练员的工作,就和宠物训练员有点类似,而不像工程师。一个 ML 比一直宠物要难训练多了,因为它不具备通用智能,它会学会它从数据中看到的所有东西,不带任何筛选和常识甄别。一只宠物在学会做坏事之前还会三思而后行,比如说杀死它的小伙伴们之类的。然而对 ML 来说,它为恐怖分子服务或为医院服务没什么区别,而且它也不会解释自己为什么要这样做。ML 并不会为自己的错误和它为恐怖分子营造的恐怖氛围而道歉,它毕竟不是一般的 AI。

实用机器学习训练。如果你用手拿着物品的照片训练一个 ML,它会把手看做是这个物品的一部分,也就无法单独识别出这个物品本身。一只狗知道如何从人的手上吃东西,而那愚蠢的 ML 则会把食物连同你的手一起吃掉。要改掉这个问题,那就要先训练它认识手,再训练它认识单独的物品,最后训练手拿着物品的情况,并打上标签“手握着物品 X”。

版权和知识产权法需要更新。就像人类一样,ML 也能发明新的东西。一个 ML 被展示了现存的 A 和 B 两个东西,然后它生产出了 C,一个完全全新的东西。如果 C 和 A、B 都足够不同,也和世界上任何其他东西不同,那 C 就可以获得发明或艺术品的专利。那么谁是这个东西的创作者呢?更进一步,那如果 A 和 B 是有专利或者有版权的材料呢?当 C 非常不同的时候,A 和 B 的创作者就不能认为 C 是因为 A 和 B 的存在而诞生的。我们假设在现有的有版权的绘画、音乐、建筑、设计、化学分子式和窃取的用户数据基础上训练 ML 不合法,那你如何识别出一个作品是否使用了 ML 产生的结果,尤其是它并不像毕加索的风格那么容易识别?你怎么能知道它有没有用一点机器学习呢?很多人都会偷偷使用机器学习,并声称那些作品是他们自己的。

对一个小公司的大多数工作来说,训练人工要比训练机器学习便宜得多。教一个人类开车很容易,但让机器学会开车去漫长而艰难。当然,也许让机器来开车比人类要安全,尤其是考虑到那些喝醉了的、困倦不堪的、看着手机开车的、无视限速的人或者那些本性疯狂的人类。但那么昂贵和可靠的训练只在大公司里有可能存在。用便宜方法训练出来的 ML 既靠不住又十分危险,但只有很少的公司有能力训练出可靠的 AI。一个受训的 ML 永远无法被复制,不像一个大脑的经历被传送到另一个大脑中那样。大的提供商将会售卖未经训练的 ML 来完成可重复使用的任务,比如“放射科医师 ML”。ML 可以补充一个人类专家,专家总是被需要的,但它可以替代其他“多余的”员工。一家医院可以聘用一位放射科医师监督 ML,而不用聘用很多个放射科医师。放射科医师这个工作并不会灭绝,只是在每家医院的工作职位变少了。训练 ML 的公司将会把 ML 卖给多家医院,从而赚回投资资金。每一年,训练 ML 需要的成本都会降低,因为越来越多人将学会如何训练 ML。但由于数据储备和测试的原因,可靠的 ML 训练最终也不会变得非常廉价。在理论上说,很多工作任务都可以被自动化,但实际上只有一部分工作抵得过训练一个 ML 的成本。对于那些过于不寻常的工作,比如泌尿科医师,或者翻译一种古代的已经失传的语言,这样的工作,其人类薪资从长期来看依然比一次性训练一个 ML 来的便宜,因为从事这种工作的人数太少了。

在 ML 研究之外,人类依然会继续从事通用 AI 的工作,IQ 测试是错误的,IQ 测试并不能预测人们在生活中的成功,因为那是非常多不同智能的综合,视觉、语言、逻辑、人际关系等等,但结果依然不能用量化的 IQ 数字来衡量。我们认为,和人类 IQ 比起来,昆虫是“愚蠢的”,但一直以来,蚊子在“咬完就跑”这样一个单独的任务上都胜过了人类。每一个月,AI 都在更加狭窄的任务领域打败人类,就像蚊子的技能那样狭窄。等到奇点时刻来临,AI 将在所有事情上打败我们人类,这很可笑。我们正在遇见很多个狭义的奇点,一旦 AI 在某件事上打败了人类,所有人都期待着那些监督 AI 的人放弃他们的工作。我总是读到这样的文章,认为人类将能够保有他们独一无二的有缺陷的手工工作,但事实上,AI 是可以假装有缺陷的,它们会学着在每一件制成品中做出手工一般的不同缺陷。要预测 AI 下一个会战胜什么领域的人类,这不太可能,AI 是有创造力的,但它依然缺乏通用的智能。举个例子:喜剧演员和政客的工作是安全的,虽然他们不需要独特的(狭窄的)学习或学位,但他们就是能够用幽默和有说服力的事情谈论任何事情。如果你的专业是一个复杂却狭窄的通用任务,比如你是放射科医师,ML 就会受训来取代你。你需要具备通用智能!

感谢陈思对本文的审校。