写点什么

创作场景

- 记录自己日常工作的实践、心得

- 发表对生活和职场的感悟

- 针对感兴趣的事件发表随笔或者杂谈

- 从 0 到 1 详细介绍你掌握的一门语言、一个技术,或者一个兴趣、爱好

- 或者,就直接把你的个人博客、公众号直接搬到这里

登录/注册

收录了 迁移学习 频道下的 50 篇内容

本文全面介绍了迁移学习的理念、范围和真实世界应用,并给出迁移学习在深度学习中的应用实例。

由于知识获取与表示的困难,以及当时计算机计算能力的限制,符号主义的主张没有得到应有的发展和大规模的应用,以知识为基础的学习方法也同样受到重创。

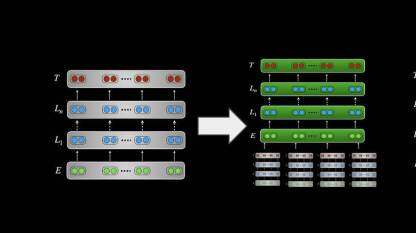

随着迁移学习方法的大行其道,越来越多的研究人员开始使用深度神经网络进行迁移学习。

迁移学习是把一个领域(即源领域)的知识,迁移到另外一个领域(即目标领域),使得目标领域能够取得更好的学习效果。通常,源领域数据量充足,而目标领域数据量较小,迁移学习需要将在数据量充足的情况下学习到的知识,迁移到数据量小的新环境中。但是,如何形式化的描述所要迁移的知识,使用何种方法迁移知识,以及何时迁移是有效的、何时是有副作用的,是使用者所要关注的重点和难点,本次分享主要集中在前两个方面。至于如何保证迁移的有效性,目前并没有很好的理论来支持。

深度剖析深度迁移学习

本文对北美计算语言学联合会 2019 年出版的《自然语言处理中迁移学习教程》(NAACL 2019 tutorial on Transfer Learning in NLP)进行了拓展。

近年来随着深度学习的急剧升温,不管是学术界还是工业界都把大量资源投入了深度学习。作为一个普通的工程师或者程序员,也想对机器学习,尤其是深度学习有所了解,应当如何入手?最好的回答当然是“gets your feet wet”——不下水是终究是学不会游泳的。然而,深度学习火爆的同时,带来的一个副作用是:面对琳琅满目的各色名词,初学者简直毫无头绪,也无从下手。特别是机器学习、深度学习,以及最近炒得很火的强化学习、迁移学习,到底是怎么一回事儿? 本文试图以自己亲自操刀的两个项目案例演示迁移学习的实际应用,并且在篇头以维基百科上的定义,对上述几种机器学习作个简单的阐明,以及做个对迁移学习的简单科普。

本文主要讲述用迁移学习的方法改善电商网站中预测评论有用性的任务。

本文介绍《迁移学习》一书。

吴恩达曾说:迁移学习将会是继监督学习之后下一个机器学习商业成功的驱动力。

近日,杨强教授在[范式大学]内部课程中,与大家分享了他在 “生成式对抗网络模型“ 和迁移学习等领域的独特见解和最新思考。

预训练模型BERT基于深度迁移学习的思想,目前已经成为业界NLP领域的主流技术。TPU解决算力的瓶颈、采用BERT和上层神经网络进行联合参数调优、采用BERT的各种扩展模型和数据增强进行效果提升等等。

在 AICon 北京 2019 大会上,苏海波讲师做了《深度迁移学习在NLP中的应用及实践》主题演讲。

本文介绍了如何快速应用Tensorflow 2 已有模型进行训练。

该方法通过语音到文本翻译作为中间步骤,改进了针对端到端自动语音识别的跨语言迁移学习。它使学习迁移成为一个两步过程,提高了模型的性能。

在AI中,感知-动作循环是自动驾驶车辆等自动系统的基石。

本文详细介绍目前多语种NLP常用的工具、前沿的算法以及百分点在实际业务中的实验结果等

它会对迁移学习产生什么影响呢?

使用深度学习技术解决问题的过程中,最常见的障碍在于训练模型过程中所需的海量数据。需要如此多的数据,原因在于机器在学习的过程中会在模型中遇到大量参数。在面对某一领域的具体问题时,通常可能无法得到构建模型所需规模的数据。然而在一个模型训练任务中针对某种类型数据获得的关系也可以轻松地应用于同一领域的不同问题,这就是所谓的迁移学习。

词向量(word vectors)是自然语言处理的核心表征(representation)技术,它长期统治着自然语言处理领域。然而,现在出现了一系列令人振奋的挑战者:ELMo、ULMFiT 和 OpenAI Transformer。它们都证明了预训练语言模型可以在各种自然语言处理任务中取得最佳的结果。这些方法的出现预示着一个分水岭时刻的到来:这些预训练语言模型可能会在自然语言处理领域造成广泛的影响,正如 ImageNet 预训练模型在计算机视觉中所造成的影响一样。