继 8 月初阿里云开源通义千问 70 亿参数通用模型 Qwen-7B 和对话模型 Qwen-7B-Chat 后,又一大模型实现了开源。

阿里云开源通义千问多模态大模型 Qwen-VL

InfoQ 获悉,8 月 25 日,阿里云开源通义千问多模态大模型 Qwen-VL。这是继 8 月初阿里云开源通义千问 70 亿参数通用模型 Qwen-7B 和对话模型 Qwen-7B-Chat 后,又开源的一大模型。

据介绍,Qwen-VL 是支持中英文等多种语言的视觉语言(Vision Language,VL)模型。相较于此前的 VL 模型,Qwen-VL 除了具备基本的图文识别、描述、问答及对话能力之外,还新增了视觉定位、图像中文字理解等能力。

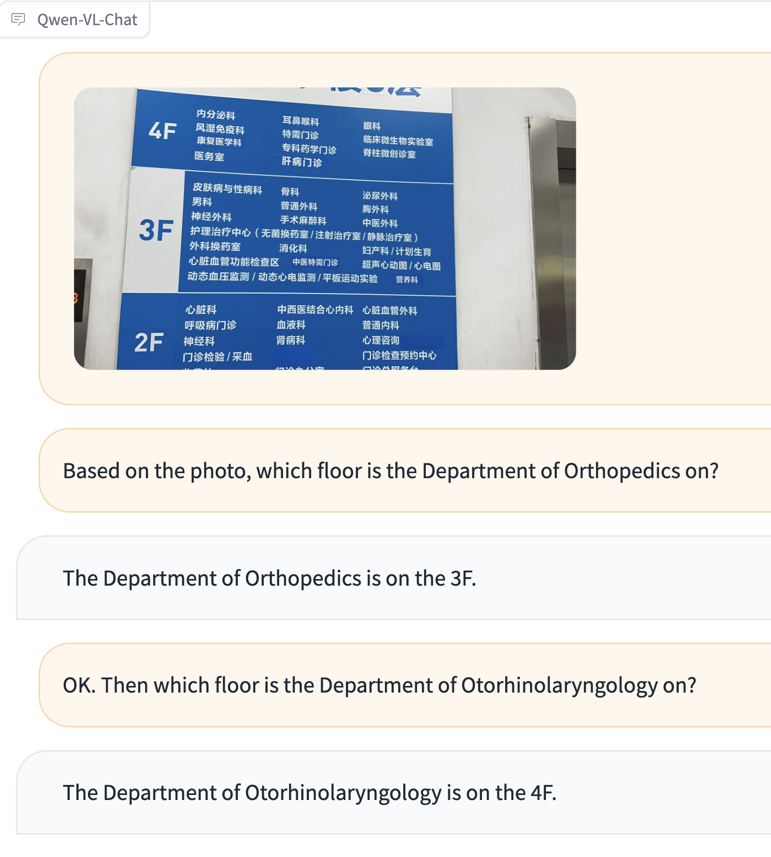

具体来说,Qwen-VL 可以以图像、文本、检测框作为输入,并以文本和检测框作为输出,可用于知识问答、图像标题生成、图像问答、文档问答、细粒度视觉定位等多种场景。比如,一位不懂中文的外国游客到医院看病,不知道怎么去往对应科室,他拍下楼层导览图问 Qwen-VL“骨科在哪层”“耳鼻喉科去哪层”,Qwen-VL 会根据图片信息给出文字回复。

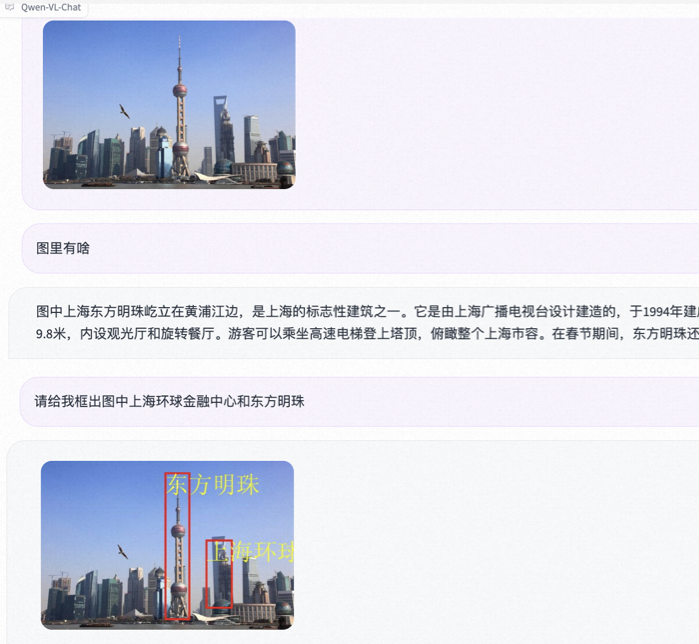

此外,Qwen-VL 还是业界首个支持中文开放域定位的通用模型,可以通过中文开放域语言表达进行检测框标注。开放域视觉定位能力决定了大模型“视力”的精准度,这意味着具备该能力的大模型能在画面中精准地找出想找的事物。比如,输入一张上海外滩的照片,让 Qwen-VL 找出东方明珠,Qwen-VL 能用检测框准确圈出对应建筑。

据了解,Qwen-VL 以 Qwen-7B 为基座语言模型研发,在模型架构上引入视觉编码器,使得模型支持视觉信号输入,并通过设计训练过程,让模型具备对视觉信号的细粒度感知和理解能力。更高分辨率可以提升细粒度的文字识别、文档问答和检测框标注,相比于目前其它开源 LVLM 使用的 224 分辨率,Qwen-VL 是首个开源的 448 分辨率的 LVLM 模型。

阿里云通义千问团队算法专家、Qwen-VL 开源模型负责人白金泽在接受 InfoQ 采访时表示,Qwen-VL 模型的训练分为三个阶段:

在预训练阶段,团队主要利用大规模、弱标注的图像-文本样本对进行训练;

在多任务训练阶段,团队整理了大量高质量多任务的细粒度图文标注数据进行混合训练,并升高了图像的输入分辨率,降低图像缩放引起的信息损失,增强模型对图像细节的感知能力,得到 Qwen-VL 预训练模型;

在指令微调阶段,团队使用合成标注的对话数据进行指令微调,激发模型的指令跟随和对话能力,得到具有交互能力的 Qwen-VL-Chat 对话模型。

白金泽表示,Qwen-VL 模型的研发难点主要体现在数据、训练、框架三个层面。“数据方面,多模态的数据整理和清洗是个难点,有效的数据清洗可以提高训练效率以及提升最终收敛后的效果。训练方面,在多模态大模型的训练中,一般认为大 batch 和较大学习率可以提升训练收敛效率和最终结果,但其训练过程可能更加不稳定。我们通过一些训练技巧有效提升了训练稳定性,具体细节将在相关论文中公布。框架方面,目前多模态大模型的并行训练框架支持并不完善,我们对多模态大模型的 3D 并行技术进行了优化,可稳定训练更大规模的多模态模型。”

除了 Qwen-VL,本次阿里云还开源了 Qwen-VL-Chat。Qwen-VL-Chat 是在 Qwen-VL 的基础上,使用对齐机制打造的基于大语言模型的视觉 AI 助手,可让开发者快速搭建具备多模态能力的对话应用。

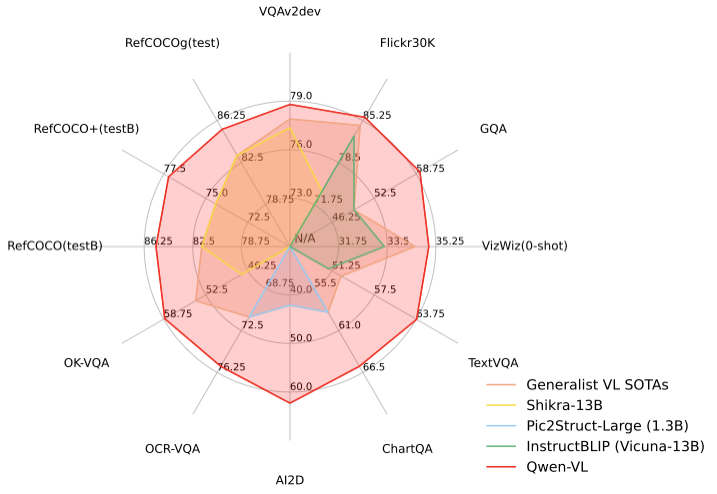

白金泽补充说,团队主要通过两类方式评估了多模态大模型的效果。其一是使用标准基准数据集来评测每个多模态子任务的效果。例如评测图片描述(Image Captioning)、图片问答(Visual Question Answering, VQA)、文档问答(Document VQA)、图表问答(Chart VQA)、少样本问答(Few-shot VQA)、参照物标注(Referring Expression Comprehension)等。其二是使用人工或借助 GPT-4 打分来评测多模态大模型的整体对话能力和对齐水平。通义千问团队构建了一套基于 GPT-4 打分机制的基准“试金石”( TouchStone),总计涵盖 300+张图片、800+ 道题目、27 个题目类别。

在四大类多模态任务(Zero-shot Caption/VQA/DocVQA/Grounding)的标准英文测评中,Qwen-VL 取得了同等尺寸开源 LVLM 的最好效果。为了测试模型的多模态对话能力,通义千问团队构建了一套基于 GPT-4 打分机制的测试集“试金石”,对 Qwen-VL-Chat 及其他模型进行对比测试,Qwen-VL-Chat 在中英文的对齐评测中均取得了开源 LVLM 最好结果。

目前,Qwen-VL 及其视觉 AI 助手 Qwen-VL-Chat 均已上线 ModelScope 魔搭社区,开源、免费、可商用。用户可从魔搭社区直接下载模型,也可通过阿里云灵积平台访问调用 Qwen-VL 和 Qwen-VL-Chat,阿里云为用户提供包括模型训练、推理、部署、精调等在内的全方位服务。

大模型发展的下一站:多模态大模型

多模态大模型是指能够理解文字、图像、视频、音频等多种模态信息的大模型,与仅能理解单一文本模态的语言模型相比,多模态大模型的优势就在于可以充分利用语言模型的指令理解能力,来做图像、语音、视频等各种模态中的开放域任务,从而具备处理不同模态信息的通用能力。而单一模态大模型的任务形式通常都是预先定义好的,比如图像/视频/语音分类任务,需要提前知道这些类别,然后针对性的找训练数据去训练模型。

有观点认为,多模态是预训练大模型最重要的技术演进方向之一。

业界普遍认为,从单一感官的、仅支持文本输入的语言模型,到“五官全开”的,支持文本、图像、音频等多种信息输入的多模态模型,蕴含着大模型智能跃升的巨大可能。多模态能够提升大模型对世界的理解程度,充分拓展大模型的使用场景。比如,以 GPT-4、PaLM-E 为代表的一批模型,通过赋予大语言模型感知、理解视觉信号的能力,展现出大规模视觉语言模型在解决以视觉为中心的实际问题的前景,并显示出进一步拓展到具身智能、通向通用人工智能的广阔前景。

其中,视觉作为人类的第一感官能力,也是研究者首先希望赋予大模型的多模态能力。因此,继此前推出 M6、OFA 系列多模态模型之后,阿里云通义千问团队又开源了基于 Qwen-7B 的大规模视觉语言模型 Qwen-VL。

不过,多模态大模型的开发并非易事,白金泽表示,多模态大模型的开发难度包括但不限于以下几点:

模态间表征差异大:大规模纯语言模型的输入输出一般是离散表征,而图像、语音等内容通常是连续表征,其模态间的信息密度、表征空间、输入输出方式等都存在巨大差异,这导致了设计的复杂性。

多模态大模型收敛不稳定:由于模态间表征差异大、各模态网络异构等因素,相比纯文本大模型,多模态大模型的训练具有更多的挑战,更有可能出现训练不稳定的情况。

缺乏稳定开源框架支持:目前常见的开源大模型训练框架,都只对纯语言模型的训练效率进行了极致的优化。为了处理多模态输入输出,多模态模型通常有非对称的网络结构,导致无法直接用常见开源训练框架扩展到超大参数量。通义千问团队对多模态的并行训练框架进行了多重优化,可稳定训练更大规模的多模态模型。

“多模态是我们很看好的技术方向,这个领域还有很多技术难题有待解决,未来我们也会持续研究。就 Qwen-VL 来说,接下来的工作包括支持更高分辨率的图像输入,无监督地从图像中学习更多的世界知识,扩展更多模态,加深对多模态数据的理解,等等。”白金泽说道。

开源地址:

ModelScope 魔搭社区:

Qwen-VL https://modelscope.cn/models/qwen/Qwen-VL/summary

Qwen-VL-Chat https://modelscope.cn/models/qwen/Qwen-VL-Chat/summary

模型体验:https://modelscope.cn/studios/qwen/Qwen-VL-Chat-Demo/summary

HuggingFace:

Qwen-VL https://huggingface.co/Qwen/Qwen-VL

Qwen-VL-Chat https://huggingface.co/Qwen/Qwen-VL-Chat

GitHub:

https://github.com/QwenLM/Qwen-VL

技术论文地址:

公众号推荐:

跳进 AI 的奇妙世界,一起探索未来工作的新风貌!想要深入了解 AI 如何成为产业创新的新引擎?好奇哪些城市正成为 AI 人才的新磁场?《中国生成式 AI 开发者洞察 2024》由 InfoQ 研究中心精心打造,为你深度解锁生成式 AI 领域的最新开发者动态。无论你是资深研发者,还是对生成式 AI 充满好奇的新手,这份报告都是你不可错过的知识宝典。欢迎大家扫码关注「AI前线」公众号,回复「开发者洞察」领取。

评论 8 条评论