据悉,Kubernetes 上游计划在其 1.6 发行版本中加入 GPU 功能,提升应用程序运行效率。因为很多应用使用 GPU 可以提升效率,比如,大数据平台应用 TensorFlow 通过使用 GPU 效率可以提升几十甚至几百倍。

那么,GPU 是如何应用在 Docker/K8S/TensorFlow 这些平台上起到提升效率的作用的?本文由才云新晋大将 赵慧智 整理编写。主要描写了 GPU 在 Docker、Kubernetes、TensorFlow 以及 Kubernetes+TensorFlow 领域的应用,并介绍了在开发领域自己的实践经验,希望给大家带来借鉴和指导意义。

作者简介:

赵慧智,2016 年下旬加入才云,前 HPE 的 Container team 的 Tech Lead,Kubernetes Member,在软件研发领域有 10 多年的经验。曾在 HP 和 HPE 工作五年多,先前负责过 Linux Kernel 及 driver 开发,后负责 Container 在 HPE Server 上的性能及团队管理工作,之后负责 Kubernetes/Mesos 在 HPE 服务器上的硬件 enablement 及开源工作。

为什么离开惠普,加入才云

2016 年下旬,前惠普 Kubernetes 技术领域的 GPU 专家赵慧智加盟才云。说起自己加入才云的原因,赵慧智从国内 Kubernetes 现状、未来发展趋势几个方面大致说了一下:“当时自己对 Kubernetes 有很多想法,觉得在云平台里面其实有很多有意思的事情。

比方说,如何提供稳定的中间层来让企业的业务更加的稳定和安全;如何降低硬件的成本;如何应对业务的突飞猛进和弹性支持,诸如此类。一开始喜欢 Kubernetes,觉得在这两个技术以后将在技术领域大有作为。

在技术领域,了解到才云研发实力很强,并且在 Kubernetes 里面有影响力,来到公司体验之后感觉工作氛围很好,于是就过来了。

对于 Kubernetes 1.6 中 GPU 功能的想法

赵慧智说:“关于 Kubernetes 1.6,我是希望把 GPU 的功能加进去,因为目前很多应用都能在 GPU 上跑出比 CPU 高很多的性能,而在云里面一个很好的地方是通用化,例如一个应用迁移到另外一个 VM 或者 Server 上可以继续运行,但是通用化也导致了一些硬件特性被屏蔽了,GPU 就是其中之一,所以在 Kubernetes 这样一种 container 编排的环境中如果能支持 GPU,那么将会对一些应用的性能产生质的影响,例如深度学习、AI 等。”

以下是赵慧智 GPU 分享具体内容:

GPU

图形处理器(英语:graphics processing unit,缩写:GPU),又称显示核心、视觉处理器、显示芯片,是一种专门在个人电脑、工作站、游戏机和一些移动设备(如平板电脑、智能手机等)上运行绘图运算工作的微处理器。

(图为:从最初的 GEFORCE 6600 GT 到 K80 的多 GPU 卡协同工作)

GPU 最大的好处就在于可以通过远远多于 CPU 的 core 数量来达到并行计算。

CUDA

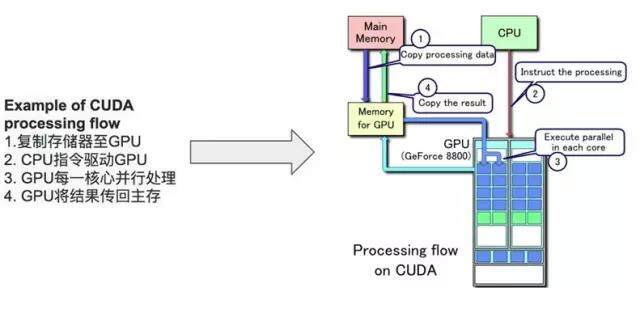

CUDA(Compute Unified Device Architecture,统一计算架构)是由 NVIDIA 所推出的一种集成技术,是该公司对于 GPGPU 的正式名称。通过这个技术,用户可利用 NVIDIA 的 GeForce 8 以后的 GPU 和较新的 QuadroGPU 进行计算。亦是首次可以利用 GPU 作为 C- 编译器的开发环境。NVIDIA 营销的时候,往往将编译器与架构混合推广,造成混乱。实际上,CUDA 可以兼容 OpenCL 或者 NVIDIA 的 C- 编译器。

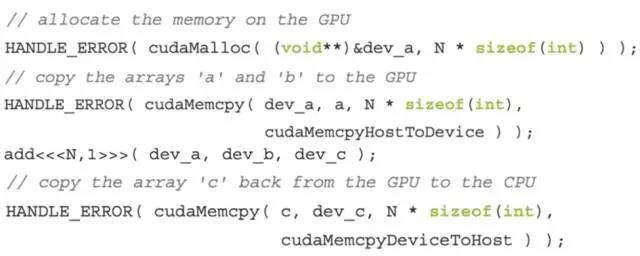

(上图为 CUDA 编程的基本逻辑)

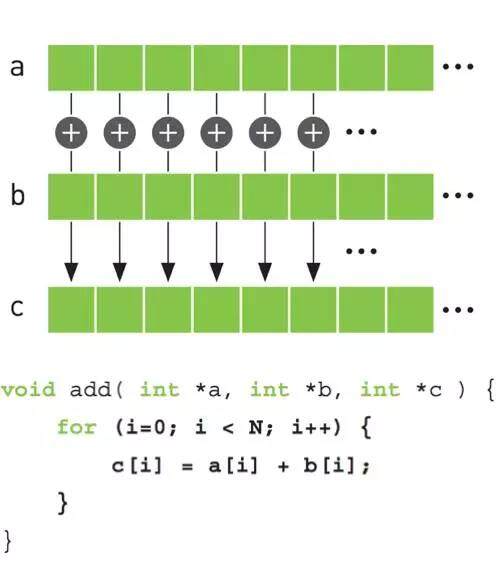

传统方式:

数组会按照从 a[0] + b[0] 一直顺序执行到 a[n] + b[n]。

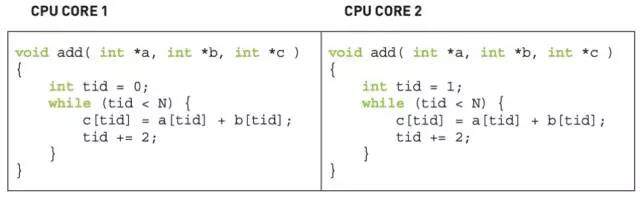

多核计算方式:

如果进行编译优化会在特定操作系统里面把这个数组的相加分配到不同的 core 里面执行,这样所有的计算就会按照 core 的数量进行并发,那么我们可以看到在数组操作中,效率的高低取决于 core 的多少。而通常个人的计算机一般会有 2-8 个 core 不等,而大部分服务器也很少会超过 100 个 core。然而,一个 GPU 很容易就可以达到上千个 core,这样在进行并行计算的时候可以实现十几甚至上百上千倍的效率提升。而 GPU 的价格远远低于相同个数 core 的 CPU(多个)的价格。既然 CUDA 可以提供一般性的并发编程模型,那么我们来看看在 CUDA 平台上上面的代码该怎么写。

代码示例:

申请一块 GPU 的内存,然后就可以把所有的并发操作都交给 GPU。

GPU in Docker

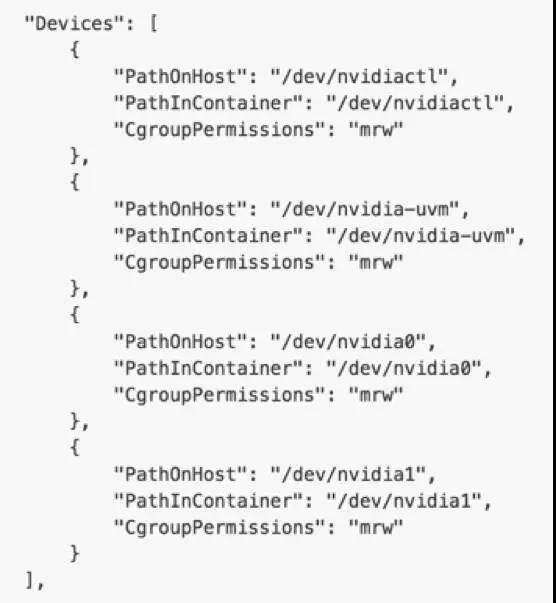

关键词:–device

Docker 是具有把 device 通过 cgroup 里面的 deivce 来 mapping 到 container 上的能力的,我们可以通过“–device”来达到这个目的。

然后我们可以通过 “docker inspect:” 来检查 container 所指定的设备。

然后我们在 container 的内部就可以看到相应的设备并且可以使用了。

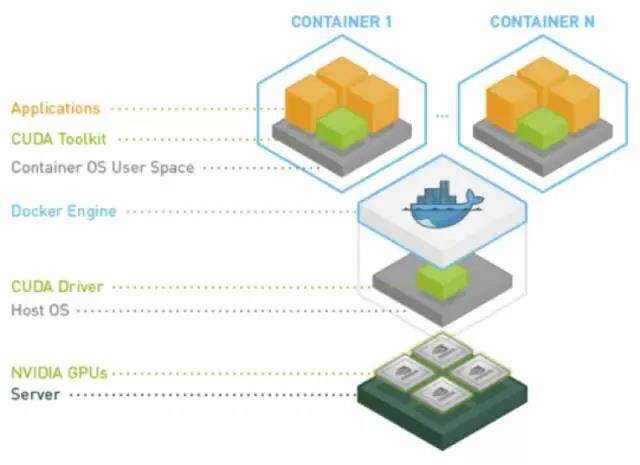

在设备已经可以绑定了之后,我们就可以提供 driver 和 CUDA 的支持了,而 Nvidia 给了一个关于如何在 container 层面支持 GPU 的原型,是基于 Docker 的,叫做 Nvidia Docker。

Nvidia Docker 所提供的功能:

支持 GPU 的 container 在 Nvidia Docker 里面的层级关系。

目前我们已经支持了如何在 container 的层面支持 GPU,但是这还远远不够在 container 编排环境里面支持 GPU,譬如我们在 Kubernetes 里面支持 GPU。

GPU in K8S:

在 Kubernetes 里面我们做一些关于 GPU 的工作才能让 GPU 能够被调度起来,功能如下:

GPU discovery.(kubelet):加入这个功能是为了能够让 Kubelet 在启动的同时就可以查找本机上的 GPU,而这个 GPU 消息可以发送给 apiserver,但 apiserver 里面有 GPU 的信息后,就可以通过 kube-scheduler 进行调度了。

GPUassignment/release. (kubelet):当一个 container 存在 GPU 需求的时候,我们可以通过 docker 的 --device 层面来支持对于 GPU 的 assign 和 release Resource API.(kube-apiserver/kube-scheduler):在 kube-scheduler 和 kubelet 之间需要一个关于 GPU 资源的协议支持,譬如目前有 CPU,memory 等,为了让 GPU 能够被调度,我们需要引入 GPU 作为一个资源可以被调度。

GPU in TensorFlow:

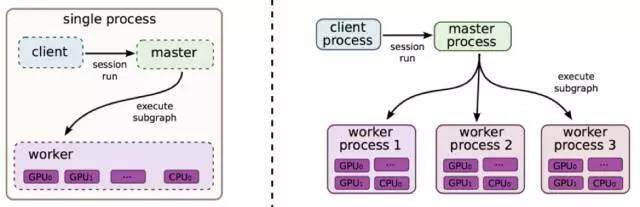

在分布式 TensorFlow 环境里面,各个 worker 不互相通信,只会跟 parameter server 通信。所以即使将各个 worker 部署到不同的机器上也不会造成性能损耗。目前 TensorFlow 支持 GPU 进行 training 的运算,但需要进行编译时设置。

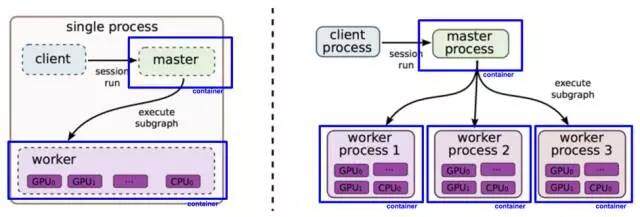

GPU in K8S + TensorFlow

由于在部署分布式 TensorFlow 时极其繁琐,并且在每次扩容都需要进行很多设置和操作。所以提供基于容器化的 TensorFlow 并运行在 Kubernetes 上就使其变得相当容易,而我们需要做的,就是在上面提到的如何让 Kubernetes 支持 GPU 的情况下,将 TensorFlow 容器化。

本文转载自才云 Caicloud 公众号。

原文链接:https://mp.weixin.qq.com/s/j8hcEjDvRGhvTGCc30mA6w

评论