毕业于清华 “姚班” 和普利斯顿大学的马腾宇是 AI 学界备受瞩目的青年翘楚。他目前在斯坦福大学计算机科学系与统计学系担任助理教授,专注于机器学习理论和算法研究,涉及非凸优化、深度学习、强化学习、表征学习等领域。马腾宇在 2018 年获得 ACM 最佳博士论文荣誉提名,并获得 COLT 2018 最佳论文奖和 NIPS 2016 最佳学生论文奖。

在本期 Robin.ly 独家专访中,马腾宇分享了他在 NeurIPS 2019 大会发表的论文亮点、ACM 获奖博士论文背后的研究工作、以及对 AI 未来研究方向的展望。

以下为完整访谈实录,点击“阅读原文”获取英文实录。

NeurIPS 2019 的论文亮点

Margaret Laffan(Robin.ly 主持人): 马博士,能跟我们介绍一下你目前的研究工作以及你在 这次 NeurIPS 2019 发表的五篇论文吗?

马腾宇:

我目前的研究重点是机器学习理论,尤其是深度学习理论,并致力于将理论知识转化为实际应用。在过去的两年中,我也一直在探索新的深度强化研究(Deep Reinforcement)。

这次 NeurIPS 大会接收的 5 篇论文中,有几篇探讨了深度学习算法的工作原理,以及如何利用理论研究改进算法的性能。

其中一篇名为 “Data-dependent Sample Complexity of Deep Neural Networks via Lipschitz Augmentation” 的论文重点介绍了为什么在存在大量参数的情况下,深度学习算法仍然可以泛化到从未见过的实例。这是目前深度学习领域的一个重要的开放研究方向,之前的一些常规理论在这些情况下并不适用。还有两篇论文是关于如何更快地训练算法以更好地进行泛化:一篇论文讨论了调整算法中学习速率/步长对泛化的重要性;另一篇是关于正则化 (Regularization) 的重要性和如何优化。

马腾宇博士(右)在 NeurIPS 2019 会场接受 Robin.ly 专访

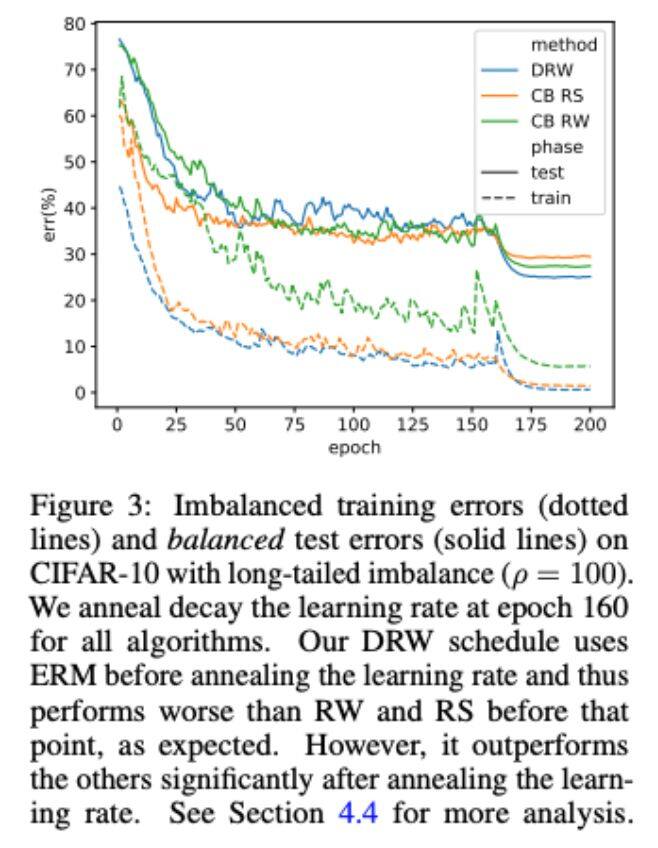

另外一篇题为 “Learning Imbalanced Datasets with Label-Distribution-Aware Margin Loss” 的论文也特别值得一提。这篇文章是研究如何针对不均衡的数据集,利用理论知识来设计实用算法,以改进生活中实际应用。业界的许多数据集不如我们常用的基准数据集(如 ImageNet、CIFAR)那样均衡 – 在某些情况下数据量很大,而另一些罕见低频事件的数据则少的可怜。以无人车为例,遇到鹿横穿马路的数据非常少,但这种情况的安全隐患很大。我们有必要让算法在此类涉及到安全的关键事件上有良好的表现,确保算法不仅适用于常见事件,也适用于罕见事件。

当前的总体解决思路是设计正则化方法 (Regularization)以提高对罕见事件的泛化能力。现有工具重新采样和优化的方法能够解决罕见事件的数据训练问题,但是这些结果会导致过度拟合,无法很好地泛化。我们这项工作就在试图解决这个问题。我们成功地改进了一些先前的简化算法,并在罕见事件的泛化结果上取得了明显的进步。

ACM 获奖论文:非凸优化研究

Margaret Laffan: 你的博士论文获得了 ACM 荣誉提名奖,能分享一下其中最重要的贡献吗?

马腾宇:

我的博士论文 “Non-convex Optimization for Machine Learning: Design, Analysis, and Understanding” 主要关注的是非凸优化研究。在 2012 - 2013 年我刚开始读博士的时候,深度学习新一轮的浪潮才刚刚兴起,我们开始意识到深度学习会是下一个大趋势。

理解深度学习算法原理的瓶颈之一是如何优化损失函数 (Loss Function),使其变得非凸。但是大多数现有的优化理论都将重点放在优化凸函数上,这不一定适用于深度学习。这项研究的目的就是了解为何我们可以实现非凸函数的优化 – 人们通常认为这是一个非常棘手的问题。

我在论文中还描述了在实际应用中损失函数的不同特征。我们针对这些特征可以相应的设计新算法或改进现有算法,而不仅仅局限于凸函数优化。除此之外,我们还分析了非凸模型的可解释性。对线性模型的解释相对容易,但是对于非线性模型和非凸模型,解释起来就比较困难。因此,论文的第二部分是关于如何在自然语言处理领域 (NLP)理解和解释这些非凸模型。

马腾宇(左二)获得 ACM 荣誉提名奖,来源:Michael Freedman

AI 研究发展方向

Margaret Laffan: 你如何看待 AI 研究未来的发展方向?你认为下一个重大突破会是什么?

马腾宇:

AI 包含很多不同的领域,但是至少从理论研究的角度来说,我觉得越来越多的工作正致力于深入挖掘深度学习的理论,探索不同模型的可解释性和可靠性。我认为在不久的将来,至少在相对标准的环境中,我们可以更好地理解深度学习的泛化和潜在的实际应用。

当然,我的观点可能存在一些个人偏见,但我认为这方面的研究会是下一个比较大的趋势。现在已经出现了对相关研究潜在社会影响的普遍担忧。我们专注技术突破的同时,也必须确保所有的算法在实际应用中都是安全、可靠、可解释的。

本文转载自 Robinly 公众号。

原文链接:https://mp.weixin.qq.com/s/KqrnZ4ZFsLfqK5EDByBfiw

评论