近日,美国麻省理工学院计算机科学与人工智能实验室(MIT CSAIL)发表了一篇名为《彩票假想:寻找稀疏、可训练的神经网络》(The Lottery Ticket Hypothesis: Finding Sparse, Trainable Neural Networks)的论文,详细解析了如何在保证精准度不打折扣的前提下缩小神经网络规模。经试验,这种方法最高可以将模型大小缩小 10 倍,甚至训练速度提高 3.5 倍,预测精度提高 3.5%。

深度神经网络是一种仿生物神经元的数学函数层,作为通用类型的 AI 架构,它们能够执行从自然语言处理到计算机视觉的各类任务。但这并不意味着它们无所不能。深度神经网络通常需要非常庞大和合适的大型语料库,即使是用最昂贵的专用硬件,也需要数天才能进行训练。

但这种情况可能将有所改变。麻省理工学院计算机科学与人工智能实验室(CSAIL)的科学家在一项新研究《彩票假想:寻找稀疏、可训练的神经网络”》中表示,深度神经网络包含的子网络可以缩小 10 倍,同时训练之后预测精度保持同等水平,甚至在某些情况下比原始网络速度更快。

这项成果将在新奥尔良举行的国际学习代表大会(ICLR)上发表,从大约 1,600 份提交论文中脱颖而出,被评为该会议两篇最佳论文之一。

“首先,如果不想初始网络那么大,为什么不能在一开始就创建一个大小适中的网络呢?”博士生和论文合著者 Jonathan Frankle 在一份声明中说。“通过神经网络,你可以对这个庞大的结构进行随机初始化,在经过对大量数据进行训练之后,它神奇地起作用了。这种大型结构就像你买了一大包彩票,但其中只有少量门票实际上会让你发财。然而,我们仍然需要一种技术,在不知道中奖号码之前找到中奖的幸运儿。“

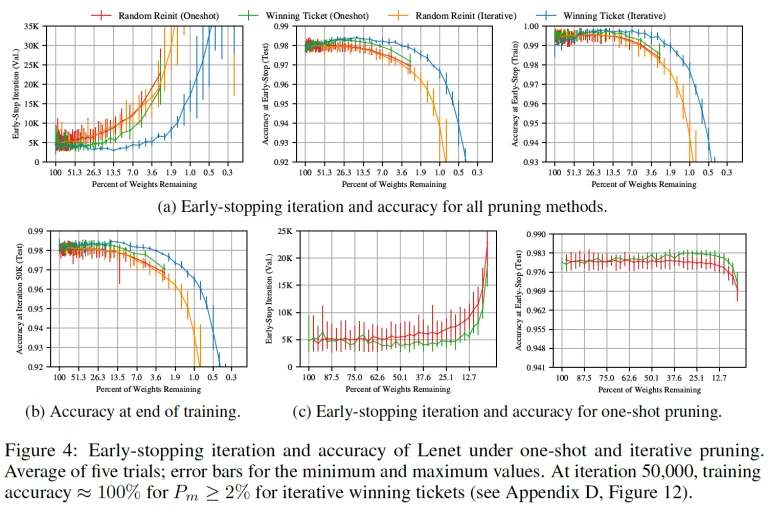

上图:在神经网络中查找子网 图片来源:麻省理工学院 CSAIL

规模缩小 10 倍,速度提高 3.5 倍,精度提高 3.5%

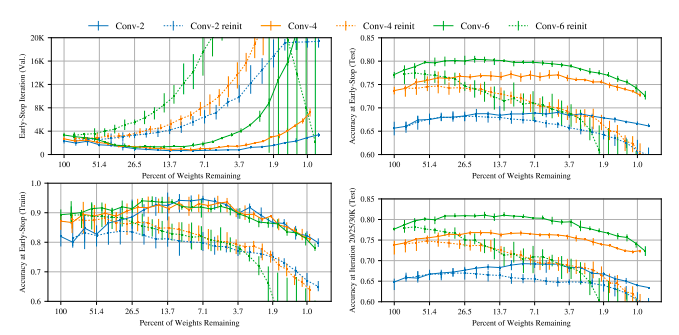

这里,我们将彩票假设应用于 CIFAR10 上的卷积网络,增加了学习问题的复杂性和网络的规模。我们考虑使用图 2 中的 Conv-2,Conv-4 和 Conv-6 架构,它们是 VGG 家族的缩小变体(Simonyan&Zisserman,2014)。网络有两个、四个或六个卷积层,后面是两个完全连接的层;每两个卷积层发生最大池化。这些网络范围广泛,包括将近到完全连接到传统卷积网络的类型,Conv-2 中卷积层的参数不到 1%,Conv-6.3 中的参数近三分之二。

寻找中奖彩票。上图中的实线表示来自每层修剪速率的 Conv-2(蓝色),Conv-4(橙色)和 Conv-6(绿色)的迭代彩票实验。

Lenet:随着网络被修剪,与原始网络相比,它学得更快,测试准确度也提高了。在这种情况下,结果更加明显。中奖彩票验证损失率达到最低,Conv-2 快 3.5 倍(Pm = 8.8%),Conv-4 快 3.5 倍(Pm = 9.2%),Conv-6 为 2.5x(Pm = 15.1%)。在精度度上,Conv-2 最高提高了 3.4%(Pm = 4.6%),Conv-4 提高 3.5%(Pm = 11.1%),Conv-6 提高 3.3%(Pm = 26.4%)。当 Pm> 2%时,所有三个网络都保持在其原始平均测试精度之上。

研究人员使用的方法涉及消除功能(或神经元)之间不必要的连接,使其适应低功率设备,这一过程通常称为修剪。(他们特别选择了具有最低“权重”的连接,这表明它们的重要性最低。)接下来,他们在没有修剪连接的情况下训练网络并重置权重,在修剪其他连接后,他们确定了可以在不影响模型预测能力的情况下删除多少连接。

在不同条件、不同网络上重复该过程数万次之后,报告显示他们的 AI 模型始终比其完全连接的母网络的规模小 10%到 20%。

“令人惊讶的是,重新设置一个表现良好的网络通常会带来更好的结果,”共同作者兼助理教授 Michael Carbin 说。“这表明,第一次的成果都不是最完美的,模型学会自我改进的空间还很大。”

Carbin 和 Frankle 指出,他们只考虑以较小数据集为中心和以视觉为中心的分类任务,未来,他们将探讨为什么某些子网特别擅长学习以及快速发现这些子网的方法。另外,他们认为这个结果可能对迁移学习产生影响,迁移学习技术可以训练针对某一任务的网络对另其他任务同样适用。

参考链接:https://arxiv.org/pdf/1803.03635.pdf

评论