外媒消息,当地时间11月19日,Cerebras Systems公司在Supercomputing 2019上正式推出搭载有 Cerebras WSE (史上最大的AI芯片)的计算产品Cerebras CS-1。目前,第一款CS-1 已经交付,并在美国能源部的 Argonne 国家实验室部署完成,Argonne将使用CS-1帮助发现癌症疗法并了解黑洞。

CS-1 的高度为 67 厘米,其性能是 Google TPU2 系统的三倍,后者占用的空间是前者的 29 倍

在 Supercomputing 2019 上,Cerebras Systems 公司推出了 CS-1,Cerebras Systems 的首席执行官 Andrew Feldman 表示,该系统是目前“最快的 AI 计算机”。

CS-1 旨在加快新型和大型神经网络的训练速度,该过程通常需要数周或更长时间,但 CS-1 却可以凭借 Cerebras WSE 将这项任务缩减至几分钟甚至几秒钟。虽然 Cerebras 声称一台 CS-1 可以提供超过 1000 个高性能 GPU 的性能,但 Cerebras 并没有提供根据标准 AI 基准(例如新的MLPerf标准)测试的性能数据。

Feldman 在接受VentureBeat采访时说到:“即使我们拥有最大、最快的芯片,但我们知道出色的处理器不一定能够提供优秀的性能,它需要构建一个专用的系统。就比如,您不能通过将法拉利发动机放入大众汽车中进而获得法拉利性能。”

换句话说,WSE 之类的高级处理器必须与专用的硬件系统和软件结合在一起,才能突破性能的瓶颈。正是因为这样,Cerebras CS-1 系统和 Cerebras 软件平台在各个方面都是为了加速 AI 计算而设计的。Cerebras 表示,CS-1 不仅从根本上减少了训练时间,而且为推理延迟设定了新的标准。对于深度神经网络,单个图像分类可以在几微秒内完成,比其他解决方案快数千倍。

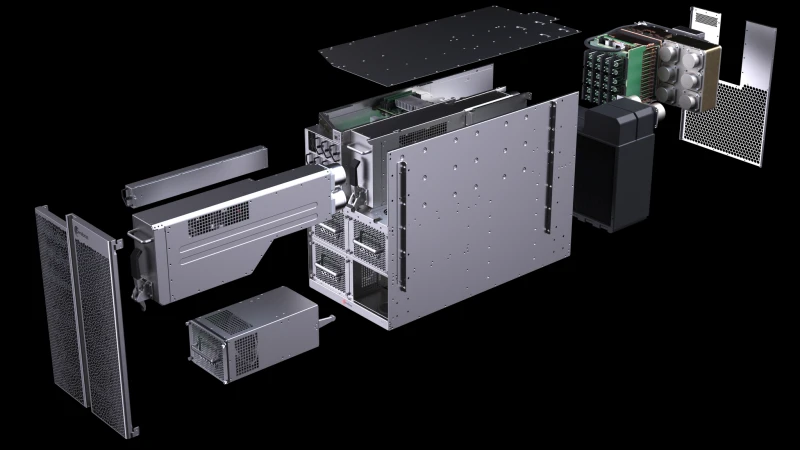

CS-1 拆解图

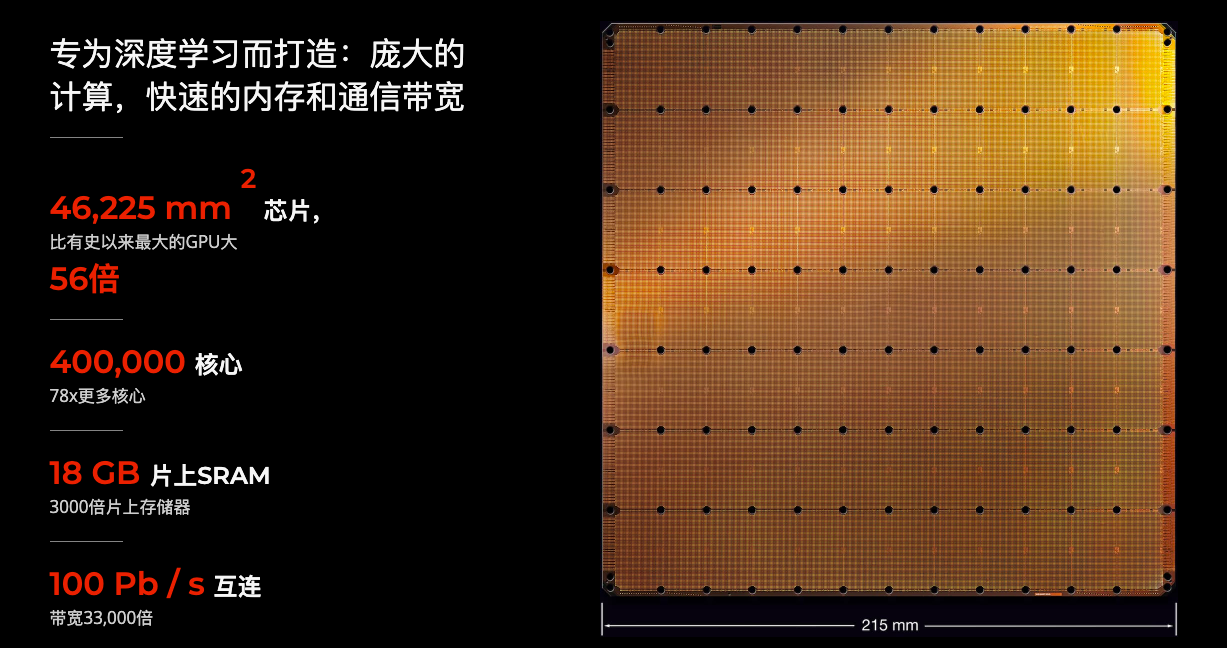

Cerebras WSE

Cerebras WSE 是全世界有史以来最大的 AI 芯片,由 Cerebras Systems 公司在今年 8 月份推出,这款芯片的面积为 462.25 平方厘米,拥有 1.2 万亿个晶体管和 40 万个优化内核,不仅面积是目前最大 Nvidia GPU 的近 60 倍,晶体管总数量也是后者的 50 余倍。

Feldman 声称:“虽然 GPU 非常优秀,但最初它是为了图形而设计的,并不是深度学习,但我们的系统在各个方面却是针对深度学习调整和优化的,所以我们的系统将与英伟达 GPU 产生激烈的竞争。”

CS-1 系统

Tirias Research 的首席分析师 Kevin Krewell 在一份声明中表示:“ CS-1 是一个单一系统,它可以提供比最大集群更高的性能,而没有集群设置和管理的开销。” 事实上,通过在单一系统中进行如此多的计算,CS-1 不仅可以缩短模型的训练时间,还能减少系统的整体部署时间,进而提升 AI 研究生产率。

GPU 集群通常需要数周或数月的设置,而且还有可能对现有的模型进行大量修改,并会消耗数十个数据中心机架,甚至还需要复杂的专有 InfiniBand 进行集群。CS-1 则完全不同,它的建立仅需要几分钟的时间。用户只需将基于标准的 100Gb 以太网链路插入交换机,就可以获得足够的算力,进行模型的训练。

Cerebras 软件平台

Cerebras 软件平台旨在让机器学习研究人员不更改现有工作流程的前提下,就可以充分利用 CS-1 的性能。他们可以使用行业标准的 ML 框架(例如 TensorFlow 和 PyTorch)为 CS-1 定义模型。

Cerebras 软件平台的图形编译器可自动将这些模型转换为 CS-1 的优化可执行文件,开发者可以通过平台利用丰富的工具集实现直观的模型调试和性能分析。

所以,总而言之,Cerebras 软件平台主要有四个部分:

ML框架集成,如TensorFlow和PyTorch。

脑图编辑器 Cerebras Graph Compiler(CGC)。

灵活的高性能内核库和内核API。

用于调试和性能分析的开发工具。

脑图编译器 Cerebras Graph Compiler

脑图编译器(CGC)将开发者指定的神经网络作为输入。为了获得最大的熟练度和灵活性,Cerebras 软件平台允许研究人员使用现有的 ML 框架,或是以其他编程语言(如 C、Python)编写的图形算法,来为 CS-1 编写代码。

CGC 通过从源语言中提取静态图形表示并将其转换为大脑线性代数中间表示(CLAIR),并开始将深度学习网络转换为优化后的可执行文件。随着 ML 框架快速发展以适应该领域的需求,这种一致的输入抽象允许 CGC 迅速支持新框架和性能,而不需要对底层编译器进行更改。

CGC 使用其独特的 WSE 体系结构知识,将计算和内存资源分配到图的每个部分,然后再将它们映射到计算数组。最后,将每个网络特有的通信路径配置到 fabric 上。

由于 WSE 的规模巨大,神经网络中的每一层都可以同时放置在结构上,并同时并行运算。这种实现全模型加速的方法是 WSE 独有的——没有其他设备有足够的片上内存在单个芯片上同时容纳所有层,也没有巨大的高带宽和低延迟通信优势,这些只有在 WSE 上才可能实现。

最终的结果是一个 CS-1 可执行文件,根据每个神经网络的独特需求进行定制,这样所有的 400,000 个计算内核和 18GB 的片上 SRAM 都可以最大限度地用于加速深度学习应用。

开发工具和 API

CGC 与流行的 ML 框架集成意味着像 TensorBoard 这样的流行工具可以“开箱即用”。此外,Cerebras 还提供了一套功能齐全的调试和分析工具,使深入的开发变得更加容易。

比如,Cerebras 提供了一个调试套件,它允许查看编译和培训运行的每个步骤。而对于需要更大灵活性和自定义功能的高级开发人员,Cerebras 提供了基于 LLVM 的内核 API 和 C / C ++编译器,允许用户为 CGC 编程自定义内核。结合大量的硬件文档、示例内核和内核开发的最佳实践,Cerebras 为用户提供了他们需要的工具来创建新的内核,以满足独特的研究需求。

评论