8 月 29 日凌晨,GLM 系列模型背后研究实验室的四位成员在 Reddit 上进行了一次 AMA,四人都参与了 GLM-4.5 的研发工作。这次,他们详细回答了全球社区者们对于 GLM 系列模型的技术细节问题、GLM 系列未来的研发规划,还与网友们讨论了当前大模型发展的观点。

参与这次 AMA 的四位成员分别是:

杜政晓(Zhengxiao Du)是《GLM: General Language Model Pretraining with Autoregressive Blank Infilling》(ACL 2022)等系列论文的作者之一,该论文奠定了 GLM 系列模型的发展基础。他参与了许多重要的 AI 项目,包括 GLM-130B、ChatGLM-MNN 等。

张宇轩(Yuxuan Zhang),毕业于利物浦大学,关注多模态模型研究、Agent 框架集成等,参与了多个 GLM 系列项目,包括 GLM-4.5、GLM-V、CogVideoX 等。

曾奥涵(Aohan Zeng)参与了多个项目,如 GLM-4-Voice、 GLM-130B 、emergent abilities 研究等。

李子玄(Zixuan Li),是《GLM-4.5: Agentic, Reasoning, and Coding (ARC) Foundation Models》的共同作者之一,该论文于今年 8 月发布,是 GLM 系列模型的最新版本。

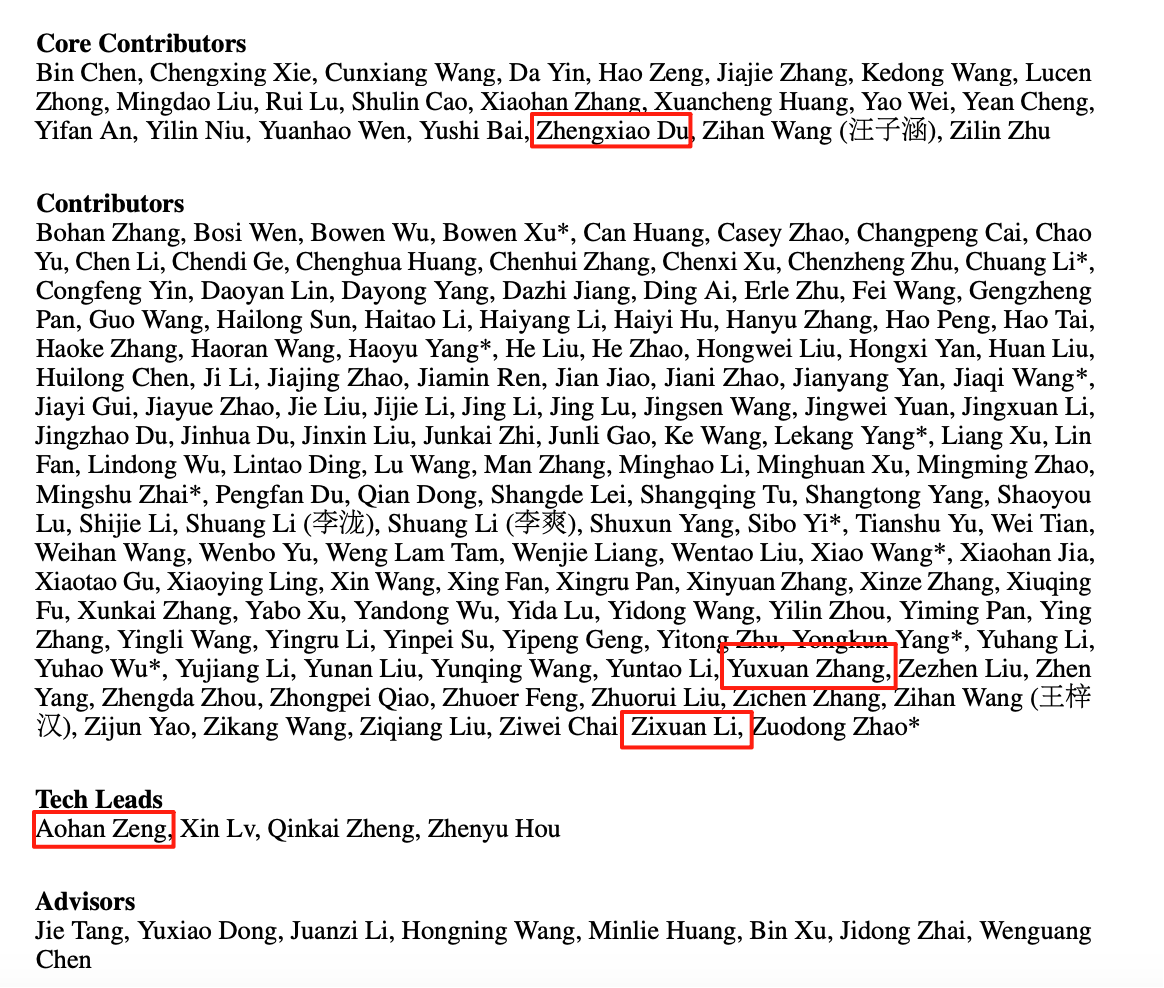

GLM-4.5 作者名单

他们透露,扩展上下文长度是 GLM-4.5 未来的重点。其出色的防幻觉能力源于有效的 RLHF 流程。在架构上,选择 GQA 而非 MLA 是出于性能考量,并对关键权重进行了特定的缩放初始化。

此外,智谱未来重点发展 MoE 模型,并发布更小参数的版本,表示大规模模型在智能体任务和知识储备上更具优势,稠密模型将专注于边缘设备。下一代模型将优先提升推理、编程和智能体能力。

下面是 AMA 具体内容,我们在不改变愿意基础进行了删减和编辑,以飨读者。

关于 GLM-4.5

Q:GLM-4.5 的上下文较短,是否会扩展?Qwen 3 已经实现了 25.6 万 token 的上下文窗口,甚至可扩展到 100 万 token。在需要 “长文本生成” 的任务中,GLM 4.5 的表现比 Qwen 3 甚至 Gemini 2.5 都要好得多,因此它一直是我最喜欢的模型之一。此外,会不会发布更小的模型?

杜政晓:是的,扩展上下文绝对是我们接下来的工作重点之一,目前正在推进相关研发。未来我们可能会推出更小参数的模型,可能是稠密模型,也可能是更小的混合专家模型。

Q:能不能介绍一下 GLM 4 9B 在预防幻觉方面为何如此出色?

曾奥涵:这很可能归功于我们行之有效的 RLHF(基于人类反馈的强化学习)流程,这有助于降低幻觉发生的几率。

Q:为什么在 GLM-4.5 中选择 GQA 而不是 MLA?初始化方式用了 muP 或是像 DeepSeek 那样采用 0.006 init 来进行初始化?

杜政晓:MLA 在解码阶段的计算量更大(因为它需要计算 512 维的点积),这在部分硬件上可能会成为性能瓶颈。

我们没有使用 muP 技术。权重方面,我们采用标准差为 0.02 的正态分布进行初始化;偏置则采用零初始化。对于注意力块和多层感知器(MLP)模块的输出层权重,我们额外进行了 1/sqrt(2.0 * num_layers) 的缩放。

Q:如何决定预训练语料库的规模?

杜政晓:取决于多个因素,包括数据过滤流程、算力资源,最重要的还是项目截止时间。

Q:你认为像 Anthropic 或者 OpenAI 这样的“SOTA”云模型,会比 GLM 拥有更多参数吗?换言之,你是否认同要想达到 SOTA 级别的智能,其参数规模必然同步扩大?

曾奥涵:我们相信前沿实验室的模型参数规模已经达到了万亿级别。根据观察,更好的预训练,包括扩展和改进数据工程,确实能够提升模型潜力。虽然我不确定 GPT-5 或者 Claude 4 的具体参数,但从实际部署成本和推理速度的角度来考虑,这些万亿模型可能会被精简成更小的版本来发布。

GLM 系列未来的“有”和“没有”

推理 or 非推理 ?

Q:AI 领域最近充斥着各种推理模型。你认为这会是唯一的发展方向吗?就个人体验,我觉得过度推理反而让很多任务的结果变差。另外,你如何看待 Daniel Saks 做出的断言,“未来在去于中心化的特定领域模型,这类模型将在特定领域带来超越人类的表现?”

曾奥涵:我们对推理还是很有信心,这也可以理解成在测试过程中充分利用更多算力的有效方法。理论上,深度思考模型至少不该比非思考模型更差。目前的问题是,思考模型的训练方法探索得可能还不充分,这也许可以解释为什么它们在某些任务上表现更差。

至于第二个问题,我认为从长远来看,通用模型和垂直模型将共存并且互为补充。通用模型可以通过更多强化学习加测试时间来扩展,最终进化为特定领域的专家模型。而这些专才模型反过来又能提供更好的数据以改进通用模型。

Q:你认为 AI 的未来在于推理模型,还是非推理模型?

曾奥涵:推理模型在测试期间可以运用更多算力资源、发挥更大潜力,但同时也会带来更严重的延迟。我认为推理模型和非推理模型各有适用之处,具体视任务而定。目前我们还没有找到一种理想方法,让推理模型得以适应所有场景。

Q:推理与非推理应该在同一模型中,还是分开?Qwen 3 最初将推理与非推理模式整合到同一模型中,但在最近的更新中改变了策略,理由是 “同一模型包含两种模式会导致整体输出质量下降”。你们对此有什么看法?

杜政晓:理想情况下,模型应能根据提示词自动决定是否启用推理模式。要实现这一点,将两种模式整合到同一模型中是更优选择。我认为,拆分出推理和非推理模型的做法,更多是出于团队管理层面的考虑,而非模型本身的需求。

Q:相比其他开源大模型,gpt-oss 的推理链更短、更简洁,特别是在数学任务上。这似乎是一种“压缩”推理链的方式,能否提升性能?未来 GLM 会改进吗?

杜政晓:我们注意到了这一点。缩短 CoT 长度是我们的待办事项之一。一种可能的办法是加入与 CoT 长度成反比的奖励信号。

Q:你们是否有打算发布一系列草稿模型,借以加速 GLM 4.5 Air 的推理速度?

曾奥涵:GLM-4.5-Air 本身已经包含一个 MTP 层,也可以理解为一种草稿模型。我们不确定训练特定领域的草稿模型是否会带来显著收益,但我们会持续研究。

Q:MTP 是一项非常酷的技术,可以大幅加速模型。但遗憾的是,目前主流的推理引擎都还没有支持这项技术。请问是否有计划向 VLLM / SGLANG / llama.cpp 提交补丁来实现 MTP?

张宇轩:我在提交给 vLLM 和 SGLang 的 PR 中,已经实现了 MTP。GLM-4.5 和 GLM-4.5-AIr 语言模型都带有 MTP。在 vLLM 和 SGLang 启动时会默认加载。我们欢迎开发者为 ollama 和 llamacpp 贡献代码,使其适配我们的模型。

是否发布更多模态魔性?

Q:你们有计划开发更多模态的模型,包括输入和输出?比如实时音频到音频,或者视频输入等。目前通过 API 的 GPT-4o-Realtime 表现其实已经非常出色(但价格极高),而且我觉得它在技术上并没有领先太多。4o 在大多数领域已经被开源权重模型超越,现在就差一个能够完全替代原生音频/视频的模型了,因为目前大多数自托管方案仍然依赖 STT→LLM→TTS 的流程。

李子玄:我们有一些多模态模型,但还没有达到 SOTA 水平。GLM-4.5V 刚刚发布,未来肯定会有所提升。

杜政晓:去年我们发布了 GLM-4-Voice,可以语音输入和输出。目前我们更专注于文本和视觉。

Q:构建一套多模态(视觉、文本和音频)模型有多难?主要问题是在数据上吗?多模态输出又是否困难?你们有没有计划推出这样的模型?

曾奥涵:我们认为构建全模态模型(视觉、文本和音频)涉及相当复杂的技术,包括处理不同模态的数据与相应架构。目前我们仍专注于 LLM 和 VLM,暂时没有足够的资源探索全模态模型。

Q:你们有没有同步研究其他技术,比如 diffusion?

曾奥涵:我们确实有探索文本扩散模型,但目前还未发现能够超越自回归 Transformer 架构的明显可能。

问:目前视觉模型已经越来越普遍,但几乎没有哪家厂商会把图像生成功能整合进大语言模型内。这很奇怪,毕竟 OpenAI 等头部大厂一直在宣传“全模态”,难道说图像模型生成的没办法融入当前架构吗?

曾奥涵:我认为在当前架构下,添加图像生成功能无法增加大模型智能,因此各厂商对这方面探索的动力不大。

更大参数模型 or 小模型?

Q:gpt-oss 120B 只有 50 亿活跃参数,远少于 GLM-4.5 Air。未来趋势会不会是更少活跃参数?

杜政晓:活跃参数量在代码、写作等现实任务中很重要,具体需根据模型的设计任务而定。

Q:最近人们对于蒸馏模型的关注度越来越高。你认为出于蒸馏目的(例如针对特定代码的模型)将超大模型“压缩”成特定小模型的作法合理吗?

曾奥涵:我们认为从万亿级模型中进行蒸馏确实是种可行的方法。当然,更大的模型往往容量更可观,在大多数任务中也仍然表现出色。相反,小模型可以通过蒸馏和更多强化学习,在某些任务上达成接近大模型的性能。

Q:英伟达有观点认为,小语言模型是代理式 AI 的未来发展方向,你们同意吗?

曾奥涵:我们也不确定。根据目前的观察,规模更大的模型在编写智能体任务时表现更好,也拥有更强大的知识储备来处理广泛的用户查询。

Q:有没有计划推出更小的 MoE 模型,类似 OSS-20B 或 30B-A3B 的模型?

李子玄:我们计划训练一个规模与 gpt-oss-20b 相当的较小 MoE 模型。

Q:你们如何看待小模型(小于等于 8B 参数)在工具调用/使用方面的表现?未来 Z AI 是否会推出自己的小模型?

曾奥涵:小模型在相对封闭的领域(例如天气查询)等可以有效使用工具,但在更复杂的领域(例如需要大量知识的编程智能体)则很难与体量更大的 MoE 模型相媲美。但我们确实会在未来考虑发布更小的 MoE 模型。

Q:GLM 4.5 在不少基准测试中名列前茅,但与较小的 gpt-oss-120B 等其他模型不同,它在跟 aider 工具协同使用时往往表现不佳,这是为什么?

曾奥涵:我认为问题在于数据覆盖范围。尽管引入了多样化的工具训练,但在某些框架下,其在某些领域的性能仍不够理想。我们正努力在未来版本中改进这一点。

Q:未来会训练大于 32B 的稠密模型吗?

杜政晓:目前没有计划。在这个规模上,MoE 模型更高效。稠密模型会聚焦在小规模和边缘设备场景。

“数据工程是关键”

Q:从零开始构建用于开发模型的训练数据有多难?你对这个问题怎么看?未来的评估方法是否会随时间推移而演进?

曾奥涵:从零开始构建训练数据并不太难,毕竟目前已经有 Nemotron-CC 这类高质量的开源数据可供使用。然而,前沿大模型往往还依赖更多专有数据源和处理技术,而这些只能靠时间来积累。

在评估文本输出时,使用大模型作为评判标准往往只能发现风格上的偏差、而非内容的正确性。在评估过程中引入标准答案或检查表有助于缓解这类情况。我们一般会避免使用大模型进行纯自主评估。

Q:英伟达认为目前的数据类型划分是否仍将存在,即 FP8 用于训练,而 FP4 对应更多推理用例?您的团队对于模型转换和量化怎么看?

曾奥涵:目前我们使用 BF16 精度进行训练,但也发布过 FP8 量化版本。我们使用训练数据进行 FP8 权重校准,因此量化几乎不会影响到准确率。我们会考虑把这种方法扩展至 MXFP4,但猜测使用 FP4 精度进行训练可能会带来一定风险。

Q:你们探讨的数据,指的是原始训练 token 吗?还是说在数据准备/过滤乃至合成方面也存在影响最终性能的差异因素?

曾奥涵:就预训练来讲,我们认为最大的差异在于原始训练 token 的总量和数据工程技巧。像谷歌这样的厂商拥有强大的搜索引擎功底,因此能够访问到远超 Common Crawl 等公共归档的更多数据源。这对于后训练、高质量标注(如复杂的数学问题和真实代码)同样有着直接影响。

Q:你认为哪些数据管理策略更有效,或者更具前景?

曾奥涵:更细致的数据工程才是关键,包括更丰富的数据源、更强大的解析器和更好的分类器。

开、闭源模型,差在资源上

Q:为什么选择开源?

杜政晓:我们在这个领域深耕已久,2022 年就发布了首个开源大模型 GLM-130B。开源权重能让更多人以自己喜欢的方式使用模型。

Q:相较于 GPT-5、Gemini、Claude 等前沿商业模型,你认为 GLM 4.5 和 Kimi K2 这类开放权重模型到底有何不同?要想追及或超越那些封闭模型,开源阵营还需要做出哪些改变?

曾奥涵:我很高兴看到开放权重模型正在赶超前沿模型。我认为最主要的差距仍在于资源,包括算力资源和数据资源。就整体能力而言,开源模型与商业模型的差距将继续缩小,甚至有望在某些领域实现反超。

Q:智谱是否会尝试非 Transformer 架构的模型?以及更多面向现实场景而非基准测试的模型?

杜政晓:目前没有这方面计划,但我们在密切关注相关进展。我们会继续优化 GLM 在写作、角色扮演、聊天等场景的表现,同时推理和代码能力仍然很重要。

Q:能否分享一些技巧,如何利用大模型裁判在非可验证领域实现有效的结果验证?

杜政晓:根据我的经验,大语言模型作为裁判时,对输出结果的分布非常敏感,有时还会引入意想不到的偏差。因此,通过提示词或微调让裁判结果与人类判断对齐至关重要。

Q:是否研究过线性或次二次注意力?

杜政晓:随着上下文变长,高效注意力机制会越来越重要。我们观察到,线性注意力模型对超参数比传统模型更敏感。

Q:对不同的分词器(tokenizer)设计有何看法?

曾奥涵:我对全模态领域并不太熟悉,但据我所知,虽然使用离散分词器将所有模态转换为分词的实施难度较低,但对于图像等非文本模态,将其转换成离散分词可能无法实现最佳性能。用于视频的 bit 级分词器往往效率低下,无法有效利用帧之间的相似性进行压缩。

Q:如何提升模型写作能力?优秀的分词器有多重要?

杜政晓:现有 MoE 模型容量足以兼顾创意写作与事实回答,但需要精心设计的后训练流程。 好的分词器能缩短序列长度,在某些情况下提升准确率。我们正在改进分词器的压缩率。

Q:来自最新的 Deepseek v3.1,他们提到尝试在华为硬件上进行训练。请问智谱有没有使用非 Nvidia 硬件进行训练或推理?

李子玄:推理和部分训练阶段完全是可行的,这是公开信息。

PPT 生成引关注

Q:你们网站上的那个 PPT 生成器真的非常酷。能不能考虑什么时候支持直接导出 PPTX?

张宇轩:目前还不支持。所有导出都是 PDF 格式。我们的 PPT 是直接由 HTML 渲染的,这与传统 PPTX 的生成方式不同。

李子玄:我们内部有一个 PPTX 导出的测试版,但将 HTML/PDF 转换成 PPTX 非常困难。我们会进一步评估,如果部分用户觉得质量可以接受,可能会发布这个测试版。

Q:这个模型是专门针对 PPT 生成进行微调的吗?背后是不是还有一个更复杂的框架,还是主要就是用 prompt 去让它生成特定尺寸的 HTML?

李子玄:它比单纯的 prompt 要复杂一些。虽然前端设计感是基础,但智谱结合了搜索和 HTML 页面整理的工具。模型具备内部化能力,可以自主决定何时以及多大程度上使用这些工具来生成最终的 PPT。

Q:你知道的表现最好的开源 CLI Agent / GLM 模型组合是什么?

李子玄:我推荐 Open Code + GLM-4.5。如果对开源没有严格要求,也可以尝试 Claude Code + GLM-4.5。我们很快会推出一个月度订阅套餐,让你在 Claude Code 上订阅 GLM-4.5,而无需按 Token 付费。

Q:我们会在 Z.ai 上看到 AutoGLM 吗?

李子玄:AutoGLM 是一款独立的产品,目前在中国可用。如果全球需求高,我们会推出国际版。

Q:我没有使用 GLM 4.5 进行氛围编程,不是因为模型本身不好,而是因为我找不到合适的 API 提供商。GLM 已经非常好了,唯一的遗憾就是不支持前端开发常用的图像输入功能。

曾奥涵:感谢你的反馈,生成速度对于氛围编程至关重要,我们也将继续改进自己的部署技术。

未来迭代方向

Q:GLM 的下一轮迭代将优先考虑哪些领域?

曾奥涵:推理、编程和智能体。

Q:你觉得 GLM 模型最大的改进潜力在哪个方向?更多/更好的预训练、架构改进、强化学习,还是算力扩展?

曾奥涵:我认为这些方面都有改进的空间。我们已经看到了扩展预训练数据和算力规模带来的收益,也相信 GLM 4.5 之后仍有进一步优化的空间。在架构方面,注意力机制还需要有效改进,以容纳更长的上下文。对于现实世界的编程和智能体任务,强化学习方面的探索空间也不少,其中最重要的则是提升泛化能力。

Q:你们今年还有计划发布其他模型吗?

曾奥涵:还没有明确的时间表,但我们会尽快发布新模型。敬请期待!

Q:你们认为如今构建新型基础模型的最大瓶颈是什么? 作为一个希望创建新基础模型的小型专家团队,从“想法”到“获得可信度”的路径如今应该是怎样的?

李子玄:我认为不存在统一的瓶颈,不同实验室面临的障碍各不相同。事实上,我们并非一个新团队。如果您搜索首篇 GLM 相关论文就会发现,我们是全球最早投身大模型研究的团队之一。我们的许多成果,都源于长期且持续的积累过程。

不过从理念层面来说,我个人认为有两点至关重要。一是追求卓越:要尽可能将手头能获取的所有资源用到极致;二是尊重该领域的基本规律:科研领域几乎不存在捷径,许多看似极具想象力的创新,实际上都源自扎实的实验结果。

Q:外界经常说中国只是跟随创新,实际上开源权重模型到目前为止落后于闭源模型,但这种差距似乎正在缩小。你同意这种看法吗?

李子玄:模型的性能和创新是相关但不同的方面。模型的性能可能受到多种因素影响,比如算力和数据的可用性。至于创新本身,许多有价值的贡献来自开源社区。GLM-4.5 训练中使用的 “slime” 框架就是一个例子,而来自中国的这种创新趋势看起来还会持续下去。

Q:你们招人吗?加入需要什么条件?

张宇轩:我们目前正在招聘。你可以在 Boss 或公司官网查看职位描述(JD)。

参考链接:

https://www.reddit.com/r/LocalLLaMA/comments/1n2ghx4/ama_with_zai_the_lab_behind_glm_models/