我们很高兴能够介绍 TensorFlow 中的神经结构学习(Neural Structured Learning in TensorFlow),这是一套易于上手的框架,新手以及高级开发人员都能利用它训练具有结构化信号的神经网络。神经结构学习(NSL)可用于构建精确且健壮的视觉与语言理解及预测模型。

目前,众多机器学习任务得益于结构化数据的支持,这类数据当中包含丰富的样本间关系信息。例如,建模引文网络、知识图推理以及句子语言结构推理,乃至分子指纹学习等,都需要通过一套模型学习结构化输入信号,而非逐一分析单个样本,进而明确给出结构化(例如以图形形式)或者隐式(例如对抗性示例)推理结果。在训练期间采用结构化信号,也使得开发人员能够获得更高的模型精度,这一点在标记数据量相对较少显得尤为重要。结构化信号的训练也能够带来更强大的模型成果。目前,谷歌公司已经开始广泛采用这项技术提高模型性能,例如学习图像语义嵌入等场景。

神经结构学习(NSL)是一套开源框架,负责利用结构化信号训练深度神经网络。它能够实现神经图学习,使得开发人员得以利用图表训练神经网络。这些图表可以来自多种来源,例如知识图、医疗记录、基因组数据或者多模关系(例如图像-文本对)等。NSL 还可延伸至对抗学习领域,其中各输入实例间的结构以对抗性扰动方式动态构建而成。

NSL 帮助 TensorFlow 用户轻松将各类结构化信号结合起来,共同用于训练神经网络,同时适用于多种不同的学习场景,包括监督、半监督与无监督(表示)等设置。

神经结构学习(NSL)的工作原理

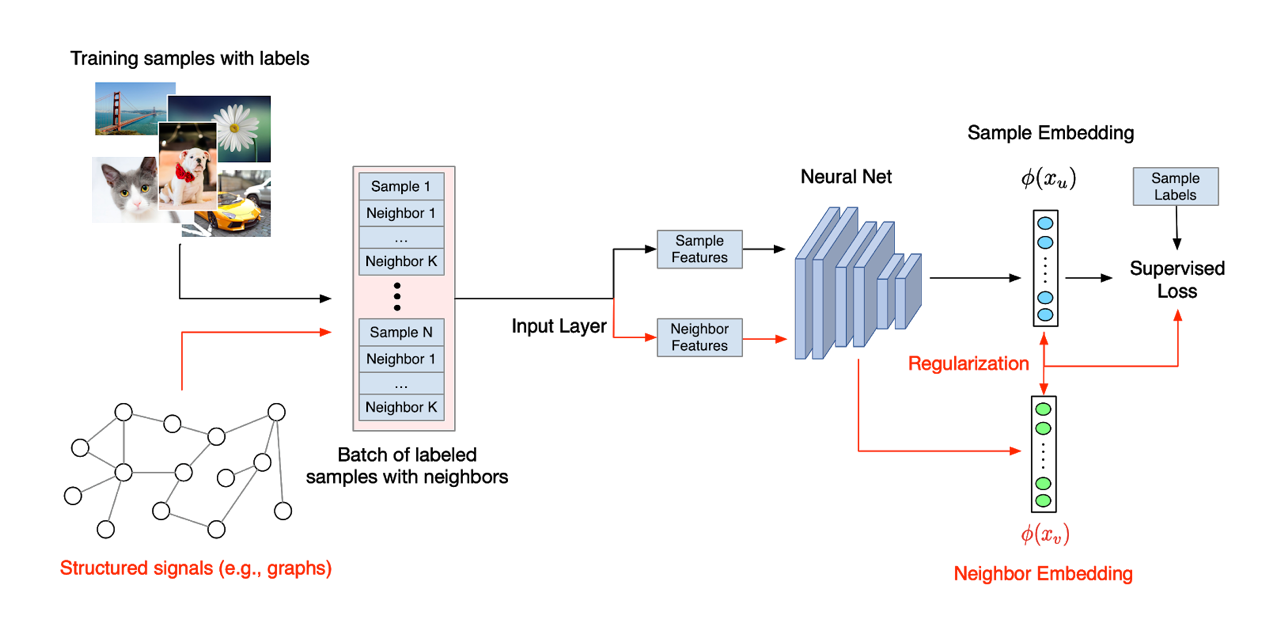

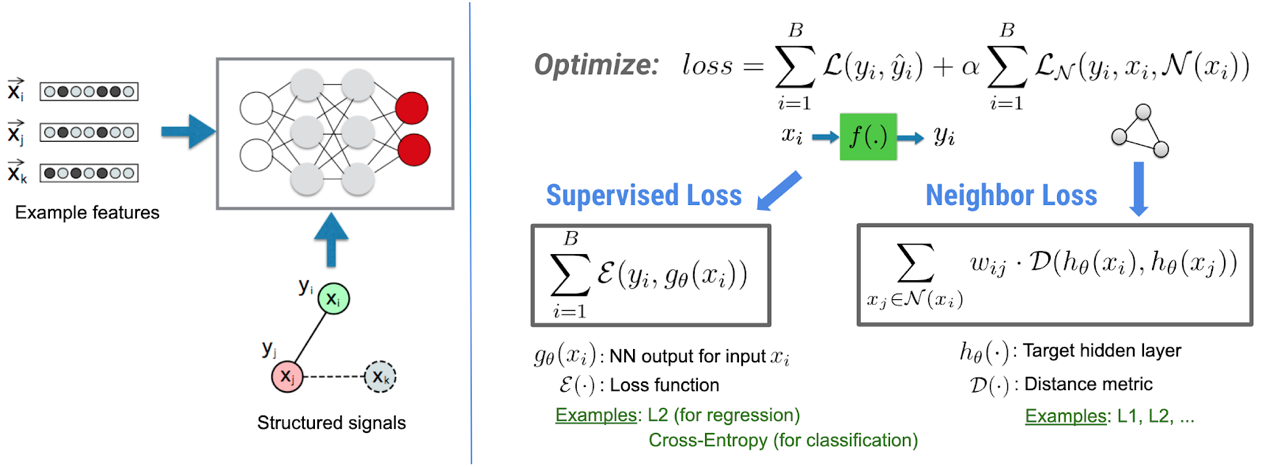

在神经结构学习(NSL)当中,结构化信号——无论是经过明确定义的图形,还是隐式学习性质的对抗性实例——都能够用于规范神经网络的训练。这将引导模型学会做出准确的预测(通过监督损失最小化),同时保证来自同一结构的输入之间具有相似性(通过相邻损失最小化,见上图)。这项技术具有通用性质,可用于任意神经架构,包括前馈神经网络、卷积神经网络以及递归神经网络等等。

利用神经结构学习(NSL)创建模型

利用 NSL,我们可以构建起模型,并确保其轻松直接地使用结构化信号。对于给定的图形(作为显式结构)以及训练亲本,NSL 提供一款专用工具,可处理这些示例并将其整合至 TFRecords 中以进行下游训练:

接下来,NSL 提供“环绕”该定制模型的 API,用于消费已处理示例并实现图形正则化。下面我们直接来看代码示例。

只需要不到 5 千行额外代码(是的,包括注释!),我们就获得了一套能够在训练期间利用图形信号的神经模型。根据以往经验,使用图形结构将确保模型通过标记程度较低的数据进行训练,且不致损失太多准确率(例如,相较于原始监督训练,只损失 10%甚至 1%准确率)。

如果没有显式结构,该怎么办?

如果没有显式结构(例如图形),或者无法将其作为输入内容,该怎么办?NSL 为开发人员提供了利用原始数据构建图形的工具;此外,NSL 还提供 API 将对抗性示例“引导”为隐式结构化信号。利用对抗性示例对模型进行混淆性训练,通常会使模型对小幅输入扰动表现出更强的健壮性。我们将通过以下代码救命,了解 NSL 如何通过对抗性示例进行训练。

只需要不足 5 行额外代码(同样包括注释在内),我们就获得了一套神经模型。该模型能够利用具有隐式结构的对抗性示例完成训练。根据以往经验,在训练中未使用对抗性示例的模型,往往会在遭遇恶意(且人类无法检测到)扰动等输入内容时发生显著的准确率损失(例如下降 30%)。

试用 NSL 可以访问

https://www.tensorflow.org/neural_structured_learning/

原文链接:

https://medium.com/tensorflow/introducing-neural-structured-learning-in-tensorflow-5a802efd7afd

评论