OpenAI 计划推出新功能吸引开发者,称开发成本最高降低 20 倍

近日,路透社援引消息人士称,为了吸引更多企业和开发者更多地使用其技术,OpenAI 计划下个月为旗下的 AI 产品推出重大更新,以便开发者们能够更便宜、更快速地构建基于其 AI 模型的软件应用程序。

这些更新包括在其开发工具中添加内存存储。理论上,这可以将应用程序制造商的开发成本削减多达 20 倍,解决合作伙伴们对于价格的担忧。

此外,OpenAI 还计划推出视觉功能等新工具,使开发人员能够构建具有分析图像和描述图像能力的应用程序,并希望将这些技术应用于娱乐、医学等众多领域。为开发人员提供这个工具也标志着 OpenAI 在推出多模态功能这条路上迈出了重要一步,该功能可以处理和生成除文本之外的不同类型的媒体,例如图像、音频和视频。

消息人士称,这些新功能预计将于 11 月 6 日在旧金山举行的 OpenAI 首届开发者大会上推出。

对于上述消息,OpenAI 拒绝置评。

一直以来,让 OpenAI 成为其他公司构建应用程序所不可或缺的元素,是公司 CEO Altman 最重要的战略目标之一,但最近该公司在吸引外部人士利用其技术开展业务方面面临着一些挑战。

今年早些时候,OpenAI 匆忙发布了 ChatGPT 插件 Scholar AI,这是允许开发人员在 ChatGPT 内创建应用程序的附加工具。OpenAI 希望插件能够像苹果的 iOS 应用商店一样受欢迎,从而获得比谷歌 Bard 等竞争对手更大的优势。

但这款插件被不少开发者视为一场“作秀”,并没有砸起多少水花。据该插件的开发者 Lakshya Bakshi 统计,截至 8 月底,Scholar AI 插件每天仅有约 7000 名用户,而 ChatGPT 每月吸引约 1.8 亿活跃用户。

Altman 公开承认还有更多工作要做。今年早些时候,Altman 在伦敦向一群开发人员承认,插件尚未获得市场关注。

此外,Altman 还亲自与一些开发者交谈,表达了他希望基于 OpenAI 模型构建新生态系统的愿望,虽然其模型现已融入从 DoorDash 到写作助手 Jasper 等无数应用程序中,但距离 Altman 的预期还有一段距离。

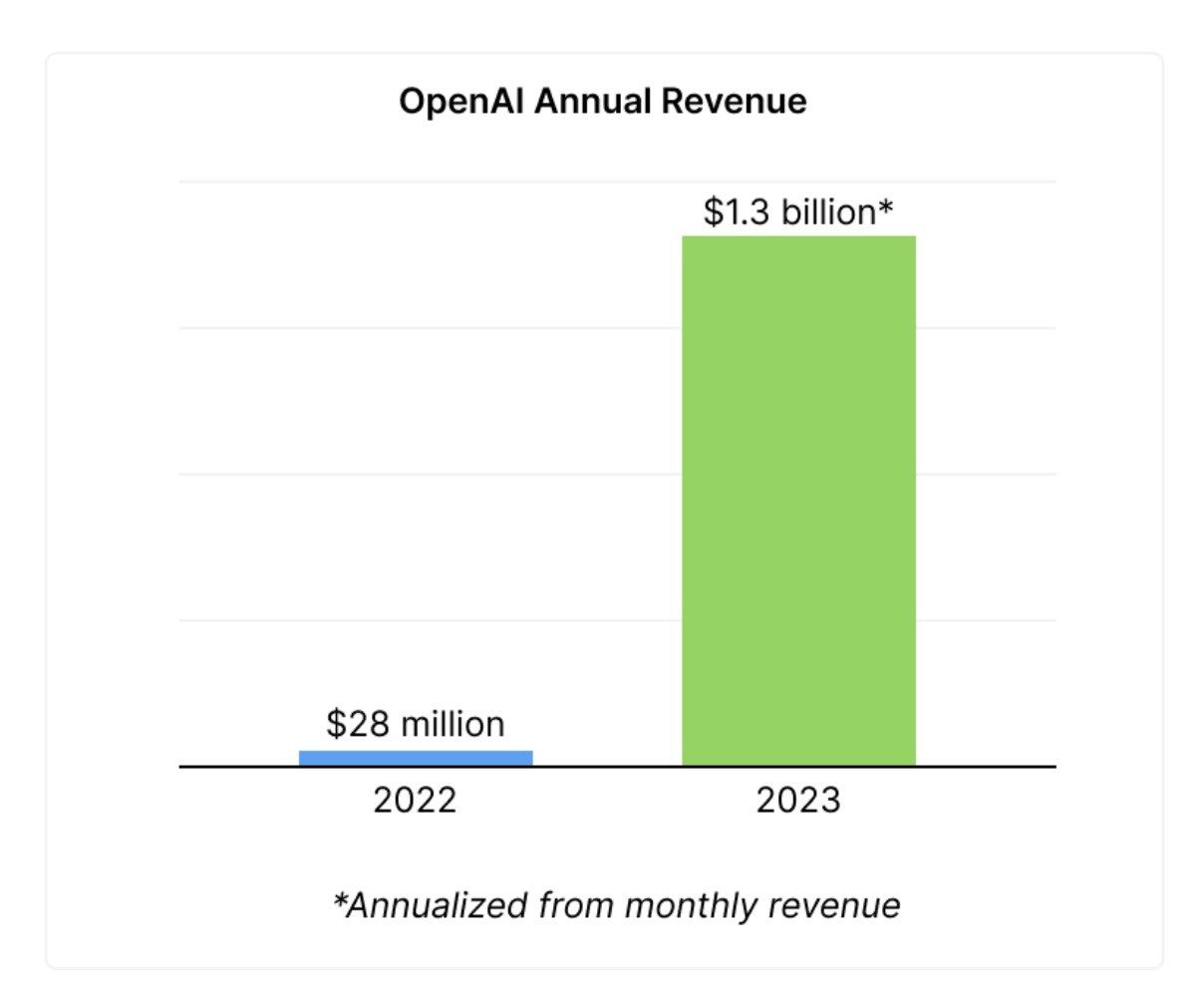

年收入已突破 13 亿美元,OpenAI 即将盈利了?

在忙着让构建 OpenAI 模型新生态之余,Altman 对于 OpenAI 的营收能力也十分关注。据 The Information 报道,Altman 本周告诉员工,OpenAI 的年收入现已突破 13 亿美元。这意味着该公司每月的收入超过 1 亿美元,比去年夏天增长了 30%。

值得注意的是,OpenAI 2022 年全年的总收入仅为 2800 万美元。

自从二月份推出付费版本的 ChatGPT 以来,OpenAI 的财务增长可谓飞速增长。此外,该公司还于 8 月宣布推出 ChatGPT Enterprise,这是其面向商业用户的流行对话式 AI 聊天机器人的商业版本。

也许单独来看,作为一家聚光灯下的人工智能独角兽企业,OpenAI 的收入并不算高,但如果对比风头最接近 OpenAI 的竞争对手 Anthropic 的收入来看,OpenAI 如今 13 亿美元的年收入还是比较有说服力的。

上周,据外媒报道称,Anthropic 正寻求再融资 20 亿美元,估值为 20 至 300 亿美元。然而,Anthropic 公司的年化收入仅达到 1 亿美元,即每月约 800 万美元。

虽然两家公司都提供同类型的产品,但 ChatGPT 的市场成功目前已经推动 OpenAI 遥遥领先。微软、Stripe、沃尔沃和宜家等大型企业已经在使用 OpenAI 的大语言模型产品构建自家应用。

收入的大幅增长可能会在即将到来的要约收购中推高 OpenAI 的私人估值。据《华尔街日报》报道,该公司的总估值可能很快就会达到令人瞠目的 80 至 900 亿美元。

目前,尽管来自谷歌和 Anthropic 的竞争不断涌现,OpenAI 似乎仍将保持势头。但维持长期增长可能需要解决开发和运行大语言模型的高计算成本问题。

尽管如此,对于一家去年仅产生 2800 万美元收入的公司来说,OpenAI 在短短几个月内收入激增至 13 亿美元,这已经是一个巨大的成功故事。这家初创公司的持续增长凸显了大型语言模型的颠覆性潜力。

此外,大模型的潜力还体现在与云基础设施成本对比上的优势。

国外的一家大语言模型团队最近一直在使用 GPT 微调API 进行实验。他们指出,GPT-3.5 上的一次微调运行成本为 4~12 美元,并且需要大约 1~1.5 小时才能微调超过 100 万个 tokens。

与此同时,AWS 上单个 p4d.24xlarge 按需收费为每小时 32.77 美元,如果预订 1 年则为每小时 19.22 美元。每台机器都配备 8 个 Nvidia A100 GPU。假设 OpenAI 仅使用 8 个 GPU 来微调 GPT-3.5,那么使用 OpenAI 比从 Amazon 租用 GPU 便宜 3-8 倍,甚至无需具备在云上部署和运行作业所需的技术专业知识。

可见,大模型提供商的优势不仅在于模型的质量,还在于他们以极端规模成本优势提供模型服务的能力。

风光背后,科技巨头也深陷 AI 盈利难困局

然而,虽然大模型有着诸多方面的优势,但想依靠大模型盈利在现阶段却并非容易事。

据《华尔街日报》报道,微软和谷歌等大型科技公司正在努力应对将 ChatGPT 等人工智能产品转变为盈利企业的挑战。尽管公司大力投资可以生成业务备忘录或代码的 AI 技术,但运行高级 AI 模型的成本被证明是一个重大障碍。某些服务(例如 Microsoft 的 GitHub Copilot)会造成重大运营损失。

用于创建文本的生成式人工智能模型的运行成本并不便宜。像为 ChatGPT 提供支持的大型语言模型需要配备高端、耗能芯片的强大服务器。例如,路透社的一份报告指出,每个 ChatGPT 查询的运行成本可能为 4 美分。因此,AWS 首席执行官 Adam Selipsky 向《华尔街日报》表示,许多企业客户对这些 AI 模型的高运行成本感到不满。

当前的成本挑战与 AI 计算的性质有关,与享有规模经济的标准软件不同,AI 计算通常需要为每个查询进行新的计算。这使得 AI 服务的固定费用模式存在风险,因为增加客户使用量可能会增加运营成本并导致公司潜在损失。

一些公司正在努力降低成本,而另一些公司则继续加大对技术的投资。微软和谷歌已对其现有软件服务引入了更昂贵的 AI 支持的升级,而据报道,Zoom 试图通过有时使用不太复杂的内部人 AI 型来执行某些任务来降低成本。Adobe 正在通过活动上限和根据使用情况收费来解决这个问题,而微软和谷歌通常坚持固定费用。

微软企业战略主管克里斯·杨(Chris Young)认为,在人们找出 AI 的最佳使用方式之前,AI 的投资回报将需要更多时间。他告诉媒体:“显然,我们现在必须将用户的兴趣转化为真正的采用。”

值得注意的是,《华尔街日报》的报道称,微软的 GitHub Copilot 通过生成代码来帮助应用程序开发人员,尽管吸引了超过 150 万用户并集成了近一半的编码项目,但该公司一直处于亏损状态。据一位知情人士透露,用户每月为该服务支付 10 美元的固定费用,但微软为每个用户每月平均支付的费用超过 20 美元。在某些情况下,个人高级用户每月给公司带来的费用高达 80 美元。

AI 服务如此昂贵的原因之一是一些公司一直在寻求最强大的 AI 模型。例如,微软使用 OpenAI 最复杂的 GPT-4 来实现其许多 AI 功能。GPT-4 是最大且最昂贵的 AI 模型之一,需要大量的算力。《华尔街日报》打趣道,使用该模型执行总结电子邮件等基本任务就像“让兰博基尼送披萨”,这表明使用最强大的人工智能模型来完成简单的任务可能有些过头了。

沿着这些思路,微软一直在为其 Bing Chat 搜索引擎助手探索成本更低的替代方案,包括 Meta 的 Llama 2 语言模型。然而,随着时间的推移,由于 AI 加速硬件的进步,运行这些复杂模型的成本可能会下降。但这段时间到底是多久,谁都无法确定。

参考链接:

https://generatingconversation.substack.com/p/openai-is-too-cheap-to-beat

https://arstechnica.com/information-technology/2023/10/so-far-ai-hasnt-been-profitable-for-big-tech/

公众号推荐:

跳进 AI 的奇妙世界,一起探索未来工作的新风貌!想要深入了解 AI 如何成为产业创新的新引擎?好奇哪些城市正成为 AI 人才的新磁场?《中国生成式 AI 开发者洞察 2024》由 InfoQ 研究中心精心打造,为你深度解锁生成式 AI 领域的最新开发者动态。无论你是资深研发者,还是对生成式 AI 充满好奇的新手,这份报告都是你不可错过的知识宝典。欢迎大家扫码关注「AI前线」公众号,回复「开发者洞察」领取。

评论 1 条评论