写点什么

创作场景

- 记录自己日常工作的实践、心得

- 发表对生活和职场的感悟

- 针对感兴趣的事件发表随笔或者杂谈

- 从 0 到 1 详细介绍你掌握的一门语言、一个技术,或者一个兴趣、爱好

- 或者,就直接把你的个人博客、公众号直接搬到这里

登录/注册

收录了 avro 频道下的 50 篇内容

Boris Lublinsky介绍了Avro,并评估了其在模式组件化、继承和多态方面的应用。他还讨论了向后兼容性问题,以及Avro对这个问题的解决方案。

Microsoft发布了他们自己对Apache Avro通信协议的实现。Avro被描述为“紧凑的二进制数据序列化格式,类似于Thrift或者Protocol Buffers”,同时还有像Hadoop这样的分布式处理环境所需要的额外功能。

2019年4月4日,Avro2TF正式开源。该项目提供了一种可伸缩的基于spark的机制,可以有效地将数据转换为TensorFlow可以轻松使用的格式。使用这种技术,开发人员可以更专注于构建模型而不是转换数据,从而提高生产率。

亚马逊云科技宣布,在预置模式下,在利用Apache Kafka事件源映射(ESM)时,AWS Lambda原生支持Apache Avro和Protocol Buffers(Protobuf)格式事件。

编者按:Hadoop于2006年1月28日诞生,至今已有10年,它改变了企业对数据的存储、处理和分析的过程,加速了大数据的发展,形成了自己的极其火爆的技术生态圈,并受到非常广泛的应用。在2016年Hadoop十岁生日之际,InfoQ策划了一个Hadoop热点系列文章,为大家梳理Hadoop这十年的变化,技术圈的生态状况,回顾以前,激励以后。本文整理自去年4月份的QCon大会演讲“以Hadoop为核心的大数据开放平台建设”。

这篇文章将告诉我们如何正确地使用消息的序列化格式,以及如何在Kafka Connect连接器中对其进行标准化。

Hadoop 作为MR 的开源实现,一直以动态运行解析文件格式并获得比MPP数据库快上几倍的装载速度为优势。不过,MPP数据库社区也一直批评Hadoop由于文件格式并非为特定目的而建,因此序列化和反序列化的成本过高。本文介绍Hadoop目前已有的几种文件格式,分析其特点、开销及使用场景。希望加深读者对Hadoop文件格式及其影响性能的因素的理解。

序列化和反序列化几乎是工程师们每天都要面对的事情,但是要精确掌握这两个概念并不容易:一方面,它们往往作为框架的一部分出现而湮没在框架之中;另一方面,它们会以其他更容易理解的概念出现,例如加密、持久化。然而,序列化和反序列化的选型却是系统设计或重构一个重要的环节,在分布式、大数据量系统设计里面更为显著。恰当的序列化协议不仅可以提高系统的通用性、强健性、安全性、优化系统性能,而且会让系统更加易于调试、便于扩展。本文从多个角度去分析和讲解“序列化和反序列化”,并对比了当前流行的几种序列化协议,期望对读者做序列化选型有所帮助。

实现强大的搜索能力——从设计决策到幕后的一切

最近一直在研究如果提高kafka中读取效率,之前一直使用字符串的方式将数据写入到kafka中。当数据将特别大的时候发现效率不是很好,偶然之间接触到了Avro序列化,发现kafka也是支持Avro的方式于是就有了本篇文章。

这是关于Yelp的实时流数据基础设施系列文章的第三篇。这个系列会深度讲解我们如何用“确保只有一次”的方式把MySQL数据库中的改动实时地以流的方式传输出去,我们如何自动跟踪表模式变化,如何处理和转换流,以及最终如何把这些数据存储到Redshift或Salesforce之类的数据仓库中去。这一篇主要介绍Schematizer,Yelp的模式存储服务。

在这篇文章里,我将分享如何通过扩展KCache来实现一个全功能的关系型数据库,我把这个数据库叫作KarelDB。

如果你使用了像Kafka这样的流式处理平台,就要搞清楚一件事情:你需要用到哪些主题?特别是如果你要将一堆不同的事件作为消息发布到Kafka,你是要将它们放在同一个主题中,还是将它们拆分到不同的主题中?

将数据存储在 Amazon S3 中会在扩展、可靠性和成本效益方面提供很多优势。

“曾经的我对技术一窍不通,但现在我已经掌握编程能力、开始努力争取自己的计算自主权。虽然还有很长的路要走,但我至少已经迈开了步伐。”

作为 Uber 其他软件(例如Marmaray和Hudi)的补充,DBEvents 从 MySQL、Apache Cassandra 和 Schemaless 中获取数据,以更新我们的 Hadoop 数据湖。

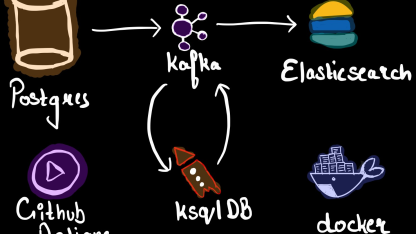

在本文中,作者Robin Moffatt展示了如何借助一个电商实例应用程序使用Apache Kafka和KSQL构建数据集成和处理应用程序。本文讨论了三个应用场景:客户操作、操作仪表板、在线分析。

现在网上到处都有推荐。亚马逊等主流电子商务网站根据它们的页面属性以各种形式向用户推荐产品。Mint.com之类的财务规划网站为用户提供很多建议,比如向用户推荐他们可能想要办理的信用卡,可以提供更好利率的银行。谷歌根据用户搜索历史记录的信息优化搜索结果,找到相关性更高的结果。

这是关于Yelp的实时流数据基础设施系列文章的第二篇。这个系列会深度讲解我们如何用“确保只有一次”的方式把MySQL数据库中的改动实时地以流的方式传输出去,我们如何自动跟踪表模式变化,如何处理和转换流,以及最终如何把这些数据存储到Redshift或Salesforce之类的数据仓库中去。这一篇中介绍的是MySQLStreamer,它从MySQL二进制文件中提取所有的数据变更操作事件,再把这些事件发布到Kafka中。