在CNUTCon上海2018大会上,张磊讲师做了《基于 CPU 的深度学习推理优化部署方案和实践》主题演讲,主要内容如下。

演讲简介:

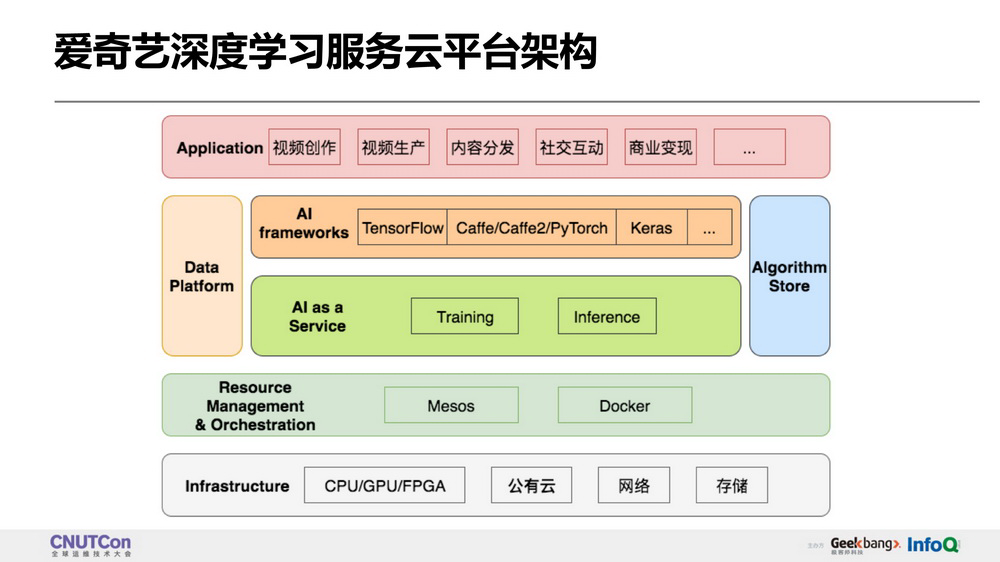

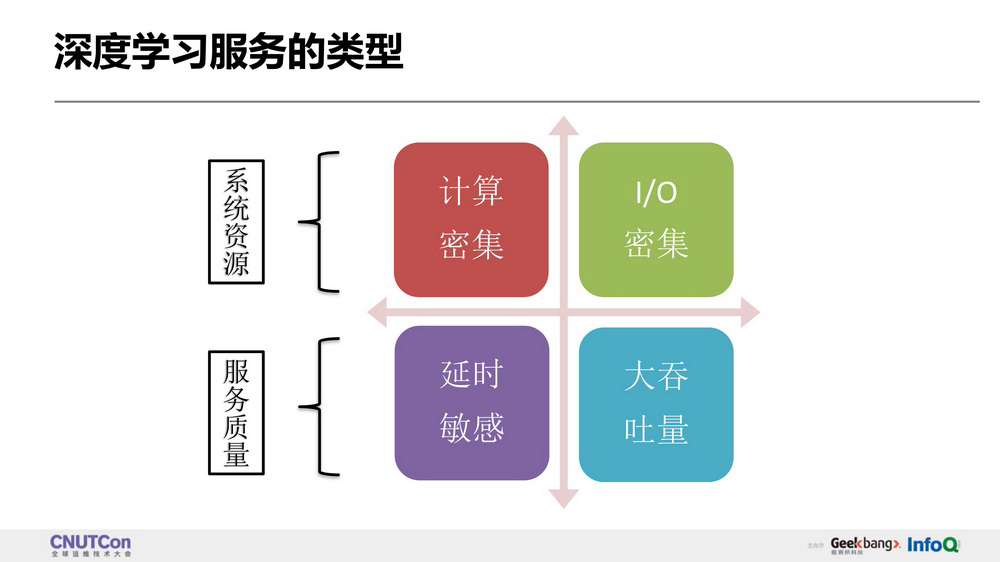

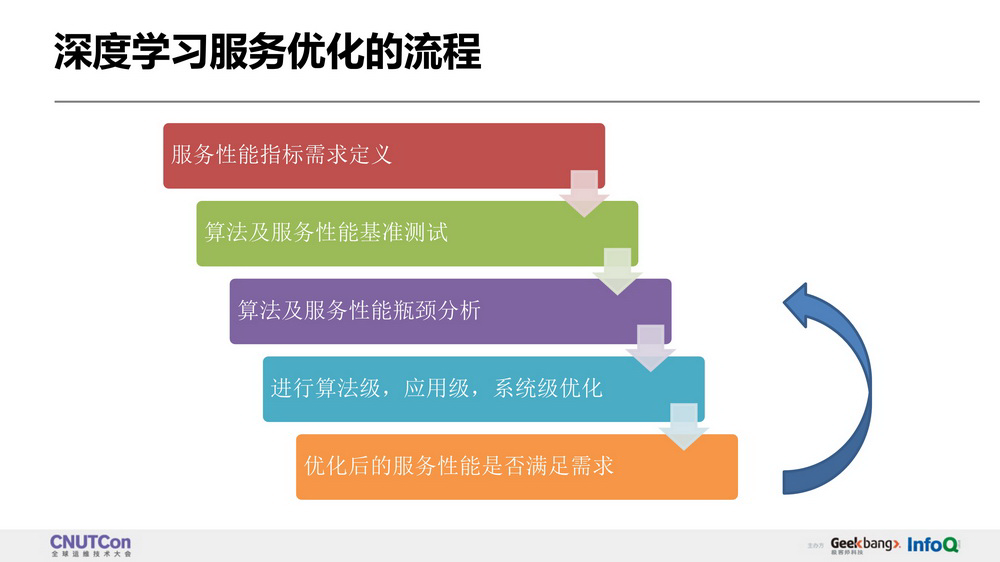

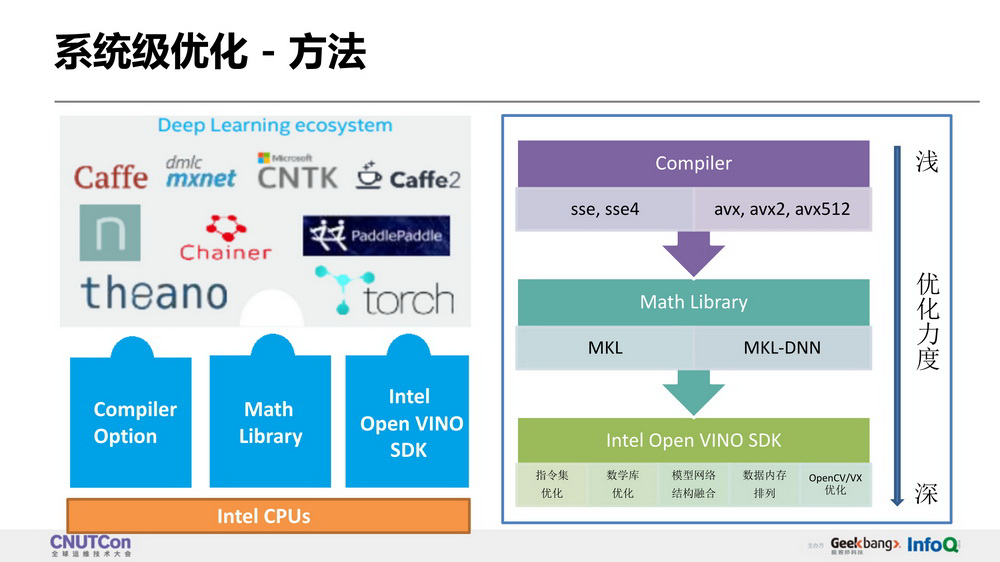

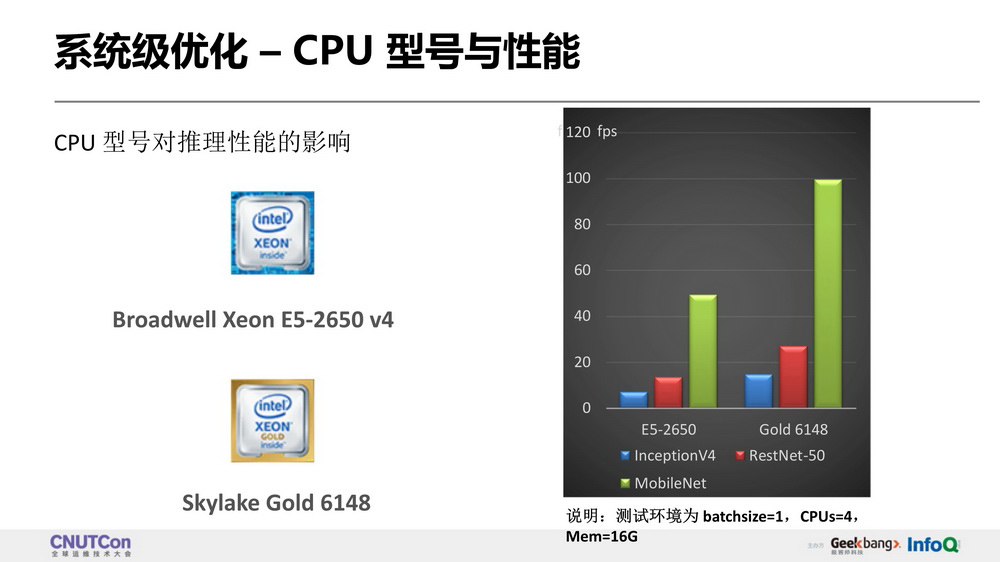

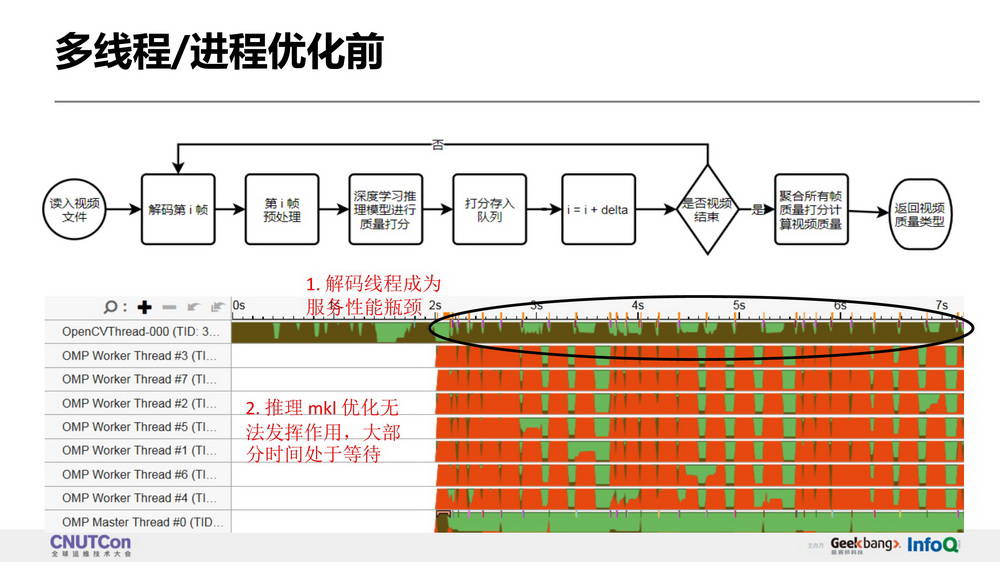

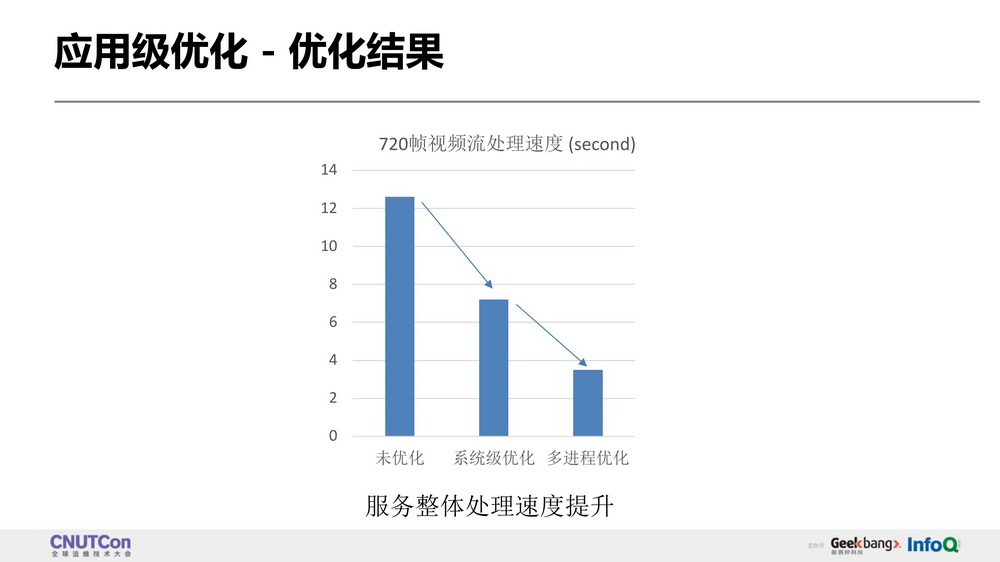

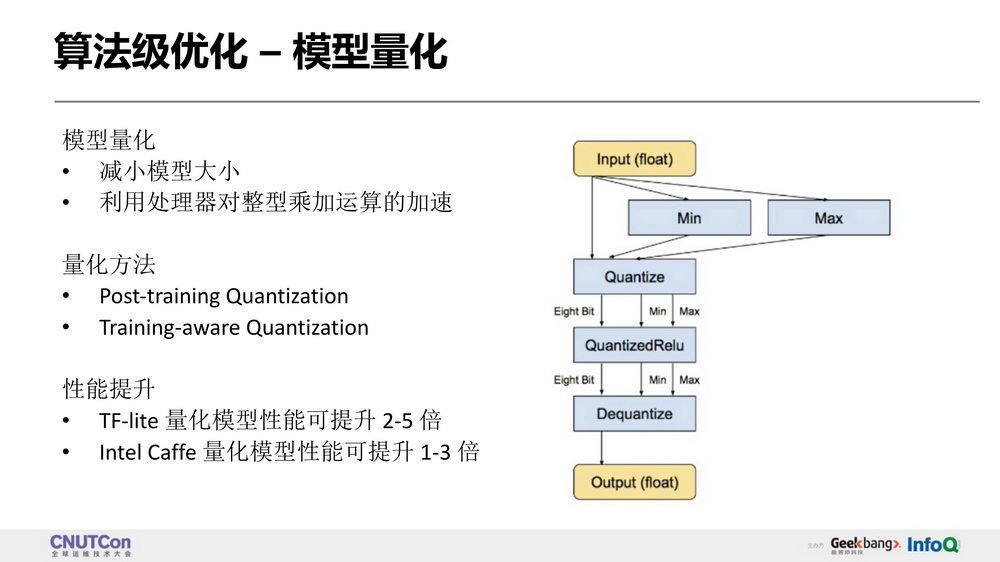

随着人工智能技术在多媒体领域的广泛应用, 深度学习算法的部署对计算平台资源的需求也在飞速增长。由于 GPU 资源总数和成本的限制,我们设计和部署了基于 CPU 的深度学习推理优化方案。方案通过封装 Intel VINO SDK 提供的基于 CPU 的深度学习加速底层软件,结合 docker 及 mesos 集群技术,完成深度学习算法在云端部署的自动化和服务化,将深度学习推理的性能在 CPU 上提升了 2~10 倍以上,满足多媒体业务的深度学习部署需求, 解决了 GPU 资源的依赖和稀缺问题。

主要内容:

使用 VINO SDK 实现 CPU 上的深度学习推理性能优化;

不同深度学习算法在 CPU 上加速的性能评估和对比;

基于 Docker 及 Mesos 的集群深度学习推理应用自动化部署方案。

听众受益:

学习 CPU 上深度学习的性能优化技术和实践;

了解大规模集群的深度学习应用部署管理方案;

理解深度学习推理的性能评估和监测方法。

讲师介绍:

张磊

爱奇艺 研究员

现就职于爱奇艺技术产品中心计算云团队,目前主要负责云平台上深度学习应用的优化落地方案。加入爱奇艺之前就职于英特尔亚太研发有限公司,负责底层图形图像软件设计和实现,对 CPU,GPU 上应用的性能分析和优化有丰富的经验。

完整演讲 PPT 下载链接:

https://cnutcon.infoq.cn/2018/shanghai/#schedule

评论