写点什么

创作场景

- 记录自己日常工作的实践、心得

- 发表对生活和职场的感悟

- 针对感兴趣的事件发表随笔或者杂谈

- 从 0 到 1 详细介绍你掌握的一门语言、一个技术,或者一个兴趣、爱好

- 或者,就直接把你的个人博客、公众号直接搬到这里

登录/注册

收录了 python词频统计 频道下的 50 篇内容

词频统计是文本处理中常见的任务之一,通过统计文本中每个词出现的次数,可以帮助我们了解文本的内容和特点。本文将介绍如何使用 Python 来实现简单的词频统计,涉及到列表、字符串操作、字典和循环等基本概念。

随着人工智能技术在业务中的渗透,我们逐渐意识到:AI 不仅是提升效率的工具,更是重构数据处理与消费方式的核心驱动力。

本文将以统计《红楼梦》中人物出场次数为例,介绍如何使用通义灵码进行简单的词频统计。我们将分析一部红楼梦中关键角色出场次数前10位有哪些,并生成一个饼图。

本文将以统计《红楼梦》中人物出场次数为例,介绍如何使用通义灵码进行简单的词频统计。我们将分析一部红楼梦中关键角色出场次数前10位有哪些,并生成一个饼图。

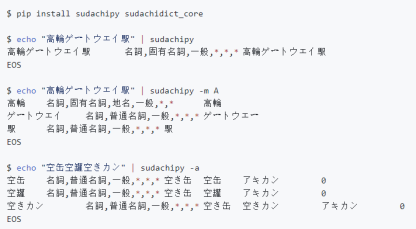

需要对一些日文进行词频统计,其中主要的技术点就是日语分词。本文使用 Python 和 SudachiPy 库进行日语分词。

本文描述了一个基于 Spark 构建的认知系统:文本情感分析系统,分析和理解社交论坛的非结构化文本数据。

本文是博客推荐系统系列文章的第二篇。主要介绍了度量推荐结果相似度的两种方法,包括欧几里德距离和余弦相似法。还详细介绍了计算博客相似度时对博客文章向量化的三个步骤:分词、词频统计、加权。直接在这个向量化后的高维度空间中进行推荐效果不一定是最优的,通过使用SVD或PCA降维算法可以得到更好的推荐效果。文章的最后给出了推荐系统的实际运行效果的例子。

为了尽量完整地呈现从原始数据到可视化的过程,接下来我们会先简单讲解数据的预处理过程,即如何将 JSON 数据转化为Excel 格式,以及如何对周杰伦的歌曲进行分词。

随着“中台”战略的提出,目前宜信中台建设在思想理念及架构设计上都已经取得了很多成果。宜信是如何借助中台化的思想打造“AI中台”及相关的智能产品呢?

别问,先上github搬运几个程序运行看看。

这篇文章中,我们将介绍如何使用Scikit-learn来实现用于机器学习的文本数据准备。文章主要介绍了三个Scikit-learn自带的文本数据量化工具——CountVectorizer、TfidfVectorizer和HashingVectorizer。

在自然语言处理(NLP)领域,文本情感分析是一项重要任务,它旨在通过计算机技术识别和提取文本中的情感倾向(如正面、负面或中性)。为了实现准确的情感分析,预处理步骤至关重要。本文将带领大家一步步完成文本情感分析的预处理,包括数据采集、分词、去停

本文我们将使用对象存储+云函数,通过 MapReduce 模型实现一个简单的 WordCount 算法。

在当今数据驱动的时代,电商平台的数据挖掘和分析变得尤为重要。作为国内最大的B2C电商平台之一,淘宝每天都产生海量的数据,这些数据为电商运营和数据分析提供了丰富的资源。本文将介绍如何使用Python进行淘宝数据挖掘,并通过API接口和词云图制作,帮助用户

计算机二级Python题库及满分代码

导入一篇txt文档,使用jieba库对文档中的文字进行分词,计算各个词汇出现的频率,使用wordcloud库按照词汇频率的大小生成词云。

如今的大多数软件很像埃及金字塔,数百万块砖堆叠在一起,缺少结构完整性

Python分析QQ群聊信息,记录词频并制作词云。包括聊天记录提取、正则表达提取消息文本、词汇处理、制作词云和最终效果展示。

摘要:这篇文章将详细讲解自然语言处理过程,基于机器学习和TFIDF的情感分类算法,并进行了各种分类算法(SVM、RF、LR、Boosting)对比