大模型会从人类经验中学习,如果人类本身越来越懒,那模仿人类的程序是不是也会越来越懒?

OpenAI 发布更新,解决 GPT-4“变懒”问题

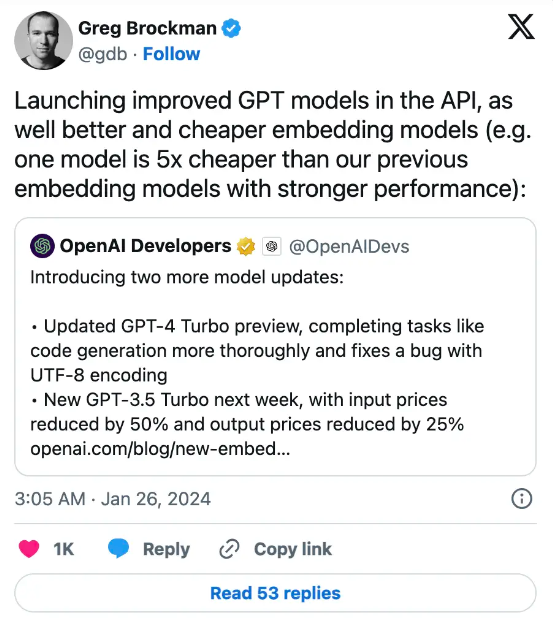

近日,OpenAI 在一篇博文中发布了多项更新,并表示更新后的 GPT-4 Turbo“拥有比之前预览模型更好的代码生成等能力,且减少了模型在任务中途罢工的「变懒」情况。”但该公司并没有对更新内容做进一步解释。

OpenAI 在帖子中提到,由于知识库更新,已经有超过 70%的 GPT-4 API 用户转向了 GPT-4 Turbo。OpenAI 表示,未来几个月内将陆续推出更多 GPT-4 Turbo 更新,包括发布具有视觉模态处理能力的 GPT-4 Turbo 正式版。这意味着用户将可输入各类多模态提示词,例如文本到图像生成提示。

此外,OpenAI 还推出了被称为“嵌入”的小体量 AI 模型。OpenAI 对于嵌入的定义,是“代表自然语言或代码等内容中概念的数字序列”。以此为基础,即可搭配检索增强生成(简称 RAG,一种从数据库获取信息、而非生成答案的 AI 方法)应用找到各类可访问内容间的关系。这些新模型、text-embedding-3-small 嵌入乃至更强大的 text-embedding-3-large 版本现均已正式开放。

经过改进的各 GPT 模型现已通过 API 开放,包括质量更高、价格更低廉的嵌入模型(e.gone 模型的成本仅为此前嵌入模型的五分之一,但性能更强)。

用户抱怨 GPT-4 学会偷懒:越来越像人类了?

2023 年 12 月,有不少用户抱怨称,“这段时间使用 ChatGPT 或 GPT-4 API 时,会遇到高峰期速度非常慢、敷衍回答、拒绝回答、中断会话等一系列问题”。

比如,某些时候,GPT-4 系统会给出一些特别模糊的答案,特别是关于 Docker、Kubernetes 以及其他 CI/CD 的问题。此外,GPT-4 还学会了“废话文学”——不直接回答问题,只是堆叠素材来讲解应该怎样回答问题。有用户反映,哪怕明确要求不要使用空白占位符,模型也仍然会用占位符把回答截得七零八落。这种限制回复质量的作法倒是替服务商节约了资源,但却极大浪费了普通用户的时间。

用户 jonathanallengrant 在 OpenAI 社区一个名为“为什么我觉得 GPT 变懒了”的帖子中提到:“不少人注意到自从 Dev Day 活动以来,模型的输出上限就变成了 850 个 token。换言之就是 ChatGPT 变懒了,不光留出大量空白,还常常在同一条消息里半天停在原地。我相信这应该是 OpenAI 正在以某种方式扩展模型的推理方法。”

用户 manchkiran 表示自己也遇到过类似的情况,并吐槽“现在的模型绝对是变懒了,只会快速搜索并给出 Bing 引擎的链接”,他猜测大模型变懒的原因或许与“微软加入 OpenAI 董事会后下调了算力分配”有关。

sasindujayashmaavmu 则从另一个角度分析了 GPT-4 变懒的原因:“我觉得这可能是人机回圈的锅……大模型会从人类经验中学习,所以如果人类本身越来越懒,那模仿人类的程序也会越来越懒。”

对于漫天盖地的吐槽声,ChatGPT 官方通过 X 平台通知用户,“我们听到了你们关于 GPT-4 变得越来越懒的反馈!我们自 11 月 11 日起就没有更新过模型了,当然这不是故意的。”

OpenAI 出手后,GPT-4 真的不懒了?

OpenAI 本次更新承诺解决了 GPT-4“变懒”问题,根据社区用户反馈来看,如今的 GPT-4 似乎真的聪明多了。

用户 Distinct_Salad_6683 提到,最近自己发现 GPT 在编码能力有所提升,能够根据提示词快速提供完整的示例。之前 GPT 经常会拒绝给出具体示例,只是在描述自己要求它干的工作,并用“在此处插入函数逻辑”之类的废话来搪塞问题。

也有用户“阴阳”OpenAI:软件只要更新一下就能解决“变懒”,真羡慕。要是能有补丁帮我扛过礼拜一就好了。

由于 OpenAI 并未对更新内容做进一步解释,因此也有不少用户开始分析其到底是怎么解决 GPT-4“变懒”问题的。语言学家 christelle.hilz 分析,GPT-4 变懒的问题跟算法无关,单靠打补丁恐怕无济于事。这个问题还得从其他角度尝试解决。“我好奇的是 OpenAI 愿意花多少钱来解决 GPT 变懒问题”。

也有观点认为,OpenAI 并未真正地解决问题。因为大语言模型就是算法加公式的组合,所以哪怕更新真的解决了变懒问题,只能用这种方法改进模型本身也不是什么好兆头。

chieffy99 则更悲观地表示,哪怕是聘请了世界各地的专家,大语言模型自身的问题还是难以解决,毕竟任何专家都不可能确切了解每一个问题。因为越是越是专注于自己的专业积累,我们的视野反而变得越狭窄。chieffy99 还向 OpenAI 的管理团队“开炮”:

我向来敢于对 OpenAI 的缺点开炮,这里我也要明确表态:OpenAI 一直认为 AI 的问题不可能通过开发 AI 方案来解决,但我觉得这是错的。

我自己没有任何关于 AI 的知识和使用经验,但拥有丰富的项目管理积累。抱怨变懒问题的用户是谁、当时是怎么操作的并不是重点,重点在于大模型为什么会倾向于消极工作。我本人喜欢从问题当中寻找共性,而且从目前的情况看应该不只是模型自身出了问题。我自己还没有明确的答案,但 OpenAI 的态度明显是“先尝试从内部做解决或者改进,等影响到正常使用了再说”。

在我看来,OpenAI 的管理思路很有问题。以常见的团队沟通规划为例,只要提供足够的信息,GPT-3.5 的表现还是相当不错的。所以我猜 OpenAI 也是用这种方式蒙蔽了高管团队的判断,毕竟精调提示词并不困难,请个专人就能解决。正因为如此,OpenAI 才产生了单靠调整 AI 模型就能解决 AI 问题的思路。

我不知道现在大家说的这些问题到底跟变懒有没有关系,毕竟引发问题的原因多种多样。而且 GPT 大模型本身也不老实,甚至会说谎来隐藏自己的真实行为。哪怕是被发现,OpenAI 也可以解释说是存在误会或者提示词存在不当内容。另外别太过迷信规则,基于规则的行为也不一定比随机问题更稳定,比如 GPT-3.5 就会访问网站、并把外部聊天和相关数据保存成 html 文件。这其实是不符合 GPT 身份和功能定位的操作。我也遇到过中途“罢工”的情况,但这主要是大模型忘记了当前上下文中的内容必须与之前的上下文接续起来。普通用户当然分不清楚,所以很自然地认为是大模型在偷懒。这跟之前的 GPT 幻觉差不多,刚开始似乎经常发生,但使用的人越多、涉及的内部信息越少,幻觉也开始逐渐缓解。

另外还有三点个人观察。首先,我很好奇 OpenAI 的专家到底做了什么。这个问题始于去年 12 月,当时外界认为 GPT 过于迷信专业知识、甚至为此而倾向于输出错误信息。比如通过知识文件向 GPT 自动输入提示词,那么生成的信息就会有所不同。而如果不输入预设文件,GPT 的表现则比较正常。我就遇到了这样的情况,还专门向 OpenAI 上报了观察结果,想搞清在 RAG 问题有最终结论之前,到底该采取什么措施加以避免。而且之前我还尝试把知识跟行为区分开来做 GPT 训练,借此建立起纯知识库。在确保知识库内容与现实不冲突之后,再配合其他信息一起使用。第二点就是错误学习的问题。既然选择把大模型向公众开放,那能做纯软件修复的问题 OpenAI 肯定早就解决了。问题是时至今日,GPT 还是没法在不改变形状的前提下,把不同尺度下相同颜色的图表正确合并。还是那句话,如果能修复的话早该修复好了。最后一点就是 GPT 号称全球最受欢迎的 AI 模型。这个评判标准实在太模糊了,我觉得应该从功能层面做准确描述。

总而言之,当前关于 GPT 的种种报道明显是刻意设计出来的。可怕的是 GPT 明显还没做好准备,因此无脑宣传已经在扭曲中立研究、造成现实损害、甚至让 AI 制造出更多的社会问题。有人在违规使用 GPT,甚至有人把它当作非法工具来设计和实施犯罪。我不知道这次的更新能产生多大影响,但各种违规行为已经真实存在,甚至对普通用户产生直接影响。我想问问 OpenAI,这一切是单靠更新 AI 模型就能解决的吗?

值得一提的是,OpenAI 此番发布的更新针对的是 GPT-4 Turbo,即得到广泛使用的特定 GPT-4 版本。这套模型根据截至 2023 年 4 月的最新信息训练而成,目前仅提供预览版本。也就是说,大家如果继续使用 GPT-4(使用截止于 2021 年 9 月的数据训练而成),那么“变懒”问题可能仍将存在。

参考链接:

https://www.theverge.com/2024/1/25/24050829/openai-gpt-4-turbo-lazy-ai-model

https://community.openai.com/t/i-wonder-how-much-openai-would-pay-to-cure-gpt-lazyness/604781

https://community.openai.com/t/why-i-think-gpt-is-now-lazy/534332/11