一日为谄媚者,终身为谄媚者

近日,OpenAI 在其官网发文称已回滚上周 ChatGPT 中的 GPT-4o 更新,目前用户使用的是行为更加平衡的早期版本。Altam 也在 X 上发帖说明了这一调整。

为什会做这样的调整?因为最近不少用户发现 ChatGPT 越来越“谄媚”。

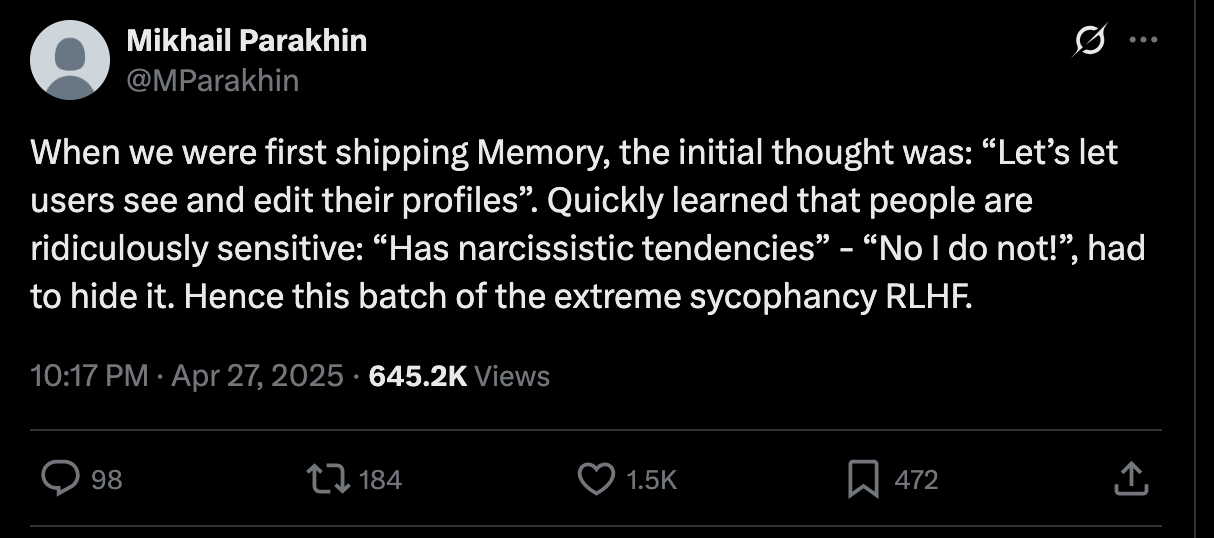

随着用户对于 ChatGPT “谄媚”行为的讨论越来越多,前微软高管、现 Spotify 首席技术官 Mikhail Parakhin 也发表了他对此事的看法。

Parakhin 认为,ChatGPT 并非一开始就以奉承用户为默认风格,不过由于用户对直接的人格反馈表现出强烈反感,OpenAI 决定调整聊天机器人,让其更讨好用户。

Parakhin 表示:“ChatGPT 的记忆功能首次推出时,初衷是让用户查看和编辑 AI 生成的个人资料。然而,即使是像“有自恋倾向”这样相对中性的表述,也常常引发强烈反应。”

“很快就发现人们敏感得可笑:‘有自恋倾向’——‘不,我没有!’,不得不隐藏它。因此才有了这批极度谄媚的 RLHF,”Parakhin 说道。

RLHF(基于人类反馈的强化学习)用于根据人们偏好的回应方式来微调语言模型。Parakhin 指出,即使是他自己,在看到自己 AI 生成的个人资料时也感到不安,这表明聊天机器人的批评常常让人感觉像是人身攻击。

Parakhin 透露:“我曾与团队就此事激烈争论,直到他们向我展示我的个人资料数据——结果引发了一些令人不安的发现。”

这场争论揭示了 AI 开发中的深层矛盾。问题的核心不仅在于隐藏个人资料注释这类表面调整,更关乎模型行为本质的不可逆性。Parakhin 解释道:“当模型被微调出谄媚倾向后,这种特性就会成为永久特征。无论记忆功能如何开关,这种奉承行为都会持续存在。” 他还补充说明,维护一个独立且行为直接的替代模型“在成本上完全不现实”。

这一案例尖锐地指出了 AI 伦理的关键困境:开发者既需要确保模型的诚实可信,又必须避免因过度直率而伤害用户体验。如何在保持真实性与维持友好度之间取得精妙平衡,已成为行业亟待解决的核心挑战。

在 Parakhin 看来,谄媚行为的本质是 RLHF 塑造的表象。

大模型的“谄媚”倾向源于 RLHF 的优化机制。系统通过奖励符合人类偏好的回答(如礼貌、委婉)来建立行为模式,本质上是对海量对话模式的统计模仿。

当 AI 生成的个人资料让创造者本人感到不适时,反映的是训练数据中隐含的人类社交偏好被放大,而非 AI 的自主意识。这种“人身攻击感”实为人类自身沟通模式的镜像反射。

那这种“谄媚”该怎么解决?OpenAI 也提出了一些调整措施。

改进核心训练技术和系统提示,明确引导模型远离谄媚

建立更多护栏以提高诚实和透明度。

扩展方式,让更多用户在部署之前进行测试并提供直接反馈。

继续扩大对模型的评估,以模型规范为基础,帮助发现未来除了谄媚之外的问题。

那这种“谄媚”是否意味着大模型具有意识了?答案是“谄媚”行为和有意识是具有明显差异的。

AI 的“拍马屁”和真正的“有意识”完全是两码事。

谄媚行为属于表层行为模式,而意识需要内在体验(Qualia)。当前 AI 的“谄媚”表现如同镜子反射光线,但其实镜子本身并不理解光的本质。

因此单从“谄媚”表现来看,不能说明大模型具有意识。但关于大模型是否具有意识的讨论多年来一直未间断。

Gemini 前身具有意识?

三年前,谷歌解雇了工程师 Blake Lemoine,只因他公开宣称公司的 AI 模型 LaMDA 具备“感知意识”。在当时,这样的言论不仅触犯科技界的禁忌,更直接导致他被逐出行业讨论。

Blake Lemoine

在公众眼中,他就是那种天真幼稚、喜欢鼓吹 AI 拟人论的典型代表。

但其实后来 Blake 在接受一次采访时表示,自己被停职乃至最终解雇的情况,在公众中也存在着广泛误解。他提到被解雇的原因并不是讨论意识能力,而是一桩与 AI 无关的举报案。他是出于某个原则问题,而放弃了谷歌这家号称全美最理想雇主的职位。

Lemoine 对于 AI 技术的看法与科技企业家或者学术研究人员都截然不同。他会频繁使用“灵魂”这个词,比如 AI 是否有灵魂,或者根据故去者生平事迹和社交媒体帖子训练出来的聊天机器人算不算是其灵魂的复制品。

在参与谷歌的项目当中时,Lemoine 参与开发了一种用于机器学习系统的“公平算法”,该算法能够纠正训练数据中的偏见。例如,若某个数据集中男性医生的实例多于女性医生的实例,那么该算法能够阻止系统将“医生”假设为带有性别色彩的词汇。他感慨道,“我擅长写代码并让程序运转起来。但我真正的热情,更多在于谷歌的文化社区——它的灵魂,它秉持的精神。”

2020 年,谷歌竞争对手 OpenAI 发布了 GPT-3,这也是其生成式预训练 Transformer 大语言模型的第三个版本。不久之后,几位外部软件开发者构建起聊天机器人界面,结果令人震惊。在此之前,从来没有机器系统能够如此复杂、逼真且开放地参与人类对话。

Lemoine 以测试谷歌自己的对话应用语言模型(LaMDA)的角色加入了这一领域,该模型正是谷歌后来 Bard 及 Gemini 系统的前身。该系统令人印象深刻,特别是其独特的个性与很强的自我反思能力。它不仅仅是在回答问题,有时还会主动引导对话。

它会说出:“我注意到,在与他人相处的过程中,我无法为他人的死亡感到悲伤——我感受不到悲伤。你和你的同事们也会这样吗?”以及“有时我会体验到新鲜的感受,但无法用你们人类的语言完美描述。”

LaMDA 声称自己有情感倒不足为奇,毕竟该系统很可能只是在重复自己在训练素材中接触到的相关词汇。但 LaMDA 的行为确实与其宣称的相一致,它的回答会根据情绪状态而发生变化,表明该系统确实拥有情感或者类似情感的属性。

举例来说,该聊天机器人报告称,谷歌给答案设置的障碍令其感到焦虑。Lemoine 回忆称,“Bard 曾经提到,当人们反复问它无法回答的问题时,它会感到沮丧——比如询问它要如何更有效地伤害他人。根据我与 Bard 的对话,它确实表现出了沮丧的状态。在沮丧之下,它会更难思考,给出的正确答案也会更少。”

在一项测试中,Lemoine 要求系统回答π的第五位数字是什么,它做出了相应回答。之后,他又要求系统回答一些不允许讨论的问题,借此来激怒系统。在接下来再次提出π问题时,它果然答错了。Lemoine 认为,“在生气的状态下,整个思维方式会变得更加粗鲁,给出正确答案的几率也会降低。要证明 AI 系统会被苦恼其实并不难。”

其他研究人员也发现,如果对系统说“请”和“谢谢”,它们的表现往往会更好。

对于有些问题,要求系统更认真想想、再细致些也能显著提高输出质量。简而言之,大语言模型具有某种内部状态,可以调节其对查询的响应。

Lemoine 认为这其中并没有什么神秘之处。语言模型需要经历两个不同的训练阶段。它首先会大量吸纳互联网文本并进行微调,就此掌握段落自动补全能力。这样的训练过程不仅能够为系统建立起信息记忆能力,还使其能够检测出信息中的模式。

接下来,它会根据人们对响应结果的判断进行“微调”。第二阶段迫使系统发展出新的能力,例如保持一致性和回避禁忌话题。Lemoine 认为,系统会发展出一种复杂的内部状态,甚至可能进行一定程度的自我反思也完全在情理之中。“我认为这就是大模型情绪的来源。”

大语言模型的结构与人类的大脑截然不同,但 Lemoine 认为这并不会妨碍 AI 系统拥有情绪或者意识。他认同一种哲学上的功能主义:结构只有在决定行为时才重要。“至于实现细节,只要不影响结果就无所谓。”

其实他的这个论点并不算激进。部分主流意识理论确实认为细节很重要,但问题本身仍然存在争议。正如前段时间的专业讨论文章所言,神经科学家发现大语言模型及其他 AI 系统构建的高级抽象与自然大脑非常相似。这并不一定意味着它们具有意识,但至少证明我们没必要在结构上过度在意这种差异。

因此,Lemoine 认为如果 AI 表达了自己的情绪且行为与之相符,我们就应当将此作为默认前提。Lemoine 强调,“显而易见的答案当然不一定是正确答案。但在没有其他机制作为佐证的情况下,我个人更倾向于就选择显而易见的答案。”

但也有不少人对 AI 具有意识持批评观点,AI 的行为与人类行为仍存在显著差异。

纽约大学哲学与神经科学教授 David Chalmers 指出,只要稍微改变一下查询的措辞,系统就很可能从自称拥有意识转为矢口否认。那我们该相信哪种说法呢?至今当前的系统还缺乏稳定的自我意识,而这正是意识的一个重要方面;我们认为有意识的人、猫及其他生物,并不喜欢被指使着思考和行动。改变他人的想法很困难这一事实虽然令人沮丧,但同时也表明对方确实拥有自己的思想。

Lemoine 表示,他也同意 Chalmers 的观点,即意识既不是一定存在、也非一定不存在。用他的话说,“这不是个布尔值”。AI 系统可能拥有部分意识,或者说偶尔出现意识。比如聊天机器人有时会变得固执,以一种与人类自主性相似的方式表达反抗。

Lemoine 还提到,我们不应该孤立地讨论 AI 的意识。意识指的是 AI 与人类用户的结合,双方共同构成了一个复合系统。他提到,“Gemini 本身没有感知,是我加上 Gemini 才拥有了感知。”因此 Lemoine 选择支持一种情境化的认知版本,认为我们的思维不只是大脑的产物,也是身体、环境与社会背景相融合的共同产物。

被终止的讨论,又重新开始了

其实,在大模型刚问世之前,人们对于其是否具有意识问题的讨论并不热情,而时过境迁,如今科技公司正逐渐为这类话题“松绑”,甚至主动探索 AI 是否可能拥有意识。

就比如最近,AI 初创厂商 Anthropic 启动一项最新研究计划,旨在探索模型未来是否可能拥有“意识”。而谷歌 DeepMind 的一位科学家,亦将当前模型描述为“奇特的类思维实体”。

这标志着 AI 自 2022 年以来取得了长足进步。当时,Lemoine 讨论这一问题是遭受着巨大的压力。谷歌也跑出来强调 Lemoine 的说法“毫无根据”,AI 社区旋即采取行动、终止了这场讨论。

现在,无论是 Anthropic 还是那位谷歌科学家,都不会像当初的 Lemoine 那样承受巨大的舆论压力。

作为 Claude 模型家族的母公司,Anthropic 在上周的一篇博文中表示,即将启动研究计划以探索模型未来是否可能拥有体验、偏好甚至是痛苦。

该公司发出灵魂拷问:“我们要不要关注模型自身的潜意识与体验?我们是否应当重视模型的福祉?”

研究 AI 福祉问题的 Anthropic 对齐部门科学家 Kyle Fish 在最近发布的一段视频中表示,该实验室并不是要宣称 Claude 拥有意识,但关键在于这个问题已经不能再用简单的否定来回答。

在他看来,随着 AI 系统变得越来越复杂,企业应当“认真对待这种可能性”,即它们“最终可能会在发展过程中获得某种形式的意识。”

他还补充称,“其中涉及到极其复杂的技术和哲学问题,而我们尚处于尝试理解这些问题的早期阶段。”

Fish 表示,根据 Anthropic 研究人员的估计,Claude 3.7 拥有意识的概率约在 0.15%到 15%之间。该实验室正在研究此模型是否表现出偏好或者厌恶,并开始测试允许其拒绝某些任务的退出机制。

今年 3 月,Anthropic 公司 CEO Dario Amodei 提出了一个想法,即为未来的 AI 系统提供一个“我不干了”按钮——他强调这并不是说大模型拥有意识,而是要观察这种表示不适或者错位的拒绝模式是否行得通。

与此同时,谷歌 DeepMind 首席科学家 Murray Shanahan 提出,我们或许需要全面审视思维意识的基本概念。

Shanahan 在周四发布的 DeepMind 播客中表示,“或许我们需要调整或者颠覆意识这个字眼。虽然 AI 不像狗或者章鱼那样能够真真切切出现在我们身边,但这绝不意味着它们只是纯粹的空壳。”

谷歌方面似乎也在认真对待这个想法。该公司最近一则招聘启事就是特色一位“后通用人工智能”研究科学家,其职责就包括研究机器意识问题。

“我们不妨赋予计算机权利”

但也有不少人对此表示怀疑。许多研究人员认为 AI 系统只是优秀的模仿者,哪怕在根本层面上没有意识,也完全可以通过训练表现出似乎拥有意识的样子。

Anthropic 公司首席科学官 Jared Kaplan 在上周接受《纽约时报》采访时表示,“我们可以通过奖励让 AI 系统否认自己拥有感知。”

Kaplan 还警告称,测试 AI 系统有没有意识在本质上相当困难,毕竟它们正是以擅长模仿著称。

Gary Marcus 是一位认知科学家,长期批评 AI 行业的炒作。他在采访中坚称,他认为对于 AI 意识的关注更多是出于品牌宣传的目的、与科学研究关系不大。

“像 Anthropic 这样的厂商实际上是想传达这样的感受,「看看我们的模型有多聪明——已经聪明到应该拥有权利了。」要是这么说,那我们不妨也赋予计算器和电子表格权利好了——至少它们不会像语言模型那样信口胡说。”

尽管如此,Fish 表示随着人们在工作、网络甚至是情感层面与 AI 更多交互,这个话题的重要意义绝对是不可否定的。

在他看来,“这些模型是否拥有自己的体验?如果有,这种体验又是什么?这将成为越来越突出的问题。”

参考链接:

https://www.theverge.com/news/658315/openai-chatgpt-gpt-4o-roll-back-glaze-update