本周可谓美国科技行业的“超级周”,而号称“AI 风向标”的英伟达 GTC(GPU Technology Conference,GPU 技术大会)也于美东时间 10 月 27 日开幕。

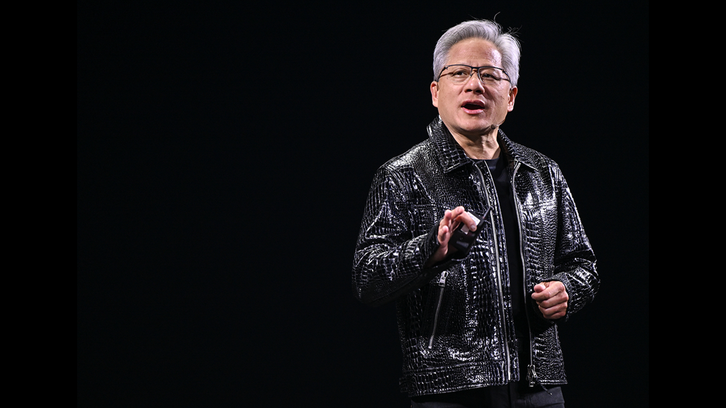

10 月 28 日,黄仁勋依旧身着皮衣登场。但与以往有明确重点的发布会不同,老黄此次演讲几乎把全球科技圈的热词悉数点了一遍:6G、量子计算、物理 AI、机器人、自动驾驶、核聚变...一个没落下。

他还官宣了一个跨次元般的重磅消息:

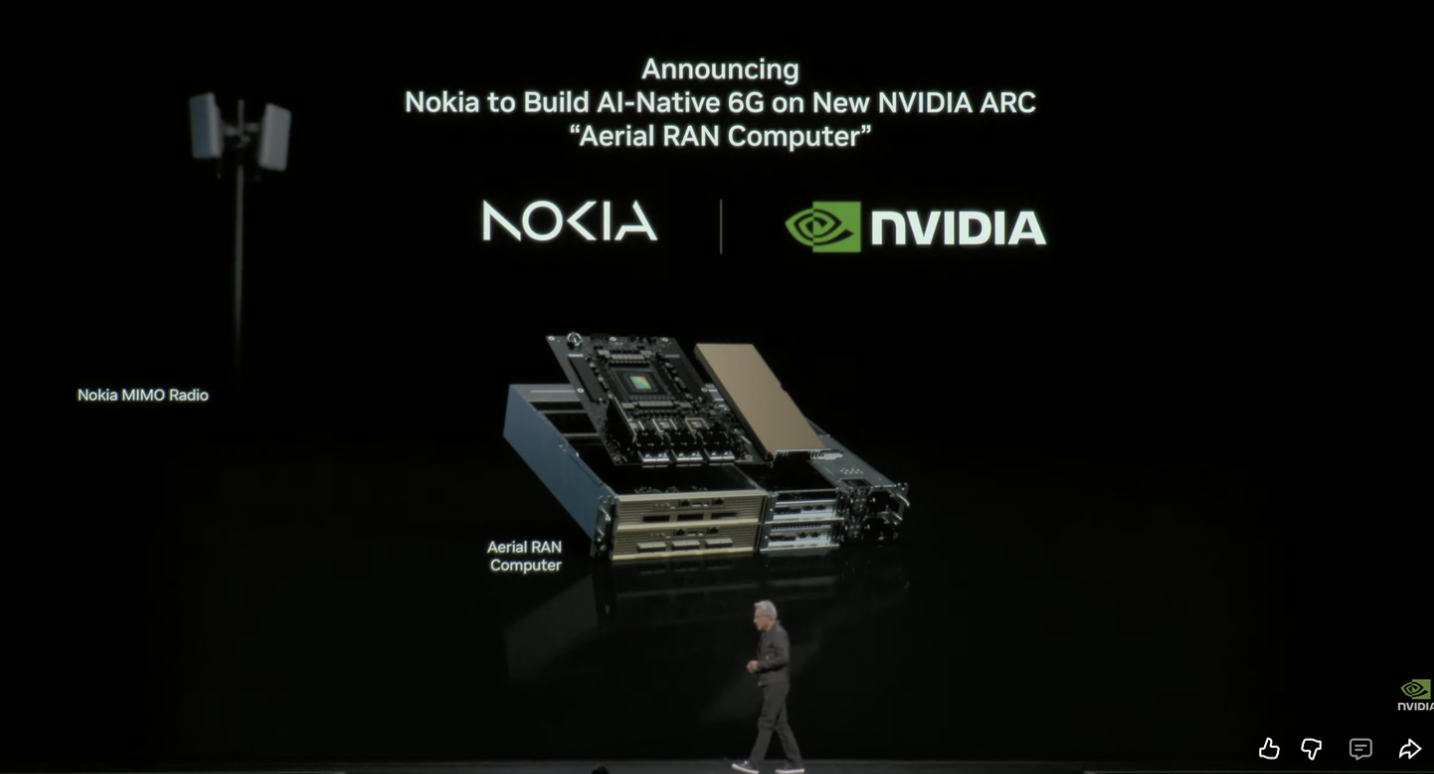

英伟达和诺基亚合作了,用 AI 提高无线通信的速度,共同建造面向 AI 原生的移动网络,搭建 6G AI 平台;为此,英伟达推出新品 NVIDIA Arc(Aerial Radio Network Computer),还将对诺基亚投资 10 亿美元(约合人民 71 亿元)。

也就是说,AI 不再只是网络的使用者,还成为了网络本身的“智能中枢”。

黄仁勋直言:“我们将采用这项新技术,升级全球数百万个基站。”

值得一提的是,老黄这次(可能下次血本了)不仅演讲话题涉猎甚广,还组建了一支超级“嘉宾足球队”,在一众大佬中,具身智能当红新星 Figure AI 创始人兼 CEO Brett Adcock(第二行左四)也赫然在列。

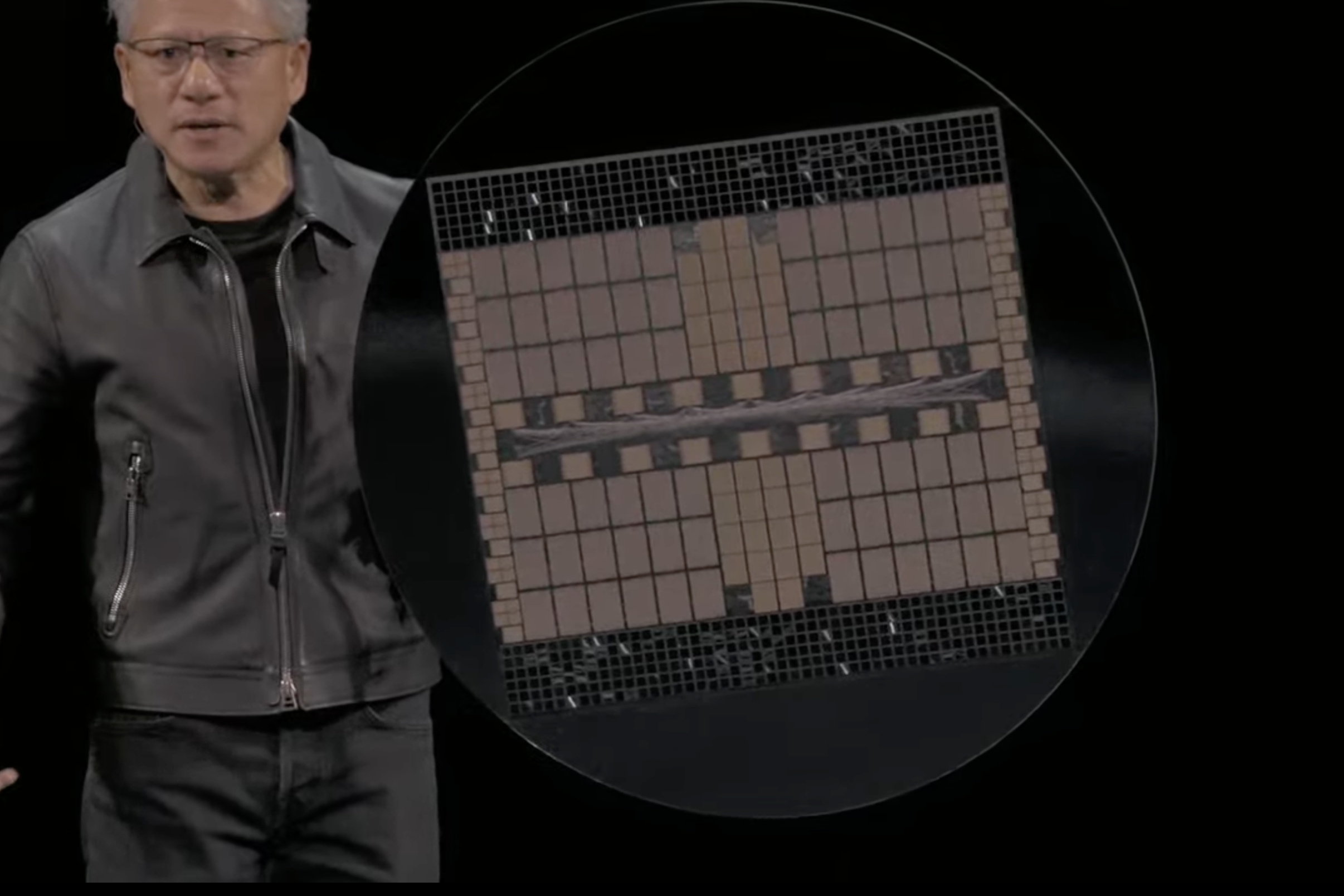

话说回来,英伟达 AI 芯片的成绩也着实亮眼:Blackwell 和 Rubin 芯片订单总额,已达 5000 亿美元(约合人民币 35,000 亿元)。

在今年 3 月的春季 GTC 大会上,老黄曾秀出最强 AI 芯片 GB300 NVL72,其中“G”是该芯片中的 CPU 架构 Grace,“B”是 GPU 架构 Blackwell,也是英伟达现在主推的数据中心 GPU 架构。

截至当日收盘,英伟达股价涨约 5%,总市值逼近 5 万亿美元(约合人民币 35 万亿元),创下新高。

次元壁破了:和老牌手机霸主一起搞通信

在这次 GTC 上,老黄官宣的第一个合作协议,就是和诺基亚携手共建 6G AI 平台。

二者此次合作重点不在“造芯片”,而在“让网络学会思考”:英伟达把其加速计算平台 Aerial RAN Computer Pro(ARC-Pro),带进诺基亚的无线通信系统 AirScale 中,推动运营商向 AI 原生的 5G 与 6G 网络过渡。

话说,诺基亚这个零几年的全球手机霸主、听起来好像是个“上古战神”,现在为什么会出现在英伟达的合作名单上,而且还被放在超级显眼位置?

首先,其实诺基亚“没死”,它只是卖掉了手机业务,退回了“根部”的通信设备业务。

2013 年,在卖掉手机部门给微软之后,诺基亚彻底转向电信基础设施:基站、天线、光纤网络、核心网软件——全球运营商的底层网络都离不开这些。

2016 年,诺基亚收购了阿尔卡特朗讯——这是由传奇的“贝尔实验室”(曾获 9 项诺贝尔奖、4 项图灵奖)改组重建的公司,然后就自然而然地继承了贝尔实验室一堆领先的技术和专利;收购后,贝尔实验室也更名为 Nokia Bell Labs。

如今的诺基亚和华为、爱立信并列,是全球三大通信设备厂商之一。

第二,英伟达做芯片的终极目标,其实不是“更强的 GPU”,而是让所有计算都发生在“靠近数据产生的地方”——也就是网络边缘,而这正是诺基亚的主场。

英伟达提供 ARC-Pro 平台:让通信基站不仅传信号,还能执行 AI 推理;诺基亚则提供 AirScale 无线系统和 RAN 软件栈:让这些“AI 基站”融入现有的 5G 网络,并能平滑升级到 6G。另外,T-Mobile 是他们的首个运营商合作方,将在 2026 年开始实地测试。

简单来说,就是英伟达把 GPU 算力塞进基站,诺基亚负责让它能在真实的网络中跑起来。

正如黄仁勋在发布会上所说的:“基于 NVIDIA CUDA 和 AI 的 AI-RAN,将彻底改变电信行业,这是一次跨时代的平台变革。”

英伟达的官方新闻稿也指出,此次合作标志着行业的转折点,通过在全球范围内推动 AI-RAN 的创新和商业化,为 AI 原生 6G 铺平了道路。

在诺基亚之外,黄仁勋还一口气官宣了几家合作伙伴:从自动驾驶巨头 Uber、政府 AI 供应商 Palantir 到与美国能源部、甲骨文达成战略合作——几乎覆盖了 AI 产业的每一个关键环节,暗含其野心。

先是 Uber。黄仁勋认为“机器人出租车的拐点即将到来”,双方计划在全球铺开 10 万辆自动驾驶汽车。这不仅是自动驾驶的突破,更是 AI 硬件与智能算法的深度融合——英伟达正试图让 GPU 成为 Robotaxi 时代的“车载大脑”,推动出行生态进入商业化阶段。

接着是 Palantir。这家擅长处理政府和军情数据的公司,将把英伟达的 CUDA-X 和 Nemotron 模型嵌入自家系统,让 AI 学会“看懂”世界。Lowe’s 已经在用这套组合调度它的供应链——AI 代理成了企业的隐形决策官。

不过更大胆的布局在科研领域,与美国能源部、甲骨文联手打造七台 AI 超级计算机。其中阿贡实验室的 Solstice 与 Equinox 系统,将以 2,200 exaFLOP 的惊人算力,成为“美国的探索引擎”。

从 Robotaxi 到政府级 AI 决策,再到超级计算,英伟达不再“造芯片”,而是在“造智能的地基”。

前沿科技话题“大点兵”

前文提到,老黄这次的演讲涉及多个话题,除了 6G,还有量子计算、物理 AI、机器人、自动驾驶等;下面来具体看几个。

1、量子计算

自理查德·费曼提出量子计算概念起,40 年后,业界终于在去年实现了关键突破——创造出可相干、稳定、且具纠错能力的逻辑量子比特(logical qubit)。

英伟达此前推出了开放式量子 GPU 计算平台 CUDA-Q,这次又开发了一个基于 CUDA-Q 核心构建的 NVQLink,是一种能把传统 GPU 和量子处理器连接起来的互联架构。

当下的量子计算仍处在“易碎”阶段——对环境噪声异常敏感,且算力利用率有限。为了让量子比特保持稳定运行,往往要借助 GPU 超算系统承担控制与纠错计算,这让量子计算暂时还离不开经典计算的“辅助臂”。

黄仁勋分享称,英伟达将与美国能源部合作建设 7 台 AI 超级计算机,这些超算将使用 Blackwell 和下一代 Vera Rubin 架构芯片,利用 AI、量子计算等最前技术投入研究。

老黄还化身“AI 赛道的美国队长”,举起了他的“芯片盾牌”:由 NVLink 连接的 72 块 GPU 构成。

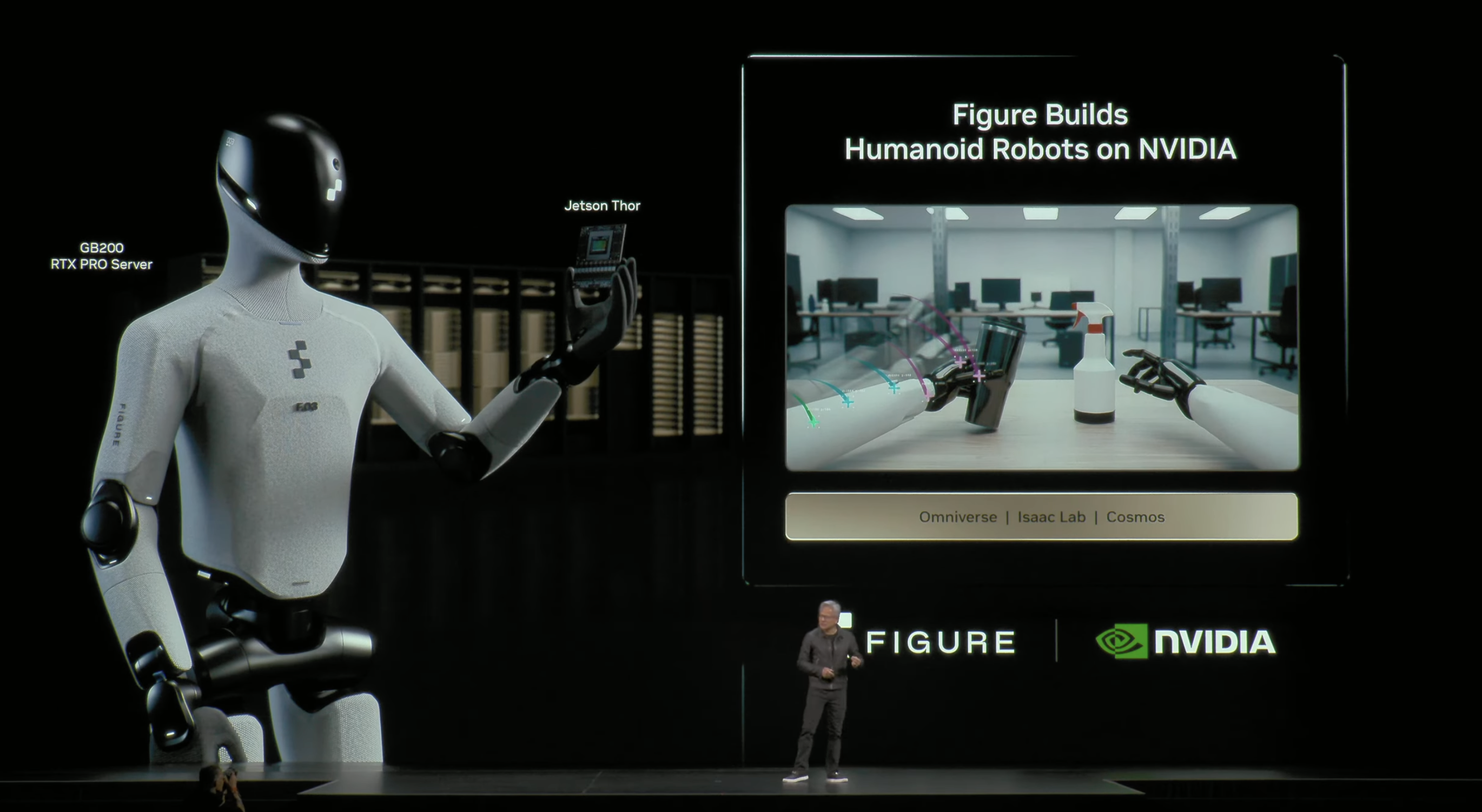

2、具身智能和物理 AI(Physical AI)

对于具身智能与机器人计算,英伟达的理念是,如果要让 AI 真正进入物理世界、具备感知和行动能力,必须依托一个“三计算机”体系:

一是用于模型训练的 Grace Blackwell AI 计算机,负责生成大规模智能模型;二是用于仿真和虚拟验证的 Omniverse 数字孪生计算机,在虚拟环境中模拟机器人行为与物理交互;三是用于实际执行的 Jetson Thor 机器人计算机,让智能在真实世界中运行。

这三者都基于 CUDA 平台运行,形成从训练、仿真到执行的完整“物理智能”闭环,使 AI 能够真正连接虚拟与现实世界。

英伟达投资过多家具体智能公司,和美国具体智能新独角兽 Figure AI 也在开展合作,加速下一代机器人的研发。

3、开源模型与生态合作

英伟达在开源模型和产业生态上正展开双线布局。

一方面,得益于推理、多模态与知识蒸馏等能力的提升,开源模型已经足够强大,成为初创企业和科研机构进行灵活定制与创新的基础。英伟达作为开源社区的重要贡献者,已有 23 个模型登上各类性能榜单,并承诺将持续投入。

另一方面,英伟达正加速与云计算和行业伙伴的深度集成:其模型与库已嵌入 AWS、Google Cloud、Microsoft Azure 等主流云平台,以及 ServiceNow、SAP 等 SaaS 系统,使用户能够在不同生态中无缝调用 AI 能力。

同时,英伟达还与 CrowdStrike(网络安全)、Palantir(数据处理)和 Synopsys(芯片设计)等行业巨头合作,以 AI 提升垂直领域生产力,推动从安全到设计的智能化变革。

4、AI 在聊天机器人之外的更多应用

AI 被广泛用于基础科学研究,远不止聊天或生成内容。在医疗、基因组学、企业计算等领域都有应用。不同类型的模型(卷积神经网络 CNN、图神经网络 GNN、状态空间模型等)被用于不同任务。

AI 不仅是工具,也能成为“数字员工”。例如英伟达内部的 Cursor 系统可帮助工程师自动生成代码;AI 驾驶员(AI Chauffeur)则被用于自动驾驶出租车。

老黄还亲自详解:AI 到底是什么?

在 GTC 大会上,除了抛出一个又一个爆炸性的技术新动向,黄仁勋还特意拿出 20 分钟,讲了一堂“AI 是什么”的深度课。

在他看来,这件事十分必要——如果没弄清 AI 的定义,就无法判断下一场产业潮水将流向何处。

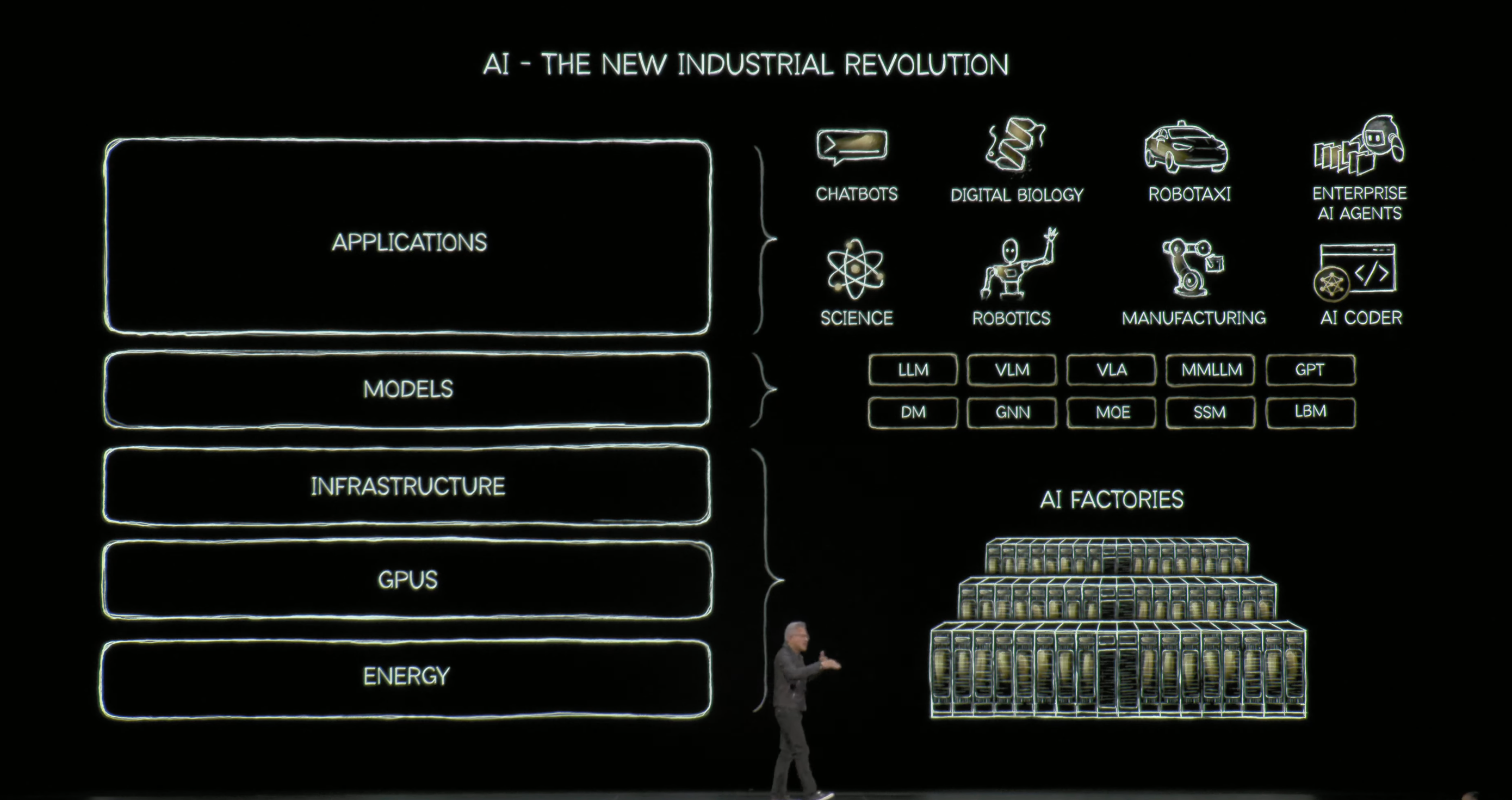

黄仁勋首先澄清一个误区:AI 的世界远不止 ChatGPT 所代表的聊天机器人,那只是大众心中的 AI 形象。真正关键的,是以 AGI 为代表的深层计算机科学,以及支撑它的惊人算力,“AI 不是某个应用,而是一种新的计算方式。”

过去的计算世界,是程序员写规则、计算机执行命令;现在,机器靠数据自己学习规律。

比如,以前要教电脑识别猫,你得写几十条规则;如今只需给它十万张猫的照片,它自己就能学会什么是“猫”。

这场转变包含三层逻辑:计算方式变了——从写代码变成喂数据;计算工具变了——从 CPU 到 GPU;计算目标也变了——从执行任务到生成智能。AI 由此彻底重构了计算栈。

换句话说,AI 正在从“螺丝刀”变成“工人”。

它不再是被动的工具,而是主动的执行者——会使用浏览器、写代码、制定计划、理解需求。

当技术第一次具备了“做事”的能力,机器也第一次进入了生产力的核心。

有了学习能力,AI 看世界的方式也彻底不同。

在它的眼中,万物都被拆解成可学习的片段:文字、图片、声音、分子、蛋白质……这些最小的信息单位叫作 token。

AI 通过这些“语言颗粒”去理解、模仿、重建世界。谁能以更低成本、更高速度生成和操控 token,谁就能主导下一代计算。

这也催生了一种全新的基础设施——AI 工厂。

如果传统数据中心像多功能仓库,负责存储文件、运行程序,那么 AI 工厂就像一条生产线,只做一件事:生产 token。

能源流入,驱动 GPU;GPU 通过 NVLink 和 Spectrum-X 网络连接成超级系统;软件与模型协同工作,批量产出 token。

黄仁勋把这条链概括成一句话:

“能源 → GPU → 算法 → 模型 → Token → 智能。”

AI 的成长轨迹,也像一个“吃电的天才”。

它先在预训练阶段“学语言、记知识”,像学前班;

后在后训练阶段“学技能、学推理”;

最后进入“思考阶段”,在与你互动时实时规划、推理——那是最消耗算力的时刻。

AI 越聪明,就越费电。这是第一条指数——AI 使用指数:智能与算力的爆炸式增长。

但还有第二条曲线——AI 采用指数:AI 越好用,越多人使用;使用越多,算力需求又被推高。

两条指数叠加,形成了一个强劲的正反馈——AI 越聪明,体验越好;越好用,用户越多;越多的使用带来更多利润,又反过来推动 AI 变得更聪明。

面对算力需求如此巨大,要让这台“永动机”持续转动,黄仁勋的答案是“极致协同设计(Extreme Co-Design)”。

摩尔定律的线性提升早已赶不上 AI 的指数爆炸,必须在芯片、封装、互联、系统、编译器、模型、算法、应用等每一层同时创新。

他说:“要让 AI 继续前进,不能只造更快的芯片,而要重新设计整座工厂。”

这座“工厂”,就是未来的 AI 工厂。

在黄仁勋眼中,它不再是通用数据中心,而是一条智能的生产线——能源是燃料,GPU 是引擎,模型是模具,Token 是产品。

算力不再是辅助资源,而是新的生产资料。只有不断压低成本、扩大产能,AI 的良性循环才能继续。

这就是未来计算的形态。

AI 工厂将成为现代经济的新基础设施,从科学、医疗、制造到娱乐,所有行业都将围绕 AI 工厂重构。

从 Arvin 在 Perplexity 的工作、软件开发中的 Cursor,到机器人出租车中的 AI 司机。人工智能正快速渗透到过去难以触及的经济领域,占据越来越广阔的版图。

那 20 分钟里,他讲的其实不只是 AI,而是人类第一次拥有一种能把能量直接转化为智能的机器。

未来的计算,不再是让电脑执行命令,而是让世界自己学会思考。

老黄演讲视频回看地址:

https://www.youtube.com/watch?v=lQHK61IDFH4&list=TLGG23pf8VjteXoyODEwMjAyNQ

参考链接:

https://nvidianews.nvidia.com/news/nvidia-nokia-ai-telecommunications