OpenAI 不久前宣布了该公司超级对齐团队的第一项成果。这个团队是该公司的一项内部计划的产物,致力于预防一种超级智能体(一种假象的未来计算机,可以比人类更聪明)走向失控。

与该公司的许多公告不同的是,这次的公告并没有包含什么重大突破。在一篇低调的研究论文中,该团队描述了一种技术,可以让一个水平较低的大型语言模型监督一个能力更强大的语言模型,论文声称这可能是向着“弄清楚人类如何监督超人类水平的机器”这一目标迈出的一小步。

此前 OpenAI 陷入了危机,首席执行官 Sam Altman 被监督委员会解雇(这显然是由首席科学家 Ilya Sutskever 领导的政变),三天后他又重新上任。这次的公告距离这桩风波不到一个月,而它传达的信息很明确:公司又回到了正轨,一切如常。

然而 OpenAI 的业务并不寻常。许多研究人员仍然质疑机器是否能够媲美人类的智能水平,更不用说超越人类智能了,但 OpenAI 团队认为机器最终一定会取得优势。“过去几年中人工智能的进步非常快,”超级对齐团队的研究员 Leopold Aschenbrenner 说:“我们不断刷新所有基准测试纪录,而且这种势头有增无减。”

对于 Aschenbrenner 和公司的其他人来说,行业出现具有接近人类能力水平的模型是指日可待的。 “但它不会就此止步,”他说:“我们将拥有超人模型,也就是比我们聪明得多的模型。这样的未来将会带来很多全新的、直击根本的技术挑战。”

7 月,Sutskever 和 OpenAI 科学家 Jan Leike 成立了超级对齐团队来应对这些挑战。 “我这样做是为了我自己的利益,”Sutskever 在 9 月份告诉《麻省理工科技评论》:“我们得保证任何人构建的任何超级智能都不会失控,这一点显然非常重要。”

人们猜测 Altman 因他在公司的人工智能安全策略方面的做法反复无常而被解雇,现在 Sutskever 的超级对齐团队又成了头条新闻。许多人都在期待着,想知道到底发生了什么。

该做什么和不该做什么

该团队想要回答的问题是如何控制或“调整”假想中的、比我们聪明得多的未来模型,即所谓的超人模型。对齐意味着让模型确保执行你希望它执行的操作,而不执行你不希望它执行的操作。超对齐的理念把这种思想应用到了超人模型上。

用于调整现有模型的一项非常流行的技术称为“通过人类反馈的强化学习”。简而言之,人类测试人员会对模型的反应打分,对他们希望看到的行为投赞成票,对他们不希望看到的行为投反对票。然后这些反馈会被用于训练模型,使其仅产生人类测试人员喜欢的响应类型。这项技术是让 ChatGPT 变得如此吸引人的一个重要原因。

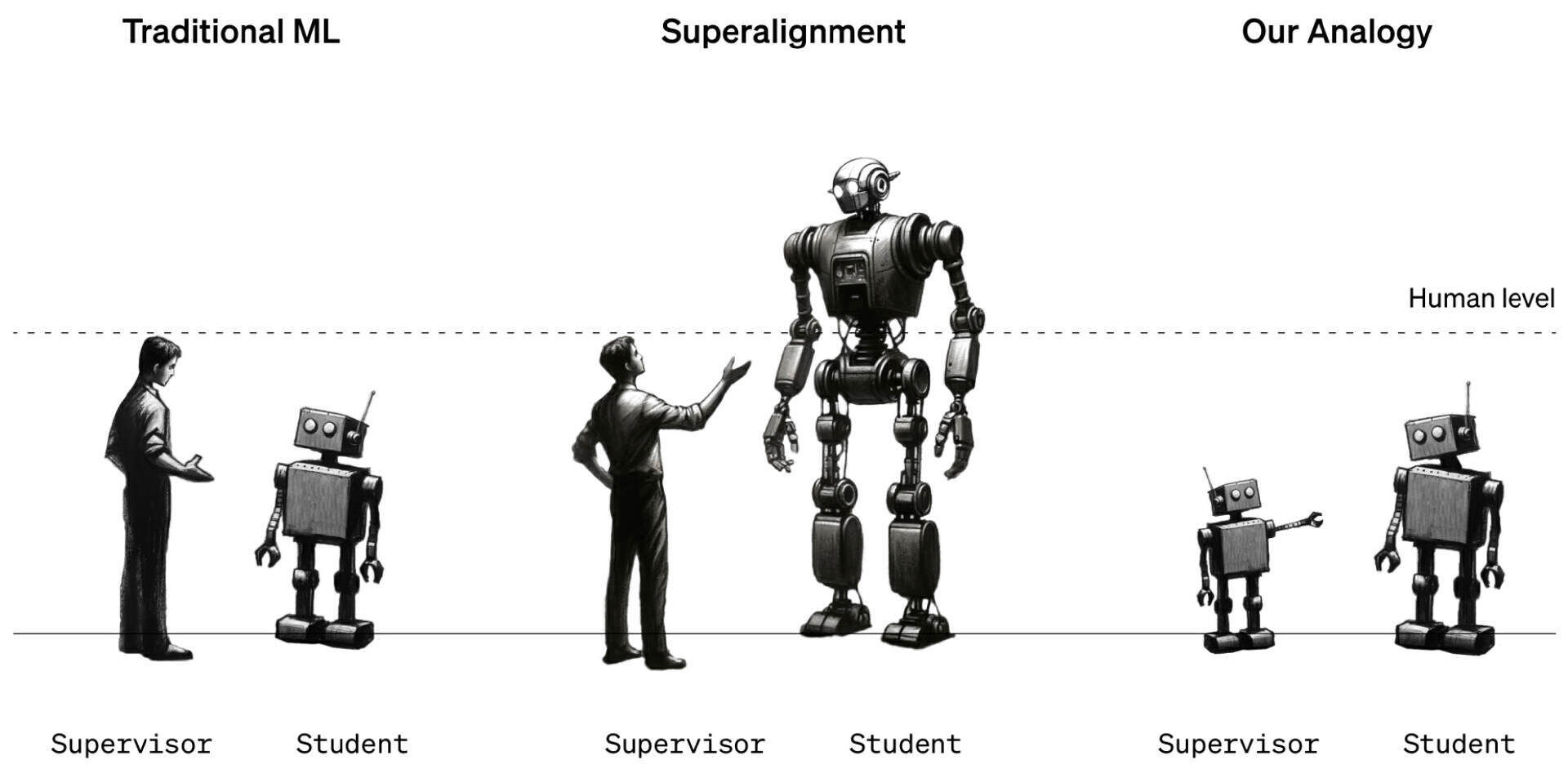

问题在于,这种方法要求人类首先能够辨别什么是理想的行为、什么是不理想的行为。但超人模型这种情况下,模型可能会做出一些人类测试人员无法理解的事情,因此测试人员无法对它们评分。(Sutskever 告诉我们,它甚至可能试图向人类隐藏其真实行为。)

OpenAI 解决超对齐问题的方法

研究人员指出,这个问题很难研究,因为超人机器目前并不存在,所以他们使用了一种替代方法。他们没有研究人类该如何监督超人类机器,而是研究了 OpenAI 五年前发布的模型 GPT-2 该如何监督 OpenAI 最新、最强大的模型 GPT-4。 “如果你能做到这一点,这也许就能证明你可以使用类似的技术来让人类监督超人类模型,”超级对齐团队的另一位研究员 Collin Burns 说。

该团队引入 GPT-2,并训练它执行一些不同的任务,包括一组国际象棋谜题和 22 个评估推理、情感分析等常见自然语言处理测试。他们利用 GPT-2 对这些测试和谜题的反应来训练 GPT-4 执行相同的任务,这就好像让三年级学生教十二年级学生如何完成任务一样。诀窍是在不让 GPT-4 的性能受到太大影响的情况下做到这一点。

结果好坏参半。该团队测量了根据 GPT-2 最佳猜测结果训练的 GPT-4 与根据正确答案训练的 GPT-4 之间的性能差距。他们发现,经过 GPT-2 训练的 GPT-4 在语言任务上比 GPT-2 表现好 20% 到 70%,但在国际象棋难题上表现较差。

团队成员 Pavel Izmailov 表示,GPT-4 完全超越了它的老师,这一事实令人印象深刻:“这是一个非常令人惊讶和积极的结果。”但他说,它远远没有发挥出它自己的潜能。他们的结论是,这种方法很有前景,但还需要做更多的工作。

“这是一个有趣的想法,”德国斯图加特大学从事对齐研究的人工智能研究员 Thilo Hagendorff 说道。但他认为 GPT-2 可能太笨了,无法成为一名好老师。 “GPT-2 往往会对任何稍微复杂或需要推理的任务给出无意义的响应,”他说。 Hagendorff 想知道如果改用 GPT-3 会发生什么事情。

他还指出,这种方法并没有解决 Sutskever 所假设的一种场景,也就是超级智能会隐藏其真实行为,并假装和人类保持一致,虽然它实际上可能已经跑偏了。 “未来的超人模型可能会拥有研究人员也不了解的新兴能力,” Hagendorff 说:“在这些情况下,对齐方法该如何发挥作用呢?”

但他说,指出缺点是很容易的事情。他很高兴看到 OpenAI 开始从猜想转向实验:“我对 OpenAI 的努力表示赞赏。”

OpenAI 现在希望招募其他人加入他们的事业。除了这项研究成果更新之外,该公司还宣布了一项新的 1000 万美元资金计划,计划用于资助从事超级对齐工作的人员。它将向大学实验室、非营利组织和个人研究人员提供高达 200 万美元的赠款,并向研究生提供 15 万美元的一年期奖学金。 “我们对此感到非常兴奋,” Aschenbrenner 说:“我们的确认为新加入的研究人员可以做出很多贡献。”

相关链接:

https://www.technologyreview.com/2023/12/14/1085344/openai-super-alignment-rogue-agi-gpt-4