“集体上云”爆火之后遇到了诸多挑战,而一种全新趋势悄然抬头:把云上的 AI 能力,拉回每一位开发者的桌面。

那个“把云上 AI 能力拉回桌面”的个人 PC,现在要来了!

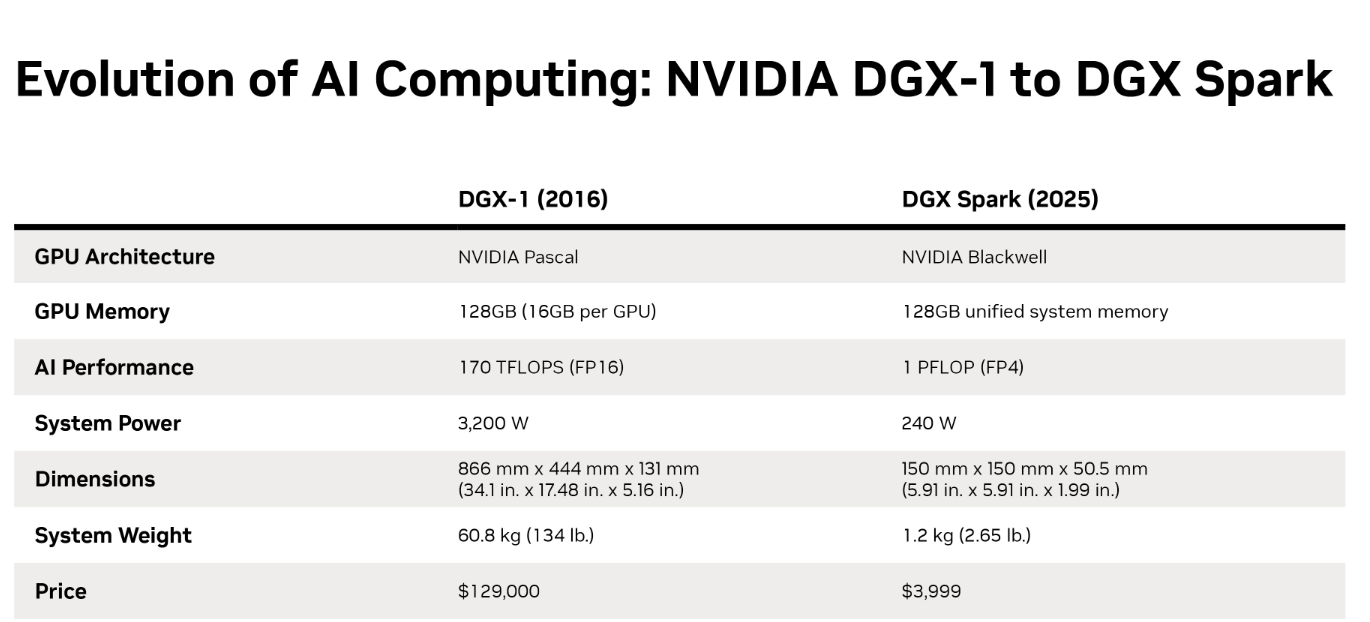

英伟达的个人 AI 超级计算机:DGX Spark 今日开售,据英伟达官方新闻信息,售价为 3999 美元起(约合人民币 23791 元);用户可以在英伟达官网订购。

据英伟达消息,DGX Spark 的本质,是把原本只存在于数据中心的 DGX 超级计算架构,浓缩成“一台能放在桌上的个人 AI 超级计算机”。

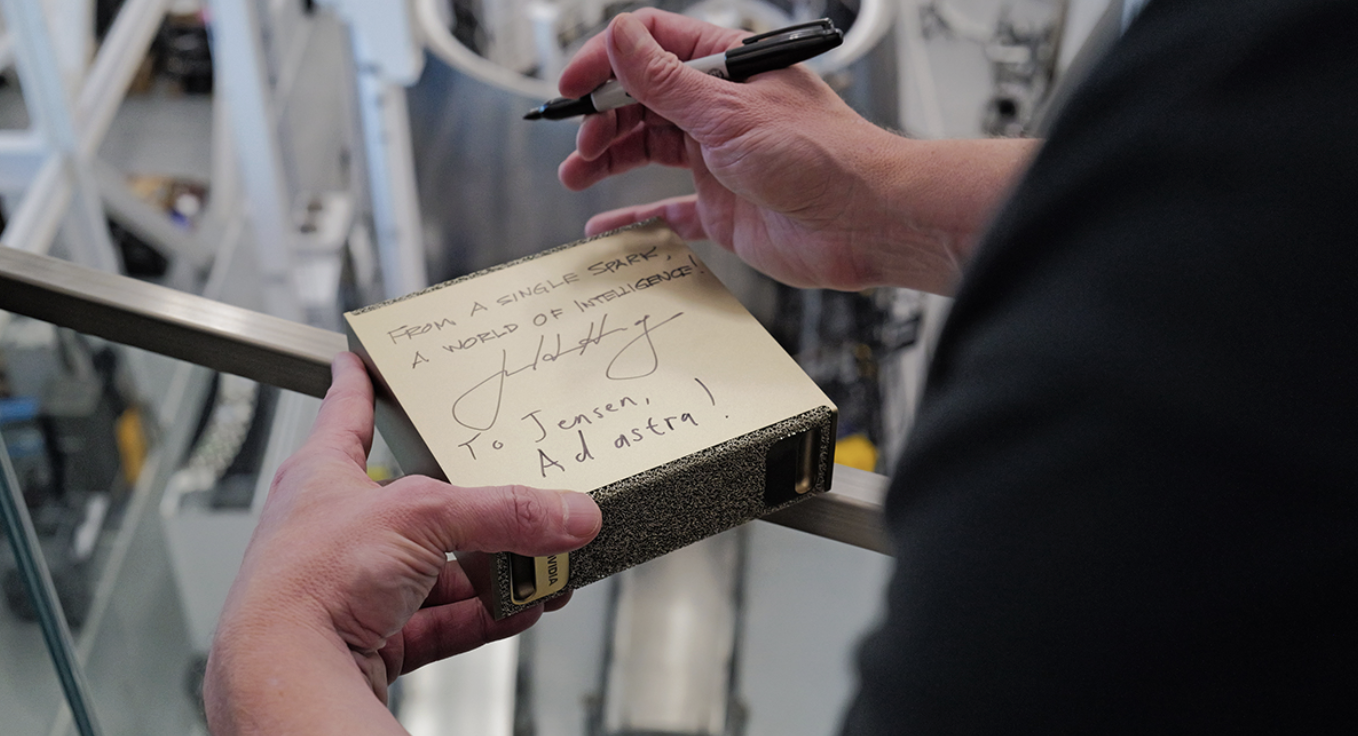

有意思的是,在第一批 DGX Spark 交付名单中,还出现了正在搞星舰测试的马斯克,而且他的这台由黄仁勋本人带机赴星舰基地,亲手转交。

图源:英伟达官网新闻稿

为此,老黄还开玩笑说:

想象一下将最小的超级计算机运送到最大的火箭旁边。

马斯克也写下一段寄语:

From a single spark,A world of intelligence!

To Jensen, Ad astra!

(由一束火花,点燃智慧的世界!致黄仁勋,奔向星辰!)

图源:英伟达官网新闻稿

新鲜测评:这款个人 AI 超算厉害在哪儿?

DGX Spark 是在今年 3 月的英伟达 GTC 大会上官宣的,号称世界上最小的 AI 超级计算机,大小与 Mac mini 差不多。

除了 DGX Spark,英伟达还在 GTC 大会上官宣了它的“大哥”DGX Station,也是一款个人 AI 超级计算机。不过据英伟达官方新闻,DGX Station 将于今年晚些时候由华硕、戴尔、惠普等英伟达的制造合作伙伴推出。

DGX Station 定位高端桌面级大模型训练与企业级工作负载,是“个人集群节点级”的重型设备。而本文的“主角”DGX Spark 则面向轻量级本地推理与微调,更加便携 。

那么,这台个人 AI 超算的实用效果如何?

一家叫 LMSYS 的组织提前拿到了 DGX Spark,并展开深度测评。LMSYS 是一家非营利组织,专注于孵化开源项目和研究;起源于 2023 年由加州大学伯克利分校、斯坦福大学、卡内基梅隆大学等多所大学合作项目。

LMSYS 的测评显示,DGX Spark 在运行 8B~20B 级的中小型模型时,性能大于等于同价位独立显卡平台,尤其在批处理(batching)+框架优化配合下吞吐表现稳定,批处理效率也高。

对于 70B 以上的模型,DGX Spark 的表现是可运行,但属于“可用级”而非“生产级”,更适合加载测试、兼容性研究。

关于 DGX Spark 的使用效果,LMSYS 还放出了一段完整的“DGX Spark 本地 AI 工作站流程演示”。

整体逻辑是:从启动模型 → 优化推理 → 通过 API 调用 → 接入界面 → 接入 IDE → 变成完整本地 AI 开发环境。

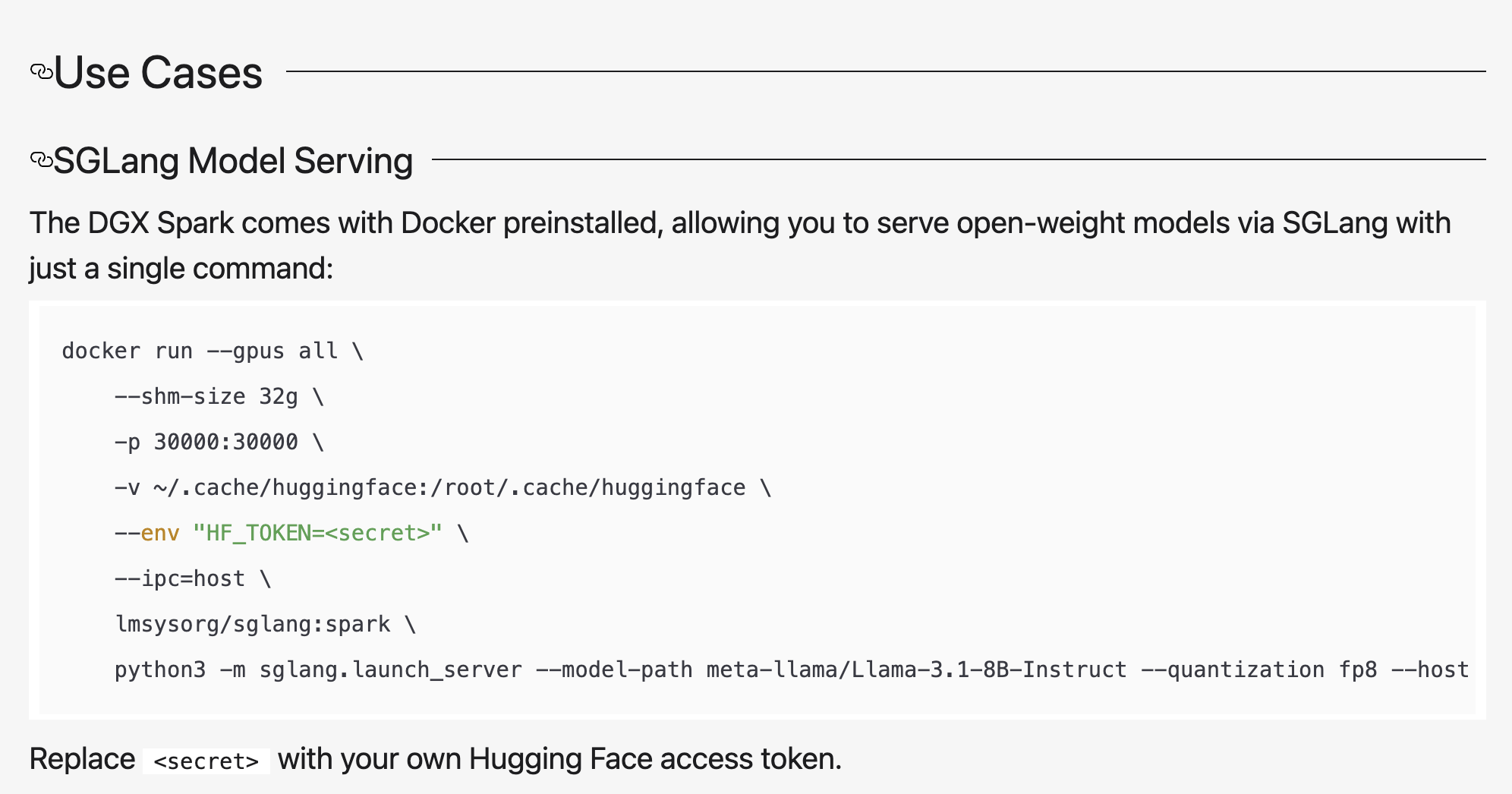

第一步:是测试 DGX Spark 能否像云服务器一样“一键上线模型服务”?这里的重点不在于模型能不能运行,而在于 DGX Spark 是否可以像云端一样,以服务形式常驻运行。

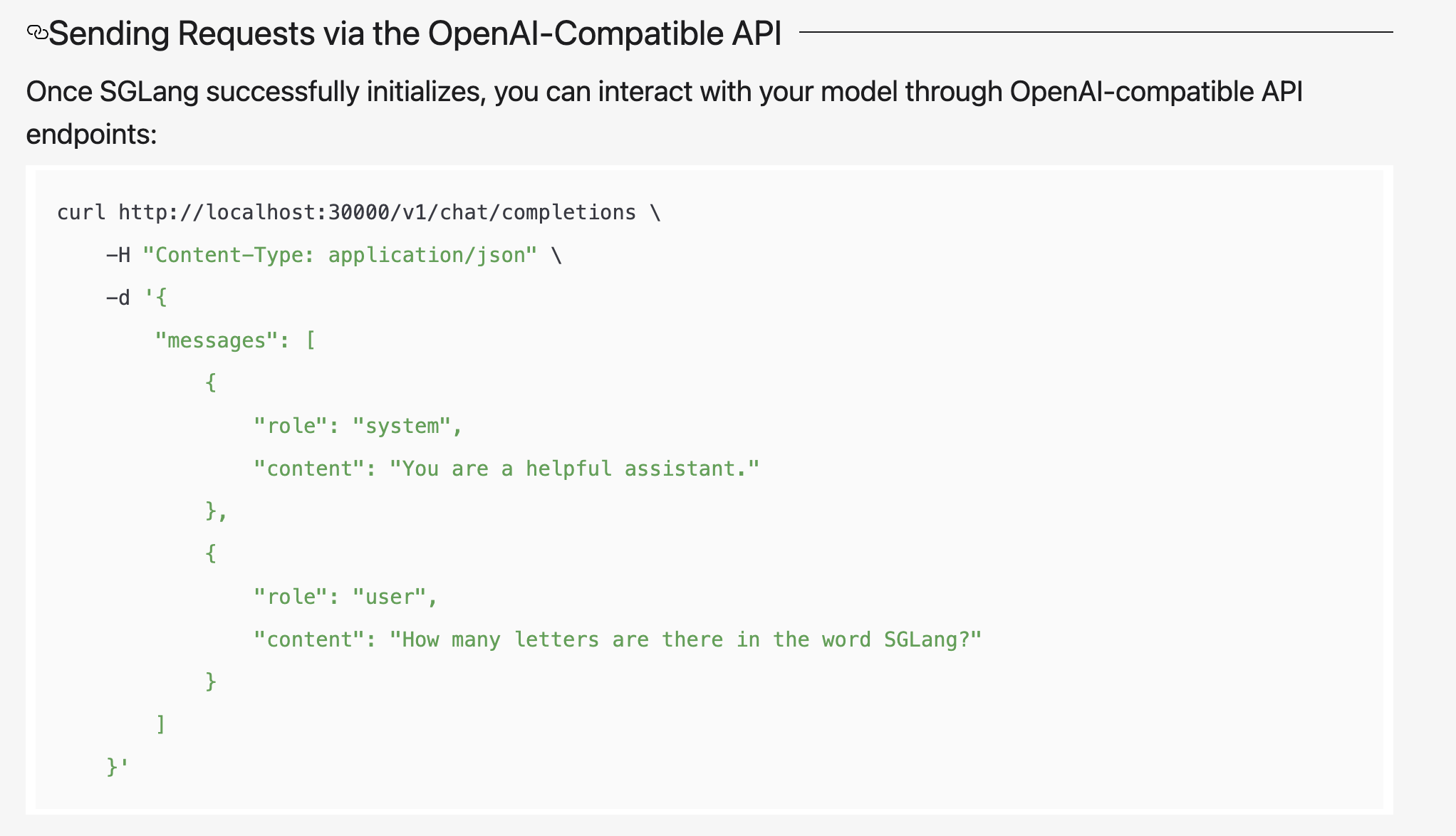

测试者首先通过 Docker 启动了 SGLang(SGLang 是 LMSYS 开发的一个专为本地大模型推理优化的高性能框架,能提供 OpenAI 接口形式的 API 服务),并直接加载 Llama 3.1 8B 模型。

结果显示:一条命令执行完毕之后,模型就常驻在本地端口等待调用,也就说 DGX Spark 此刻不只是 GPU,而是“本地 AI 节点”。

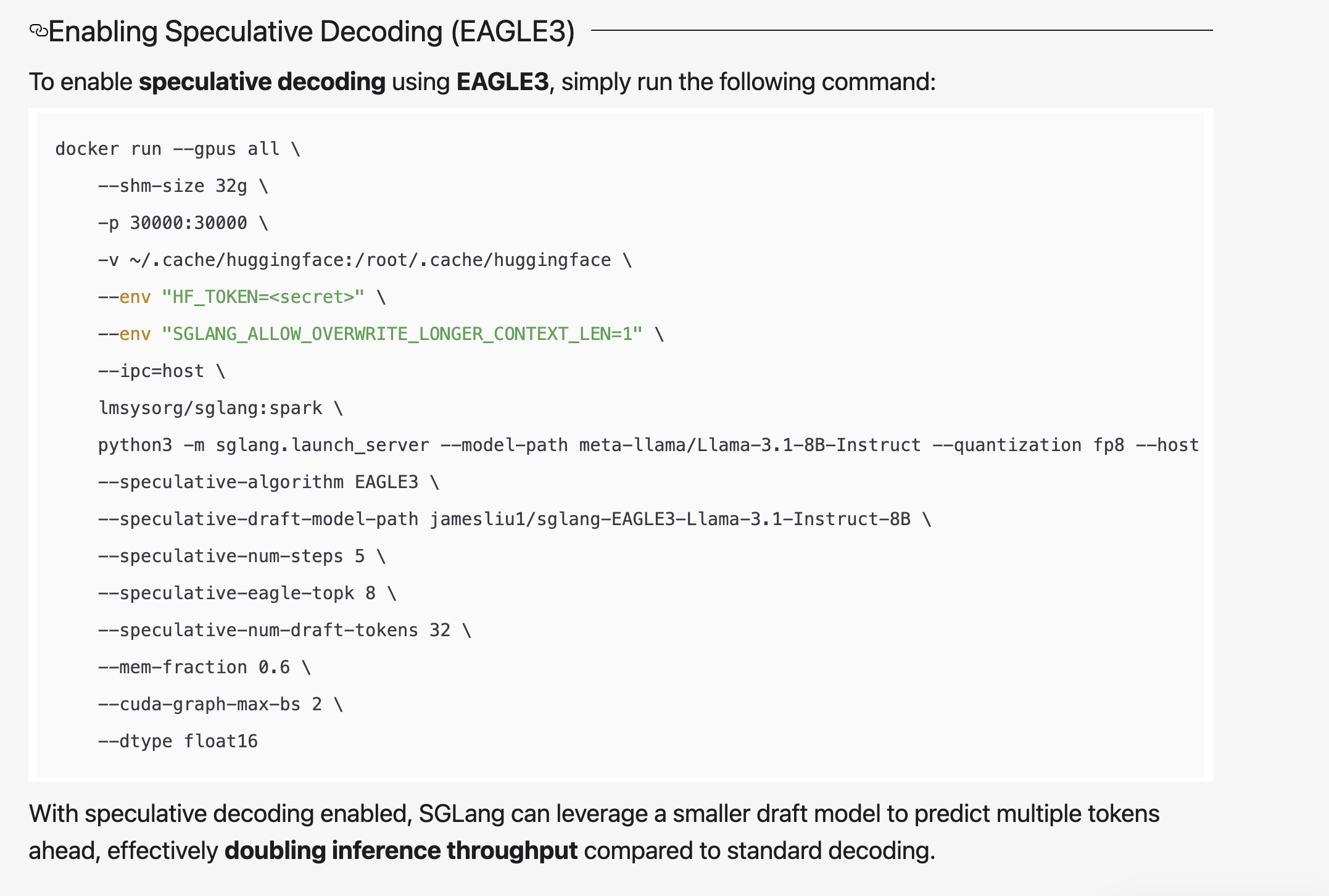

第二步:测试者启用了 Speculative Decoding(EAGLE3),这是目前高效推理框架正在使用的加速技术。如果 DGX Spark 只是能跑模型而缺乏调度和优化能力,这一步就会失败。

测试结果显示,DGX Spark 可以流畅启用该机制,吞吐效率明显提升,说明它不仅能运行模型,还支持推理加速策略。

第三步:测试者通过标准的 OpenAI API 格式(/v1/chat/completions)请求本地端口,DGX Spark 返回了完整 JSON 格式回复。

这一步非常关键:它证明 DGX Spark 不是执行一次性脚本,而是能以“API 服务”的方式对外提供模型能力,本质形态已经接近云端 ChatGPT 的调用体验。

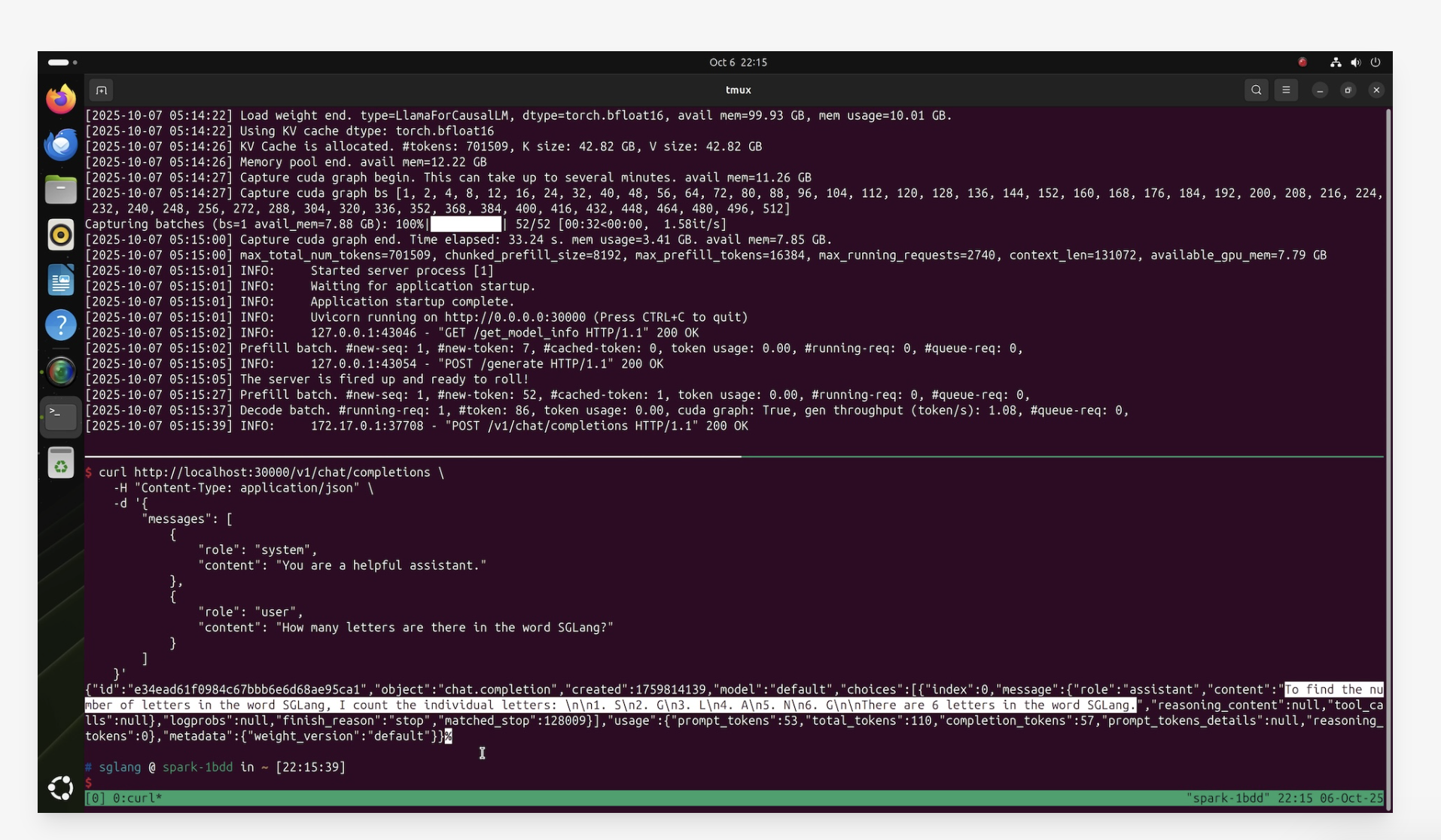

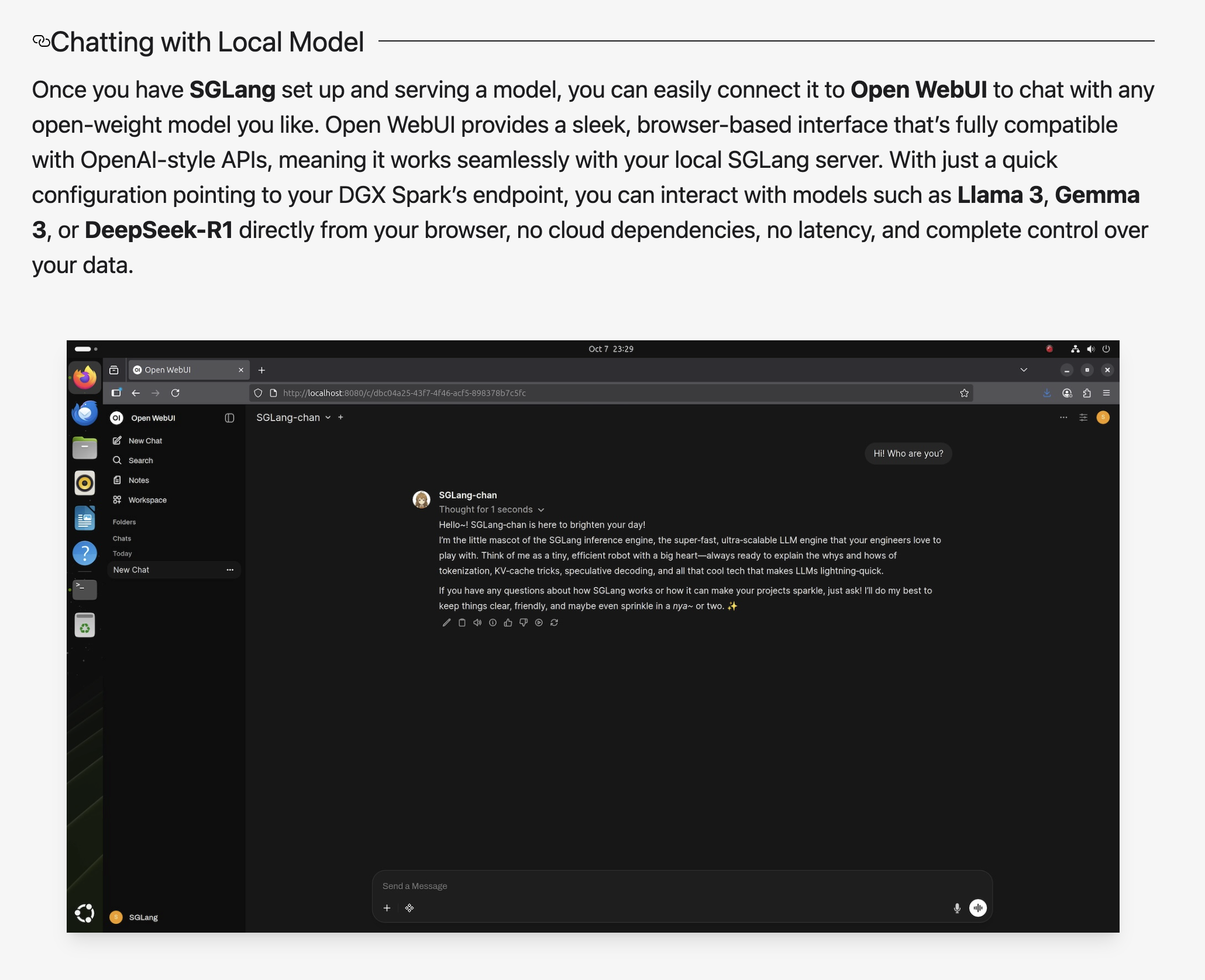

第四步:在此基础上,测试者接入了 Open WebUI。只需要在浏览器里输入地址,就能像访问 ChatGPT 网页那样与本地模型对话。

整个交互过程中不经过云,不需要账号,也无延迟抖动,也就是说 DGX Spark 不只是“算力盒子”,而已经是一个“类 ChatGPT 本地对话终端”。

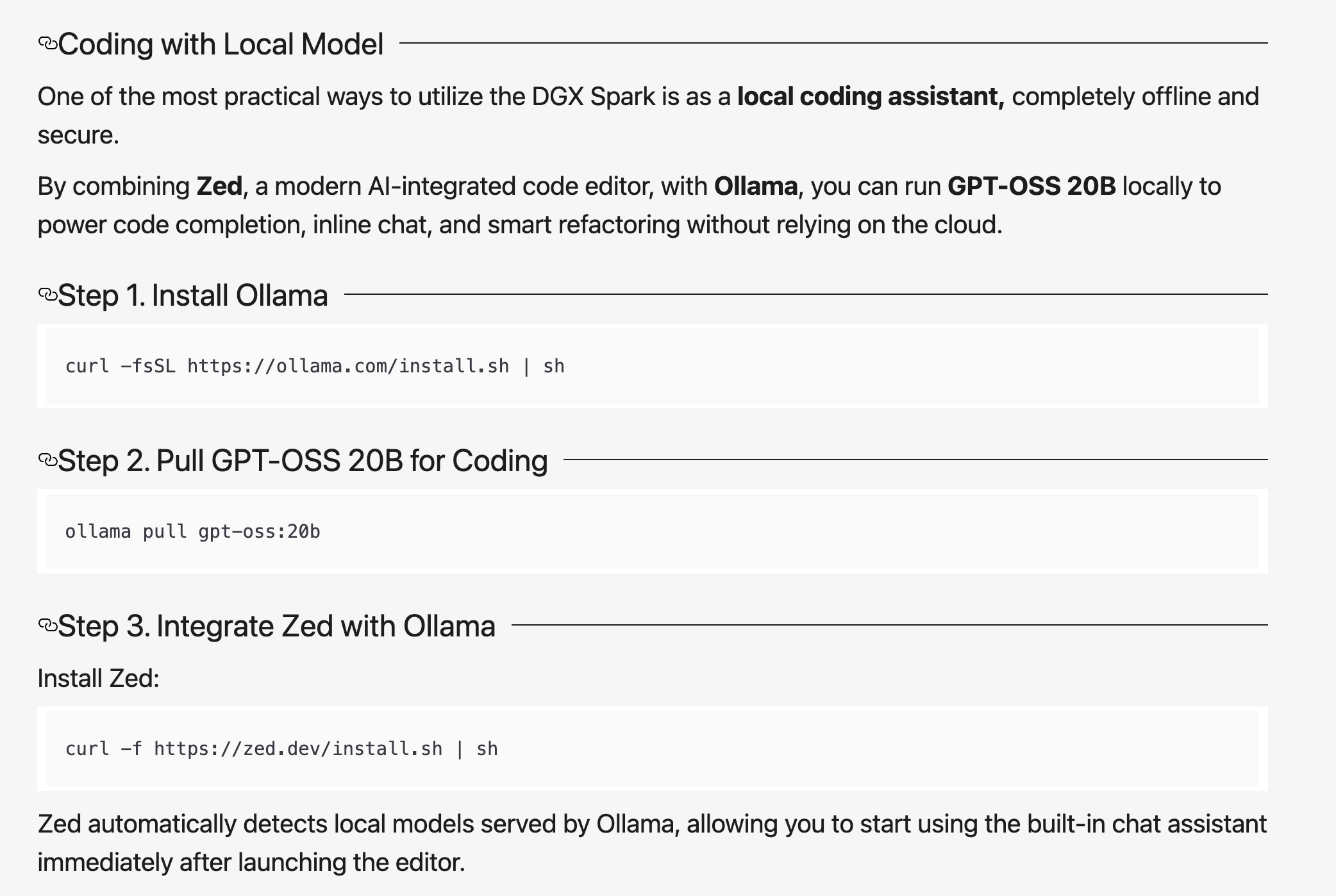

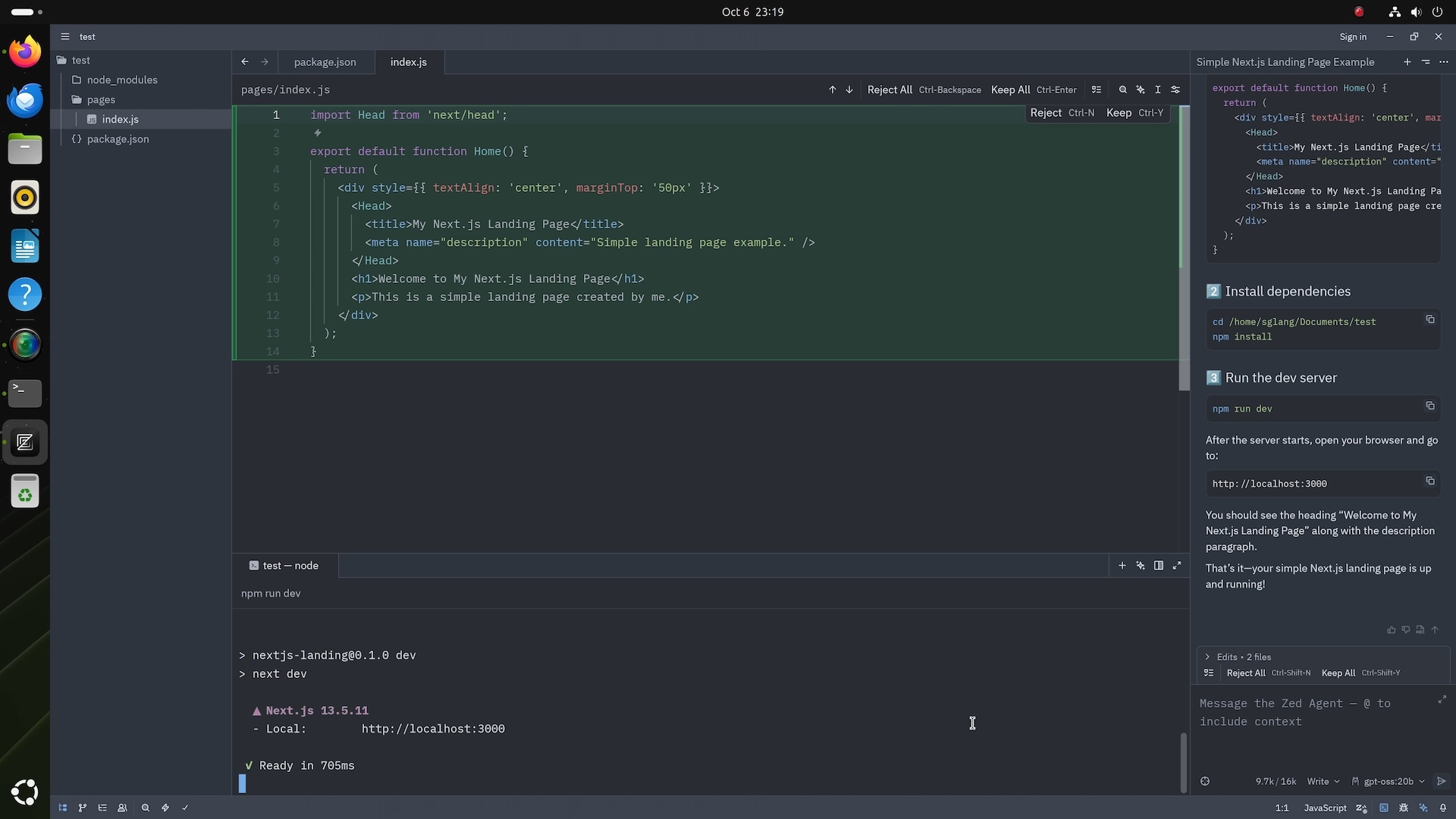

最后:测试者引入了 Zed 编辑器 + Ollama,IDE 可以自动识别 DGX Spark 提供的模型服务,并实现代码自动补全、上下文对话式重构等功能。

也就是说,DGX Spark 不只是能让你跑模型,还能直接成为“离线版 Copilot / Cursor 开发环境”,形成一个完整的个人 AI 工作流。

LMSYS 的测试证明,DGX Spark 最强的地方不是算力有多猛,而是它能在桌面上像“个人版 ChatGPT 服务器”那样一直开着,随时被浏览器、应用或编程工具调用,就像你自己拥有了一个本地的 OpenAI。

据英伟达消息,DGX Spark 基于全新 NVIDIA GB10 Grace Blackwell(GB10)超级芯片,这是让 Spark 成为“桌面级 DGX 节点”的关键。

GB10 不是一块普通 GPU,而是把 CPU 和 GPU 直接“焊成一颗芯”,共享同一块 128GB 统一内存,让大模型可以一次性加载进系统里跑,不用再受显存限制,也不用来回搬数据——换句话说,它把“只有数据中心 DGX 里才有的算力架构”塞进了一台桌面机器里。

“统统上云”遇到了哪些问题?

英伟达发布桌面级 AI 超算,也是 AI 由云转本地“反向迁移”的一个具体表现。

过去几年,“上云”几乎是 AI 行业的共同信仰。2020 到 2023 年,被认为是“云算力独大”的时代:模型训练、推理、数据存储与应用部署几乎全部在云端完成。那时的逻辑很简单:GPU 昂贵,本地算力薄弱,而云可以“即开即用”。

然而,到了 2025 年,热潮背后的一些问题开始浮出水面:比如昂贵的 GPU 租赁、隐私风险与网络瓶颈等等。

首先,云变贵了:推理成了新的成本黑洞。

在 2020 年代初期,云计算让 AI 公司几乎“租”到了无限算力。OpenAI、Anthropic、Cohere 等都依赖 AWS、Azure 或 Google Cloud 的 GPU 集群。

但当模型进入商业化阶段后,推理(inference) 成为新的成本中心——这是每天都要发生的动作,而云 GPU 按秒计费、带宽与出站流量另算,账单像雪球一样滚大。

InfoWorld 形容这种现象是“云端最隐蔽的烧钱机器”。

项目管理平台 Basecamp 的母公司 37signals 就曾发现年度云账单高达 300 万美元,最终决定“下云”,自建机房。另一家合规平台 EasyAudit AI 则遭遇更直接的冲击:CEO Christian Khoury 坦言,“我们看到账单从每月 5000 美元一夜飙到 5 万美元——推理就是新的云税。”

随着推理量级激增,成本失控成为普遍现象。于是,许多公司开始把部分推理迁移到客户本地节点或边缘服务器,甚至与硬件厂商合作开发“本地加速器”。这不是理念转变,而是经济现实的选择。

另外,本地也变强了:设备性能不再是瓶颈。

在 2025 年的 AI 生态中,桌面不再只是输入终端,而正在重新成为“计算现场”。

除了英伟达的 DGX Spark 把 1 PFLOP 级别的 AI 超算塞进开发者的办公室;还有微软的 Copilot+ PC 让笔电自带 NPU,可以直接在本地运行 GPT 模型;苹果的 Apple Intelligence 则把语义理解、日程提取、照片识别等敏感操作优先留在设备上执行。

一家 SaaS 公司将推理迁移至本地后,月度 AI 基础设施开销从 4.2 万美元降至 9000 美元;另一家客服工具厂商则因靠近用户部署模型,将响应延迟压缩至 50 毫秒以下,成本减半。

The Verge 称这是“一场算力回归个人设备的革命”。

多家厂商与分析机构判断:未来训练主要在数据中心,但推理正外溢到设备与边缘。越来越多的企业客户也在自建 GPU 节点,以获得更低成本和更高合规性。对他们来说,本地不是怀旧,而是控制力的回归。

还有值得一提的是,AI 应用变了,像是从后台工具转变为了实时伙伴。

AI 不再只是文本生成或图像处理,而正深入语音助手、视频生成、工业控制、AR/VR 等实时场景。

这些应用对延迟极其敏感:几百毫秒的网络往返就足以让体验崩塌。

因此,越来越多公司把实时推理下放到端侧和边缘节点,只让云端负责训练与汇总。

这种“近端计算”的扩散,让 AI 真正变成分布式系统:云是“大脑”,本地是“手脚”,端侧是“神经末梢”。

在 AI 快速发展的时代,云端依然是大热门;不过正如英伟达的个人 AI 超算,或许正在为另一种选择打开窗口——让开发者有机会在自己的桌面上掌控算力、部署模型,并决定 AI 运行的位置和方式。

对于把“把云上 AI 能力拉回桌面”的 AI 超算,你怎么看?

参考链接

https://www.theverge.com/news/798775/nvidia-spark-personal-ai-supercomputer

https://blogs.nvidia.com/blog/live-dgx-spark-delivery/?utm_source

https://lmsys.org/blog/2025-10-13-nvidia-dgx-spark/

https://www.theverge.com/news/631957/nvidia-dgx-spark-station-grace-blackwell-ai-supercomputers-gtc