在一年前和我司 CTO 探讨开源和技术势态的时候,我们碰撞出来一个观点——“作为一个开放、领先的科技公司,我们应该可以主动利用社区数据,形成自己对技术趋势的洞察”。由此,我们开始尝试基于开源社区的行为数据,对技术趋势进行分析。并且,“来自于社区,回馈到社区”,我们不仅会把这个分析到的全景图和结论分享给社区,也会把过程中的数据分享出来。

在上半年的 “527 蚂蚁技术日”,我们发布的全景和趋势 1.0 版本得到了很多关注和肯定。更重要的是,我们的同事和社区的朋友们在技术和架构判断、技术选型、兼容性取舍,甚至是商业拓展选择上都有参考全景图所呈现的信息。当然,发布后的这三个多月,我们也收到很多意见、建议和疑问,同时社区也发生了很多变化,于是,在外滩大会上,2.0 的发布也如期而至了。

—— 王旭,蚂蚁集团开源技术委员会副主席

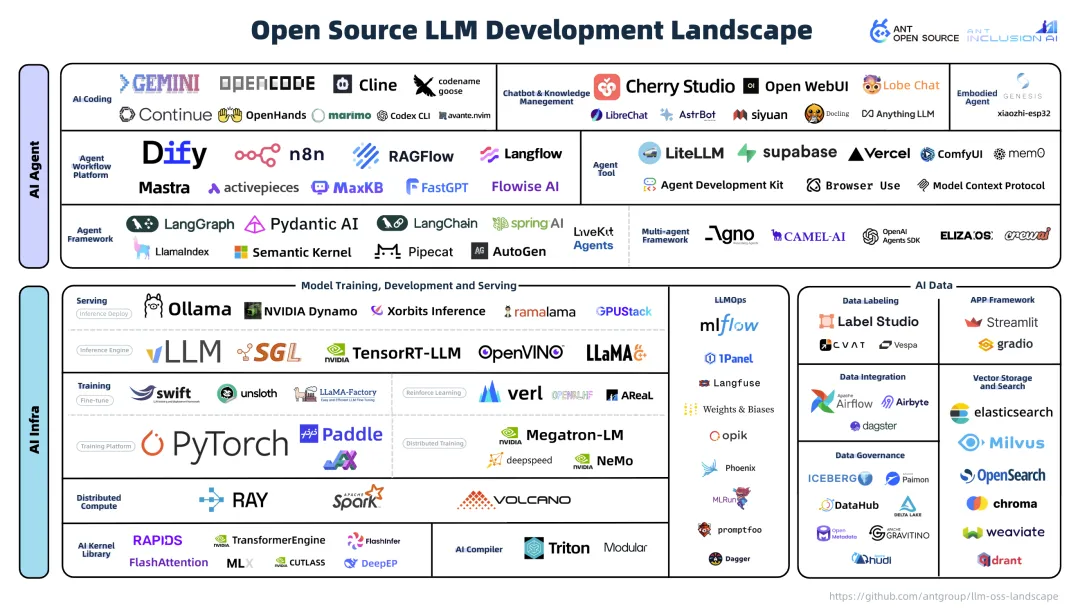

3 个多月前,在一年一度的「527 蚂蚁技术日」上,蚂蚁开源联合 Inclusion AI 首次发布了一份大模型开发生态下的开源项目全景图,和一份对生态趋势的洞察报告。我们希望能依据对社区的洞察,指出生态中哪些项目是最应该跟踪、使用和参与的,反之亦然。在这一全景图中,我们收录了 19 个技术领域的 135 个社区核心项目,并结合社区数据洞察给出了 7 大趋势预测。

(图源:527 蚂蚁技术日,蚂蚁开源技术委员会副主席 - 王旭)

很高兴看到,我们发布的全景和趋势在过去这段时间得到了很多关注和肯定。当然,发布后的这三个多月,我们也收到很多意见、建议和疑问,比如对于上榜项目许可证选择的争议、开源项目入选标准的咨询、以及在其他技术领域是否可以复刻相关研究方法的探讨……100 天转瞬即逝,开发者们在开源社区的每一次代码提交、每一次项目引用,都在悄然勾勒着行业未来的走向,在这个仿若「真实世界的黑客松」的 AI 战场里发生了很多变化。于是今天,在外滩大会上,我们诚意满满的「大模型开源开发全景与趋势」2.0 版本如期而至。

在 2.0 版本的迭代中,我们对看生态全景的方法进行了更新,果然发现了更多之前未注意到的、热度和活跃度都相当高的开源项目。当然,也有不少在数据拼杀中被拿掉的项目,从趋势来看已经在走向「AI 墓园」的路上。再看生态与趋势,有些领域和项目已经出局,有些领域和项目第一次进入视野,还有一些,正从早期的混沌中脱颖而出,在这个新兴的生态位中站稳了脚跟。

开源明星易主,群雄逐鹿今谁强?重器谁执牛耳,我辈入局在何方?这 100 天中的变与不变,都将在下文的报告中为你一一呈现。

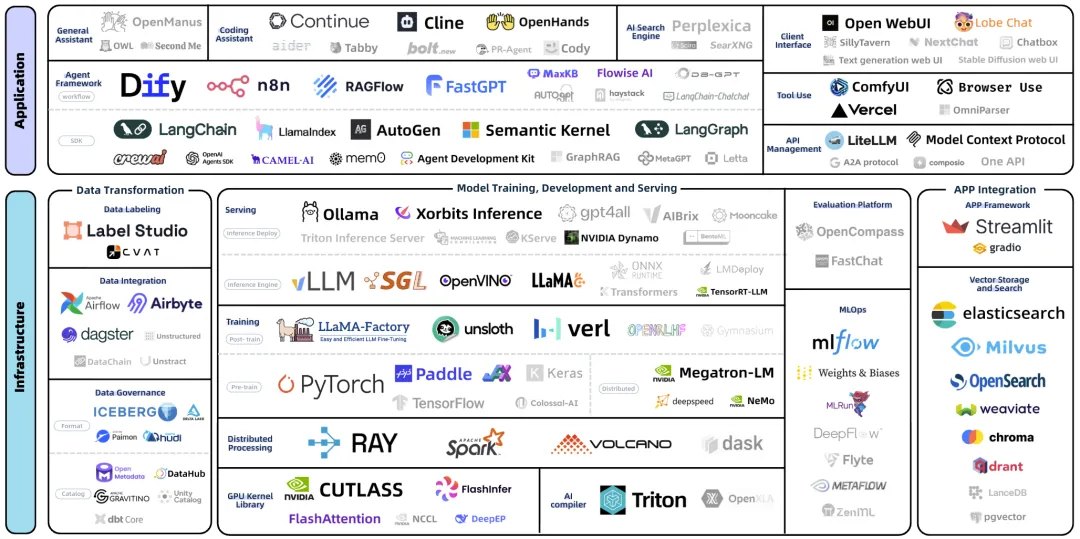

大模型开源开发生态全景

https://antoss-landscape.my.canva.site/

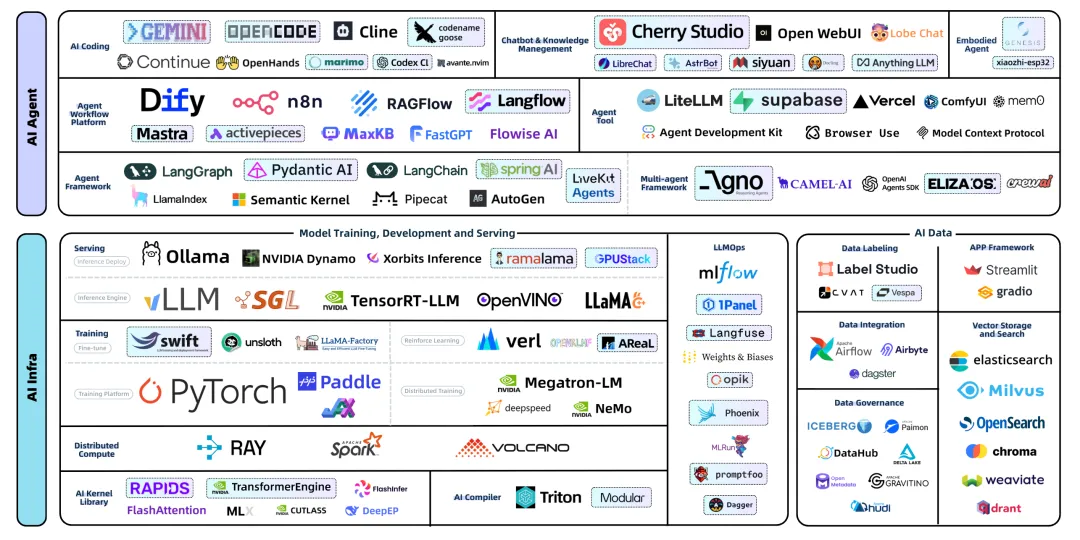

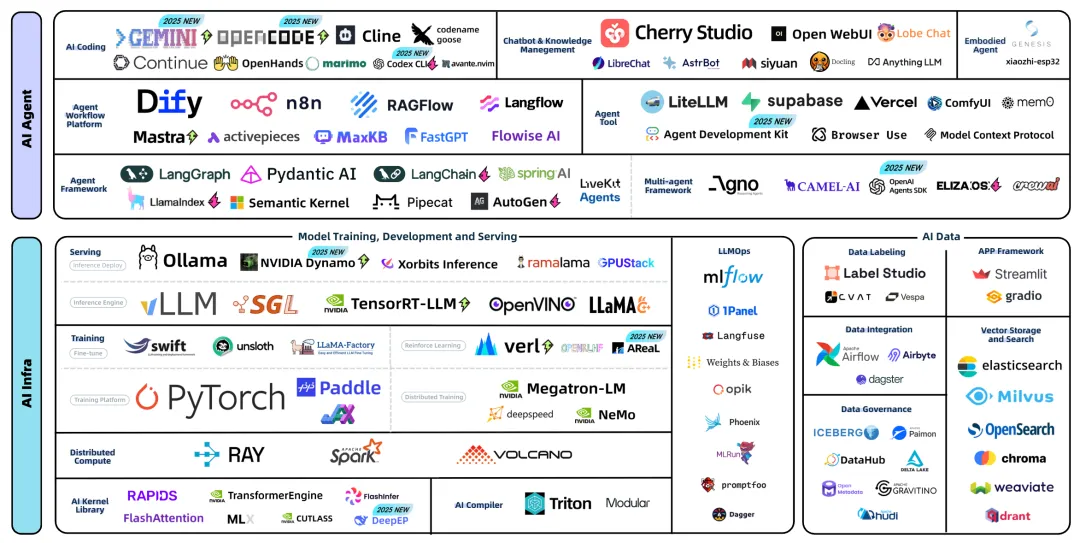

这张全景图整体分为 AI Infra 和 AI Agent 两大技术方向,基于我们对社区数据的洞察,收录了 114 个在这个生态下最顶尖也最受关注的开源项目,这些项目分布在 22 个技术领域。

在数据洞察中,我们依旧大量使用了 OpenRank 评价体系,OpenRank 是一种基于社区协作关联关系,计算生态中所有项目的相对影响力的算法,在我们后续的数据洞察中还将多次引用这一概念,在此特别说明。关于 OpenRank 评价体系的详细介绍可以参阅其文档:https://open-digger.cn/docs/user_docs/metrics/openrank

不同于 1.0 版本的是,第一版中,我们是通过一些已知的种子项目(PyTorch、vLLM、LangChain),基于开发者的协作关系多跳搜索和它们紧密关联的开源项目,并将其进行整理呈现。这种方式受到选取的种子项目、每跳返回的项目数量等因素影响,得到的结果具有很大程度的随机性。而这一次,考虑到全景图使用的评价方法 OpenRank 本身就是一种基于社区协作关联关系的算法,我们直接拉取了当月 GitHub 全域项目的 OpenRank 排名,根据描述和标签来从上往下标注出其中属于大模型生态的项目,再逐步收敛。果然,这个过程中发现了更多之前未发现的、热度和活跃度都相当高的项目们,让我们可以自信的将参考标准提高至了当月 OpenRank 达到 50 这个水平。

和百天前发布的大模型开源开发生态全景图 1.0 版本相比,有 39 个项目是这次新进的,占据当前整体版面的 35%。而第一版中的 60 个项目被拿掉了,这背后最主要的原因是项目达不到 OpenRank 大于 50 这个新的标准,而其中有不少从趋势来看,也确实已经在步入「AI 墓园」的路上,后面我们会详细展开;也有部分项目,典型的如 ONNXRuntime,由于主要面向于传统机器学习的训练和推理,在大模型领域并没有很紧密的结合而被拿掉。

算上那些被拿掉的在大模型开发生态的项目,这些项目从创建至今的“年龄”中位数是 30 个月,也就是两年半。他们年轻的程度正应和着这个领域迭代的速度 —— 高达 62% 的项目都是在 “GPT”时刻(2022 年 10 月)之后发布的,而其中有 12 个项目甚至是在今年才新近发起的。在如此崭新的基础上,这些项目获得的关注度却是上一个时代的开源项目们难以企及的:它们平均获得的星标数量高达近 3 万个。

这些项目吸引了全球 366,521 位开发者的参与。在能够统计到位置信息的开发者中,约 24% 来自美国,18% 来自中国,其次是印度(8%)、德国(6%)和英国(5%)。无论是大模型的研发还是围绕着模型的开源开发生态,美国和中国都扮演着主导角色,这一格局也许会进一步影响全球技术的演进与合作。

从生态全景到技术趋势

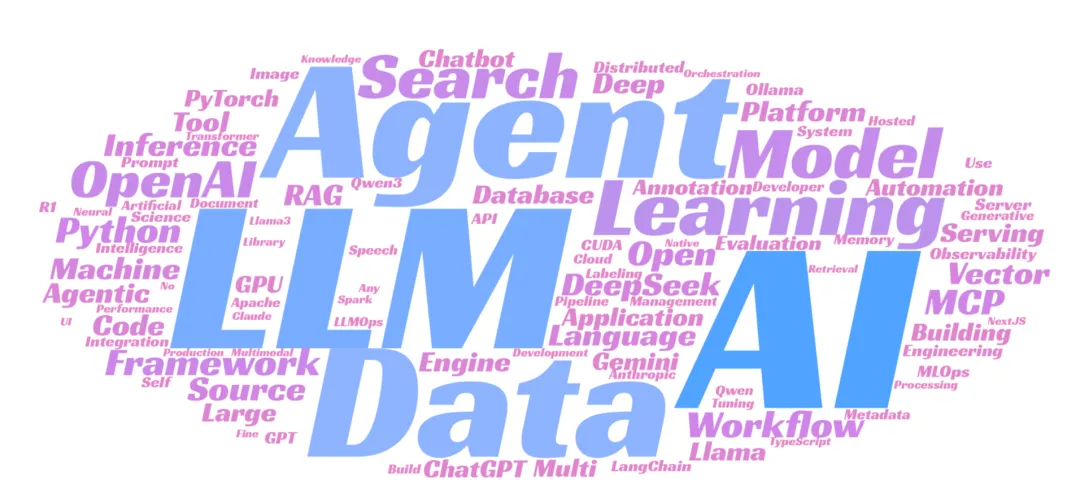

大模型开发生态关键词

把上述大模型开源开发生态全景图中所有的开源项目在 GitHub 首页填写的 description 和 topics 中的内容作为文本提取关键词,并在提取过程中做一些基本的规则化处理:大小写和单复数合并(MCP & mcp、agents & agent 等),去除常用词(a、an、and 等)。我们最终得到一张这样的词云图,图中一共有 100 个单词,总结了当下大模型开发生态的技术关键词。其中,最高频出现的词语为:

0. AI:126 次

1. LLM:98 次

2. Agent:81 次

3. Data:79 次

4. Learning:44 次

5. Search:36 次

6. Model:36 次

7. OpenAI:35 次

8. Framework:32 次

9. Python:30 次

10. MCP:29 次

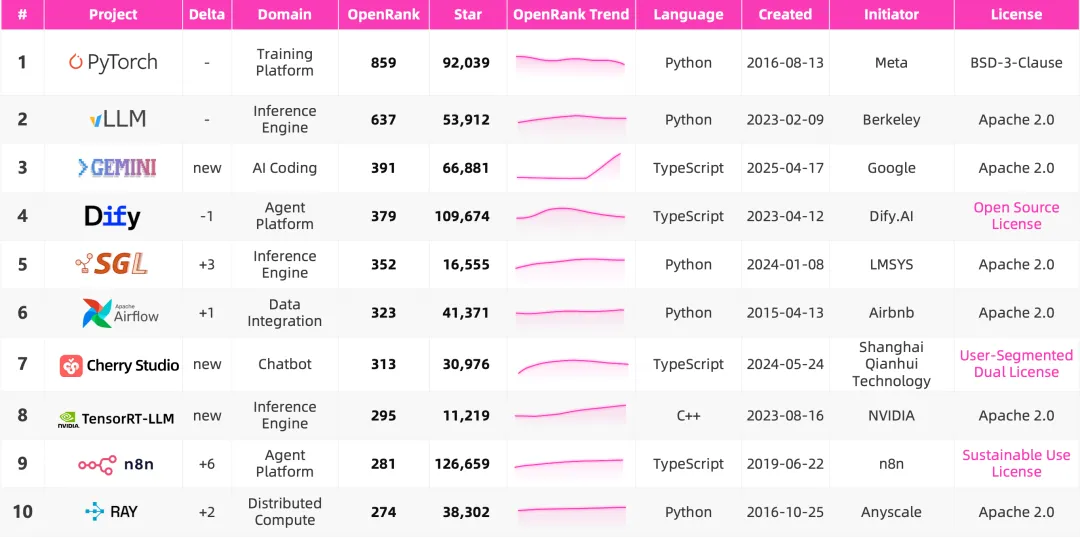

最活跃的开源项目 Top 10

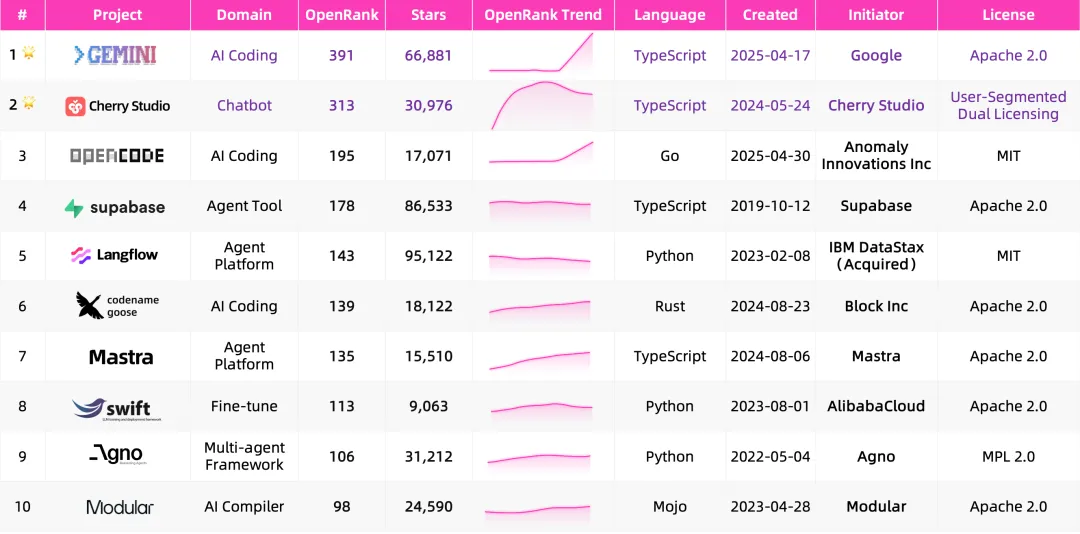

我们梳理了 OpenRank Top 10 的开源项目。

注:以上数据截止 2025 年 8 月 1 日

头部的这 10 个项目,代表了当下大模型开发生态里最活跃、最具代表性的社区力量。它们几乎覆盖了模型生态的完整链路:从底层的算力和框架 PyTorch、Ray,模型训练的数据处理管线 Airflow,模型服务的性能基座 vLLM、SGLang、TensorRT-LLM,到 Agent 应用调度平台 Dify、n8n,直接面向开发者与终端用户的 Gemini CLI、Cherry Studio。

从编程语言来看,Python 主导基础设施,TypeScript 统治应用层,成为支撑整个生态体系的核心语言。

从背后的发起力量来看,我们看到了来自学术界的创新迸发出的高影响力:vLLM、SGLang、Ray 都生长于 Ion Stoica 执掌下的伯克利实验室;Meta、Google、NVIDIA 这些大厂掌控或布局在一些关键节点之上,但在靠近应用层的位置,Dify、Cherry Studio 这样的独立团队也能够迅速创新,通过提供用户友好的工具,形成快速增长点。

如何定义这个时代的开源?

熟悉围绕开源许可证的一些前尘往事的开源朋友,在看到刚刚这 10 个顶尖的项目所采用的许可证时,也许心中已经警铃大作。是的,虽然多数大模型开发生态的项目仍然采用的是 Apache 2.0 或 MIT 宽松许可,但仍然有不少值得关注的特别案例:

Dify 的 Open Source License 基于 Apache 2.0 许可的文本做了修改,增加了两个附加条款:

限制未经许可的多租户环境运营;

使用 Dify 前端时,不得移除或修改 LOGO 和版权信息。

n8n 的 Sustainable Use License 是 n8n 基于 fair-code 主张,新提出的一种许可,在允许免费使用、修改、分发的基础上,做了三点限制:

仅限于在企业内部,或者非商业、个人用途下使用或修改;

在分发时,必须基于非商业目的免费提供;

不能更改软件中的许可、版权或作者信息。

Cherry Studio 的 User-Segmented Dual Licensing 根据用户所在组织的规模做分段,提出了一种双许可限制,不同规模组织下的用户使用不同的许可:

如果是个人用户或者所在组织是 10 人及以下,采用 AGPLv3,这也是一种 copyleft 协议,用户可以免费使用,但如果做了修改和分发,必须同样开源并提供完整的源代码;

超过 10 人的情况,则需要联系 Cherry Studio 的团队进行商业授权。

可以看出,上述许可证的条款多半是出于保护商业利益的考虑,由于带有对部分用户的限制属性,自然难以获得 OSI 的批准。从开源原教旨主义的角度来看,它们甚至未必算得上真正的开源项目。

在当下,「开源」的定义愈发模糊:不仅“开源大模型”与“开放权重大模型”之间存在诸多争议,传统软件的开源也仿佛在雾里看花。与此同时,GitHub 不再只是单纯的代码托管、协作和分发平台,而是成为这一时代的运营阵地:许多连源代码都闭源的产品(如 Cursor、Claude-Code 等)依旧在 GitHub 上占有一席之地,让看客们常常拥有一种它们也是开源项目的错觉。这些仓库无一例外拥有一骑绝尘的 Star 数量,但它承担的真正功能也许只是作为厂商收集用户反馈的入口。

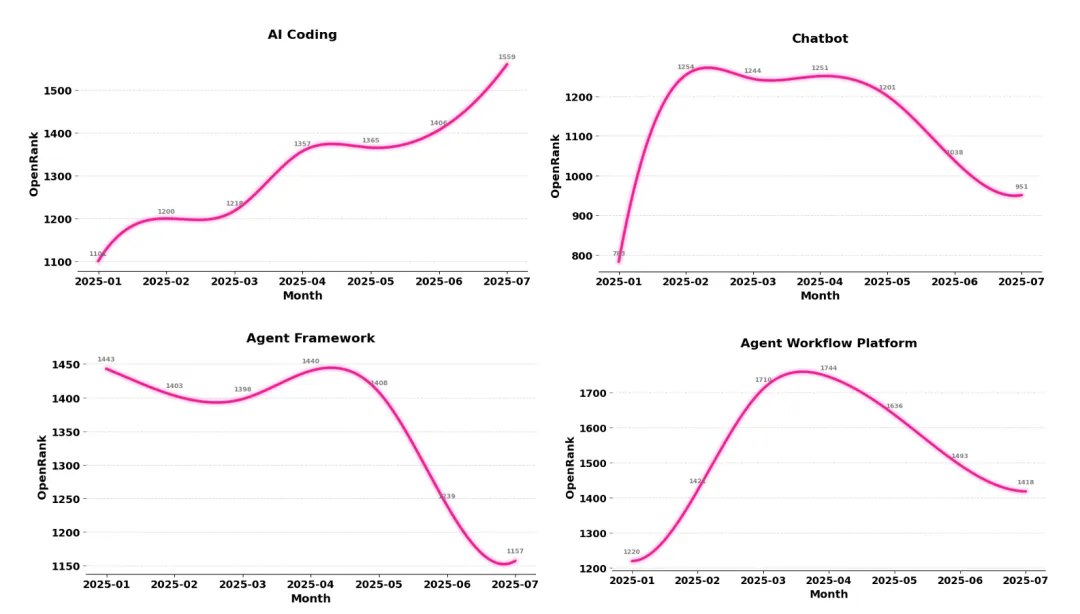

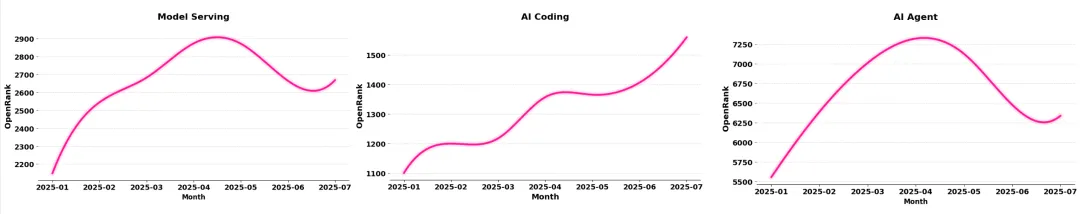

技术领域的发展趋势

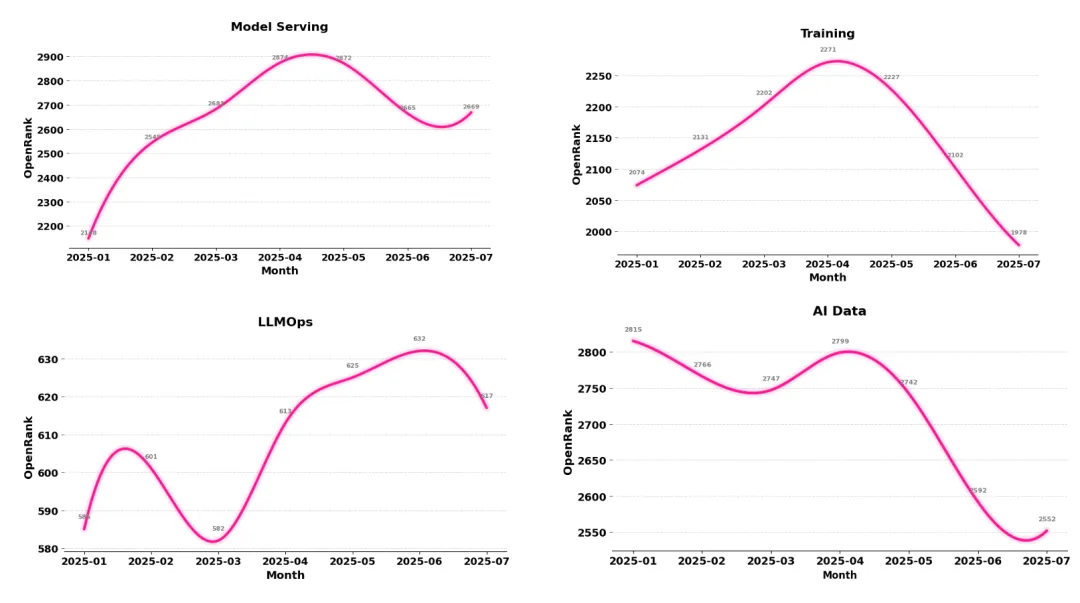

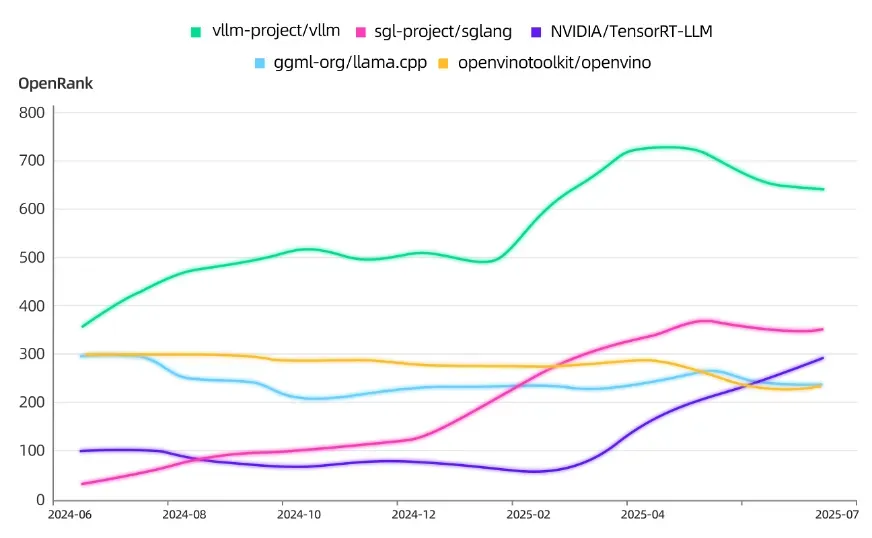

从今年的技术领域发展趋势来看,AI Coding、Model Serving 和 LLMOps 整体处于增长的态势,尤其是 AI Coding 的增长斜率在近两个月还在持续攀升,再次印证了 AI 研发提效是 2025 年真正被验证和落地的应用场景;Agent Framework 和 AI Data 是下跌比较明显的两个领域,Agent 开发框架的下跌和曾经在头部的 LangChain、LlamaIndex、AutoGen 等项目在社区投入上的显著收缩有很大关系,而 AI Data 在向量存储、数据集成及数据治理等维度上,也表现出在平稳中逐步下降的趋势。

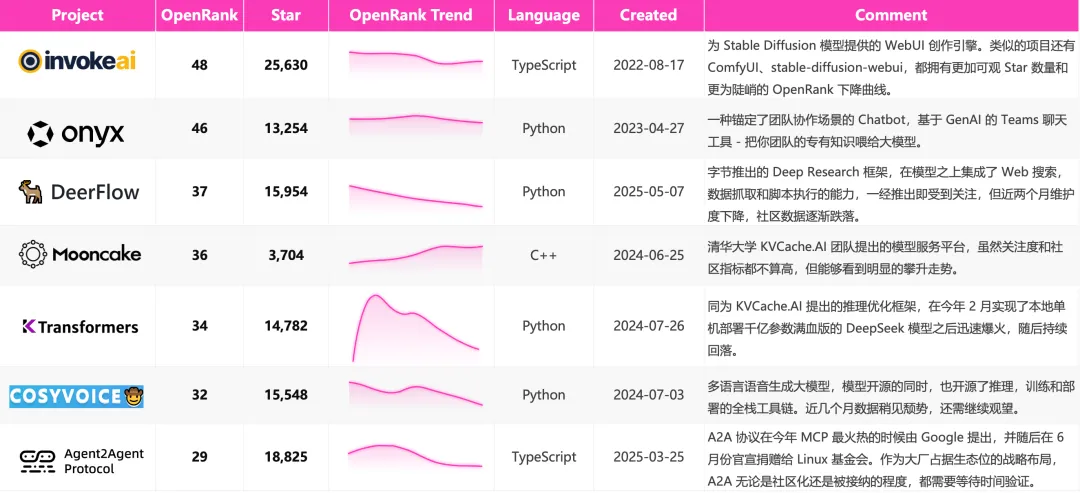

边缘地带的项目们

除了上述提到的「明星项目」,我们同样梳理了部分没有出现在全景图上,但是依旧被认为是很有潜力的开源项目们,我们会持续保持关注。

大模型生态下全球开发者分布画像

从 1.0 到 2.0,两次发布的全景图涉及到的一共 170 多个开源项目中,在其中有过 Issue 或 PR 相关行为的 GitHub 账号高达 36 万,这个数字一定程度上体现了当下大模型生态的开发者规模。我们识别到其中 124,351 位在个人页面填写了可以被正确解析位置信息的开发者,并统计了他们的国家分布和对应的在大模型开发生态中的贡献度分布。图和表中展示了头部国家的开发者贡献度总和、整体贡献度占比和识别到的开发者数量,其中,将开发者数量乘以三的话,可以大致认为是估算出的该国家大模型生态开发者的总量。

总体来看,中美引领了 AI 领域的开源贡献。美国以 37.4% 的贡献领先,中国以 18.7% 位居第二,这两个国家的贡献总比例达到 55% 以上,而排名第三的德国已降低至 6.5%。

注:开发者贡献度也使用 OpenRank 评价体系计算,是一种项目内基于 Issue/PR 协作网络的计算方式。

大模型开源开发生态整体贡献度 Top 10 国家分布

不同技术领域下的贡献度 Top 3 国家分布

分技术领域来看,AI Infra 开发者 56,206 人,AI Agent 开发者 56,580 人,AI Data 开发者 27,018 人,这个总和与 12 万开发者的总人数相差不多,说明不同领域下的重复开发者比例不高,大多数人只参与一个技术领域下的项目。

从三大技术领域下的国家贡献度分布来看,整体以中美为主导,在 AI Infra 领域中美的领先地位更加明显,两国在基础设施领域的贡献度达到 60% 以上,排名第三的德国不足 4%,可见在基础设施领域中美有较强的控制力;AI Data 领域全球的参与情况更加平均,中美的总体贡献占比仅 46.5%,欧洲各国,如波兰、挪威、法国、荷兰等国的参与度均进入全球前十;AI Agent 领域中美差距大幅缩小,贡献度占比分别为 24.6% 和 21.5%,中国开发者在 Agent 层面相较其他领域的投入更多。

从 1.0 到 2.0,100 天中的变与不变

和 3 个月前的第一个版本相比,除了最明显的项目更替之外,我们也对整体的生态结构和领域做了合并、拆分和描述的调整,例如,将笼统的 “Infrastructure” 和 “Application” 的一级分类描述修改为更加具体的、也已经在逐渐发展出清晰技术边界的“AI Infra”、“AI Agent” 和 “AI Data”。技术仍在高速的发展,尤其在 Agent 领域,项目之间的定位和边界必然会随着技术发展而动态演化,我们可以通过 Landscape 的变化,观察到一个新的技术生态从混乱逐渐归为有序的过程。

哪些领域和项目出局了

无论 Manus、Perplexity 这些商业产品发展和普及程度如何,在开源生态里,相关领域下的开源项目都并没有得到很好的发展。

出局的项目中,有不少可能正在步入“AI 墓园”的路上 ——

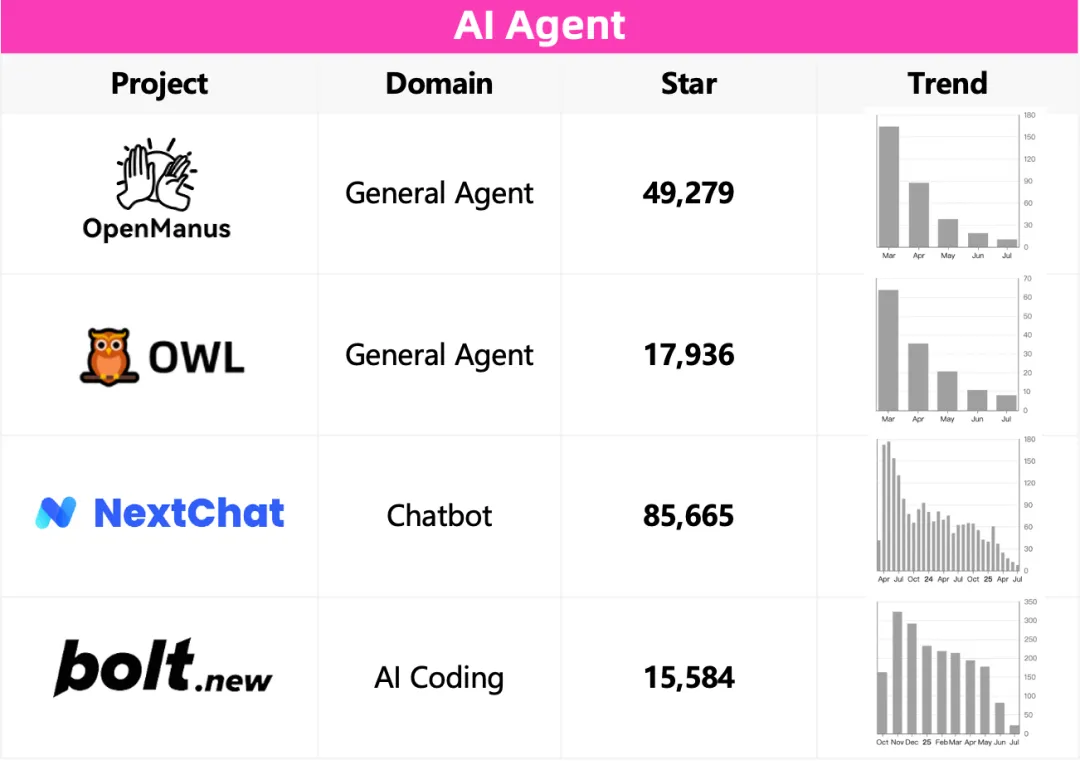

3 月份 Manus 一时爆火,多智能体框架 MetaGPT 和 Camel AI 紧随其后推出了开源版本的 OpenManus 和 OWL,但也仅仅只是昙花一现;

NextChat 是最早一批流行的大模型客户端应用的项目,但后续的迭代和新特性接入速度远远比不上 Cherry Studio、LobeChat 等后起之秀,渐渐无人维护;

Bolt.new 作为流行的全栈 web 开发工具,以开放模板的方式被开源出来,且很少合入外部的代码,因此项目开发者也在大幅减少。

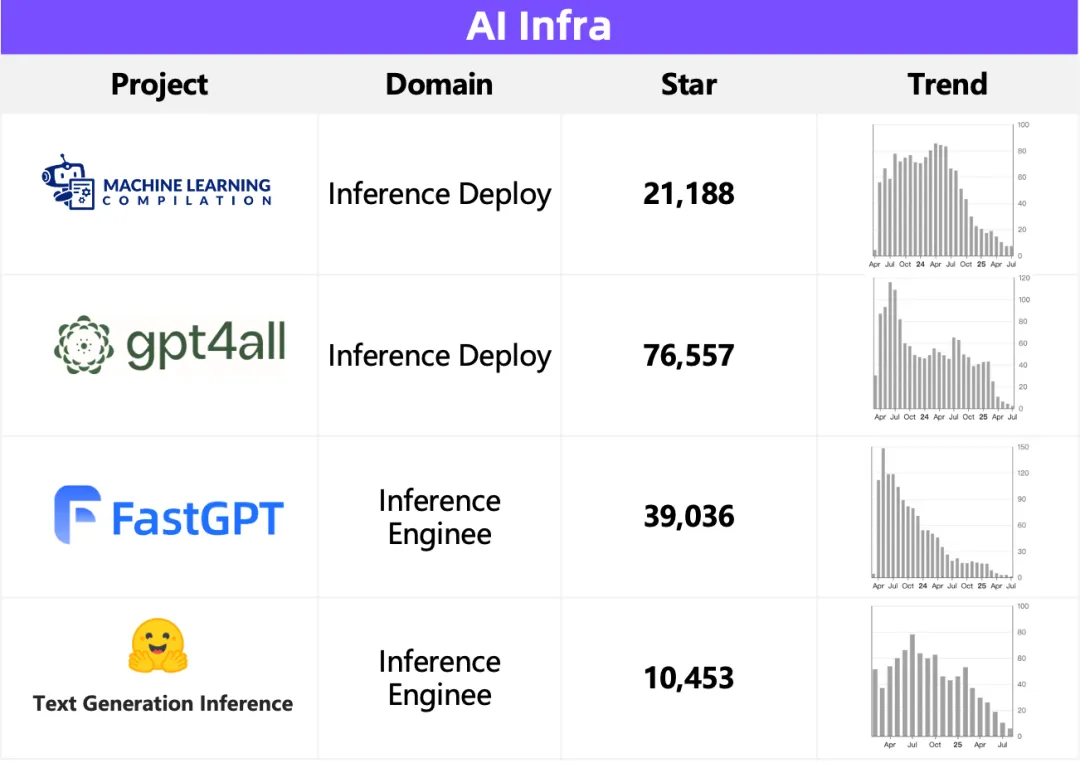

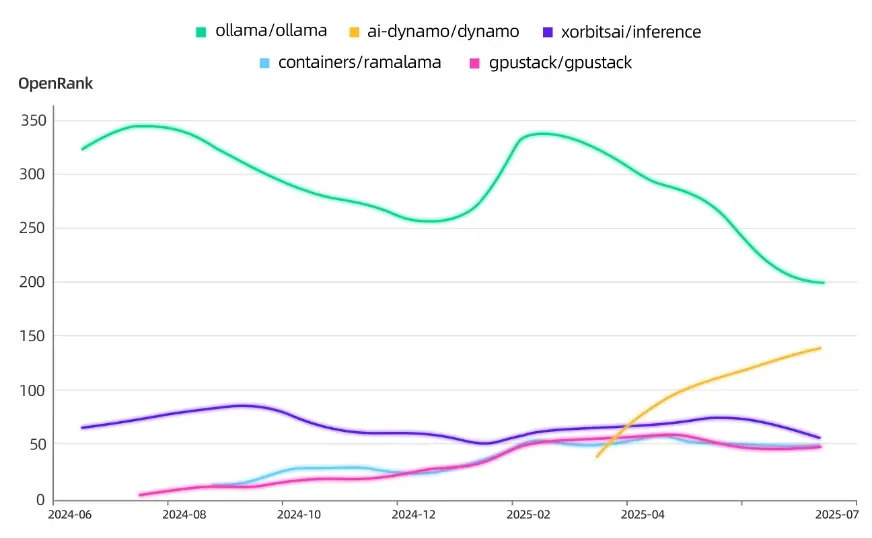

一度非常流行的两个端侧模型部署的工具:MLC-LLM 和 GPT4All,前者绑定了自家的推理引擎 MLCEngine,后者和 Ollama 同样使用了端侧推理引擎 llama.cpp,然而最终这个生态位还是被 Ollama 拔得头筹;

FastChat 是 LMSYS 在模型训练、推理和评测等环节的早期尝试,如今他们已经有了更成功的 SGLang 和 LMArena 平台,而更早出现的 TGI,由于性能落后于 vLLM 和 SGLang 等引擎,也渐渐被 HuggingFace 放弃。

昔日巨星 TensorFlow 的十年消亡之路

2015 年 11 月,谷歌将 TensorFlow 以 Apache 2.0 开源,很快发展为深度学习领域的主导框架。从诞生之初,TensorFlow 就为生产环境而设计,这与后来发布的 PyTorch 采取的 “Pythonic”和“研究人员优先” 构建理念截然不同。作为开发下一代模型的创新者,研究人员倾向于选择 PyTorch,因为它灵活、易用。

2019 年 10 月,TensorFlow 发布了 2.0 版本,借鉴了 PyTorch 的核心理念,简化了模型构建。然而,这种技术上的合理转变却付出了巨大的代价:由于缺乏无缝的向后兼容性,以及复杂的迁移工具,许多已经转向 PyTorch 的开发者不愿意承担迁移遗留的 1.x 代码和学习新 API 的负担,从而对 PyTorch 的忠诚度更加坚定。正是在这个时间点,PyTorch 社区正式超过了 TensorFlow,两个项目也从此走向了分化的发展曲线。

哪些领域和项目第一次进入视野

领域的变化主要体现在 Agent 层面,以 AI Coding、Chatbot 和开发框架为主的领域出现了不少新的高热度项目。在其中,还发现了两个和具身智能应用场景相关有趣项目:

小智 AI 聊天机器人:构建一个基于 ESP32 微控制器 的 AI 语音交互设备——“AI 小智”,让大语言模型(如 Qwen、DeepSeek)能运行在硬件中。

Genesis:面向通用机器人与具身的物理仿真平台,用途包括机器人学习、物理模拟、渲染与数据生成,具备极高的科研与应用价值。

Infra 层面在领域的变化主要体现在对“模型运维”这一概念的整合,我们将原先涉及到模型评测和传统机器学习运维的领域合并在一起,成为纵穿模型全生命周期的 LLMOps,它本质上是 MLOps 在大语言模型时代的延伸,解决的是如何在真实生产环境下高效、可靠、可控地使用 LLM。当前 LLMOps 领域下的这些项目覆盖了模型与应用的可观测性(Langfuse、phoenix)、模型评测与基准测试(Promptfoo)、Agentic Workflow 的运行时环境管理(1Panel、dagger)等环节。

新进项目中的最活跃开源项目 Top 10

注:以上数据截止 2025 年 8 月 1 日

其中,终端 AI 编程助手 Gemini CLI 和模型客户端交互聊天工具 Cherry Studio 还在本次大模型全景图的所有项目中位列第 3 和第 7。

没变的是:此消彼长,前浪后浪,增长与衰落,一如既往

全景图上的「The New Wave」

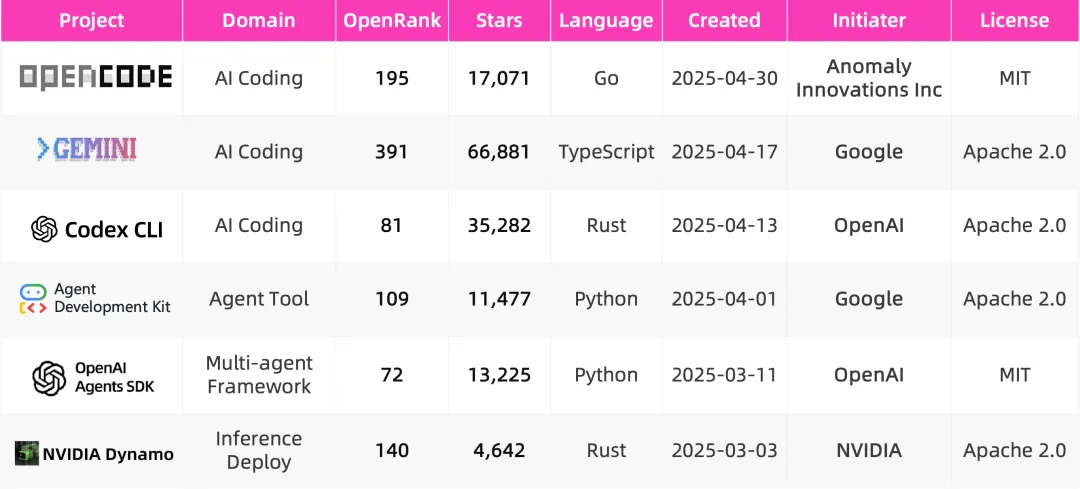

注:以上数据截止 2025 年 8 月 1 日

在这些 2025 发起的新势力项目中,OpenCode 来自于创业公司 Anomaly Innovations,并且在发起之日就定位为是 Claude Code 的 100% 开源替代。在剩下的几个项目中,我们可以看出 OpenAI、Google、NVIDIA 这些大厂通过开源开放的工具链来建立围绕其闭源模型或硬件生态的护城河的野心:Dynamo 在支持 vLLM、SGLang 和自家的 TensorRT-LLM 等主流推理后端的同时,也完美适配 NVIDIA GPU 的硬件特性,在成为高吞吐、多模型部署的行业级工具之后,会进一步促使企业倾向选择 NVIDIA 硬件以最大化性能收益。

OpenAI 和 Google 通过在应用层布局开源工具链,把开发者逐渐锁定在各自闭源模型的生态之中的野心则更加明显:adk-python 和 openai-agents-python 是专为其各自的闭源模型封装的 Agent 系统构建工具,Google 甚至做了云服务的生态优化,支持在 Google Cloud 上优先部署编排好的智能体;而 Codex CLI 和 Gemini CLI 同样效仿了 Claude Code 这种在终端实现高度自治的代码理解与修改的形态,把大模型直接带到开发者最熟悉的命令行里,一个深度绑定 Gemini,一个兼容 OpenAI 并开放 MCP 接口。

在接下来的一段时间,我们可以拭目以待,看看这些项目是否达到了它们被寄予的战略使命。

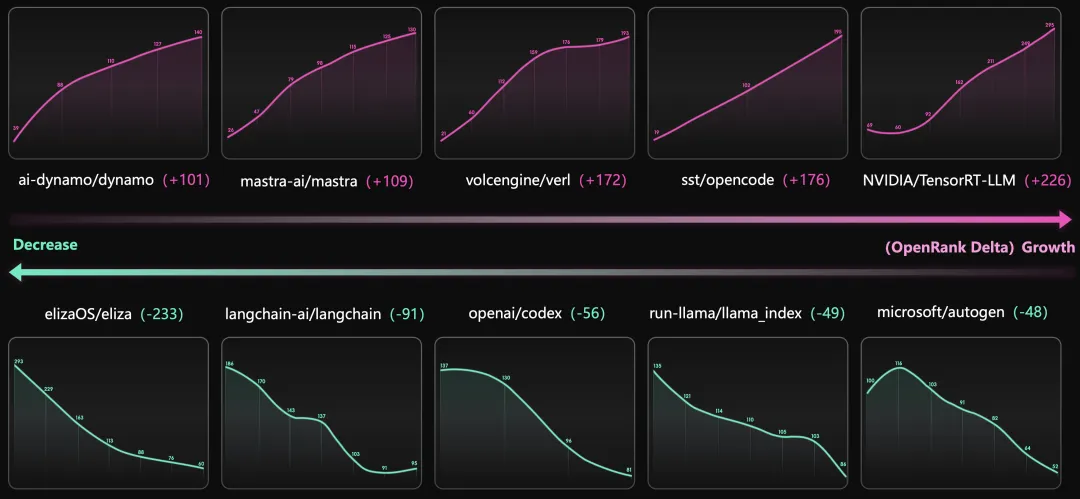

全景图上的「Up and Down」

上述十个项目,分别在近半年内 OpenRank 的增长和下降绝对值与比例都位列前茅,图上我们展示的是他们从 2 月到 8 月的 OpenRank 绝对值变化。

增长较明显的五个项目,分别是:NVIDIA 推出的企业级推理引擎后端 TensorRT-LLM 和多租户推理编排工具 Dynamo、字节推出 LLM 强化学习框架 verl、对标 Claude Code 的开源命令行 Coding 工具 OpenCode、面向 TypeScript/JavaScript 开发者的 Agent 编排框架 Mastra。

下降较明显的五个项目,有四个都是 Agent 编排框架:Eliza、LangChain、LlamaIndex 和 AutoGen。剩下的一个项目,是 OpenAI 在 4 月新推出的命令行 Coding 工具 Codex,相较于 Gemini CLI 的快速增长,它的起步看起来有一些出师不利。

专题洞察:技术趋势下的项目故事

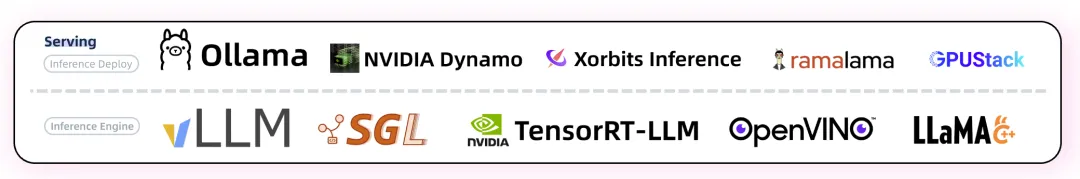

第一篇:Model Serving

模型服务的本质,是把训练完成的大模型以一种可被应用层稳定调用的方式运行起来。它需要解决的不仅仅是“能不能跑”,更是“能不能高效、可控地跑”。在场景上,大规模在线推理是模型服务的主战场,数据中心级的部署支撑了数以千万计的请求;与此同时,企业内部也常常出于安全与合规的考量,搭建私有化的推理服务;而在端侧,像 llama.cpp 或 Ollama 这样的项目,让模型能在个人电脑、手机甚至嵌入式设备上运行,满足离线和隐私需求;还有越来越多的混合模式,部分处理在端侧完成,复杂推理则交给集群完成。

2023 年以来的快速演进已经让模型服务成为连接 AI 基础设施与应用层的关键中间件。一方面,vLLM、SGLang 等代表性的推理引擎项目不断在高吞吐、长上下文、多用户并发的场景里打磨出极致性能,另一方面,Ollama、llama.cpp 等则推动了本地可用性和生态扩散,让大模型“跑在你手边”成为现实。同时,NVIDIA Dynamo 这样的编排框架正在把单机高效推理扩展到多节点、多模型、多租户的集群层面。

第二篇:AI Coding

从最初的单一代码补全功能发展到如今的多模态支持、上下文感知与协同工作流,AI Coding 的核心技术在不断进化。CLI 工具如 Gemini CLI 和 OpenCode 利用 AI 模型的强大推理能力,将开发者的需求转化为更高效的编程体验;与此同时,插件形态的工具,如 Cline 和 Continue,通过无缝集成到现有开发平台中,让开发者在保持现有工作流的基础上享受 AI 提供的各种智能服务,极大地提升了开发效率。

Goose 和 OpenHands 等协作开发平台,将 AI 能力融入团队项目管理、代码审查、任务分配等各个环节,推动了跨地域、跨职能的团队协作。而 Claude Code、Cursor 和 Windsurf 等闭源的商业化项目,也吸引了大量个人开发者和企业客户。随着市场需求的提升,AI Coding 的商业化潜力巨大,付费订阅、SaaS 服务、增值功能等将成为未来的主要盈利模式。

第三篇:AI Agent

人们常说 2025 年会是 AI 应用真正落地的一年。最初,是 LangChain、LlamaIndex 等框架提供了基础的 Agent 搭建方式;随后,开源生态中出现了专注于不同环节的项目,如 Mem0(记忆)、Browser-Use(工具调用)、Dify(工作流执行)、LobeChat(交互界面),开源社区正在构建完整的拼图,为更强大的自治 AI 系统打下基础。每个项目聚焦的方向不同,但目标一致:让 AI 更加智能地理解、记忆、行动和交互,从而真正解放生产力。

接下来一段时间里,我们会陆续放送围绕着上述热门的技术领域和代表性的开源项目们的专题洞察,敬请期待!

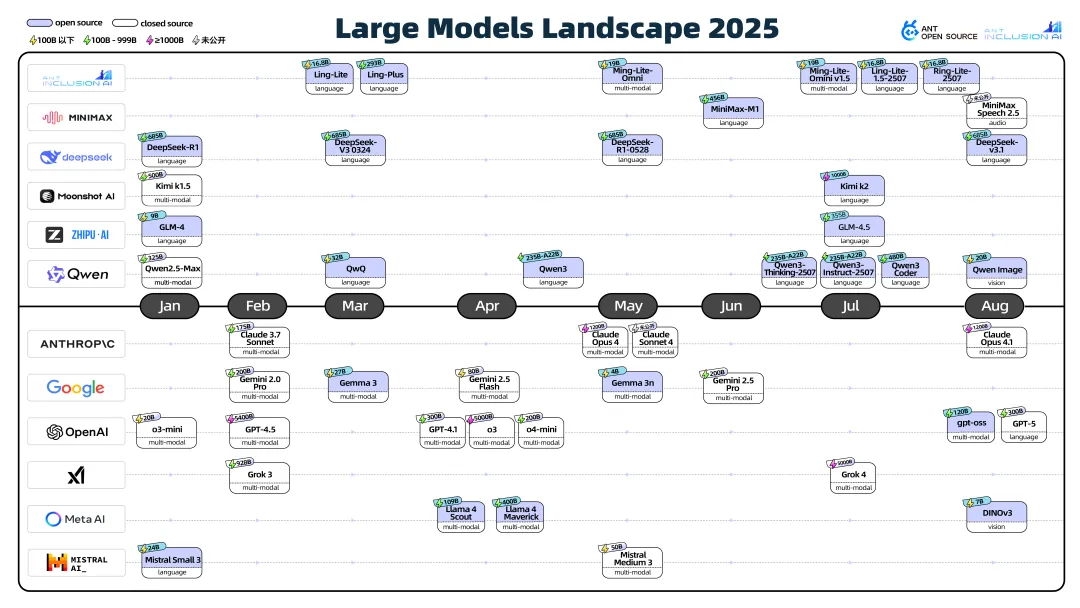

番外篇:大模型生态全景

在开源开发生态之外,大模型也在进行着高频的发布。虽然目前还没有很好的数据渠道来帮助我们理解大模型社区,但毕竟它们处在注意力焦点的中心。因此,我们也精心梳理了 2025 年 1 月至今国内外主流厂商的大模型发布时间线,包含开放参数的模型和闭源模型。这张全景图内也标注了每个模型的参数、模态等关键信息,来一定程度上帮助理解当下各家厂商的白热化竞争究竟是在哪些方向上展开的。以此,我们得出了一些有趣的观察,比如:

中美开源与闭源的路线分化:从这张图上,能够更直观地感受到中国开源大模型的百花齐放,而国外的顶尖模型厂商依旧走的是闭源路线。在早期几乎凭借一己之力对抗模型封闭生态的 Meta(也使得不少在全景图上的开源项目名字中都带有“llama” 的元素),似乎也正在考虑向闭源转型:7 月 31 日,Meta CEO 扎克伯格发布了一封名为 「Personal Superintelligence」的公开信,表达对超级智能个体的野心的同时,还说了这样一句话:“我们会更谨慎的选择开源什么"。Meta 在今年的 AI 战略发展确实不尽人意,各大评测榜单上已经看不到 Llama 系列的身影,而四月份发布的 Llama 4 也陷入了“效果差”甚至是“造假”的争议。

MoE 架构下模型参数在规模化发展:今年发布的 DeepSeek、Qwen、Kimi 等旗舰模型全面采用了专家混合(Mixture of Experts,MoE)这种神经网络架构,它最朴素的原理为“稀疏激活”:虽然模型总参数可以非常庞大,但每次推理时只用其中很小一部分。在这种架构下,我们看到了 K2、Claude Opus、o3 等达到了万亿参数规模的庞大模型在今年陆续发布。参数规模的增加能够有效提升模型在任务上的表现,但同时也对训练和推理时的计算与内存带来了进一步的挑战。

通过强化学习提升模型 Reasoning 能力:DeepSeek R1 通过将强化学习后训的过程与大规模预训练结合,显著提升了模型性能,在自动化推理、复杂决策和知识推断等任务上,比传统的 LLM 提高了多个维度的能力,Reasoning 能力也成为了今年重磅模型在发布时的时尚单品。由于模型在推理时普遍需要更久的时间和更多的 token,Qwen、Claude、Gemini 等系列模型也逐步整合了“混合推理”的能力:如同人类大脑有快速反应和深度思考两种模式,用户也可以基于需求场景,让模型在不同模式下给出反应。

多模态模型走向主流:当前市面上的多模态模型支持的能力以语言、图像和语音的交互为主,也有一些垂类的视觉模型和语音模型在今年发布。而在开发生态中,我们也发现了围绕着语音模态的丰富工具链,如 Pipecat、LiveKit Agents 和 CosyVoice。在 2024 年年初,OpenAI 发布的 Sora 演示视频惊艳世界,有关世界模型和通用人工智能似乎已经不再停留于畅想,而站在 2025 这个时间节点,无论是视频模态的成熟还是 AGI 的成功,都仍旧有一段路要走。

基于主观和客观的不同模型评价模式:对模型的评价和排名,整体可以分为以下模式:

基于人类主观投票的评测,代表平台:Design Arena,LMArena;

基于客观标准答案的评测,下表梳理了最近两个月新模型发布时主要提及的性能对比评测集,可以作为当下最顶尖也最前沿的评测集的代表:

3.基于各家模型调用数据的评测也正在兴起:以 OpenRouter 为代表的大模型聚合 API 调用的网关平台,天然能够拿到各家模型的调用数据,利用这一得天独厚的优势,也顺便做起了模型评价的副业。基于各家模型每周被调用的情况统计得到的大模型排行榜,何尝不是一种用户“用脚投票”之后的结果呢。除 OpenRouter 外,还有一个上榜全景图的开源 API 网关项目:LiteLLM。这是一个 2023 年兴起的开源项目,同样支持上百种大模型的 API 调用,OpenRank 活跃度近半年仍在不断攀升,最近一个月高达 251。在高用户量和高活跃度的基础上,LiteLLM 支持模型调用的评测也许也只是时间的问题。

致谢

本篇报告从蚂蚁作为一家科技企业的视角出发,深度使用到了 X-lab 实验室的 OpenRank 评价指标,期间也咨询了很多来自蚂蚁内部的技术专家和开源社区的开发者们,非常感谢大家的宝贵观点。

此外,我们特别感谢全景图及本文创作过程中参与共创的社区伙伴们,包括:CSDN、InfoQ、机器之心、量子位、开源社等,以及赵生宇、陈阳、姜宁、唐小引、褚杏娟、周笑寒、周微、金磊等行业资深专家的输入。相关工作我们已经开放在 GitHub 上,欢迎大家共同协作,一起贡献高质量的生态洞察。

接下来一段时间里,我们会陆续放送围绕着上述热门的技术领域和代表性的开源项目们的专题洞察,敬请期待!