12 月 14-18 日,计算机图形学顶会 Siggraph Asia 2025 在香港召开。火山引擎多媒体实验室有多项工作入选,包括了拓扑变换的自适应建模、动态人体重建、人体重打光的三项成果进行汇报和展出。

TAOGS:突破传统模板依赖的限制进行自由建模!拥有拓扑变换的自适应能力

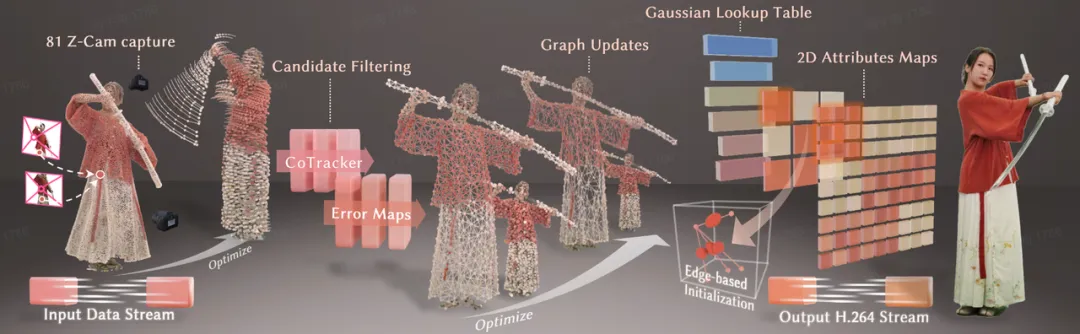

多媒体实验室研究人员与来自德国马克思普朗克研究所、上海科技大学的团队进行深入合作,提出了应对体积视频中拓扑变换的自适应解决方案 TAOGS,针对视频制作过程中频繁出现的拓扑变化问题进行了长时序跟踪与自适应建模,在极具调整性的场景下也能进行高保真的渲染。

为了解决这个问题,研究人员提出了一种双层的动态高斯表示方法,利用运动高斯去自适应地处理新观测的出现与过时观测的消失,以及利用外观高斯来进行复杂纹理的表征。其核心思想是利用稀疏的拓扑感知高斯来表示底层场景运动,并在时空跟踪器与光度线索的引导下捕捉新出现的观测,融合这些观测,并持续更新局部形变图。在其生命周期内,每个运动高斯可以派生并激活多个高斯,以建模细粒度的视觉细节。该方法在保持训练高效与压缩友好的同时,支持稳健的跟踪与拓扑自适应。

该方案生成的拓扑感知的高斯表示,可以自然适配基于标准视频编解码的体积视频格式,支持在移动端进行快速的传输和推理,进行自由视点的高清渲染,呈现与真实世界相融合的沉浸式体验。

EvolvingGS:告别基于关键帧的 GoP 切分,能够应对任意复杂动作的可进化 4D 高斯表征

动态 3D 重建技术正面临一个核心矛盾:序列越长、动作越复杂,重建质量越难保持。现有方法要么因误差累积而失真,要么因关键帧切换而产生画面闪烁。

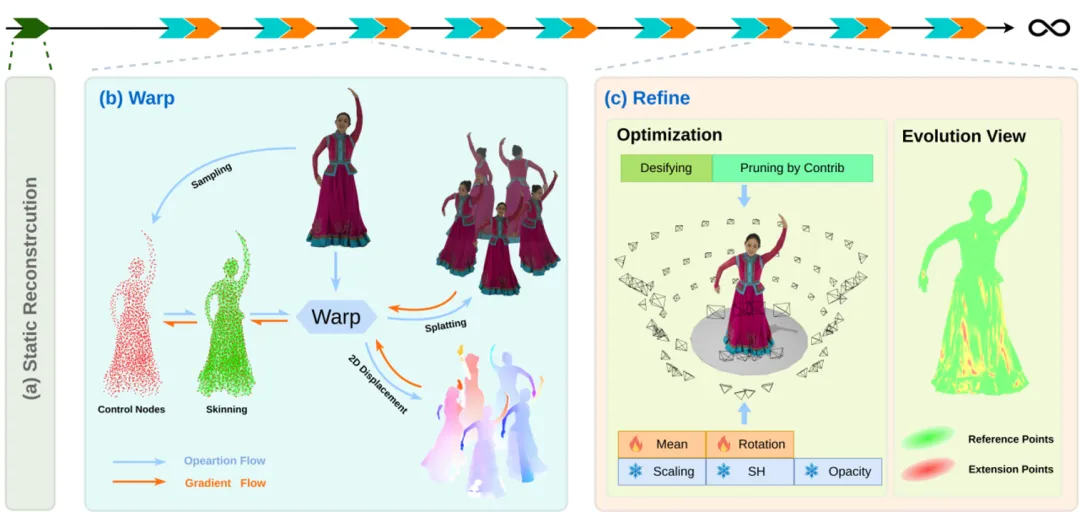

火山引擎多媒体实验室最新提出的 《EvolvingGS: Stable Volumetric Video via High-Fidelity Evolving 3D Guassian Reconstruction》,通过一种“先对齐,后生长修复”的两阶段协同范式,首次实现了在单个连续时间段内,对任意时长与复杂运动的鲁棒 4D 高斯重建,无需关键帧切换,彻底避免闪烁。

方法核心:让模型学会“动态生长”

形变场粗对齐

引入光流一致性损失指导形变场学习,确保高斯模型的运动趋势与实际场景严格一致,即使应对快速运动也保持稳定。

修复阶段

在形变对齐的基础上,允许模型在拟合不足的区域智能增减少量高斯点:

保留的“参考高斯点”维持外观不变,保障时序连贯性;

新增的“拓展高斯点”自由优化,赋予模型强大的细节拟合能力;

提出基于贡献度的删点策略,解耦删点策略对不透明度下降的依赖,防止模型无限膨胀。

这一设计使模型能自适应物体的出现/消失、服装剧烈飘动、拓扑结构变化等极端情况。

w/o v.s. w/ 修复阶段 (应对拓扑变化)

w/o v.s. w/ 修复阶段 (应对局部细节拟合)

EvolvingGS 不只是一个技术方案,更是一种建模理念的进化:我们让模型具备结构性对齐能力(形变阶段)与局部生长能力(修复阶段),使其像生命系统一样,在保持整体一致的前提下,灵活适应局部变化。这意味着,无论是复杂舞蹈、服装飘动、还是场景中物体的突然出现或消失,EvolvingGS 都能应对自如,为动态 3D 重建打开了“无限时长”的大门。

Disentangled3DGS:画质与几何质量的双重飞跃,基于解耦 3D 高斯表征的可打光体积视频

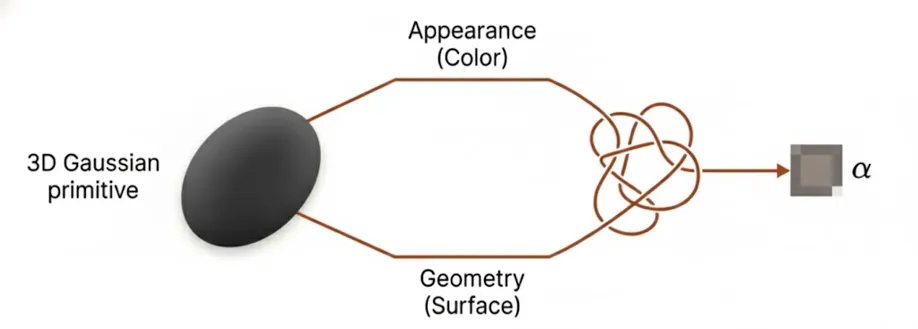

在 3D 高斯场建模中,几何与外观的深度纠缠,长久以来是一个被默认却充满代价的设定。当颜色与形状被迫共享同一套不透明度分布时,其结果往往是渲染质量与几何精度互相妥协,真实感重光照更是难以企及。

传统方法内生地将模型的外观和几何紧密捆绑

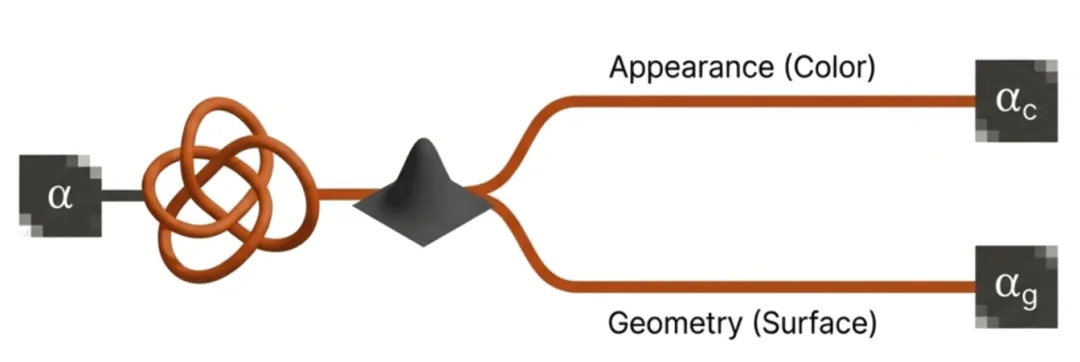

解耦外观和几何

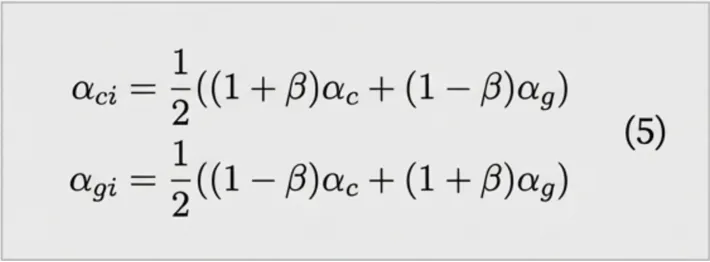

引入耦合系数

火山引擎多媒体实验室的最新研究 《Disentangled Gaussian Splatting:High-Fidelity Relightable Volumetric Video through Geometry-Appearance Decoupling》 ,提出一种几何-外观解耦式高斯表征。它如同为 3D 重建赋予了“双重身份”:让几何结构精准独立,让外观细节自由表达,最终在渲染质量与几何精度上同时实现显著提升,为高保真、可重光照的容积视频开辟了新路径。

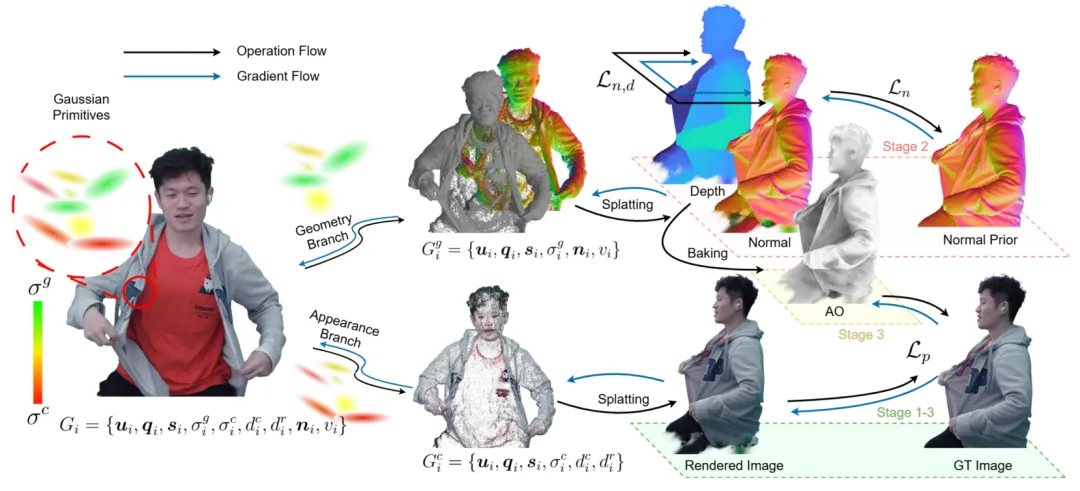

核心思路:为每个高斯点赋予“双重松耦合的不透明度”

传统 3DGS 将颜色与几何属性捆绑优化,如同用同一把刻刀同时雕刻形状与上色。我们的方法进行了根本性革新:

双分支独立渲染:我们为每个高斯基元同时引入几何不透明度场与外观不透明度场。在渲染时,两者通过可学习的解耦因子β进行加权融合,实现像素级的精准对齐与独立控制;

协同优化与独立规制:几何分支专注于法向量、深度与可见性的重建;外观分支则负责建模视点相关的色彩与光照。两个分支通过 β 因子动态协作,既能互相促进优化,又允许我们对各自施加针对性的约束(如法向平滑、深度一致),最小化相互干扰;

智能生长策略:基于两个分支的梯度信息独立判断局部区域的欠拟合情况。当一处需要“生长”更多高斯点来细化几何时,另一分支会以最小化干扰的方式协同初始化,确保模型紧凑高效;

可以轻松与 EvolvingGS 结合,将其优点拓展到 4D 重建领域

全息通信方案

12 月 18-19 日,在火山引擎 FORCE 原动力大会上,多媒体实验室也展示了全息通信的商业化技术。该项技术由实验室研发的实时 4D GS 重建及压缩技术驱动,能够在消费级带宽(<10mbps)下高清高保真实现全息通信,支持远程面对面互动。与行业内全息通信(e.g.,Google Starline/Beam)方案相比,该技术不仅支持普通摄像头实时生成 6DoF 视频,更将设备成本与带宽需求降低了一个数量级,降低了全息通信的门槛,将促进该技术的规模化应用。

该项技术通过创新性地采用前馈神经网络架构,仅使用少量相机采集画面,极大的降低了采集成本,同时在保证画质的前提下将计算量降低 70%,在 A10 显卡上以超过 30 FPS 的帧率实现实时的 3D 高斯泼溅重建。在传输层面,实验室展示了全链路能力:通过基于渲染重要性的低损耗压缩策略,LiveGS 将 3D 高斯数据的传输带宽从行业普遍的 60Mbps 压缩至 10Mbps 以下,并保持画质损失(PSNR)小于 3dB——这意味着全息通信可以无缝复用现有的视频传输链路。在渲染层面,结合混合渲染技术,在 iPhone 15 等设备上实现了 30FPS 流畅的视角旋转、缩放等交互操作,同时支持在 PC、VR 等多终端实现流畅分发。

随着硬件成本实现量级下降,火山引擎计划在 2026 年全面推进全息直播场景的落地。全方位重塑社交、互动直播及办公协同体验。在全息通信的赋能下,多个行业正迎来体验革命:远程医疗可实现更真实的微表情反馈,金融与奢侈品服务能通过线下面谈般的临场感建立信任,而企业协作中的全息沙盘则让异地专家实时标注三维模型成为现实。火山引擎通过区域化高斯裁剪与高效编码技术,解决了移动端算力瓶颈与传输难题,使空间视频在手机、PC、VR 等多终端实现流畅分发。随着空间视频落地节点的到来,全息通信将不再是科幻场景,而是提升用户留存与互动深度的商业利器。

总结

火山引擎多媒体实验室将“拓扑自适应+动态演进+解耦表征”的创新思路应用于动态 3D 重建与 6DoF 视频任务中,在处理复杂拓扑变换、长序列稳定性以及高保真可重光照渲染等核心挑战上取得了突破性表现。

通过 TAOGS 的拓扑感知高斯优化、EvolvingGS 的“先对齐后生长”演进范式以及 Disentangled3DGS 的几何-外观解耦架构,该系列研究有效解决了传统动态重建中对模板依赖高、长时序闪烁及几何外观纠缠等痛点,显著提升了复杂动态场景下的渲染精度与建模鲁棒性。

更重要的是,这些前沿技术促进了全息通信的商业化方案形成,通过创新的实时 4D GS 重建与超低带宽压缩技术,在消费级带宽(<10Mbps)和移动端设备上实现了高清、流畅的 6DoF 沉浸式交互,将全息通信的设备成本与传输门槛降低了一个数量级。从学术顶会的算法突破到 2026 年全息直播的规模化落地蓝图,火山引擎正在通过技术迭代重塑社交、办公与远程协作的视听体验,为下一代空间计算与全息媒体产业的发展奠定了坚实的技术基石。

团队介绍

多媒体实验室是字节跳动旗下的研究团队,致力于探索多媒体领域的前沿技术,参与国际标准化工作,其众多创新算法及软硬件解决方案已经广泛应用在抖音、西瓜视频等产品的多媒体业务,并向火山引擎的企业级客户提供技术服务。实验室成立以来,多篇论文入选国际顶会和旗舰期刊,并获得数项国际级技术赛事冠军、行业创新奖及最佳论文奖。