Meta发布Llama 1至今已经 7 个月左右,而Llama 2以及Code Llama的发布也有了数月的时间。当地时间 9 月 27 日,Meta 发布博文系统介绍了当前 Llama 生态的情况。官方统计,通过 Hugging Face 的 Llama 模型下载量超过 3000 万次,其中仅在过去 30 天就超过了 1000 万次。

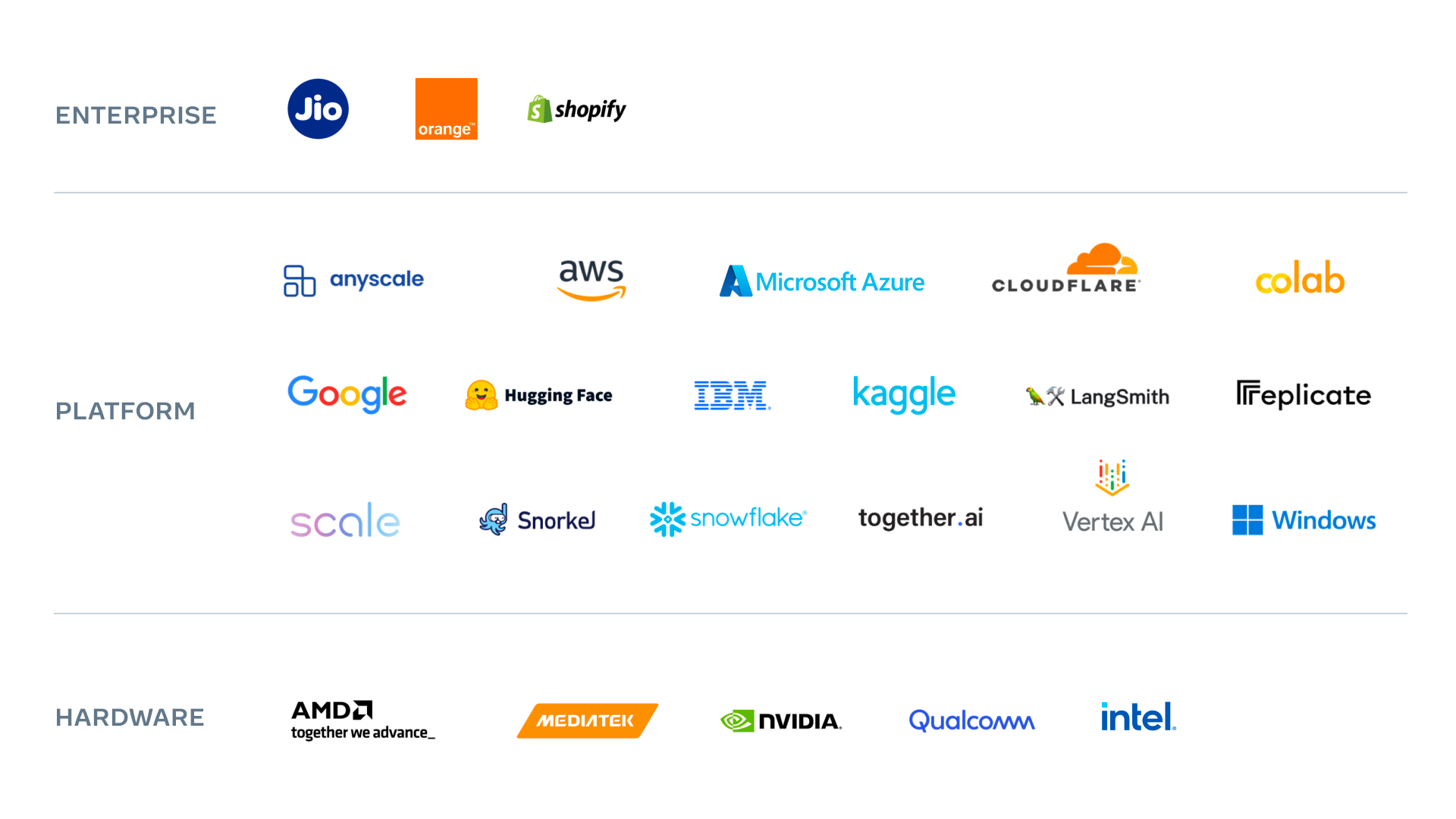

当前的 Llama 生态情况如下:

云厂商:AWS、Google Cloud 和 Microsoft Azure 等主要平台已在其平台上采用了 Llama 模型,并且 Llama 2 在云中的使用正在扩大。Google Cloud 和 AWS 总共有超过 3,500 个企业项目基于 Llama 2 模型启动。此外,Meta 还宣布 AWS 成为 Llama 2 的首个托管 API 合作伙伴,各种规模的组织都可以访问 Amazon Bedrock 上的 Llama 2 模型,而无需管理底层基础设施。

创新企业:包括 Anyscale、Replicate、Snowflake、LangSmith、Scale AI 等在内,已有上万家初创公司正在使用或评估 Llama 2。“像 DoorDash 这样的创新者正在使用它进行大规模试验,然后再发布由 LLM 支持的新功能。”

众包优化:截至目前,社区已在 Hugging Face 上微调并发布了 7000 多个衍生品。平均而言,在标准基准测试中,它们将常见基准测试的性能提高了近 10%,对于 TruthQA 等基准数据集的性能提升高达 46%。

开发者社区:GitHub 上现在有超过 7,000 个基于 Llama 构建或提及 Llama 的项目。为方便将 Llama 引入边缘设备和移动平台,新的工具、部署库、模型评估方法,甚至 Llama 的“微型”版本都在开发中。此外,社区还扩展了 Llama 以支持更大的上下文、增加了对其他语言的支持等。

硬件支持:各大硬件平台 AMD、Intel、Nvidia、Google 均通过软硬件优化提升了 Llama 2 的性能。

对于 Llama 生态的未来,Meta 表示,仍致力于为当今的人工智能提供开放的方法,主要会在多模态、安全责任和社区上投入更多关注。

参考链接: