如果把过去十年的 AI 落地情况简单概括为一句话,那大概是:AI 学会了“看”和“判断”,却还没真正学会“动手”。

在这段演进过程中,算法被装进摄像头、产线和各类终端设备,AI 在真实世界中承担起感知与决策的角色,成功完成了从实验室到产业化的跨越。

但在范浩强看来,这条路径始终存在一个边界——智能还停留在系统里,很少真正介入物理世界本身。

从某种程度上来说,范浩强的职业路径,正是沿着这条 AI 落地的主线一路走来的。

2025 年初,范浩强做出了一个在外界看来有点“不走寻常路”的选择:

作为旷视科技的第一位算法研究员,在 AI 1.0 时代经历了计算机视觉与 AIoT(AI 技术 + 物联网设备)的规模化落地之后,范浩强选择转身进入具身智能,一个技术门槛更高、研发周期更长的赛道。

他参与创办的这家公司,名为 Dexmal 原力灵机(下文简称原力灵机)。与他并肩创业的汪天才、周而进,同样来自于“AI 四小龙”之一的旷视。

围绕这次转身,AI 前线与范浩强展开了一次深度访谈,聊到了他的创业选择、具身智能的技术演进以及产业趋势等话题。谈及为何要去做机器人,范浩强表示:

“在 AI 的道路上,机器人是一个绕不过去的点。”

至于为何选择在 2025 年初这个时间点入局具身智能,范浩强的给出了一个冷静而务实的理由:

“之前没做,是因为我觉得还不成熟;现在这个时间点,硬件和算法的拼图终于开始拼起来了。”

“硬件和算法的拼图终于拼起来了”

在 2024 年,具身智能可谓是“火出圈”的——随着大模型能力外溢、真机效果显著提升,以及头部厂商集体入场,这一方向首次从学术讨论走向产业共识,成为 AI 领域最受关注的新热点之一。

到了 2025 年,更多变化已明显发生,首先是硬件侧。

在过去两年里,机器人关键零部件——尤其是关节的国产化率出现了明显提升。

相比早期高度依赖进口方案,如今国内供应链在性能、稳定性和交付节奏上都逐步可用,这使得机器人在成本控制、系统集成和快速迭代上的不确定性大幅下降。

范浩强提到,这种变化并不意味着硬件问题已经被彻底解决,但至少从“不可控”,走向了“可工程化”:

“当供应链能跟得上研发节奏时,很多事情才有可能往前推进。”

与硬件变化几乎同步发生的,是算法侧出现的拐点。

Diffusion、Transformer 等模型开始进入机器人动作生成与控制领域,机器人不再只依赖规则或手工调参,而是可以通过数据学习复杂行为。在范浩强看来,这意味着具身智能不再只是“能演示”,而是开始具备系统性提升能力的基础。

也正是在这样的背景下,他判断:硬件和算法这两块长期错位的拼图,终于开始对齐了。

再往前看,范浩强对下一阶段算法能力的期待,并不止于“动作更像人”。他认为,更关键的是机器人能否真正理解人的意图,并在交互过程中持续修正自身行为。

比如通过对话澄清不明确的指令,或在操作被打断、纠正后继续完成任务。这些能力,将决定具身智能能否从“可用”,走向“好用”。

具身智能研发,算法先行还是硬件先行?

近两年,机器人从动作到形态的进步都“肉眼可见”:能跑能跳已经不稀奇了,有的还能丝滑跳舞、打太极;而且过去只能在科幻片里看见的人形机器人也越来越多,甚至已经有不少进入了量产阶段。

伴随着这些变化,围绕机器人形态、硬件、整机能力的讨论也逐渐升温。

硬件之外,算法对于机器人的能力泛化和长期演进也很关键。那么算法与硬件在具身智能领域如何协同推进,在各家公司的具身智能早期研发中,是算法先行还是硬件先行?

对此,范浩强直言道:

“在我们看来,其实都是算法先行。”

他认为,即便是在外界看来以硬件能力见长的公司,其关键突破往往仍然来自算法层面。不同之处在于,这些算法未必是通用意义上的大模型,而可能是更偏底层的能力,例如运动控制(locomotion)相关算法。

他指出,当运动控制等核心算法成熟到一定阶段后,原本难以实现的动作能力会自然被解锁,硬件形态也随之发生变化。从这个意义上看,硬件能力的提升更像是算法突破之后的结果,而非起点。

基于这一判断,原力灵机内部在反复强调一条方法论:“模型解锁场景,场景定义硬件。”

模型能力决定了哪些任务和场景可以被真正解决,而具体场景的需求,才反过来塑造硬件的结构、配置与形态。

同时,范浩强也强调,硬件研发本身有其客观周期,无法被简单压缩;真正需要持续保持高节奏竞争的,是算法能力的演进速度。

在他看来,具身智能是一场长期竞争,不同环节在不同阶段承担的角色并不相同,但算法能力的迭代效率,始终是决定整体进展速度的重要因素之一。

原力灵机的路线:多模态、真机数据,先把规矩立住

那么,要如何保证算法能力的高节奏演进速度?

原力灵机作出的选择,是一条更贴近落地需求、也更耐磨的路线。

首先,他们是从一开始就做多模态。

在范浩强看来,传统的 VLA(Vision–Language–Action)框架,如果过度依赖视觉信息,在真实场景里很快就会撞上天花板。比如机器人真正“干活”时,面对的不是干净的画面,而是接触、摩擦、受力和空间约束,这些信息单靠“看”是远远不够的。

因此,原力灵机并没有把 Vision 当作默认前提,而是从模型训练阶段就引入 Multimodality:除了视觉,还包括深度信息、力觉、触觉,必要时甚至加入声音信号。

这样做并不是为了把系统搞复杂,而是出于一个非常现实的判断——如果机器人要稳定、安全地完成任务,这些感知维度缺一不可。

第二点,是在数据上选择“慢一点,但更真”。

在数据策略上,原力灵机把重点放在真机遥操数据上,并且明确坚持“质量优先”。范浩强多次提到,机器人做的往往是“细活”:一个抓取动作是否成功,差别可能只在几毫米、几牛顿的力控误差。

这也意味着,数据采集本身就不能是“顺手一录”,而必须被当作一项工程来设计——包括传感器的同步方式、遥操流程的规范程度,以及操作行为本身的可复现性。

只有在这样的基础上,算法训练出来的能力,才有可能在真实场景中稳定复现。

此外还有一个重点,就是得赶紧先把“怎么比”这件事说清楚。

在范浩强看来,具身智能仍处在早期阶段,行业里一个明显的缺口是:缺少统一、可信的评测体系。如果没有清晰的 Benchmark,不同方案之间很难进行有效比较,也很难形成真正的技术共识。

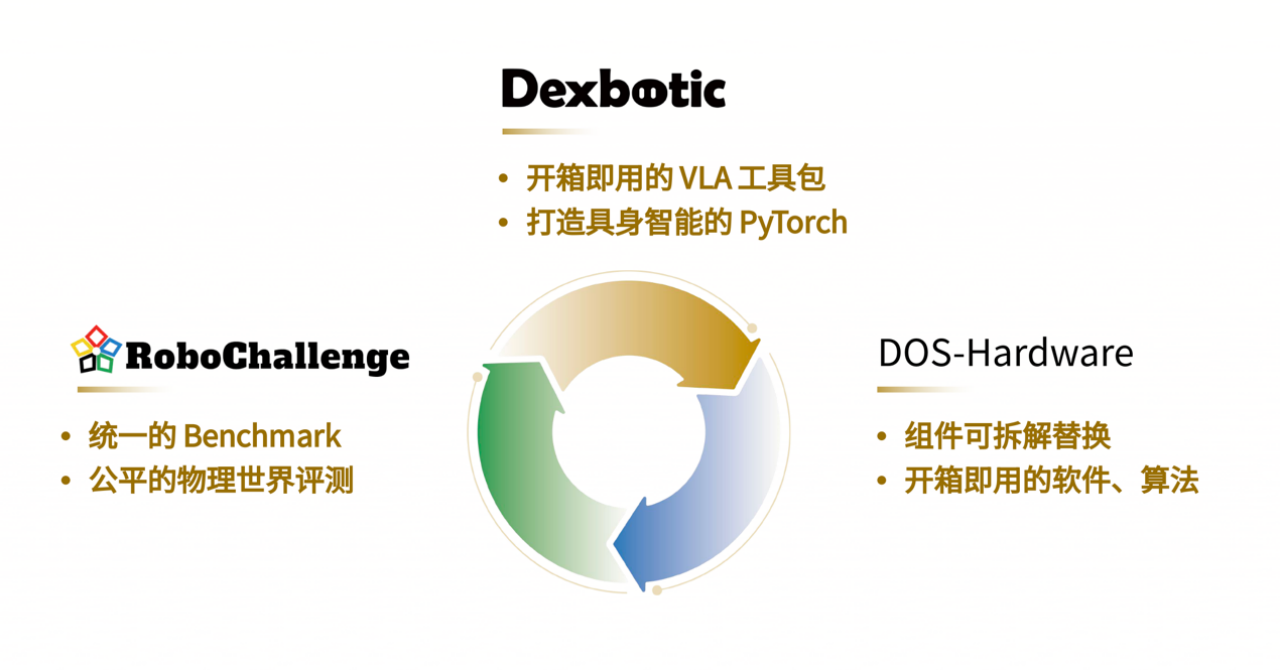

因此,原力灵机选择在早期就投入精力,联合 Hugging Face 共同推出真机评测平台 RoboChallenge 以及相关开源工具的建设,比如一站式 VLA 工具箱 Dexbotic 和公司首个开源硬件产品 DOS-W1。

用范浩强的话说,就是先把规矩立住,再谈模型强不强:

“我们希望先把比较的方法拿出来,让大家在同一套标准下形成共识。之后再在这些已被认可的方法上,去验证和证明我们模型的表现,这样也更利于外界准确理解我们的能力。”

从多模态感知,到真机数据,再到评测体系,每一步都指向同一个目标:让算法能力能够被验证、被复现、被长期积累。