谷歌为 LiteRT 引入了一个名为Qualcomm AI Engine Direct(QNN)的全新加速器,旨在增强搭载骁龙 8 系列 SoC 的高通安卓设备的设备端 AI 性能。这个加速器带来了显著的性能提升,与 CPU 执行相比速度提升了高达 100 倍,与 GPU 相比也提升了 10 倍。

尽管现代安卓设备普遍配备了 GPU 硬件,但谷歌软件工程师 Lu Wang、Wiyi Wanf 和 Andrew Wang 表示,完全依赖它们来执行 AI 任务可能会产生性能瓶颈。例如,他们指出,“在设备上运行一个计算密集型的文本到图像生成模型,并同时处理实时摄像头输入的基于 ML 的分割”,即使高端移动 GPU 也可能不堪重负。这可能导致用户体验卡顿和画面丢帧。

不过,许多移动设备现在包括了神经处理单元(NPU),与 GPU 相比,这些定制设计的 AI 加速器可以显著加速 AI 工作负载,并降低功耗。

QNN 是谷歌与高通紧密合作开发的,旨在替代之前的 TFLite QNN delegate。它广泛集成了各种 SoC 编译器和运行时,并通过简化的 API 暴露它们,为开发人员提供了一个简化的统一工作流。它支持90个LiteRT操作,目标是实现全模型委托,这是实现最佳性能的关键因素。QNN 还包括专门的内核和优化,进一步增强了 Gemma 和 FastLVM 等 LLM 的性能。

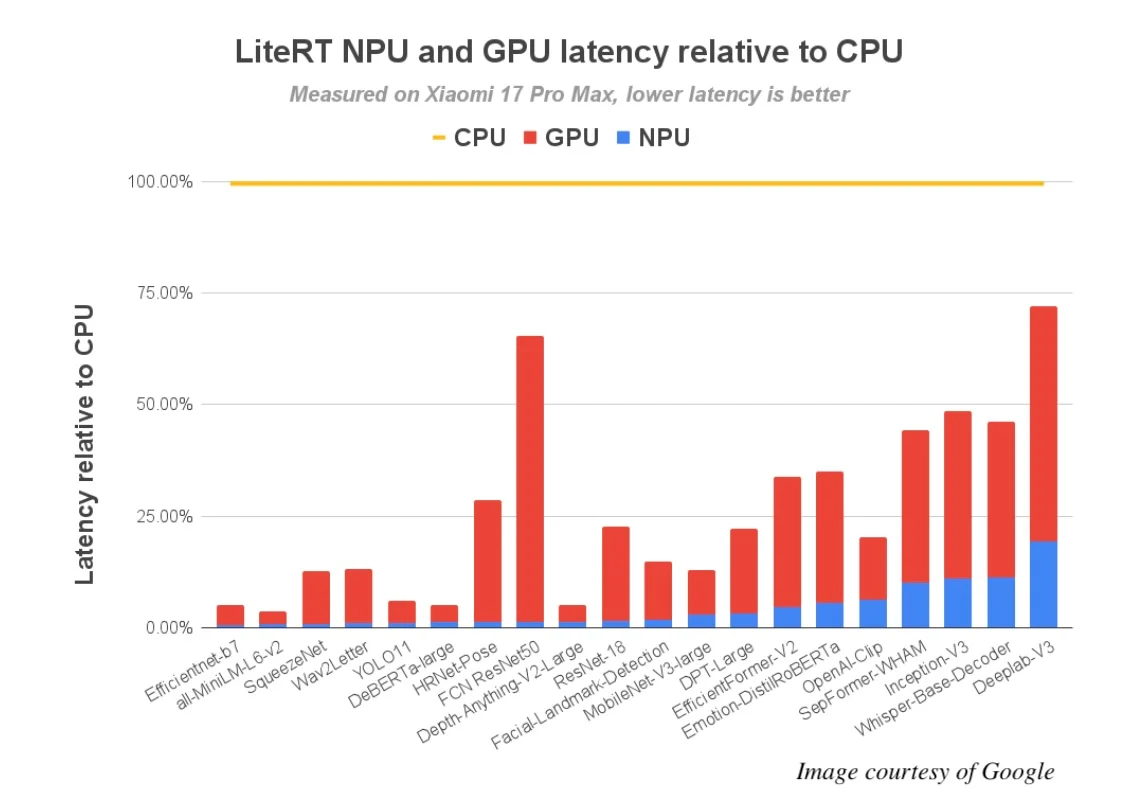

谷歌在 72 个 ML 模型上对 QNN 进行了基准测试,其中 64 个成功实现了全 NPU 委托。结果显示,其性能与 CPU 执行相比提升了高达 100 倍,与 GPU 相比提升了 10 倍。

在高通最新的旗舰 SoC 骁龙 8 Elite Gen 5 上,性能提升显著:在 NPU 上有超过 56 个模型运行时间少于 5ms,而在 CPU 上只有 13 个模型能做到这一点。这解锁了一系列之前无法实现的实时 AI 体验。

谷歌工程师还开发了一个概念应用,使用了苹果 FastVLM-0.5B 视觉编码模型的优化版本。该应用几乎可以即时解释摄像头的实时场景。在骁龙 8 Elite Gen 5 NPU 上,该模型在 1024×1024 图像上实现了令人印象深刻的首次令牌时间(TTFT)(仅为 0.12 秒),预填充速度超过 11,000 个令牌/秒,解码速度超过 100 个令牌/秒。苹果的模型通过 int8 权重量化和 int16 激活量化进行了优化。根据谷歌工程师的说法,这是解锁 NPU 最强大的高速 int16 内核的关键。

QNN 目前仅支持有限的安卓硬件子集,主要是搭载骁龙 8 和骁龙 8+ SoC 的设备。感兴趣的话,可查阅NPU加速指南并从GitHub下载LiteRT。

原文链接:

https://www.infoq.com/news/2025/11/litert-snapdragon-accelerator/