从 OpenAI 于 3 月 27 日宣布全面支持 MCP 协议开始,市面上的 MCP Server 数量,在不到一个月的时间里,逼近了 10,000 大关。接下来,Google 在 4 月 10 日为 Gemini 系列模型添加了对 MCP 协议的支持,称其为“AI Agent 时代的开放标准”,同时推出 A2A 协议(Agent-to-Agent Protocol)与 MCP 形成互补,聚焦智能体间协作。

至此,从模型到 Agents,Agents 之间的多点协作,在通信协议层面,已经完全就绪,AI 推理业务至此完成了在 2025 年的“二级加速”,可以预见的是,其云用量即将迎来迅猛上涨。

但对于 AI Infra 来说,仍面对很大挑战。从技术产品上,整个 AI Infra 属于迭代更新的初期,还有大量面对推理的调优亟待完成,比如模型下载的策略优化等。

本质上,预训练业务与推理业务,对 AI Infra 的需求,有着非常大的不同。预训练对单卡性能和显存带宽要求极高,需适配大规模专家并行系统。但推理业务更看重推理数据传输效率、全链条的低延迟,以及稳定性、可观测等方面。

基于以上行业变化,云厂商纷纷处于“技术解题”阶段,最新交卷的火山引擎 AI 云原生,给出了一份让客户推理更强、更省的解决方案。

我们该如何理解 ServingKit 推理套件

4 月 17 日,在杭州火山引擎 Force Link 大会上,火山引擎推出 AI 云原生推理套件 ServingKit,目标是为企业提供从模型部署、推理优化到运维观测的一站式解决方案。套件内涉及多项服务,包括镜像服务、算子加速器、AI 网关等等。

应该说,2025 年,各家云厂商的一个主要任务,就是对 AI 推理业务的基础设施进行升级。

但以全链路服务套件的形式推出,目前来看,仅有火山引擎一家。

火山引擎云基础产品负责人罗浩对 InfoQ 分享了背后的思考:

在服务客户的过程中,火山引擎发现,有一类客户,原本就是做企业服务的,他们可能在开发 AI 中间件,甚至正在推动 AI 平台类产品的诞生。这类客户可能会有模型开发和定制服务。

还有一类客户是大体量的 C 端互联网公司,他们往往具有很强的科研驱动力。

第三类客户像金融行业、汽车行业,可能会组建 AI 相关业务部门,专注 AI 带来的业务效率提升与品牌增值效果。

因此不同客户群体对 AI 技术的底层需求完全不同,可能会用三种不同的工具来实现 AI 的能力。且不想将自己的能力完全绑定在某个技术提供方身上,这是可以理解的。所以今天的 AI Infra 升级,不仅需要为客户提供资源层面的能力,还需要提供解决方案层面的能力和服务。

从技术上要看懂 ServingKit,也不麻烦。简单来说,就是推理业务的主要流程,在各个核心节点做优化。

总体来说,在推理服务启动前,需完成模型仓库调度与异构资源适配:即从 Hugging Face 拉取模型文件及依赖库,通过分级缓存策略(如火山引擎 ServingKit 的 Onion 镜像权重加速引擎)加速分发。

模型加载与预热完成后,来自公网或私网的推理请求流量,通过智能网关进行分发与治理。

与此同时也要注意资源的运维和调度,包括将 Prefill 预填充与 Decoder 生成阶段解耦,按负载独立扩缩容器实例。通过统一的 KV Cache 管理将高频访问的 Cache 常驻 GPU 显存低频模型动态卸载至主机内存、SSD 或远程存储等。

在 ServingKit 中,镜像服务提供对推理引擎镜像的加载提速,同时用 VKE、APIG、GPU 算子加速器、KV Cache 来分别解决模型加载预热、流量调度、推理执行流水线等环节的工作。

最终实现两项核心成绩:

部署提速:拉取 DeepSeek-R1 满血版(671B 参数)模型仅需 109 秒,40 秒完成集群内模型缓存预热,13 秒加载至多节点 GPU 显存。

推理优化:TPS 提升 2.4 倍,首字节响应时间(TTFT)降低 60%,长文本推理 KV Cache 命中率提升十倍。

这里提到的 DeepSeek-R1 满血版模型部署时间,几乎是业界第一次给出秒级的时间承诺。罗浩对 InfoQ 表示,参数规模为 671B 的模型约 700G 大小,将它从核心配置上下载之后再分发到每个推理节点上,如果不做任何加速,可能需要几个小时的时间。

按此推算,在以往不做加速的情况下,做模型部署,需要的时间基本是按天计算的,很难评价这对企业效率造成了多大的影响。

火山引擎将对模型部署阶段的加速能力,对外抽象成了 Onion 工具集。Onion 的内核在于实现了多线程资源下载的成熟方案。

此外,Onion 采用两级缓存架构,覆盖模型分发全链路:

中心缓存层:基于对象存储(如火山引擎 TOS)构建模型仓库,支持多种开源模型权重缓存和更新。

节点缓存层:利用 GDKV Server 在集群内实现模型权重分布式缓存。

另外一个重要的提速手段在于通过 GDR(GPU Direct RDMA)实现模型加载加速,允许 GPU 绕过 CPU 直接访问缓存的模型权重文件。

三者相加,最终使得 ServingKit 在大模型部署提速这件事儿上卓有成效。

而对整个推理阶段的加速,则涉及更多的技术环节,尤以 KV Cache 命中率和 GPU 算子加速器提升最为引人关注。原因也很直观:这几乎是每个云厂商都在攻坚的技术项目,但最终的技术实现效果却千差万别。

火山引擎优化 KV Cache 命中率的核心方式是提供统一的 KV Cache 管理方案,从而节省更多的推理 GPU 算力。传统的单机本地 Cache 往往仅能够支持较少时间段的 KV Cache, 随着本地缓存不断释放,整体缓存命中率较低,而火山引擎 EIC 提供的高性能分布式 KV Cache 服务,能通过内存和 SSD 资源构建大规模 KV Cache 资源池,实现 KV Cache 以存代算,提升推理吞吐并降低推理时延,实现更高的 KV Cache 命中率。

同时还会通过在流量调度过程中增加 Prefix Cache 感知调度和 Session 亲和调度,进一步提升 KV Cache 命中率。

在智能流量调度,以及 P/D 独立扩缩容的问题上,火山引擎同样保持着技术优势。

ServingKit 套件里包含了 APIG 和 VKE。APIG 支持根据支持推理引擎负载和 KV Cache 分布调度流量,降低 TTFT,提升 KV Cache 命中率,而 VKE 支持跨物理机、私有云、公有云的混合资源池管理,通过「节点池」机制实现异构 GPU/CPU 资源的统一编排,可以助力实现秒级的故障切换。

而另外一大优势,在于火山引擎云基础产品团队自身极强的研发能力。

例如,GPU 算子加速器,每一家厂商都在做,但很难做好。

一方面,不同 GPU 型号,不同架构,对应的 GPU 并行计算能力和显存带宽都有差异。另一方面,不同模型,其模型架构也有差异。算子优化时候需要充分 GPU 硬件特性和模型特性进行优化。火山引擎 ServingKit 的 GPU 算子加速器,适配了多种开源的推理引擎框架,并且针对 SGLang/vLLM 等框架,充分借鉴了 DeepSeek 开源算子,结合字节内部经验,自研了系列算子。例如 TP 并行下,优化 Fused MoE 算子,多 Token 预测特性;DP+EP 并行,优化 Group GEMM 算子等,提升单卡 TPS。

经过火山引擎优化后的单卡 R1 满血版 TPS 比原生 SGLang 提升了 2.4 倍。

当前行业变化极快,新模型层出不穷,量化参数各有差异,对算子的适配和优化几乎永无止境。所以这不光是个技术活,也与研发效能息息相关。需要相关的公有云团队,孜孜不倦地在算子优化这一工作上长期投入。

字节跳动为业界津津乐道的,也是其组织文化的高效特质。火山引擎云基础团队同样在快速变化的行业需求中敏捷迭代,总是能将“务实”和“浪漫”结合得很好。

因此火山引擎云基础业务总能在保证业务增长的同时,在技术战略上取得一定领先优势。去年发布 GDR 时如此,如今发布 ServingKit 时,在可观测领域,也是如此。

火山的速度,很难被复制

将这种领先放在可观测技术上,会体现得尤为明显。

相比于最时髦的、与业务表现直接相关的技术栈,可观测这种偏运维场景的、关乎研发效能的能力,总显得有些底气不足。

因此可观测技术的流行,几乎比热门技术迟滞 1-3 年以上。

比如国内微服务架构的规模化落地主要集中在 2015-2018 年,到 2018 年,Kubernetes 和 Istio 已经全面普及,生态蓬勃发展。

微服务也造成了一些问题,当一个服务被拆分成数个黑盒的、虚拟的微服务,故障排除彻底成为一种折磨。可观测问题的兴起,很大程度上就是要解决微服务架构的维护问题。

实际上,可观测技术在国内的兴起,差不多要等到 2021 年前后,中间已经过了三年。

ServingKit 中可观测套件的上架,打破了这一规律。AI 推理业务从去年至现在刚刚兴起,来自火山云基础的可观测技术组件就已经完成了升级——以 APM & VMP 为核心。APM & VMP 通过告警、Trace ID、Trace 分析、问题定位等核心功能,实现了全链路观测,同时对业务没有侵入性。

罗浩对 InfoQ 分享了其中的关键:我们的可观测能力,源于之前在云原生微服务架构中使用的方法——字节跳动在线微服务数量超过 10 万,我们致力做好可观测,因为希望业务团队可以将主要精力关注在业务逻辑、业务创新,而非基础架构及其运维。

不但是对内提供的核心能力,也是较早经过打磨可对外提供的服务之一,这种在面对业务的务实,让火山引擎云基础服务,变相取得了 To B 产品服务的领先。

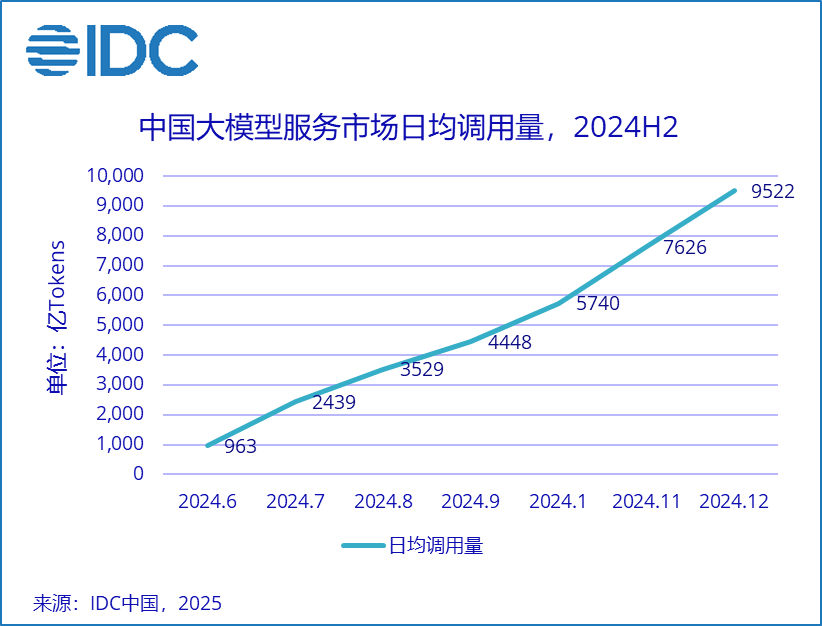

4 月 10 日,国际数据公司(IDC)发布的《中国公有云大模型服务市场格局分析,1Q2025》显示,2024 年中国公有云上大模型调用量达 114.2 万亿 tokens,火山引擎以 46.4%的市场份额位居中国市场第一。作为底层的技术支撑,火山引擎 AI 云原生云基础设施自有过人之处。

但比阶段性的成绩更重要的是,在国内,无论是 AI Infra 市场,还是 AI 应用市场,都已经步入中场阶段,头部玩家的优势正在被放大,火山引擎在此刻发布 ServingKit,等同于对服务 AI 推理业务的基础设施的一次“热升级”,提高了 AI infra 提供者的服务水平,降低了企业落地 AI 的使用门槛,进一步加速了 AI 应用在国内的发展。