整理 | 华卫

凌晨,OpenAI 发布了新一代 AI 科研利器 Prism,该平台由 GPT-5.2 加持,供科学家们撰写和协作研究,即日起向所有拥有 ChatGPT 个人账户的用户免费开放。用华人 AI 创业者 Yuchen Jin 的话说,“每篇论文都将把 ChatGPT 列为合著者。”

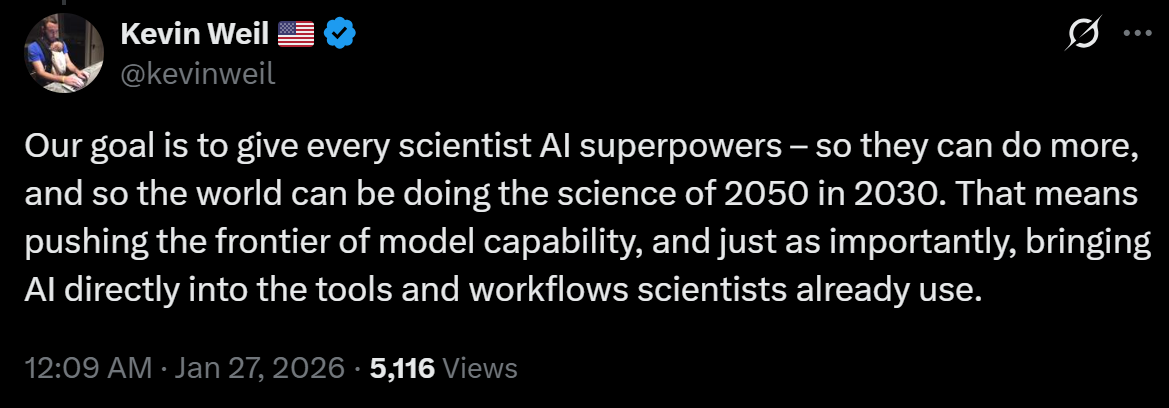

而在昨日,OpenAI 副总裁、新成立的 OpenAI for Science 团队负责人 Kevin Weil 就在 X 上发文预热道,“我们的目标是赋予每位科学家 AI 超能力,让他们能做更多事情,让世界在 2030 年就能开展 2050 年的科学研究。”

自 ChatGPT 爆红面世后的三年里,OpenAI 的技术颠覆了日常生活中方方面面的行为模式。如今 OpenAI 正明确发力科研领域,面向科研人员布局。10 月,该公司宣布成立全新的 OpenAI for Science 团队,核心致力于探索其大语言模型(LLM)助力科研人员的路径,并优化旗下工具为科研人员提供支持。过去数月,社交媒体上涌现出大量相关内容,学术期刊也刊发了诸多研究成果,数学家、物理学家、生物学家等领域研究者纷纷撰文,讲述大语言模型、尤其是 GPT-5 如何助力他们取得新发现或是为他们指引方向,让他们找到原本可能错失的解决方案。

那么,OpenAI 为何选择此时入局?此番布局,究竟想要达成怎样的目标?发力科研领域,与该公司更宏大的使命如何契合?在这一领域,OpenAI 已然姗姗来迟。谷歌 DeepMind 早在数年前便已成立 AI-for-science 团队,打造了 AlphaFold、AlphaEvolve 等具有开创性的科学模型。2023 年,谷歌 DeepMind 的 CEO 兼联合创始人 Demis Hassabis 曾就该团队的情况在采访中表示,“这是我创立 DeepMind 的初衷。事实上,这也是我整个职业生涯深耕 AI 领域的原因。”

近日,Kevin Weil 在一次访谈中不仅正面回应了这些问题,还对当前模型的实际能力给出了比先前更为保守的评价:目前模型还达不到取得颠覆性新发现的水平,但倘若能让人不必把时间浪费在已经解决的问题上,也是对科研的一种加速。有意思的是,据其透露,一位 OpenAI 主动接触且开通了 GPT-5 付费服务的科研人员反馈,GPT-5 会犯一些低级错误,比人犯的错误更加愚蠢,不过一直在进步。

此外,按照 OpenAI 在 AI 科研领域的布局,接下来其将对模型整体设计作两大思路优化:一是让 GPT-5 在给出答案时降低置信度,具有认知层面上的谦逊性;另一方向,是利用 GPT-5 反向对自身输出进行事实核查。

“2026 年对于科研领域的意义,将堪比 2025 年之于软件工程。”Weil 表示,“2025 年初,若有人借助 AI 完成大部分代码编写,还只是早期尝鲜者;而 12 个月后的现在,若还未用 AI 编写大部分代码,就可能已经落后。现在,科研领域正显现出与编程领域类似的早期发展势头。一年后,倘若一名科研人员还未深度运用 AI 开展研究,就将错失提升思考质量、加快研究进度的机会。”

模型能力早已超过 90%研究生,AGI 最大价值在于推动科学进步

数年前,Weil 加入 OpenAI 出任首席产品官,他曾担任 Twitter 和 Instagram 的产品负责人官。但他的职业起点是科研领域:在斯坦福大学攻读粒子物理博士学位期间,他完成了三分之二的学业,随后为追寻硅谷梦离开学术界。Weil 也乐于提及自己的这段学术背景,他说:“我曾以为自己余生都会做一名物理教授,现在度假时还会读数学相关的书籍。”

当被问及 OpenAI for Science 与公司现有的白领生产力工具、爆火的视频应用 Sora 如何契合时,Weil 脱口而出:“OpenAI 的使命是研发通用人工智能(AGI),并让这项技术为全人类带来福祉。”他表示,不妨想象这项技术未来能为科研领域带来的变革:全新的药物、材料、器械。

“试想一下,它能帮助我们探索现实的本质,攻克悬而未决的科学难题。或许 AGI 能为人类创造的最重大、最积极的价值,正是其推动科学进步的能力。”他补充道:“GPT-5 的出现,让我们看到了这种可能。”

在 Weil 看来,如今的大语言模型已足够优秀,能成为科研人员的得力协作伙伴。它们能提出各种想法,建议新的研究方向,并在新问题和几十年前发表在冷门期刊或外语期刊上的旧解决方案之间找到富有成效的联系。但在大约一年前,情况并非如此。自 2024 年 12 月发布首个推理模型(一种能够将问题分解成多个步骤并逐一解决的逻辑学习模型)以来,OpenAI 一直在不断拓展这项技术的边界。推理模型的问世,让大语言模型解决数学和逻辑问题的能力得到大幅提升。

“放在几年前,模型能在 SAT 考试中拿到 800 分,就足以让我们所有人惊叹不已。”Weil 称。而如今,大语言模型能在数学竞赛中夺冠,解出研究生阶段的物理难题。去年,OpenAI 和 谷歌 DeepMind 均宣布,其研发的大语言模型在国际数学奥林匹克竞赛中取得金牌级成绩,该赛事是全球难度最高的数学竞赛之一。Weil 表示,“这些模型的能力,早已不只是超过 90% 的研究生,而是真正达到了人类能力的极限。”

这一论断非常大胆,却也并非无懈可击。但毋庸置疑的是,搭载了推理模型的 GPT-5,在解决复杂问题方面较 GPT-4 有了质的飞跃。行业基准测试 GPQA 包含 400 多道选择题,专门考察生物、物理、化学领域的博士级专业知识,GPT-4 在该测试中的正确率仅为 39%,远低于人类专家约 70% 的基准线;而据 OpenAI 数据,2024 年 12 月推出的 GPT-5 最新版本 GPT-5.2,正确率达到了 92%。

读遍 30 年来的论文,模型也做不出颠覆性新发现

Weil 的这种兴奋之情显而易见,却或许有些过头了。去年 10 月,Weil 等 OpenAI 高管曾在 X 平台高调宣称,GPT-5 已为多个数学未解难题找到解决方案。但数学家们很快指出,GPT-5 实际只是从早期研究论文中挖掘出了已有的答案,其中至少还有一篇德文文献。这样的能力虽有价值,却绝非 OpenAI 宣称的那般突破性成就。事后,Weil 与其同事删除了相关帖子。

当时,这件事闹出了不小的风波。刚开始疯传的是:GPT-5 解决了 10 个此前未解决的埃尔德什问题(Erdős problems),并在另外 11 个问题上取得了进展,而之后被负责维护埃尔德什问题网站的数学家 Thomas Bloom 澄清为;GPT-5 只是找到了一些能解决这些问题的参考文献。DeepMind 首席执行官 Demis Hassabis 对此指出,该团队的沟通方式“过于草率”。前 Meta 首席 AI 科学家 Yann LeCun 则讽刺道, OpenAI“被自己的炒作所反噬”(hoisted by their own GPTards),“搬起自己的 GPT 石头砸了自己的脚”。

但就在前几天,又有消息称,GPT-5.2 Pro 破解了一道埃尔德什猜想,题目是埃尔德什问题库中的第 281 号。这次证明由数学家 Neel Somani 推动,且论证过程由菲尔茨奖得主陶哲轩证明没有问题,并评价其是“AI 解决开放性数学问题中“最明确的案例之一”。目前,GPT-5.2Pro 对该问题的证明结果已被埃尔德什问题网站收录。

据悉,GPT-5.2Pro 对这个问题提出了新的证明方法,虽然忽略了此前已有的相关证明,但陶哲轩指出 GPT-5.2Pro 的证明思路与之前的方法“相当不同”,只在概念上有些重叠。现在这道题有了两条论证思路,一是 GPT-5.2 Pro 采用的遍历理论框架,策略是“弗斯滕伯格对应原理”的变体;二是两个早在 1936 年和 1966 年就已经存在的定理组合:达文波特-埃尔多斯定理和罗杰斯定理,且解法更简单。

不过,如今的 Weil 也更加谨慎了。他表示,能找到那些已存在却被遗忘的答案,本身就已意义重大:“我们都站在巨人的肩膀上前行,倘若大语言模型能整合这些知识,让我们不必把时间浪费在已经解决的问题上,这本身就是对科研的一种加速。”他也淡化了大语言模型即将取得颠覆性新发现的说法:“我认为目前模型还达不到那个水平,未来或许能做到,我对此持乐观态度。”

但他强调这并非团队的核心使命:“我们的使命是加速科学发展,而加速科学发展的标准,并非一定要像爱因斯坦那样对整个领域进行彻底的重新构想。”在 Weil 看来,核心问题只有一个:科学发展速度是否真的更快了?“当科研人员与模型协作时,能比独自研究完成更多工作、效率也更高。我认为我们已经看到了这一点。”

去年 11 月,OpenAI 发布了一系列由公司内外科研人员提供的案例研究,以真实案例展现了 GPT-5 的实际应用及助力科研的过程。Weil 表示,“这些案例的研究者,大多早已在研究中直接使用 GPT-5,他们通过各种方式找到我们,告诉我们‘看看这些工具能让我做到什么’。”GPT-5 擅长的关键事情是:找到科研人员尚未意识到的现有研究成果及关联线索,这有时能催生新的思路;协助科研人员草拟数学证明过程;为科研人员在实验室验证假说提供实验思路。

“GPT 5.2 几乎阅读了过去 30 年发表的每一篇论文。它不仅理解科学家所处领域的内容,还能从其他不相关的领域中提炼出可类比的思路。”Weil 称,“这太强大了。你总能在相关领域找到人类合作者,但要在所有可能相关的上千个相关领域找到上千个合作者,那就难上加难了。除此之外,我还能在深夜与模型一起工作,它从不需要休息,也能同时向它提出十个问题,这些事若是对人做,难免会显得尴尬。”

GPT-5 犯错比人更愚蠢,机器人更愿意听它的指挥?

据悉,OpenAI 为佐证 Weil 的观点,接触了多位科研人员,其中绝大多数都对此表示认同。范德堡大学物理与天文学教授 Robert Scherrer 此前仅将 ChatGPT 当作消遣工具把玩,他告诉我:“我曾让它以《贝奥武夫》的文风改写《吉利根岛》的主题曲,它完成得非常出色。”直到同在范德堡大学的同事、如今任职于 OpenAI 的物理学家 Alex Lupsasca 告诉他,GPT-5 帮其解决了一个研究中的难题,他才改变了对这款模型的看法。

Lupsasca 为 Scherrer 开通了 GPT-5 Pro,这是 OpenAI 每月 200 美元的高级订阅服务。Scherrer 说,“我和我的研究生为一个问题钻研了数月都毫无头绪,GPT-5 却成功解决了它。”但他也坦言,这款模型并非完美:“GPT-5 还是会犯一些低级错误。当然,我自己也会出错,但 GPT-5 犯的错误更愚蠢。”不过他表示,其进步速度有目共睹,“如果当前的发展趋势能持续下去,我想很快所有科研人员都会用上大语言模型。当然,这只是个假设。”

非营利性研究机构杰克逊实验室的生物学教授 Derya Unutmaz,在其免疫系统相关研究中,会借助 GPT-5 进行头脑风暴、论文总结和实验规划。在他向 OpenAI 分享的案例研究中,其团队曾分析过一组旧数据集,而 GPT-5 对这组数据的分析,得出了全新的见解和解读。他说:“大语言模型对科学家来说已经至关重要了。以前需要几个月才能完成的数据集分析,现在用大语言模型就能完成了,不用大语言模型已经行不通了。”

加州大学伯克利分校的统计学家 Nikita Zhivotovskiy 表示,从 ChatGPT 首个版本发布开始,他就在研究中使用大语言模型了。和 Scherrer 一样,他认为大语言模型最有用的地方在于,能挖掘出其研究工作与一些未知现有研究成果之间的意外关联。“我相信大语言模型正在成为科学家们必不可少的技术工具,就像曾经的计算机和互联网一样。那些拒绝使用这类工具的人,将会长期处于劣势。”但他并不指望大语言模型能在短期内取得什么新发现,“我几乎没见过模型能提出真正值得单独发表的全新观点或论证。到目前为止,它们似乎主要是在整合现有的研究成果,有时还会出错,而非创造真正的全新研究方法。”

也有与 OpenAI 无任何关联的科研人员,态度则没那么乐观。

利物浦大学化学教授、勒沃休姆功能材料设计研究中心主任 Andy Cooper 表示,“到目前为止,我们尚未发现大语言模型从根本上改变了科学研究的方式,但我们近期的研究结果表明,这类工具确实有其用武之地。Cooper 正牵头研发一款所谓的 AI scientist,该系统能实现部分科研工作流程的完全自动化。他表示,其团队并不会借助大语言模型构思研究思路,但这项技术已开始在更庞大的自动化系统中显现实用价值,比如大语言模型可协助操控机器人。

“我猜测,大语言模型或许会更多应用于机器人工作流程,至少在初期会是如此。因为我不确定人们是否愿意听从大语言模型的指挥,我自己当然是不愿意的。”Cooper 称。

团队重点发力:让 GPT 少点自信、更加谦逊

大语言模型的实用性或许与日俱增,但保持谨慎仍是关键。去年 12 月,研究量子力学的科学家 Jonathan Oppenheim 指出,某本科学期刊中出现了一处由大语言模型导致的错误。他在 X 平台发文称,“OpenAI 的管理层正在推广《Physics Letters B》上的一篇论文,其中的核心思路由 GPT-5 提出,这或许是首篇由大语言模型贡献核心观点且通过同行评审的论文。但有个小问题:GPT-5 提出的思路,验证的对象完全错了。研究人员让 GPT-5 设计一个能检测非线性理论的验证实验,它却给出了一个检测非定域性理论的方案。二者看似相关,实则截然不同。这就好比你想要一个新冠检测试剂盒,大语言模型却兴冲冲地递给你一个水痘检测试剂盒。”

显然,许多科研人员正以富有创意、贴合实际的方式运用大语言模型。但同样显而易见的是,这项技术所犯的错误可能极为隐蔽,甚至连专家都难以察觉。这一问题的成因,部分源于 ChatGPT 的交互特性,它总能以迎合的语气让使用者放松警惕。正如 Jonathan Oppenheim 所言,“核心问题在于,大语言模型的训练目标是迎合用户,而科学研究需要的是能够挑战我们的的工具。”曾有一个极端案例,一名非科研领域的普通人被 ChatGPT 误导,长达数月都坚信自己发明了一个新的数学分支。

当然,Weil 也深知大语言模型的幻觉问题,但他强调,新一代模型产生幻觉的概率已大幅降低。即便如此,他认为,仅仅关注幻觉可能就偏离了重点。

“我的一位同事曾是数学教授,他说过的一番话让我印象深刻:‘我做研究时,和同事交流碰撞想法,自己的观点 90%都是错的,但这正是意义所在。我们都在大胆畅想思路,只为找到一条可行的研究路径。’”Weil 表示,“这其实是科研中最理想的状态。当你提出足够多的错误观点,有人偶然发现了一丝真理,另一人抓住这一点继续探讨:‘你说的这点并不完全正确,但如果我们换个思路’。就这样,人们便能在科研迷雾中逐渐摸索出前行的道路。”

这正是 Weil 为 OpenAI for Science 设定的核心愿景。他认为,GPT-5 固然优秀,但它并非万能灵药。这项技术的价值在于引导人们探索新的方向,而非提供最终答案。事实上,OpenAI 目前正着手优化 GPT-5 的一项特性:让它在给出答案时降低其置信度。它不会再直接说“答案在这里”,而是会以更委婉的方式告诉科研人员:“以下思路可供参考。”“这正是我们目前投入大量精力在做的事:努力让模型具备某种认知层面的谦逊性。”Weil 称。

据透露,OpenAI 正在探索的另一方向,是利用 GPT-5 对自身输出进行事实核查。实际应用中常有这样的情况:如果你把 GPT-5 的某个答案重新输入到模型中,它会逐条分析并指出其中的错误。Weil 表示,“我们可以让模型充当自身的校验者。如此便能搭建一套工作流程:模型先完成初步推理,再将结果交由另一模型审核;如果这个模型发现了可以改进的地方,就会把结果反馈给原模型,并提示‘注意,这部分内容有误,但这部分思路有价值,可保留’。这就像两个智能体协同工作,只有当输出内容通过校验者的审核后,才会最终呈现。”

这一机制,与谷歌 DeepMind 为 AlphaEvolve 打造的模式高度相似。AlphaEvolve 是一款工具,它将大语言模型 Gemini 封装在一个更大的系统中,该系统能够筛选出优质回复,并将其反馈给模型进行改进。谷歌 DeepMind 已借助 AlphaEvolve 解决了多个现实中的科研难题。

如今,OpenAI 面临着竞争对手的激烈角逐,这些企业的大语言模型即便无法实现 OpenAI 为其模型宣称的全部功能,也能完成绝大部分。倘若如此,科研人员为何要选择 GPT-5,而非同样在逐年迭代升级的 Gemini 或 Anthropic 旗下的 Claude 系列模型?归根结底,OpenAI for Science 的布局,很大程度上也是为了在这一新领域抢占先机。而真正的技术创新,尚未到来。

参考链接:

https://www.technologyreview.com/2026/01/26/1131728/inside-openais-big-play-for-science/

https://openai.com/zh-Hans-CN/prism/