过去几年,基于哈希中心的深度哈希方法逐渐成为大规模图像检索的主流。这类方法通过为每个类别预设固定的哈希中心作为学习目标,避免了成对或三元组方法的高计算复杂度。然而,随机初始化的哈希中心往往忽略了类间语义关系。现有两阶段方法 SHC 通过引入与哈希函数训练分离的中心生成阶段,为哈希中心注入了语义。但其引入的额外复杂性、计算开销和阶段间偏差导致了次优性能。

近日,北京邮电大学、北京航空航天大学和中国电信等机构联合提出了一种新颖的端到端框架——中心重分配哈希(Center-Reassigned Hashing, CRH),它在训练哈希函数的同时,通过重分配动态地更新哈希中心。CRH 无需复杂的预训练或离线优化阶段,就能将语义关系无缝集成到中心学习过程中,显著提升了检索精度和语义一致性。该创新工作论文已被 AAAI 2026 收录,代码已开源,为哈希学习领域提供了新的思路和可复现基础。

论文题目:Codebook-Centric Deep Hashing: End-to-End Joint Learning of Semantic Hash Centers and Neural Hash Function

论文链接: https://www.arxiv.org/abs/2511.12162

代码链接: https://github.com/iFamilyi/CRH

研究背景

图像哈希因其高效的计算和紧凑的存储,成为大规模图像检索的核心技术。随着深度学习的发展,深度哈希方法显著超越了传统浅层方法。现有深度监督哈希方法可分为三类:成对方法、三元组方法和点态方法。成对和三元组方法通过保留样本间的局部相似性关系进行优化,但计算复杂度高( $ O(N^2) $或更高),且难以捕捉全局数据结构。点态方法直接利用类别标签,实现线性复杂度,但早期方法将哈希视为分类问题,性能有限。

近年来,基于哈希中心的点态方法受到关注,如 CSQ[1]、OrthoHash[2] 和 MDS[3]。这些方法为每个类别预设二值哈希中心,并训练网络将图像表征对齐到对应中心。虽然取得了先进结果,但哈希中心通常随机初始化,忽略了类间语义相关性(例如,“猫”和“狗”的哈希中心应比“猫”和“汽车”更接近)。为解决这一问题,SHC [4] 等方法采用两阶段策略:先通过分类器相似性估计和迭代优化生成语义感知的哈希中心,再训练哈希函数。但这引入了高计算开销、破坏了端到端可训练性,且基于分类的相似性估计可能偏离检索目标。

CRH 的创新在于通过哈希中心的动态重分配机制,实现哈希中心和哈希函数的端到端联合学习,避免两阶段方法的缺陷。

CRH 方法框架

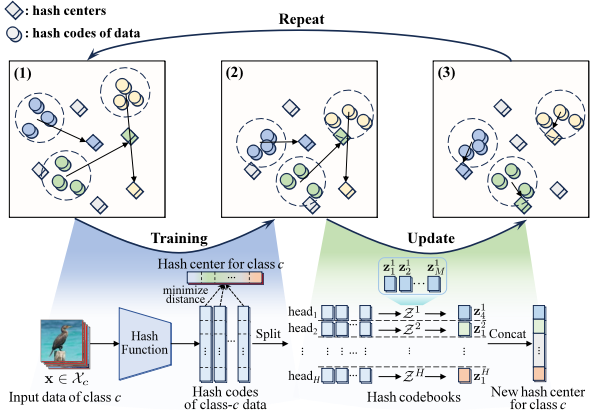

CRH 的核心思想是迭代地更新哈希中心的分配,使其逐步对齐类间语义关系。整体框架分为三个关键组件:(1)哈希码本初始化;(2)哈希函数优化;(3)哈希中心重分配。整个过程无需显式预训练,实现端到端学习。

图 1 CRH 的框架图。上图:汉明空间的可视化。三张图分别表示 1)初始化 / 上一轮的数据的哈希码和中心的分配、2)经过训练哈希码靠近对应的哈希中心和 3)为每一类重新分配哈希中心,这些步骤被重复执行。下图:以单个类别 c 为例的训练时的学习目标以及多头更新机制的流程。

2.1 哈希中心初始化

CRH 构建一个包含 M 个候选哈希中心的哈希码本$Z = \{ z_m \}_{m=1}^M$(M≥C,C 为类别数),每个中心 zm 是 K 维二值向量。码本通过均匀采样生成,确保哈希中心之间的汉明距离足够大。初始时,随机从码本中选择 C 个中心分配给各个类别。

2.2 哈希函数训练

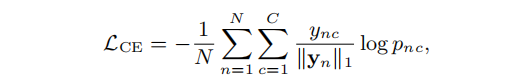

哈希函数 f(x) 使用深度神经网络(如 ResNet-34)实现,将输入图像映射到松弛哈希码。损失函数结合边际交叉熵损失和量化损失:

边际交叉熵损失拉近样本与对应中心距离,推远其他中心。

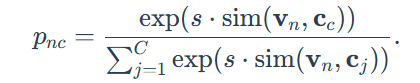

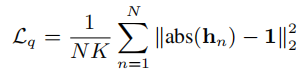

其中,

量化损失减少二值化误差。

总体目标函数为二者加权和:$\mathcal{L} = \mathcal{L}_{\text{CE}} + \lambda \mathcal{L}_c$。

2.3 哈希中心重分配

在训练过程中,定期(如每 5 个 epoch)重新分配哈希中心:基于样本当前的哈希码$\mathbf{h}_x$,计算每个类别样本与码本中心的平均距离$\text{l}_{\text{cm}}$,作为将中心$\text{z}_{\text{m}}$分配给类别 c 的分配误差,形成成本矩阵 $L = (\text{l}_{\text{cm}}) \text{C} \times \text{M}$:

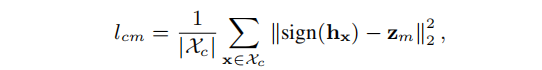

然后使用贪心或匈牙利算法优化中心分配,最小化总距离:

其中 j∗c 为分配给类别 c 的中心在 Z 中的索引。通过重分配来更新哈希中心,避免直接优化二值的中心本身,确保哈希中心保持二值性和分离性。对于多标签数据集,还引入权重对分配误差的计算进行加权。

2.4 多头码本设计

为增强中心的语义表达能力,CRH 将每个 K 维向量$\text{z}_{\text{m}} $分割为 H 个头$\{ z_m^1, \cdots, z_m^H \}$,每个 $z_m^h$ 的维度为 K/H。每个头独立进行中心重分配,得到各个头的子中心$c_c^h$ ,最终中心通过拼接每个头的子中心得到 $\mathbf{c}_c = \text{concat}\left( \mathbf{c}_c^1, \cdots, \mathbf{c}_c^H \right)$ 。这在不增加码本实际大小的情况下,将码本容量从 $M$ 扩展到 $M^H$,实现更细粒度的语义表示。

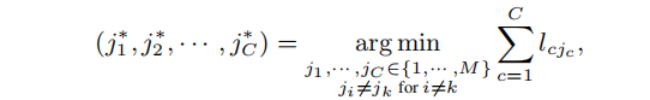

整个算法流程交替执行哈希函数优化和中心重分配,总结如下。

图 2 CRH 的算法流程:包含中心初始化、交替的哈希函数训练与中心重分配。

实验与结果

实验在三个基准数据集上进行:Stanford Cars(单标签)、NABirds(单标签)和 MS COCO(多标签),评估指标为平均精度 mAP。

3.1 主要结果

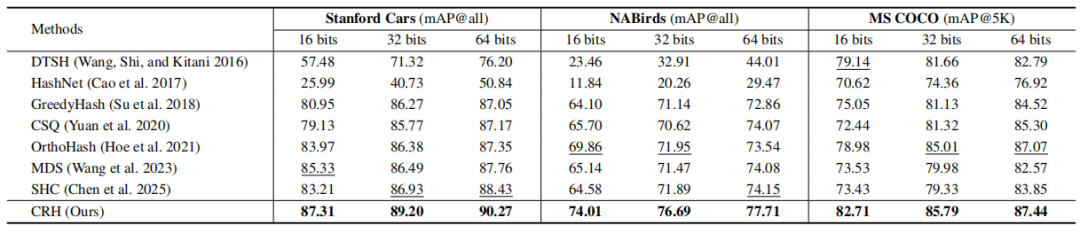

表 1 我们的方法与深度哈希 baseline 在三个图像数据集上不同码长的检索性能(mAP,%)比较。

CRH 在所有数据集和码长(16、32、64 位)上均优于现有先进方法,包括 CSQ、OrthoHash、MDS 和 SHC 等。具体地,在 Stanford Cars、NABirds 和 MSCOCO 数据集上, CRH 比基线的最好结果分别相对提升了 2.1%~2.6%,4.8%~6.6% 和 0.4%~4.5%。在包含更多类别的 NABirds 上,提升尤为显著,说明 CRH 能有效处理细粒度语义关系。

3.2 消融研究

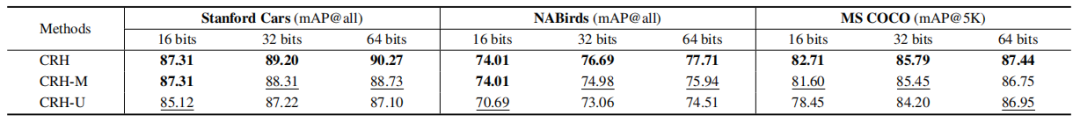

表 2 CRH 与消融变体 CRH-M、CRH-U 在三个数据集上的检索性能比较。

消融实验验证了中心重分配和多头机制的有效性:

CRH-U:移除中心重分配(固定中心),性能显著下降,平均 mAP 相对保留重分配的 CRH-M 降低 1.76%~3.08%。

CRH-M:移除多头设计(单头),性能优于 CRH-U 但低于完整的 CRH,证明多头能进一步细化语义表示。

3.3 稳健性分析

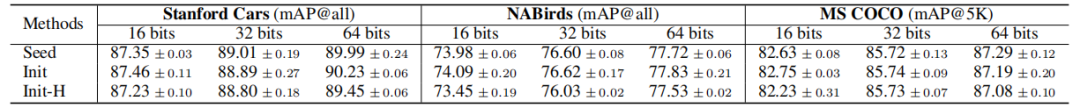

表 3 初始化和更新算法引入的随机性对性能的影响(mean±std mAP)。Seed:贪心算法;Init:中心初始化;Init-H:匈牙利算法。

CRH 对初始化(Init)和贪心算法(Seed)引入的随机性的稳健性高,多次运行的 mAP 标准差极低(<0.4%),表明方法稳定。相同初始化下,贪心算法(Init)比匈牙利算法(Init-H)更优,兼顾性能和效率。

3.4 语义质量分析

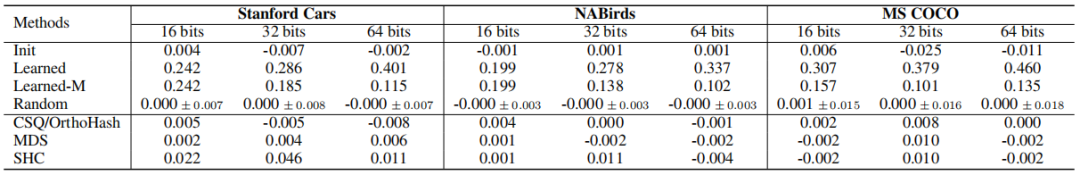

表 4 哈希中心的相似性矩阵 $S^h$ 与参考相似性矩阵 $S^r$ 的 Pearson 相关系数。Init 对应初始化的中心。learned 和 learned-m 分别对应多头和单头下学到的中心。Random 对应随机中心。下面是 4 个基线的结果。

通过计算哈希中心两两间相似度与基于 CLIP 的视觉表征相似度的 Pearson 相关系数(PCC),评估所学哈希中心语义对齐程度。CRH 学习到的哈希中心 PCC 显著高于无语义的基线(如 CSQ 和 OrthoHash 接近零)以及两阶段方法(SHC),说明 CRH 能捕获有意义的语义结构。

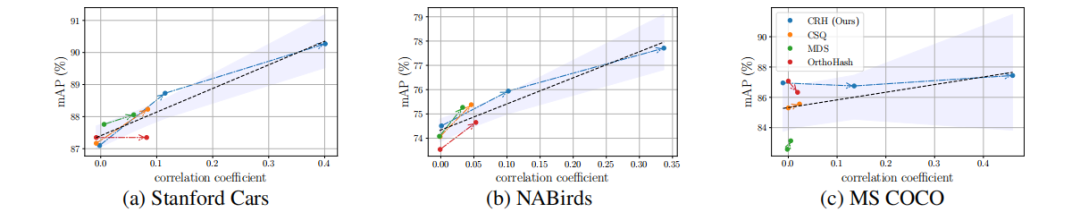

图 3 不同方法在 64bits 下的 mAP 与相关系数的关系。

图 3 揭示了 mAP 与 PCC 的正相关关系,即更好的语义对齐通常带来更优的检索性能。

3.5 参数分析

通过对超参数的敏感性分析,可得如下关键发现:

码本大小 M:M=2C 时平衡性能和效率。

头维度 $d$:最佳 $d$ 为满足 $d \ge \log_2 M$ 的 2 的最小幂次,保持 $d$ 尽可能小的同时避免码本碰撞。

更新频率:频繁更新(如每个 epoch 更新一次)提升 PCC 和 mAP,但后期可放宽间隔以降低计算。

总 结

CRH 通过中心重分配机制,实现了哈希中心和哈希函数的端到端联合优化,无需复杂的两阶段流程,多头设计进一步增强了语义表达能力。实验表明,CRH 学习到了能表达语义的哈希中心,在单标签和多标签检索任务上均达到最先进水平,且具有高稳健性和可复现性。

这项工作为深度哈希学习提供了新方向,强调动态中心优化的重要性,未来可扩展至多模态检索和长尾分布场景。

参考文献

[1]Yuan L, Wang T, Zhang X, et al. Central similarity quantization for efficient image and video retrieval[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2020: 3083-3092.

[2]Hoe J T, Ng K W, Zhang T, et al. One loss for all: Deep hashing with a single cosine similarity based learning objective[J]. Advances in Neural Information Processing Systems, 2021, 34: 24286-24298.

[3]Wang L, Pan Y, Liu C, et al. Deep hashing with minimal-distance-separated hash centers[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2023: 23455-23464.

[4]Chen L, Liu R, Zhou Y, et al. Deep Hashing with Semantic Hash Centers for Image Retrieval[J]. ACM Transactions on Information Systems, 2025, 43(6): 1-38.