作者|陈姚戈

世界模型领域迎来了一个重要开源模型。

今天,蚂蚁集团旗下的具身智能公司“蚂蚁灵波”,正式发布并开源其通用世界模型 LingBot-World。与许多闭源方案不同,蚂蚁灵波选择全面开源代码和模型权重,而且不绑定任何特定硬件或平台。

去年 DeepMind 发布的 Genie 3,让人们看到了世界模型能够根据文本或图像提示,实时生成一个可探索的动态虚拟世界。LingBot-World 沿袭了这条路线,并在交互能力、高动态稳定性、长时序连贯性以及物理一致性等维度取得了突破。

更令人惊喜的是,LingBot-World 呈现出从“生成”到“模拟”的跨越。随着模型规模的扩大,灵波团队观察到,LingBot-World 开始表现出远超普通视频生成的复杂行为,涌现出对空间关系、时间连续性和物理规律的理解。

可以看到,鸭子腿部蹬水的动作、水面对扰动的响应、以及鸭子身体与水之间的相互作用都比较符合物理规律。

这显示出模型不仅记住了视觉表象,还在某种程度上理解了流体力学等基础物理机制。同时,水面对扰动的反应,显示出模型对因果关系的理解。

用户切换视角后再回来时,环境中的智能体(比如这只猫)仍能保持持久记忆。智能体即使没有被观察到,也能持续行动。这确保了当视角回归时,世界状态会自然推进。

当环境中智能体(这只猫)碰到沙发后,没有穿透沙发,反而向空地走去。可以看到,LingBot-World 遵循了空间的逻辑,让智能体运动具有物理的合理性。

这是一个长达 9 分 20 秒的视频,没有经过任何剪辑和拼贴。视频为用户第一视角,从一座破旧的古希腊神庙出发,沿城市小径前行,经过一座新古典主义建筑,再向左进入一片复原的古希腊建筑群。

在近十分钟内,画面保持了较为稳定的物理状态和视觉质量,这在目前的视频生成模型和世界模型中都比较罕见。

不过,在视频最后几分钟,建筑之间的位置关系似乎被模型遗忘了。在 7:00,新古典主义建筑和复原式古希腊建筑群是连接在一起的;但 7:31,从复原式古希腊建筑群望向新古典主义建筑时,新古典主义建筑消失了。8:30 回到新古典主义建筑时,它成为了一栋孤立的房子。

尽管存在这些细节瑕疵,LingBot-World 的进步依然显著——单次生成接近 10 分钟的连贯视频,很可能刷新了当前视频/世界模型的长度纪录。作为对比,Veo 3 和 Sora 2 的单次生成上限分别为 8 秒和 25 秒,Runway Gen-3 Alpha 为 40 秒,Kling 最长支持 2 分钟。

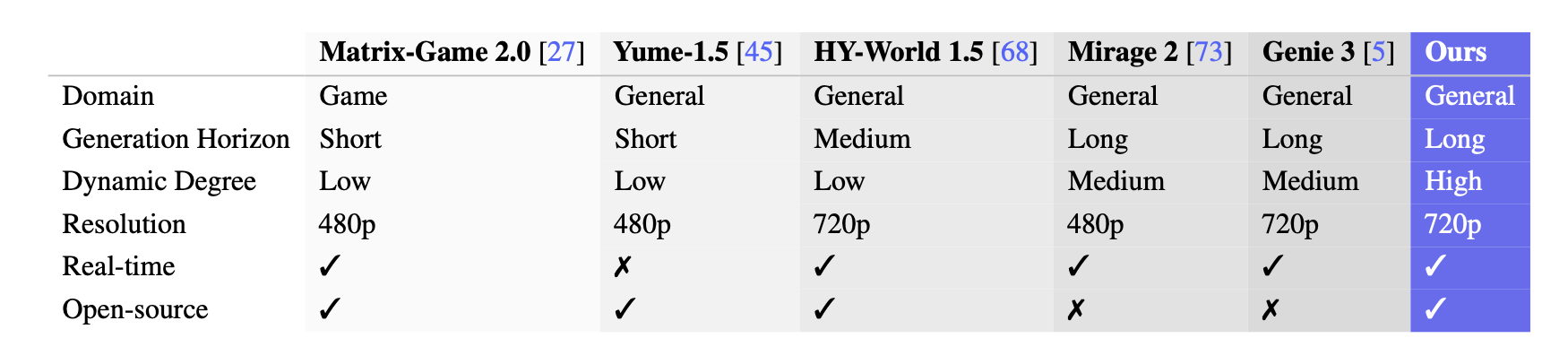

与其他交互世界模型相比,LingBot-World 在开源、提供 720p 分辨率的情况下,还保证了高动态程度和长生成跨度。

在 VBench 测试中,LingBot-World 全面领先于 Yume-1.5 和 HY World-1.5 等先进开源模型,证明了自己不仅是一个视频生成器,更是一个强大的交互式模拟器。通过接收用户输入的动作指令,它能够生成高度动态且物理一致的视觉反馈,保持在高动态度下的整体一致性,使视频内容在长时间段内始终与最初的提示保持一致。

在看到大语言模型的局限后,世界模型成为火热赛道。Google、李飞飞、Yann LeCun 以及众多科学家纷纷指出,LLM 无法很好地理解物理世界、因果关系,而“世界模型”是 AI 走向真实物理世界深度理解的一个解。

至于“世界模型”究竟该长什么样,行业至今尚无统一标准。

李飞飞的 Marble 正专注理解空间关系;英伟达把世界模型细分为预测模型、风格迁移模型、推理模型;DeepMind 团队的 Genie 3,则试图在同一个模型中,实现端到端的实时渲染。

路线的分歧,也反应了行业需求的多样性,以及寻找解决方案的困难——无论是智能驾驶、具身智能,还是游戏,都在寻找各自需要的智能方案,以及合适的开发范式和入口。

蚂蚁灵波的世界模型方案更接近 Genie 3,旨在成为一个通用模型,为 Agent、具身智能、游戏、仿真等领域提供理解世界物理规律的基础设施平台。

通过开源其训练方法、模型权重等内容,蚂蚁灵波不仅展示了其在具身智能领域的战略布局,也为行业提供了探索世界模型更多可能性的契机,帮助降低验证世界模型的门槛。

这一周,蚂蚁灵波对外集中发布和开源模型研究成果,相继发布并开源空间感知模型 LingBot-Depth、具身大模型 LingBot-VLA。

如今,随着 LingBot-World 的发布,蚂蚁灵波正从幕后走向台前。蚂蚁灵波的目标是打造一个开放、通用的智能基座,与越来越多行业和厂商共建生态。这一次,它用开源的方式,向世界抛出了自己的世界模型范式。

构建世界模型的梦想和努力

在深入探讨蚂蚁团队通用世界模型的细节之前,我们需要花点时间,回顾一下 1990 年世界模型的开始。这将帮助我们更清楚地理解过去 30 多年中“世界模型”研究的变与不变、当前世界模型技术路线之争的焦点,从而更好地理解蚂蚁是在怎样的方向和基础上努力。

世界模型 40 年,变与不变

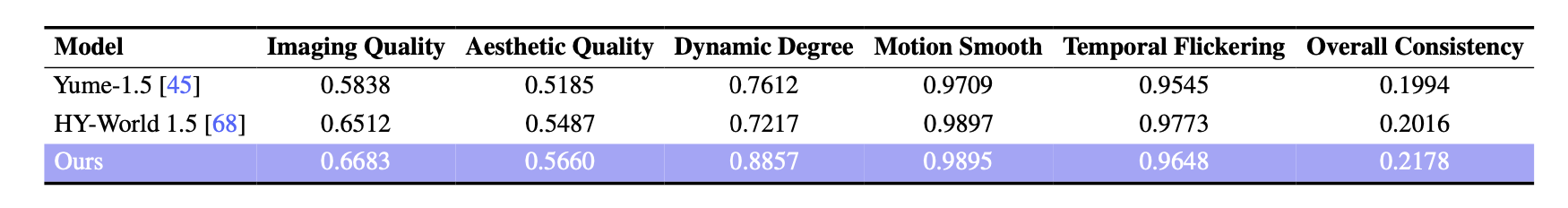

1990 年,强化学习领域奠基人、2024 图灵奖获得者 Richard S. Sutton 在人类认知学习过程的启发下,在论文《Dyna, an Integrated Architecture for Learning, Planning, and Reacting》中提出了一个开创性架构:智能体不应只靠真实世界试错学习,而应构建一个内部世界模型,在“脑海”中模拟动作后果,低成本地进行规划与策略优化。

图片来自 Dyna 论文。

图片呈现的是 Dyna 框架的核心逻辑,智能体的目标是最大化其在时间维度上累积获得的总奖励。

在 Dyna 框架中,世界模型也被称为动作模型,它被视为一个“黑盒子”,输入当前的情境和动作,输出对下一个情境和即时奖励的预测。模型的作用是模拟现实世界,Agent 通过与现实世界的持续互动产生经验,并利用这些经验通过监督学习方法来改进模型,使其更接近真实的物理规律。

在 2026 年回顾这篇 36 年前的论文,会发现这份古早的研究为理解当下复杂的技术路线之争提供了共同的根基——

对世界模型的探究,起源于对人类、机器,以及更广泛的智能体如何学习和行动的好奇。

而“世界模型”作为一种方法,提出的解决方案是在模拟出的世界中,让智能体学习、行动、获得反馈和迭代。

Dyna 这篇论文的核心理念,成为了今天世界模型的研究的底层思路。

不管是 NVIDIA Cosmos、World labs、Google Genie,还是 LingBot-World,都沿袭了 Dyna 的核心理念:世界模型是为智能体提供“模拟经验”的内部环境,使得智能体可以在一个虚拟的环境中进行规划和策略训练。

在不同方向的探索中,我们可以得到的共识是:世界模型从多样化的输入数据中学习对真实世界环境的内部表征,包括物理规律、空间动态和因果关系等。这些表征帮助模型预测未来状态,模拟动作序列,并支持复杂的规划与决策,而不需要反复进行真实世界的实验。

36 年过去,我们正站在大语言模型的阴影和语境中讨论世界模型。LLM 在理解真实物理世界、及模拟/预测未来后果等方面的局限,正加速科研和商业领域对世界模型的探索。

在 2025 年的一次访谈中,Dyna 的创作者 Richard S. Sutton 强调,LLM 已经走到了瓶颈。他指出,LLM 的核心缺陷在于,它们仅仅是在模仿人类行为,而无法理解世界、预测现实世界中的未来事件。他提倡放弃基于 LLM 的路径,转而开发基于强化学习、拥有世界转换模型(Transition model of the world)。这种世界模型不仅能学习奖励,还能从所有感官信息中获取环境的丰富理解,最终能够预测“如果做某事,后果将是什么”。

大语言模型在理解真实物理世界的不足,以及模拟/预测未来后果的不足,让一批科学家转向,在世界模型中寻找解法。

李飞飞认为 LLM 缺乏对物理世界的感知,提出“空间智能”(Spatial Intelligence)是 AI 的下一个北极星,AI 需要理解三维空间、几何、物理规则以及因果关系,才能从“理解文本”迈向“理解并作用于物理世界”。

Yann LeCun 则批评 LLM 依赖文本概率预测,感知学习世界的方式背道而驰。为此,他推广 JEPA(联合嵌入预测架构),并成立 AMI Labs,通过世界模型的路径实现 AGI,探索如何让 AI 系统具备理解物理世界、持久记忆、逻辑推理以及复杂任务规划能力。

DeepMind 联合创始人兼 CEO Demis Hassabis 在今年 1 月的对谈节目中强调,目前的 AI 系统还不能理解物理世界、因果关系、行为如何影响结果,而精确的世界模型是实现科学发现或理论创新的关键。他表示,Genie 这样的模型还只是“胚胎期世界模型”,Genie 体现出的,生成关于世界的内容的能力,某种程度上体现了模型理解了世界的知识。

Google AI 团队深度押注了世界模型的发展,并认为它会在 2026 年赢得重大发展。Hassabis 在谈及 2026 年的突破和期待时提到,“最令我兴奋的,莫过于进一步推动‘世界模型’的发展,提升其运行效率,从而使其能够真正被用于我们通用模型中的‘规划’环节。”这可能意味着,未来世界模型将融入 Gemini 这样的基础模型中。

世界模型的路线分歧

在探索 AGI 的道路时,蚂蚁集团也看到了世界模型的潜力。

作为蚂蚁集团旗下的具身智能企业,蚂蚁灵波的定位是“智能基座公司”,致力于打造一个能够理解世界、物理规律以及时空演化的 AI 系统。而世界模型正是实现这一目标的重要方式之一。

尽管各方都将世界模型视为未来的关键技术,然而不同公司选择的路径却各不相同。总体上,这些路径可以分为生成式和非生成式两类,两种路径的核心区别在于预测空间。

NVIDIA Cosmos、DeepMind Genie 和 World Labs 都是生成式路径的代表。

Cosmos 和 Genie 主要使用由像素构成的观测空间,利用大规模高维视觉数据训练,通过特定的时空架构设计,让模型产生对三维物理世界的理解。Genie 3 官网中特别提到“Genie 3 的一致性是一种涌现能力……Genie 3 生成的世界更为动态和丰富,因为它们是基于世界描述和用户动作逐帧创建的。”

World Labs 则另辟蹊径,将预测空间设定为在 3D 空间中带有位姿的帧,通过查询待生成帧的位姿来生成新图像。其发布的 RTFM 模型表明:“模型对世界的记忆(存储在各个帧中)具备了空间结构;它将带有位姿信息的帧视作一种‘空间存储’,这赋予了模型一种弱先验——即所建模的世界是三维欧几里得空间,而无需强迫模型显式预测该世界中的物体几何结构。”

非生成路径的代表是 Yann LeCun 的联合嵌入预测架构(Joint Embedding Predictive Architecture, JEPA)。JEPA 通过编码器将输入转化为潜空间(Latent Space),并在该空间内预测未来抽象表征(Embeddings),从而无需进行像素级的重建。

蚂蚁灵波的 LingBot-World 选择了类似 Genie 的路径,试图在此基础上解决从视频生成到世界模拟之间的技术障碍。

拆解 LingBot-World

在前文的案例和分析中,我们看到蚂蚁灵波的 LingBot-World 沿袭了 Gienie 的生成式路线,同时在交互能力、高动态稳定性、长时序连贯性以及物理一致性上表现惊艳。

在此基础上,蚂蚁灵波选择开源代码和模型权重,并在论文中完整披露了从数据采集到训练部署的全链路设计,鼓励社区测试、使用和复现。

即使是在近 10 分钟的超长视频中、或是快速运动下,画面中的物体依然保持了较为稳定的几何物理特性,没有出现视频生成模型常见的崩坏。这种稳定性,源于其独特的数据引擎和模型架构设计。

数据引擎

许多从视频生成模型切入世界模型研发的团队,很快会撞到数据瓶颈。

互联网上浩如烟海的短视频大多是“被动”记录,缺乏因果链条。对于世界模型而言,它需要理解的是动作和后果之间的关系。

比如:“按下 W 键向前走,门是否会打开?”“绕到建筑背面,窗户是否依然存在?”这类智能体动作与环境反馈之间的因果闭环,在普通视频中几乎不存在,在真实世界中规模化采集的成本也很高。

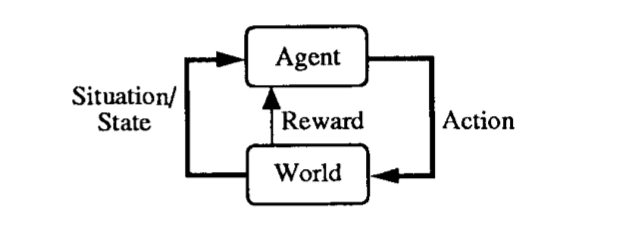

为了构建“动作-反馈”的闭环,LingBot-World 打造了从采集、处理到标注的流程。

LingBot-World 的数据包含通用视频、游戏数据和合成渲染数据,以确保训练语料的丰富性、高质量和交互性。为游戏数据,灵波团队还开发了专门的平台,捕获 RGB 帧并严格对齐用户的输入和相机参数。合成数据由 Unreal Engine 生成,带有精确相机数据和自定义轨迹。

LingBot-World 数据处理和标注流程

在数据处理层面,灵波团队首先对原始视频进行质量筛选与切分,生成结构清晰的视频片段;然后借助 VLM 视频的视觉质量、场景类型和视角等,结合几何标注提供必要的 3D 结构先验,产出元数据。

在此基础上,团队引入三种不同粒度的描述标注,涵盖视频全过程的宏观描述、去除了动作和相机数据的静态描写,以及带有时间标注的描述。

模型构建和训练

LingBot-World 将世界模型定义为一个条件生成过程,模拟由智能体动作驱动的视觉状态演化。

从模型构建和训练过程,我们可以看到,LingBot-World 是从“视频生成模型”起步,通过不同阶段训练,让模型从“生成”走向“模拟”。

从目标函数上看,这种模拟本质上是一种概率预测。

LingBot-World 的目标函数明确表达了这一思想:

$$\max_\theta \sum_{t=1}^{T-1} \log p_\theta(x_{t+1} | x_{1:t}, a_{1:t})$$

即在最大化给定历史帧 ($x_{1:t}$) 和动作序列 ($a_{1:t}$) 的条件下,预测下一帧状态 ($x_{t+1}$) 的似然概率。

简单来说,就是让模型学会根据过去看到的画面和执行过的动作,尽可能准确地预测下一帧画面。

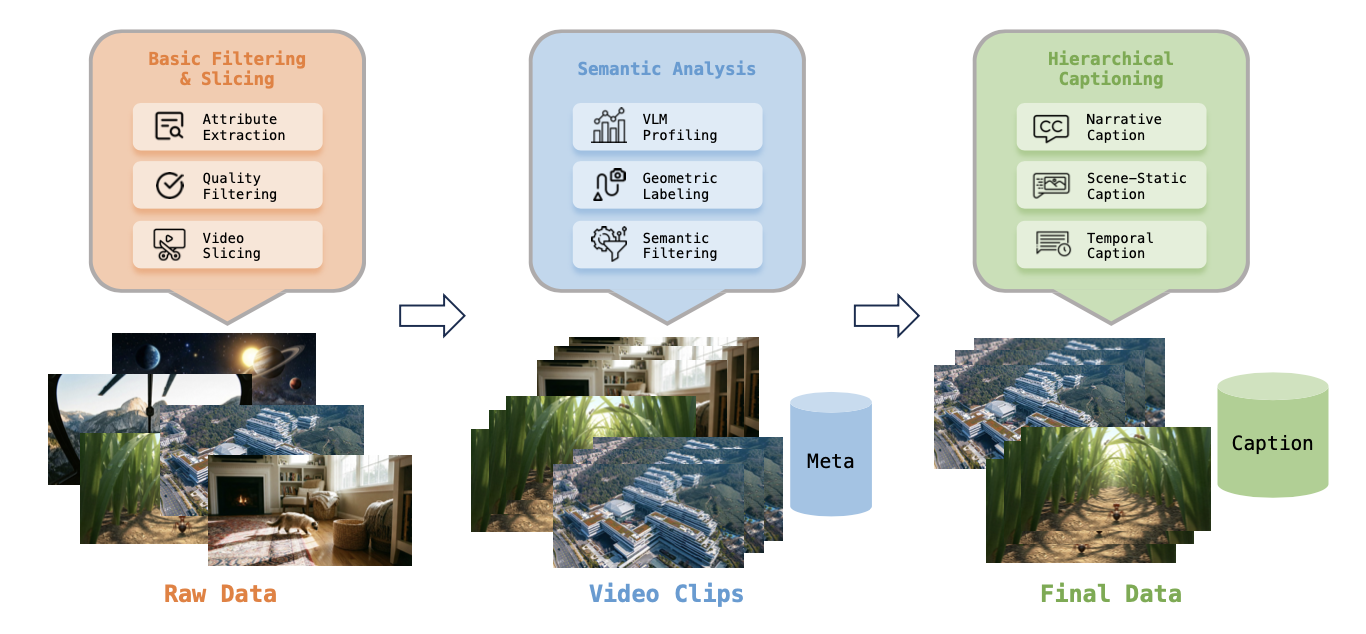

为了避免直接从零训练导致的计算开销和模式崩塌,LingBot-World 采取了分阶段的训练策略。

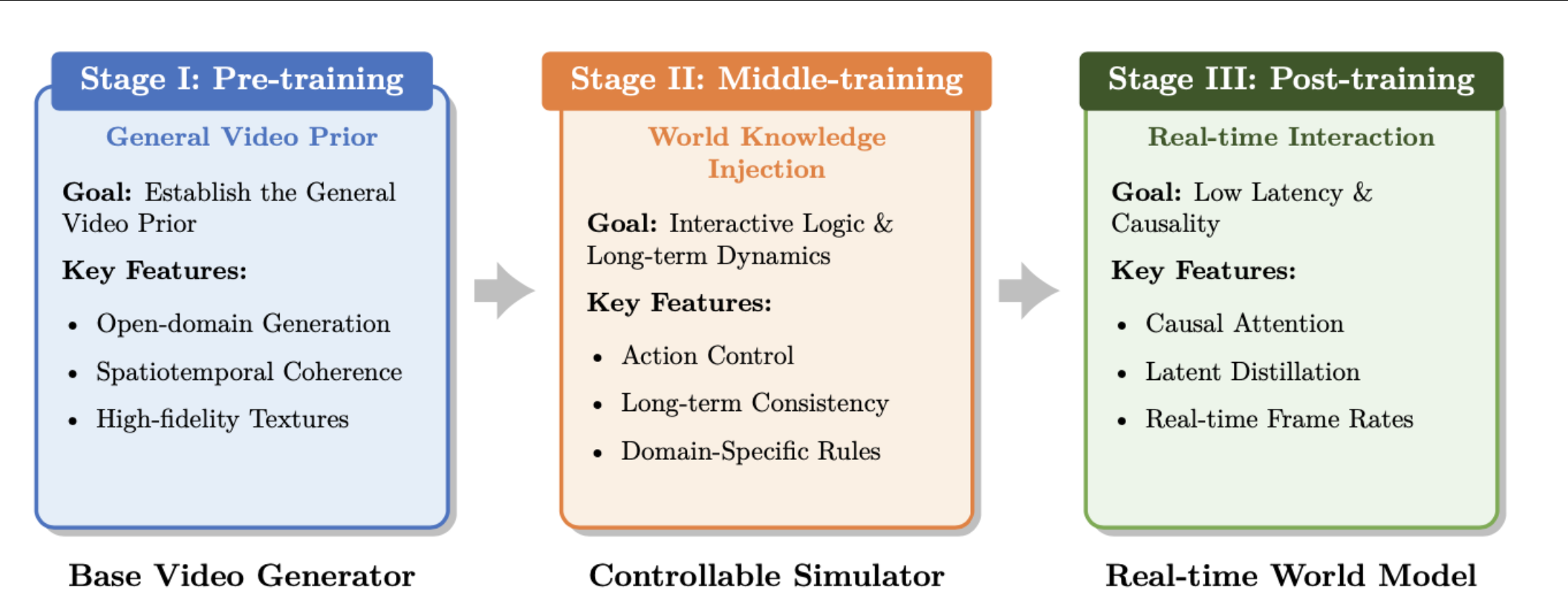

预训练负责建立稳健的通用视频先验,确保高保真开放域生成;中训练注入世界知识和动作可控性,使模型能够模拟具有一致交互逻辑的长期坚持动态;后训练使架构适应实时交互,采用因果注意力和少步蒸馏以实现低延迟和严格因果性。

LingBot-World 模型训练流程。

从“生成视频”到“模拟世界”,LingBot-World 带来的可能性

LingBot-World 的意义绝不仅在于生成一段精美的视频,而在于它提供了一个高保真的物理交互沙盒,成为具身智能、自动驾驶与虚拟现实等下游任务的通用基础设施。

LingBot-World 最直观的突破在于它赋予了通过自然语言控制模拟过程。例如,通过输入“冬季”或“夜晚”,模型会渲染出城堡结冰或夜晚灯光变化的物理效果,同时支持向“像素风”或“蒸汽朋克”等风格的切换。还可以在具体场景中精确注入特定物体。例如,在城堡上空触发烟花,或在喷泉中生成鱼和鸟。

在环境中生成烟花效果

改变环境整体风格

在自动驾驶训练中,这种能力极具价值。算法团队可以人为制造“鬼探头”、极端天气或突发交通冲突,构建出严苛的因果推理环境,从而低成本地解决智驾中的长尾问题。

深层物理特性的稳定性,则为这种模拟提供了实际应用的底座。得益于模型展现的长程记忆,生成的视频序列具备了较高的 3D 一致性,这使得视觉信息可以直接转化为场景点云,从而服务于 3D 重建或高精度仿真任务。

LingBot-World 具有很好的 3D 一致性。可以看到,视角变化的情况下,房间结构和物理性状仍然保持稳定。

这种稳定性试图触及具身智能训练中的一个核心痛点:机器人的导航或复杂操作往往涉及跨越长时序的决策序列。LingBot-World 展现的 10 分钟级别生成能力,在理论上为多步骤任务提供了更稳定的物理一致性。如果这种长程模拟能有效控制累积误差,将有助于机器人在虚拟环境中进行高频次、深度、低成本试错。

在此基础上,LingBot-World 与 LingBot-VLA(视觉-语言-动作模型)的结合,勾勒出了一种具身大脑的闭环方案。在这种设定下,世界模型充当了机器人的“内部模拟器”:在 VLA 模型输出最终指令前,系统可以在虚拟空间中先行演练不同的动作轨迹,评估其物理后果,从而筛选出更符合物理规律且具备安全性的执行路径。

令人惊喜的是,利用训练 LingBot-World 的数据,蚂蚁灵波团队还微调出了动作智能体。智能体可以被置于 LingBot-World 打造的环境中,Agent 的动作改变会实时重塑环境状态,而环境的演变则反过来决定 Agent 的下一步决策。

灵波团队利用 LingBot-World 相同数据训练处的自主智能体,能在生成的世界中自主规划并执行动作。

这种互动揭示了世界模型在“模拟沙盒”之外的另一种可能——它不仅能理解环境对智能体变化的响应,也具备预测智能体动作流的能力。

这意味着,世界模型未来或许不仅仅是训练智能体的工具,也有可能成为驱动智能体(包括机器人)的底座。

项目官网:

https://technology.robbyant.com/lingbot-world

论文连接:

https://arxiv.org/abs/2601.20540

代码和模型权重下载:

https://github.com/robbyant/lingbot-world

https://huggingface.co/robbyant/lingbot-world

https://www.modelscope.cn/models/Robbyant/lingbot-world-base-cam