OpenAI发布了Open Responses开放规范,该规范旨在实现智能体式(agentic)AI 工作流的标准化,减少 API 碎片化的问题。该规范获得了 Hugging Face、Vercel 及多家本地推理服务商支持,为智能体循环、推理可观测性,以及工具的内部与外部执行制定了统一标准,它能够让开发者避免重写集成代码,即可在专有模型与开源模型之间轻松切换。

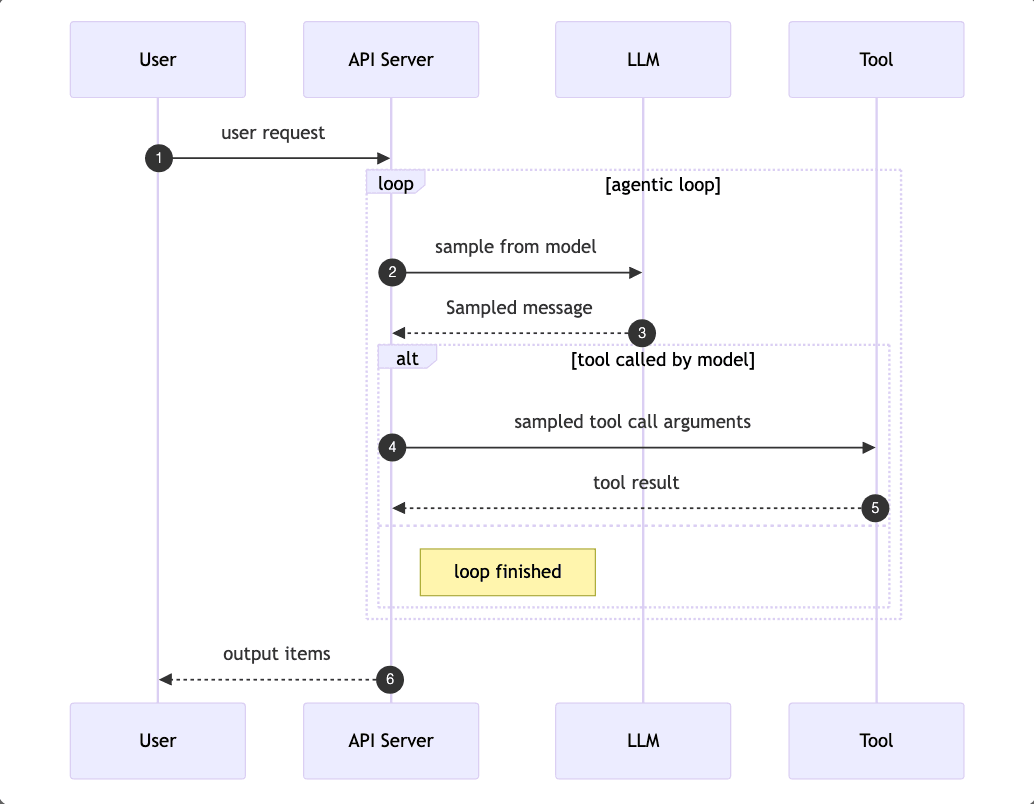

规范将条目(item)、推理可观测性、工具执行模型等概念进行了正式化定义,让模型服务商可在自身基础设施内管理多步骤的智能体式工作流,即推理、工具调用、结果反思的循环过程。这一改变使得模型服务商能在自有基础设施中处理复杂的工作流,并通过单次 API 请求返回最终结果。此外,规范原生支持多模态输入、流式事件和跨服务商工具调用,大幅减少了开发者在前沿模型与开源替代模型间切换时的适配工作量。

该规范的核心概念包含条目、工具使用和智能体循环。条目是代表模型输入、输出、工具调用或推理状态的原子单元,常见类型有 message、function_call、reasoning 等,同时具备可扩展性,允许服务商自定义规范之外的条目类型。其中值得关注的是 reasoning 类型,它能以服务商可控的方式暴露模型的思考过程,其负载可包含原始推理内容、受保护的内容或摘要,既让开发者能清晰看到模型的推理决策过程,也让服务商可自主把控信息暴露的范围和程度。

Open Responses 规范通过区分内部工具和外部工具,明确了编排逻辑的归属。内部工具直接在服务商的基础设施中执行,模型可自主管理智能体循环;在该模式下,模型服务商可完成文档检索、结果汇总等任务,再通过单次 API 往返将最终结果返回给开发者。而外部工具则在开发者的应用代码中执行,此模式下模型服务商会暂停流程并发起工具调用请求,由开发者处理工具执行并将输出结果回传给模型,才能继续后续的智能体循环。

该规范已获得Hugging Face、OpenRouter、Vercel,以及LM Studio、Ollama和vLLM等本地推理服务商的早期应用,实现了本地设备上标准化智能体式工作流的落地。

这一规范的发布引发了行业关于厂商锁定和生态成熟度的讨论。Rituraj Pramanik评价说:

在 OpenAI 的 API 基础上构建一套“开放” 标准,这一点看似有些讽刺,但它很有实用价值。行业真正的噩梦是碎片化,我们耗费了大量时间去对接各种不同的数据模式。如果这套规范能让我不用再写那些“套娃式的封装代码”,能让模型切换变得毫无门槛,那它就解决了智能体开发领域最棘手的难题。

另外,还有开发者将此举视为 LLM 领域生态日趋成熟的信号。AI 开发者兼教育者Sam Witteveen预测:

预计领先的开源模型实验室(如 Qwen、Kimi、DeepSeek)会训练同时兼容 Open Responses 规范和 Anthropic API 的模型。Ollama 也已宣布对 Anthropic API 的兼容性支持,这意味着,能运行高质量本地模型且可调用 Claude Code 工具的时代已不远。对于希望在专有模型和开源模型间切换、且无需重写技术架构的开发者而言,这无疑是一次重大利好。

目前,Open Responses 的规范文档、数据模式和合规测试工具已在项目官方网站上线,Hugging Face 也推出了演示应用,方便开发者直观体验该规范的实际应用效果。

原文链接:

Open Responses Specification Enables Unified Agentic LLM Workflows