2022 年 9 月 2 日最新消息:

在事件发酵一天之后,英伟达方面表示:已经获得美国政府批准,可以在明年 3 月前继续向美国客户出口(到中国)的产品提供 A100,可以在明年 9 月前继续履行 A100 和 H100 的订单。

具体包括如下三点:

1.授权英伟达继续开发 H100 芯片所需的出口、再出口和国内转移;

2.授权允许英伟达在 2023 年 3 月 1 日前进行必要的出口以向 A100 的美国客户提供支持;

3.授权英伟达在 2023 年 9 月 1 日之前通过其香港办事处履行 A100 和 H100 订单和物流;

英伟达 A100 和 H100 已被禁止向中国供货

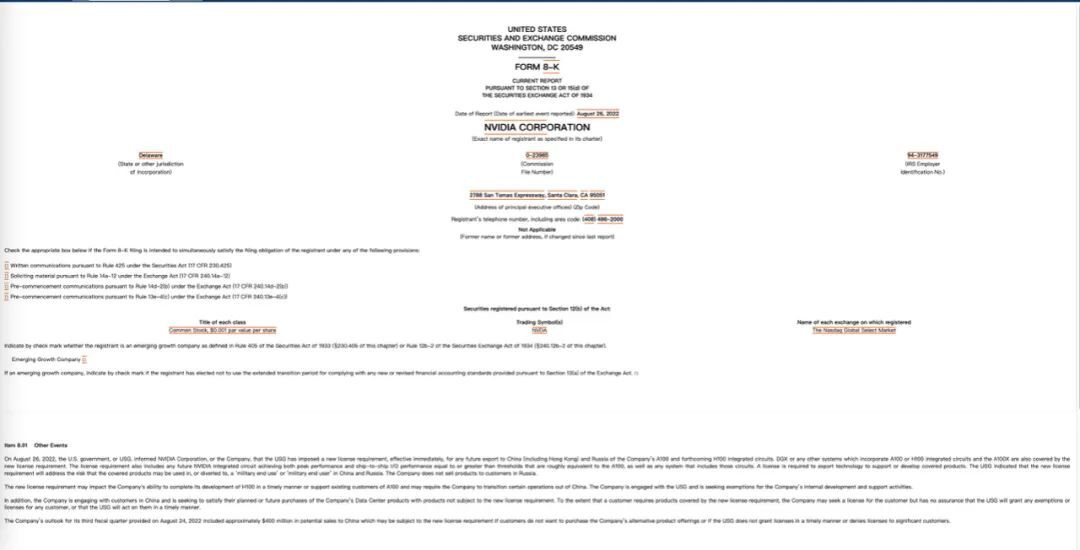

根据美国证券交易委员会(下文简称:SEC)的最新通知,英伟达将需要获得许可才能向中国和俄罗斯出口任何基于最新架构的 A100 GPU 或 DGX/HGX 等系统。新规定的要求也适用于即将推出的 H100(Hopper)GPU 或实现类似性能的产品。

美国政府认为,需要此类许可来限制此类产品被两国用于某些领域。需要注意的是,英伟达不对俄罗斯的客户销售产品。这一决定可能会影响英伟达 Hopper 架构的开发,因为这一新要求或许会让英伟达将“某些业务”转移出中国。

英伟达则可能会因为该规定损失约 4 亿美元的潜在销售收入,前提是没有其他选择或 SEC 未按时授予出口许可证。

通知全文如下:

2022 年 8 月 26 日,美国政府(USG) 通知英伟达,已对本公司未来向中国和俄罗斯的所有出口实施一项新的许可要求,立即生效。A100 和即将推出的 H100 集成电路,DGX 或包含 A100、H100、A100X 的所有系统均在新的许可要求中。本次发布的许可要求同样适用于 NVIDIA 未来一切性能等于或大于 A100 的产品,以及包括这些芯片的任何系统。USG 表示,新的许可要求将解决其中的产品用于或转用于中国和俄罗斯某些用途的风险。该公司不向俄罗斯客户出售商品。

新的许可要求可能会影响公司及时完成 H100 开发或支持 A100 现有客户的能力,并可能要求公司将某些业务转移到中国以外。该公司与美国政府合作,并正在为公司的内部开发和支持活动寻求豁免。

此外,公司正在与中国的客户接触,并寻求满足他们计划或未来购买公司数据中心产品的需求(注意:这里提到的产品是指不受新许可要求约束的产品)。如果客户需要新许可要求涵盖的产品,公司可能会为客户寻求许可,但不能保证 USG 会及时同意授予许可。

公司于 2022 年 8 月 24 日提供的第三季度财报展望中提到了中国市场约 4 亿美元的潜在销售额。

据集微网报道,英伟达方面也告知收到如下通知,英伟达中国区已收到总部要求,暂停对中国区所有客户所有代理商的数据中心 GPU 卡 A100 和 H100 的发货,其它 GPU 卡不受影响;各服务器 OEM 的现有库存 A100 GPU 卡,目前可以对各自的行业客户继续交付, 英伟达中国区目前也没有对 OEM 发任何 Letter。据悉,英伟达总部还在分析美国政府的政策要求,预计还需要 2~3 天才会有对中国区客户与合作伙伴的沟通口径。

除此之外,业内也有媒体报道称 AMD 收到了类似的要求,对中国区客户断供高端 GPU 芯片,但目前尚未得到 AMD 方面的官方回应。

消息来源:https://www.sec.gov/ix?doc=/Archives/edgar/data/1045810/000104581022000146/nvda-20220826.htm

A100 和 H100 有多强悍?

相比于英伟达前一代的 Volta GPU,A100 的性能提升了 20 倍,非常适合于人工智能、数据分析、科学计算和云图形工作负载。该芯片由 540 亿个晶体管组成,打包了第三代 Tensor 核心,并具有针对稀疏矩阵运算的加速功能,对于 AI 推理和训练来说特别有用。此外,每个 GPU 可以划分为多个实例,执行不同的推理任务,采用 Nvidia NVLink 互连技术可以将多个 A100 GPU 用于更大的 AI 推理工作负载。

然而,这些在 H100 出现之后显得略有不足了。在今年春季的发布会中,黄仁勋发布了面向高性能计算(HPC)和数据中心的下一代 Hopper 架构,搭载新一代芯片的首款加速卡被命名为 H100,它就是 A100 的替代者。

H100 是一款针对大模型专门优化过的芯片,使用台积电 5nm 定制版本制程(4N)打造,单块芯片包含 800 亿晶体管。同时也是全球首款 PCI-E 5 和 HBM 3 显卡,一块 H100 的 IO 带宽就是 40 terabyte 每秒。

Transformer 类预训练模型是当前 AI 领域最热门的方向,英伟达以此为目标专门优化 H100 的设计,提出了 Transformer Engine,集合了新的 Tensor Core、FP8 和 FP16 精度计算,以及 Transformer 神经网络动态处理能力,可以将此类机器学习模型的训练时间从几周缩短到几天。

针对服务器应用,H100 也可以虚拟化为 7 个用户共同使用,每个用户获得的算力相当于两块全功率的 T4 GPU。此外,H100 还实现了业界首个基于 GPU 的机密计算。

基于 Hopper 架构的 H100,英伟达还推出了机器学习工作站、超级计算机等一系列产品。8 块 H100 和 4 个 NVLink 结合组成一个巨型 GPU——DGX H100,一共有 6400 亿晶体管,AI 算力 32 petaflops,HBM3 内存容量高达 640G。

与此同时,得益于与 Equinix(管理全球 240 多个数据中心的全球服务提供商)的合作, A100 和 H100 的新型 GPU 通过水冷方式来节省用户的能源成本。使用这种冷却方法最多可以节省 110 亿瓦时,可以在 AI 和 HPC 推理工作中实现 20 倍的效率提升。

今年 5 月份,英伟达曾开源了 Linux GPU 内核模块代码,未来是否还会有更多开源计划,暂未可知。