eBay 利用各种营销渠道将新客户和现有客户汇集到该网站,其中之一就是 eBay 的联盟计划。eBay 还提供工具包来帮助发布商 / 分支机构增加佣金。有些工具可在 eBay 网站上购物时创建可跟踪的链接。至于更复杂的工具,如我们的 API,可以支持自定义访问 eBay 的产品列表数据。例如,用户可以创建横幅来添加实时的 eBay 清单到自己的网站。本文讨论了如何根据页面内容在发布商网站进行上下文广告。这种方法的亮点包括:

- 根据页面内容,通过算法确定如何识别出页面的标题 / 相关关键词。

- 忽略凌乱的 HTML 内容,只筛选相关和重要的关键词。

- 在不丢失推荐关键词的相关性的情况下,随着网址数量的增加进行扩展。

- 使用经测试并确认有效的 eBay 搜索算法,提供相关的 eBay 条目,在发布者页面上呈现。

- 仅当页面返回积极情绪时才触发条目呈现算法。我们已根据内容和上下文,为每个 HTML 页面构建了情绪预测算法。

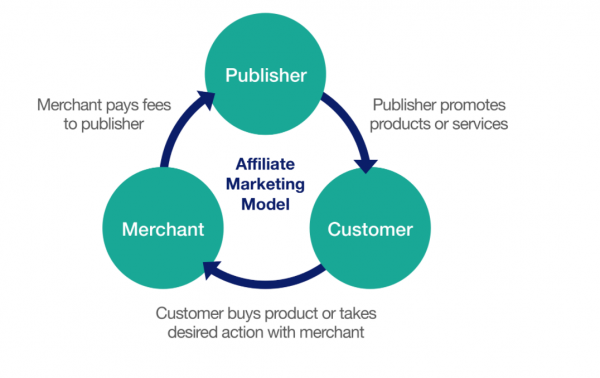

联盟营销模式

联盟营销是一个网上推荐项目,商家向发布商支付他们所提到的客户销售的佣金。

AI 前线:Affiliate Marketing,中文可以理解为联盟推广,也叫联盟营销,佣金计算方式是按成交付费,也即是 CPS。Affiliate Marketing 的优点是佣金往往比较客观。Affiliate Marketing 是一种由来已久的推广方式,由你向某个人推广某一个产品,当那个人通过你的推广购买了产品时,你就可以获得佣金。佣金的多少取决于你推广的产品。

有很多方法可以向访问我们合作伙伴网站的客户提供相关广告:

- 通过展示用户在过去与 eBay 互动的内容 (也称为重定向广告),我们将其定位为相同、相似或者互补的项目。(已产生兴趣,我们尝试通过购买来转话客户。)

- 通过提供来自发布商提供的关键词的 eBay 条目。(使用 eBay 搜索服务提供基于发布商提供的关键词的条目)

- 基于用户正在查看的内容,从而鼓动他们在 eBay 上进行订阅或购买决定。

AI 前线:所谓重定向广告是效果类广告中的一种精准投放方式。在消费者购物的过程中,常常会因为这样或那样的原因,最终没有完成转化。重定向广告将商品展示到此类未完成转化的消费者面前,将其带回到相关网页。由于展示的商品往往也是消费者最想要的,所以重定向广告的转化率比一般广告要更高。

在本文中,我们将讨论如何发布就广告内容相关的广告,并讨论一些我们用来实现业务目标的几个算法。

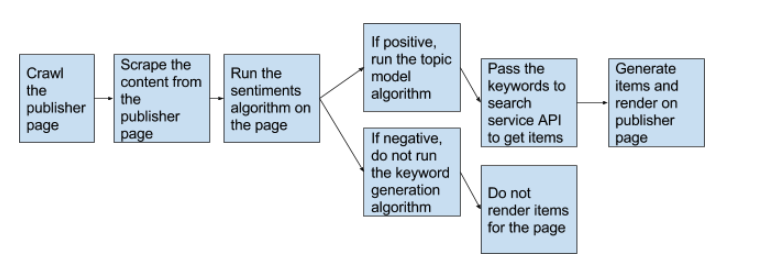

算法 1:基于主题建模和页面标题

处理流程:

- 搜寻发布商网站。

- 抓取发布商的内容。

- 确定内容是否反映正面或中立的情绪。

- 使用自然语言处理技术来确定感兴趣页面中相关的关键词。

- 基于关键词,调用 search API 获取该单词的 top 项目,并在发布商的网页上分享。

详细过程:

- 搜寻发布商网站:使用自制的网络爬虫,搜寻发布商的网站。网络爬虫会搜寻并返回发布商网址的 HTML 文件。(发布商明确地选择这种定位的方式,因此理解并允许我们抓取他们的网站。)

- 抓取发布者内容:抓取由

<p>描述的内容标签的 HTML 文件。另外,抓取标签<div>下的内容,这样我们就可以获得更多关于页面的细节。该算法将处理页面上不需要的内容。 - 识别页面的情绪:

算法:为页面内容生成一大堆单词,对否定词进行惩罚,并对正面单词进行奖励,然后计算整个页面的得分。

- 一旦页面被抓取,我们通过删除停止字、特殊字符、标点、空格等清理网站内容,以获得文献术语相关矩阵(Document Term Matrix,DTM)。DTM 包含页面上的单词列表及其相关的频率计数(通常也成为术语频率)。

- 然后我们运行三个单独的通用情感词典,如 AFINN、Bing 和 nrc(由 Finn Arup Nielsen、bing Liu 及其合作者 Saif Mohammad、Peter Turney 编纂)。所有这三个词典都是基于一元模型(unigrams),即单个单词。这些词典包含了许多英语单词,这些单词被赋予积极 / 消极情绪的分数,也可能是诸如喜欢、愤怒、悲伤等情绪。nrc 词典将单词以而二进制形式分类(是 / 否)分为积极、消极、愤怒、期待、延误、恐惧、喜悦、悲伤、惊讶和信任。Bing 词典以“二元”方式将单词分为“褒义”“贬义”两类。而 AFINN 词典则给单词打分,分数在 -5 到 5 之间,负分表示消极情绪,正分表示积极情绪。

- 该页面必须有三个词典中的两个才能返回正分数,以便将 URL 视为正数。

这种简单易行的检测情绪的方法是强大而准确的,我们构建了一个人工判断工具来整理算法的效率。实现了误分类率为 16%,这意味着 84% 的时间,算法预测了页面的实际情绪。

4. 确定相关的关键词

- 基于内容:我们采用 Gibbs 抽样(Gibbs Sampling)来运行 LDA 主题建模算法,获得两个主题,每个主题有三个关键词,以概率最高的术语被作为页面的关键词。少于一次的单词则从集合中予以删除。

- 基于页面的标题:我们拉取页面的标题,进行解析并过滤出名词(单复数)、专用名词(单复数)、外来词和基数词,并根据标题,基于它们在网页上出现的频率从中抽取前三个关键词。

然后将上述两种方法生成的关键词结合起来,根据页面出现的频率,从结合中取出前三个唯一关键词。

AI 前线:Gibbs 抽样是 Metropolis Hastings 算法的一个特例。MH 算法利用了马尔可夫链的细致平衡,从而获得了联合分布的采样。有了联合分布的采样我们就可以得到边缘分布,而这在贝叶斯推断中求后验分布有重要作用。

主题建模概念

- 主题建模是一种无监督的方法,可自动识别出出现在文本中的主题,并派生出文本语料库所展现的隐藏模式。粗略地说,一个主题是在词汇表中一组术语的概率分布,可以看做是“在语料库中共同出现的术语的重复模式”。

- 主题模型与基于规则的方法不同,它们使用正则表达式或者基于词典的关键词搜索技术。

- 我们使用隐狄利克雷分布(Latent Dirichlet Allocation,LDA)进行主题建模。它是一种矩阵分解技术,是潜在语义索引(Latent Semantic Indexing,LSI)的概率版本,试图提取数据中的潜在因素,即“主题”。

AI 前线:隐狄利克雷分布,简称 LDA(Latent Dirichlet allocation),是一种主题模型,它可以将文档集中每篇文档的主题按照概率分布的形式给出。同时它是一种无监督学习算法,在训练时不需要手工标注的训练集,需要的仅仅是文档集以及指定主题的数量 k 即可。此外 LDA 的另一个优点则是,对于每一个主题均可找出一些词语来描述它。LDA 首先由 Blei, David M.、吴恩达和 Jordan, Michael I 于 2003 年提出,目前在文本挖掘领域包括文本主题识别、文本分类以及文本相似度计算方面都有应用。

通俗来说,可以理解为:让计算机给人们推测分析网络上各篇文章分别都写了些啥主题,且各篇文章中各个主题出现的概率大小(主题分布)是啥。简而言之,就是根据给定的一篇文档,推测其主题分布。

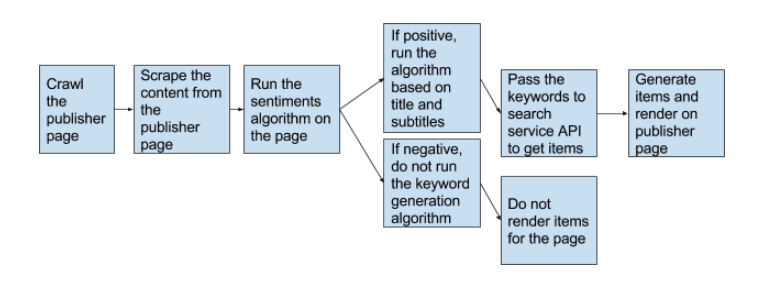

算法 2:基于页面的标题

该算法基于页面标题和副标题的词频。

- 一旦网站被搜寻(我们使用 HTML 标签

<div>和<p>中的内容),通过移除停用词、特殊字符、标点符号、空格等来清除站点内容,获取包含单词列表及其相关频率的文档。 - 然后,我们只抓取页面的标题和副标题 (

<h1到h6>),只过滤名词 (单数和复数)、专有名词 (单数和复数)、外来词,以及标题和副标题上的基数词。 - 然后,我们在实际页面内容上获取最常见的三个标题 / 副标题,并将这三个关键词传递给搜索服务。

5. 调用 eBay search API 来获取关键词——一旦为各网页提供了关键词,就会将其传递到我们的搜索服务 API 中,以获得条目推荐。

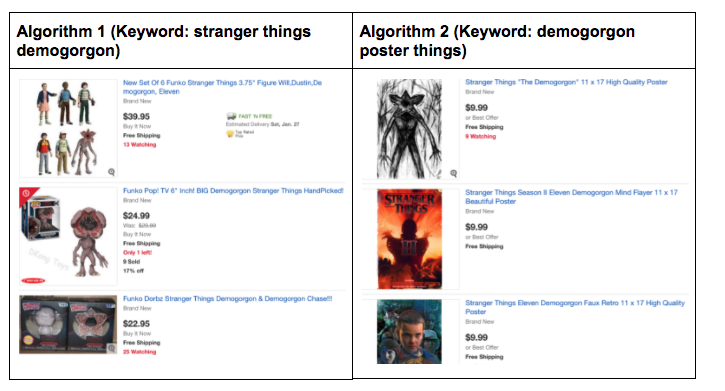

示例

URL: http://mashable.com/2017/10/25/stranger-things-eleven-poster-netflix-art/#Mcar2m5NDiqh

算法 1 展示了《怪奇物语》(Stranger Things)的纪念品,而算法 2 则展示了《怪奇物语》的魔王海报。这是因为算法 1 缺少“海报”关键词,这正是本文要讨论的内容。

我们从用户的判断工具中选择了算法 2 和算法 1,并进行比较,算法 2 的表现优于算法 1。

结果:这个简单而有效的算法在收集大量网址的反馈过程中,经过多轮人工判断,我们发现:

- 触发关键词生成算法的情绪算法能够预测页面的正确情绪,高达 84%。

- 与算法 1 相比,针对关键词的算法 2,及之后的 eBay 条目生成得到了更高的反馈分数(在人工判断工具中以 5 分为满分,则大于 3.5 分)。

- 每个网址都有一个新的 eBay 类别预测算法,如果没有关键词生成算法的结果,则会使用这个算法。

- 此外,营销数据科学团队正致力于基于页面上显示的图像生成类似的 eBay 条目列表。另外,该团队正在为发布商页面上出现的图像构建一个合理的撤回 eBay 条目清单机制。(即如果发布商页面上有高山的图片,那么在为图像呈现 eBay 相关条目时,算法不应将这些图片作为种子图像。)

- 一旦产生这些不同的定位方式,营销数据科学团队计划建立一个机器学习模型,确定用户层面上如何响应不同的定位方式(基于上下文相关的关键词、基于由发布商提供的关键词的图像、基于重定向)并根据访问相同页面的不同客户来进行调整。

总之,如果发布商可以在其页面上提供与上下文相关的 eBay 条目,则无需执行任何操作,只需注册该程序即可,我们最终会为发布商、买家、卖家和 eBay 提供一个有利的生态系统。

原文链接:

Contextual Advertising for eBay Affiliate Marketing

感谢蔡芳芳对本文的审校。