Netflix 详细介绍了其全球直播流媒体平台背后的架构,概述了它是如何构建基于云的采集管道、定制的直播源站(live origin)系统、通过 Open Connect 扩展的传输层,以及支持数百万观众的大型直播活动的实时推荐系统。名为“Behind the Streams”博客系列分为三部分,描述了三年来的工作重点,他们将直播流媒体从早期实验阶段,逐步发展成为一个可靠、低延迟的系统,并深度集成到 Netflix 更广泛的播放与个性化体系中。

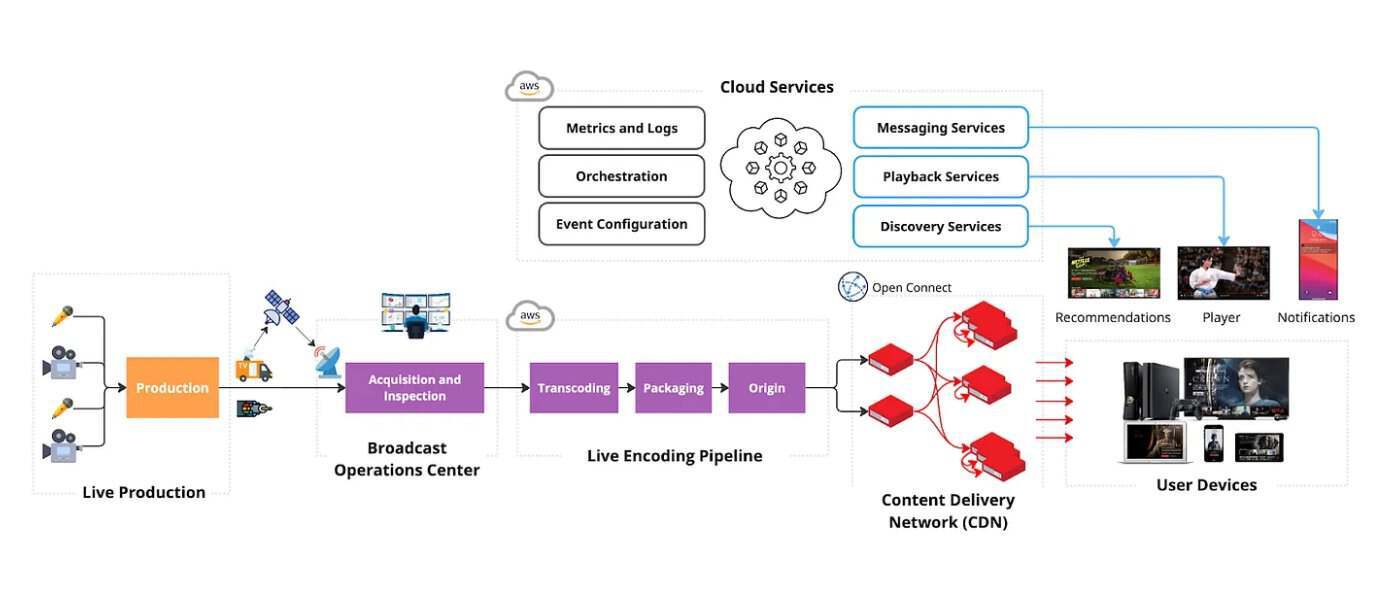

采集和转码管道构成了系统的基础。Netflix 工程师解释说,公司使用了AWS MediaConnect和MediaLive等云服务来引入直播广播源,并将其转换为适合其多样化设备生态系统的自适应比特率格式。团队指出,基于软件的转码会在事件生成期间为格式、分辨率和编解码器提供更多的配置灵活性。这种灵活性允许在事件生成期间快速迭代,并能够处理全球合作伙伴的广泛内容源。

用于采集直播内容的专用广播设施(来源:Netflix博客文章)

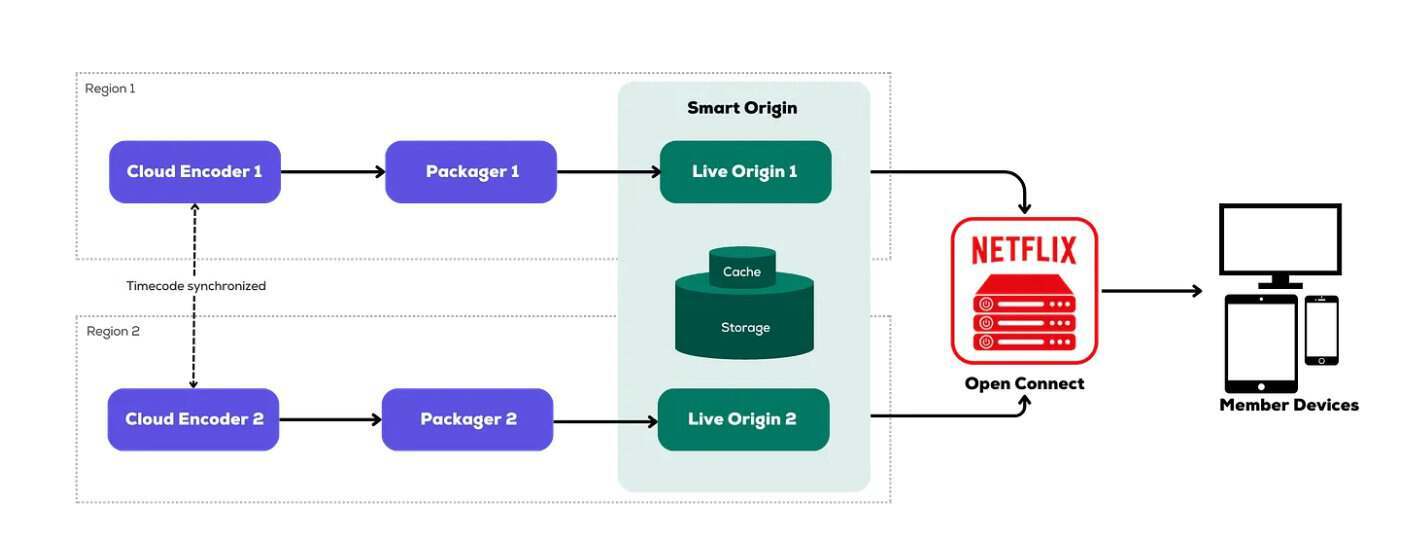

第二个关键组成部分是自研的直播封装(live packaging)与源站层。Netflix 没有依赖第三方封装服务,而是构建了一套内部系统,用于生成视频分片、管理加密、生成播放列表(manifest),并将时效性极强的内容资产存储在专用的 Live Origin 环境中。据 Netflix 工程师介绍,该系统旨在满足严格的延迟和持久性要求,同时支持多条音轨、字幕,以及AVC和HEVC两大编解码器系列。团队强调,直播源站在每几秒内必须处理数百万次读取请求,并在流量激增期间仍保持稳定的性能表现。

直播活动的内容分发进一步扩展了Open Connect(Netflix 全球内容分发网络)的能力。通过将快速生成的分片发布到地理分布广泛的边缘节点,该平台有效减轻了中心源站的负载,并为全球观众最大限度地降低了延迟。工程师指出,这种架构对于体育赛事和特别节目等需要同步观看体验的场景至关重要,即使分片到达时间存在微小差异,也可能显著影响用户的整体观看体验。

直播源站的启动(来源:Netflix技术博客)

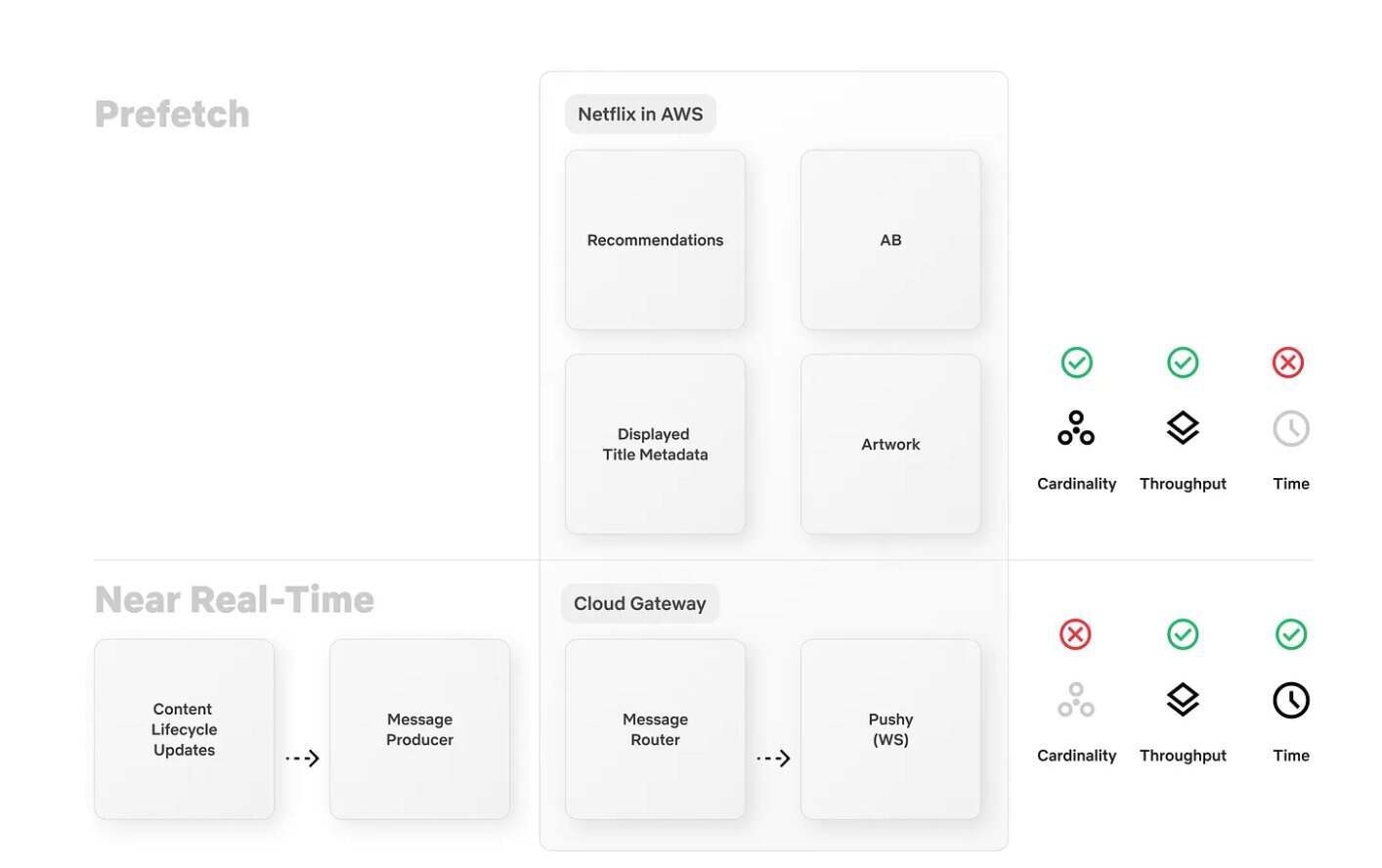

实时发现(real-time discovery)带来了独特的挑战,因为传统的推荐系统依赖预计算和缓存机制,而这在快速变化的直播内容面前失效了。为此,Netflix 重新设计了其基础设施,确保直播活动能在用户界面中迅速呈现,即使在需求激增期间也不例外。为了让数百万台设备保持同步,系统采用两阶段机制:提前预取推荐内容以分散负载,并实时广播低基数(low-cardinality)更新,以触发即时缓存刷新。该方案不仅保障了系统可靠性、避免了“惊群效应”(thundering herd problem),还能动态适应节目排期的临时变更。据 Netflix 工程师介绍,在峰值负载期间,该系统曾在不到一分钟内向超过一亿台设备推送了更新。

面向实时推荐的分阶段架构,针对每项约束进行优化(来源:Netflix技术博客)

Netflix 的实时监控体系融合了内部工具(如Atlas、Mantis和Lumen)与开源技术(如 Kafka 和Druid),每秒可处理高达 3800 万条事件,并在数秒内交付关键指标。专门设立的“控制中心”(Control Center)将核心指标集中展示,供运营团队实时监控直播事件。

此外,Netflix 的编排系统实现了采集、编码、封装和源站配置的自动化,大幅减少人为的错误,并支持快速响应。跨区域部署的冗余流水线确保了系统的高可用性,而“控制室”(Control Room)则提供对直播事件的实时可视化、故障切换控制和全生命周期管理。这一整套架构不仅简化了运维流程、优化了资源利用,更保障了全球数百万观众获得稳定、高质量的观看体验。

原文链接:

From On-Demand to Live : Netflix Streaming to 100 Million Devices in Under 1 Minute