Pico-Banana-400K 是由苹果研究人员构建一个图像数据集,包含了 40 万张图像,用于更轻松地创建文本引导的图像编辑模型。这些图像基于 Open Images 收藏集合中的真实图像生成,使用谷歌的 Nano-Banana 进行了修改,并通过 Gemini-2.5-Pro 根据其整体质量和提示词一致性进行了筛选。

研究人员指出,该数据集是为了填补大规模、高质量且完全可共享图像编辑数据集的空白。现有的替代方案要么是由人工策划,在规模上受到限制,要么是完全合成的,依赖于像 GPT-4o 这样的专有模型。

Pico-Banana-400K 与以往合成数据集的区别在于我们对质量和多样性的系统化追求。我们采用了更精细的图像编辑分类法,确保涵盖了各种编辑类型,同时通过基于 MLLM 的质量评分机制以及严谨的策划流程确保精确的内容保留和指令一致性。

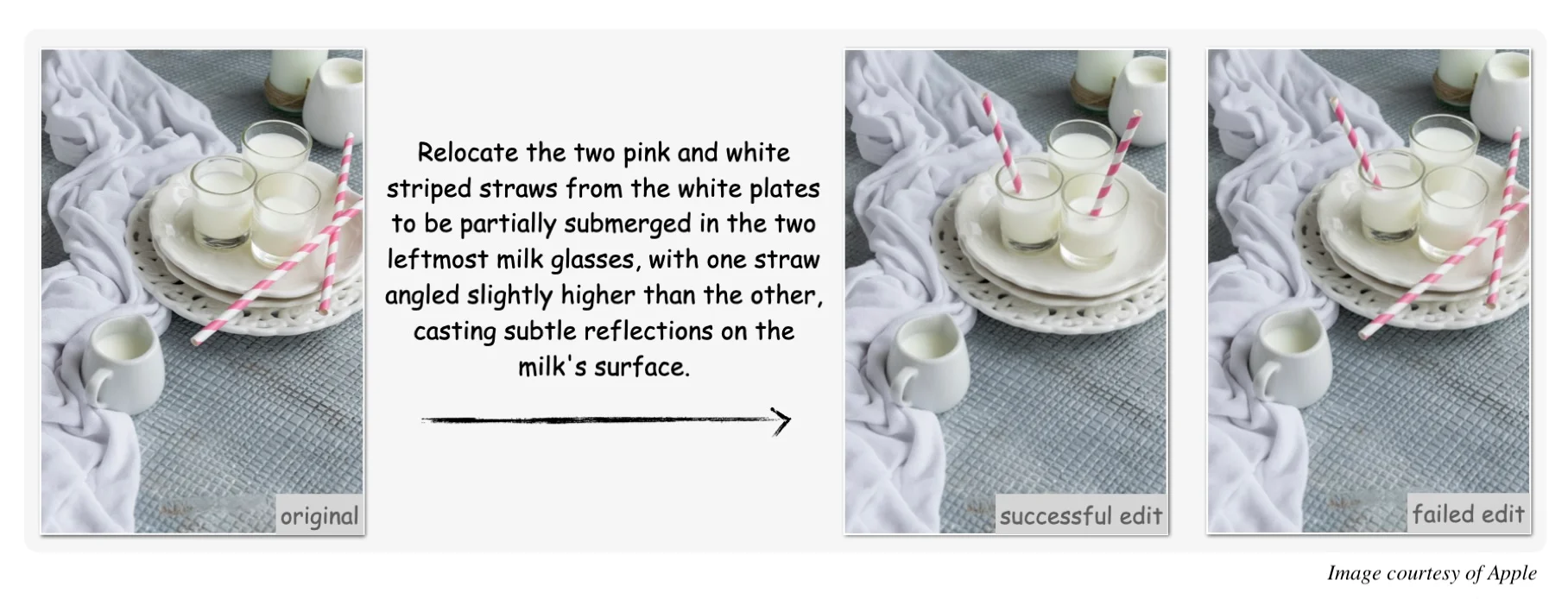

如上所述,研究人员首先从 Open Images 中选择了一些真实照片,包括人物、物体和文字场景。然后,他们设计了一组编辑提示词,并用它们驱动 Nano-Banana 对照片进行相应的编辑处理。最后,他们使用 Gemini-2.5-Pro 对编辑结果进行分析,筛选出失败的编辑,或者对相关提示进行重新调整以优化编辑效果。他们依据一套明确的评估标准来判定编辑的成功与否,这些标准包括:指令一致性(占比 40%)、编辑逼真度(占比 25%)、内容保留平衡(占比 20%)以及技术质量(占比 15%)。

大约有 56000 生成的图像被保留作为失败案例,用于模型的鲁棒性测试和偏好学习研究。

研究人员设计了 35 种编辑类型,分为八个类别,包括像素和光度调整(例如,改变整体色调)、对象级语义(例如,重新定位对象,改变对象颜色)、场景构图(例如,添加新背景)、风格转换(例如,将照片转换为素描)等。

这些提示词本身是使用 Gemini-2.5-Flash 生成的。在系统提示词中,模型被要求“编写一个用户可能给图像编辑模型的简洁的自然语言指令……注意可见内容(对象、颜色、位置)并与图像内容密切相关”。然后,使用 Qwen2.5-7B-Instruct 将生成的较长的提示词提炼为更短、更贴近人类表达的提示词,从而获得更逼真的结果。

除了包含使用单轮文本——图像——编辑提示词创建的 257000 张图像的主数据集外,Pico-Banana-400K 还包含了三个专门的子集合。第一个子集合包含 72000 个示例,涵盖多轮指令,用于研究连续修改过程中的顺序编辑、推理和规划能力。第二个包含 56000 个示例,主要是失败的图像,用于对齐研究和奖励模型训练。第三个子集将长编辑指令与短编辑指令配对,为指令重写和总结能力的开发提供支持。

Pico-Banana-400K 数据集可以在 GitHub 上获取,采用了知识共享署名非商业性使用禁止演绎(CC BY-NC-ND 4.0)许可,而 Open Images 原图则是基于 CC BY 2.0 许可。

【声明:本文由 InfoQ 翻译,未经许可禁止转载。】

查看英文原文:https://www.infoq.com/news/2025/11/apple-pico-banana-image-editin